一个普通摄像头就让二次元老婆“活”了过来,网友:求收费

鱼羊 明敏 发自 凹非寺

量子位 报道 | 公众号 QbitAI

你敢信,这年头只靠一个普通摄像头,就能让二次元老婆实时完成如此灵活的手指舞?

没错,不用穿戴硬件设备,打开电脑摄像头,AI就能让二次元老婆随你实时舞动。

即使没有昂贵传感器加持,摇花手这种高难度动作,照样能轻松拿下。

真人手指再怎么复杂地开合变化,屏幕里的Ta都能完美同步:

双臂前后交替变换都不会识别错误:

这还不算完,更让网友们直呼“离谱”的是,这样的视频动作捕捉AI,只要你有一台电脑+一个RBG摄像头,就能直接抱回家。

不用学编程,也不用多花钱,技术直接就是一个免费可商用。

这给网友整得都不敢相信了,赶忙自己上手试了试,结果——

确定是可以摆花手的灵活程度。

这个手抠鼻屎也看得很清楚啊!

好家伙,这岂不是人人都能定制专属3D虚拟主播了?究竟是怎么一回事?

上百个识别位点的3D动捕

正如前面提到的,这是真真正正的视频动捕。

像《阿凡达》《指环王》等电影中的许多特效、角色动作设计,都是由动作捕捉来实现。

不过,传统的光学动作捕捉和惯性动作捕捉,都需要通过传感器来记录演员的动作。

因此在片场,需要动捕的演员身上往往佩戴很多设备,大概长这样:

而在开头我们看到,二次元老婆背后的真人主播,身上却无需佩戴任何设备。

那它是如何来捕捉动作的呢?

通过AI。

与以往需要昂贵传感器支持的光学动捕、惯性动捕不同,近几年兴起的视频动捕主要用到了计算机视觉技术。

它只使用普通的RGB摄像头通过卷积神经网络(CNN)来识别图像中人体的骨骼关键点。

其中,特征提取器会通过分辨率由高到低的过程来提取高级特征,姿势解码器则可以基于检测或回归的方式来估计目标输出、2D/3D关键点位置或3D网络。

基于检测的方法可以生成特征图或热力图,基于回归的方法则可以直接输出坐标位置。

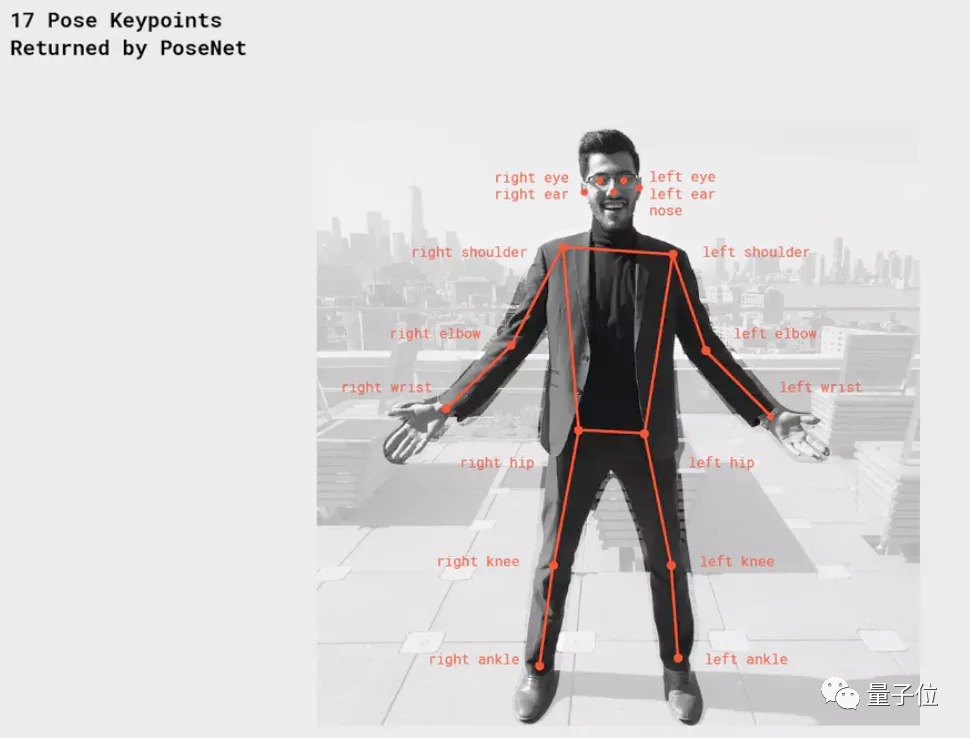

此前剑桥大学开发的人体姿态工具PoseNet就是一个很经典的案例。

它使用端到端学习框架,可以从RGB图像中直接映射出人体的关键骨骼坐标,检测全身17个位点,最终捕捉到人体动作。

如上虚拟主播用到的动捕技术,也是类似于此的神经网络。

特别的是,这套名叫小K直播姬的视频动作捕捉技术,识别位点远超17个,仅上半身就有100多个,覆盖了面部、手部和双臂。

这也是“老婆们”能够活灵活现的关键所在。

要知道,此前许多vTuber直播时,都只有脖子以上可以活动,上半身像是被封印了一般。

而当动捕技术能够捕捉的身体位点越多,可以呈现的效果也就越丰富。

比如借助小K直播姬,vTuber就可以随意扭动身体、摆出各种动作,面部表情也多了很多细节。

而最令人惊叹的手部动作的实现,则有赖于深度信息的引入。之前的卷积神经网络(CNN)学习的关节点只有2D信息,无法使用到3D虚拟形象上,但是小K直播姬自研的AI算法能捕捉3D信息并应用的3D虚拟直播里。

比如“石头”握拳这个动作,在普通摄像头“眼中”,手部位点会出现遮挡、重叠,这时只用2D关键点识别是很难还原真实动作的。

具体而言,小K直播姬的解决方案,是根据摄像头捕捉到的2D图像,来估计每个关节点到镜头之间的距离。

掌握了3D深度信息后,即便摄像头只能拍到手部侧面,想要还原动作也不成问题。

尤其是双臂前后交换这种动作,2D识别很可能无法识别前后的差别,但是3D识别就能让画面呈现明显的立体感。

目前,这种技术已经能做到每秒输出30帧画面。

其实它还能开放到每秒60帧,只是考虑到vTuber一般在直播时还需要开启其他软件,主播的电脑可能会承受不住,所以当下推荐大家开30帧。

看到这里,是不是已经被惊艳到了?

然鹅,这还不是最厉害的。

其实,不只是上半身的动作捕捉,全身动捕现在都能仅靠摄像头完成。

没错,仍旧不需要佩戴任何穿戴设备,只需多个普通的RGB摄像头,就能将真人的全身动作完全还原。

人人都可试玩的那种

效果丝滑自然、只需一台电脑+普通摄像头,还是免 费 的……这确实让人看了很难不心动。

也难怪小K直播姬一登场,惹得网友们直呼:

赶紧收钱,求求了。

要知道,传统的光学动捕、惯性动捕,由于对传感器设备、专业摄影棚等方面的需求,成本始终居高不下。

以今年火出圈的A-SOUL为例,它由字节跳动和乐华联合推出,传闻称其所使用的动捕设备成本高达8位数。

而小K直播姬这个免费产品,直接实现了“人人皆可vTuber”。

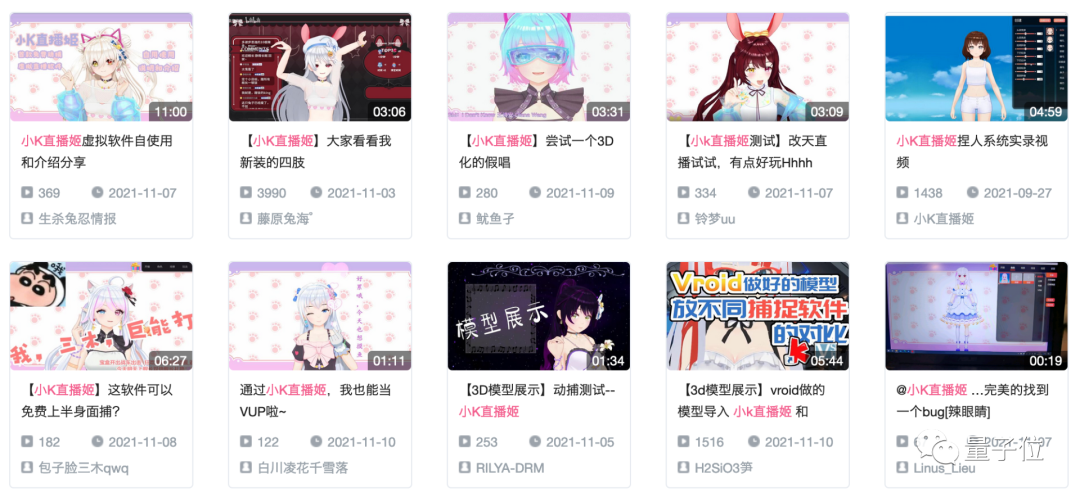

这不,在小K直播姬公测后,不少人都来一探究竟,公测10日后虚拟主播注册数就已经破万。

在这里不仅可以自己捏人,还能导入模型,B站上许多人都晒出了自己的vTuber形象。

知名VUP小希小桃最近大变身,也是因为用了小K直播姬。

会出现一石激起千层浪的现象倒也不稀奇,毕竟市面上这种将视频动捕技术商业化、还面向vTuber的产品,实在是太少了。

团队出身游戏行业

那为什么会是小K直播姬呢?

这个答案要从它的幕后打造者——云舶科技身上找答案。

2017年,出身游戏行业的梅嵩和陈敏联合创立了云舶科技。

其中,梅嵩是原蓝港互动SVP,《王者之剑》系列手游制作人;陈敏是原蓝港互动CTO,核心团队有着16年的研发经验。

凭借自身对游戏动画市场的了解,他们从创业初期就专注于视频动捕技术。

事实上,小K直播姬所采用的所有视频动捕技术,都是由云舶科技自主研发。

起初,他们利用动捕技术将视频直接生成bip、fbx动画文件,大幅提升动画师的作画效率。

后来随着自身技术的不断积累,在2019年,他们便想着将原本离线才能实现的视频动捕技术,升级为实时在线版。

因为出身游戏圈,对二次元市场有着敏感的嗅觉,云舶在2018年就察觉到了虚拟偶像市场在逐渐升温。

所以便将技术落地场景选在了这一领域。

而小K直播姬大受欢迎,除了本身的技术效果吸睛这一原因之外,也同样得益于他们的游戏行业产品背景,认为用户交互体验能提升甚至改变虚拟直播的最终价值。

同时云舶科技对用户也是抱有“有求必应”的态度,如果你想要捕捉云舶科技的技术leader,到官方论坛、用户QQ群里“钓鱼”可能是个不错的选择(手动狗头)。

现在,小K直播姬背后,从一线程序员到公司创始人,全都活跃在这些用户聚集的地方,还常常追着用户沟通交流,只为彻底弄清楚用户对于产品的更多需求。

比如最近即将上线的模型饰品增加自定义调整位置,就是网友们多次向小K提议的功能。

食用指南

OK,说了这么多,如果你也对虚拟直播感兴趣,现在就可以下载试玩一波走起了~

目前,小K直播姬暂只支持Windows系统,1060及以上显卡可实现上半身动捕,其它显卡支持面部捕捉。

进入应用后可以自己捏脸定制形象,也可以选择导入模型。

如果你在体验过程中有了好的idea,也不妨加个群水个论坛,小K直播姬背后的技术leader和一众程序员们都在“虎视眈眈”。

说不定下一个上线功能,就是受你启发的!

觉得还不错就给我一个小小的鼓励吧!