彻底搞懂感受野的含义与计算

极市导读

本文解释了感受野的概念,并举出了感受野大小及中心的计算公式,是一篇很好的入门文章。>>加入极市CV技术交流群,走在计算机视觉的最前沿

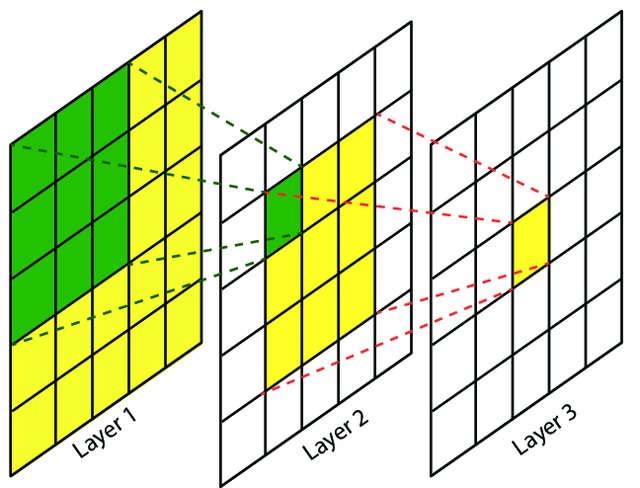

什么是感受野

The receptive field is defined as the region in the input space that a particular CNN’s feature is looking at (i.e. be affected by). —— A guide to receptive field arithmetic for Convolutional Neural Networks

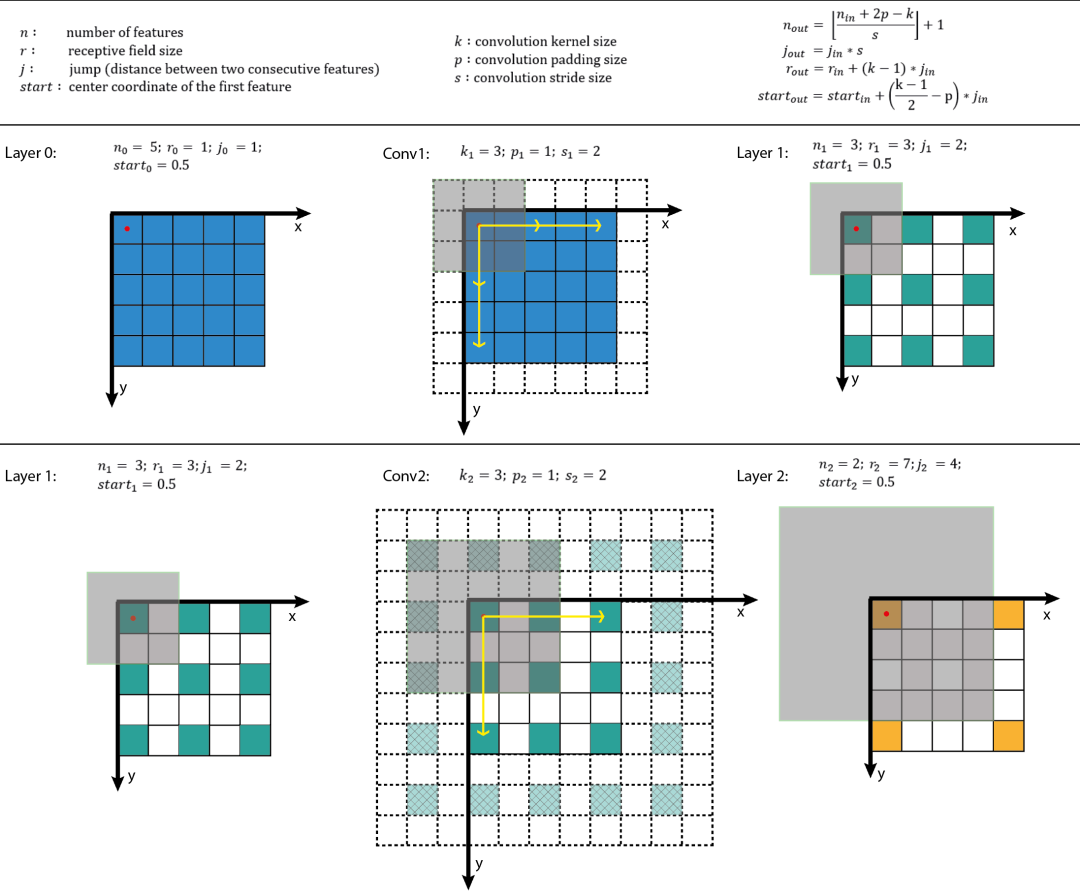

约定

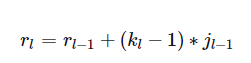

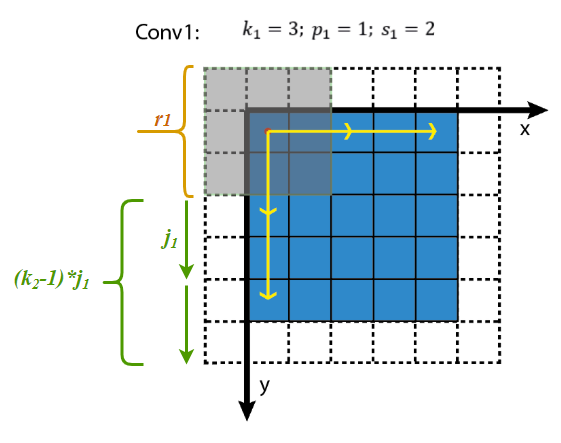

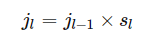

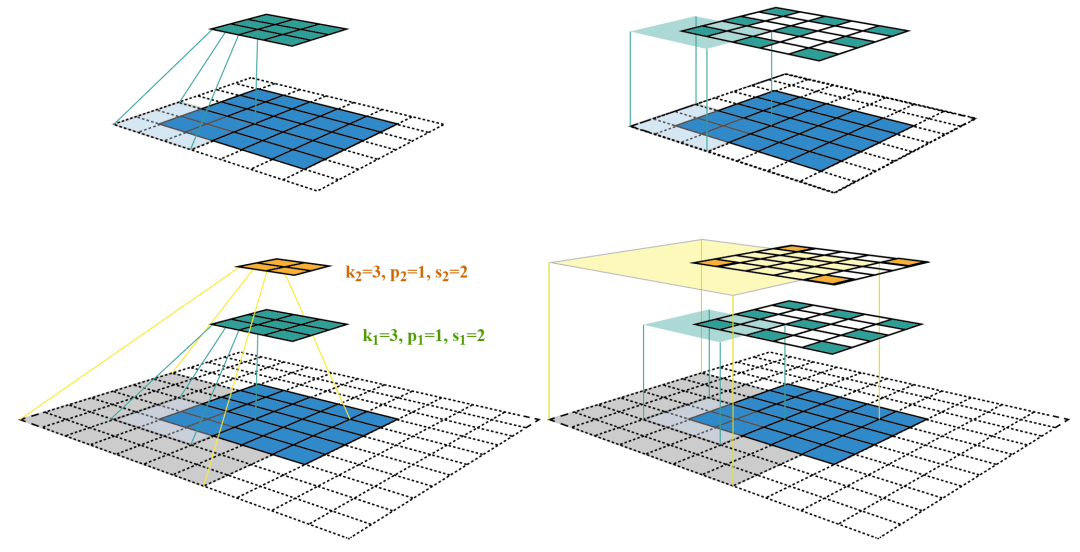

感受野大小

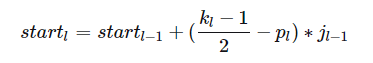

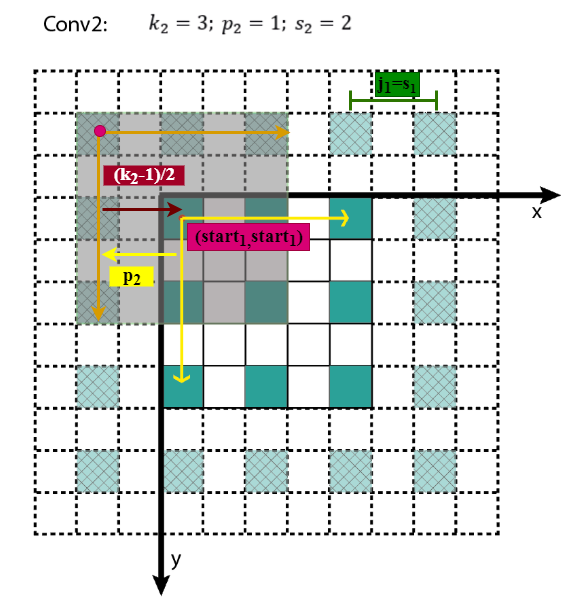

感受野中心

小结

由上面的递推公式,就可以从前向后逐层计算感受野了,代码可参见computeReceptiveField.py,在线可视化计算可参见Receptive Field Calculator。

参考资料

推荐阅读

评论