英伟达H100将在2024年之前售罄!推理GPU根本不够用,AI初创公司急了

新智元报道

新智元报道

编辑:Aeneas

【新智元导读】据悉,英伟达H100 GPU在2024年之前基本已售罄。AI初创公司真的开始急了。

英伟达最好的芯片H100,在2024年之前就会售罄!

这一消息,让AI初创公司们开始揪心了。

现在,我们已经进入了一个GPU至上的时代。

英伟达的芯片,现在已经成为了科技行业最宝贵的资源。

无论是大厂还是初创企业,都在疯狂地把预算从其他项目转到AI项目上,对GPU的需求日益旺盛。

台积电:所有产品需求都降低了,除了英伟达的芯片

作为全球最大的合同芯片制造商,台积电在上个月公布收益时表示:现在几乎所有产品的需求都减弱了,唯一的一个例外,是AI芯片。

台积电为英伟达制造的图形处理单元GPU,主导着AI应用的半导体市场。

英伟达的高端H100 GPU非常适合训练AI模型、服务客户所需的并行式计算。而如今随着生成式AI的热潮,H100已经出现了大量短缺。

4月,GPU市场忽然紧俏起来

根据《巴伦周刊》的采访,CoreWeave的联合创始人兼首席技术官Brian Venturo表示,在今年第一季度,保证供应链中GPU的分配和容量还很容易。

但是从4月开始,市场忽然变得异常紧张。交货时间甚至推迟到了年底。

而这种转变,发生在仅仅一周之内。

大型企业和人工智能实验室的GPU需求,忽然出现了猛增。

而英伟达最顶级的H100,在当前的环境下,甚至已经买不到了。

英伟达快垄断了?

为什么客户要求购买的是英伟达的AI芯片,而不是AMD和其他云供应商的产品呢?

表示,英伟达的护城河是双重的。

首先,在硬件方面,没有人像英伟达那样制造芯片。

其次,是在软件上。上市时间对于初创企业来说非常重要。如果用AMD或TPU(谷歌的张量处理单元)重装整个技术堆栈,就会耽误宝贵的时间,可能会让人失去潜在的市场机会。

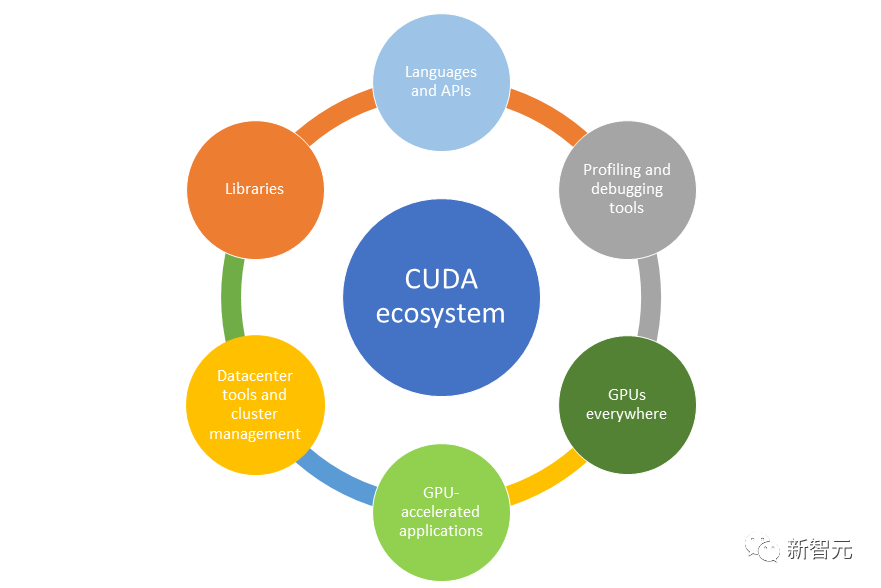

英伟达在CUDA生态系统上投入如此之多,是非常有先见之明的。

可以说,他们现在基本上比要比其他人领先10年。

这不仅仅是英伟达花了10年做的工作,而且是他们的客户和开发者CUDA生态系统上(使用软件工具和库),利用了前人的工作。

短期内,没有谁能超越英伟达。

另外,使用谷歌的TPU的问题,被锁定在具有具体技术解决方案的供应商身上。

作为一家初创公司,这或许不是最佳选择。他们需要的是具有灵活性的供应商,可以让他们在多个地方获得同样的东西。

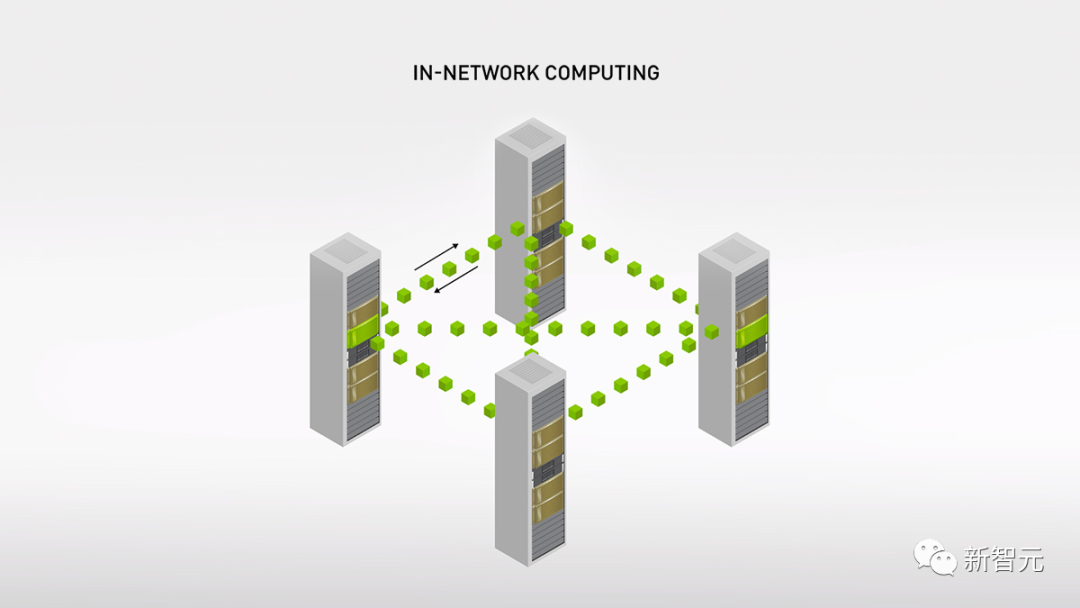

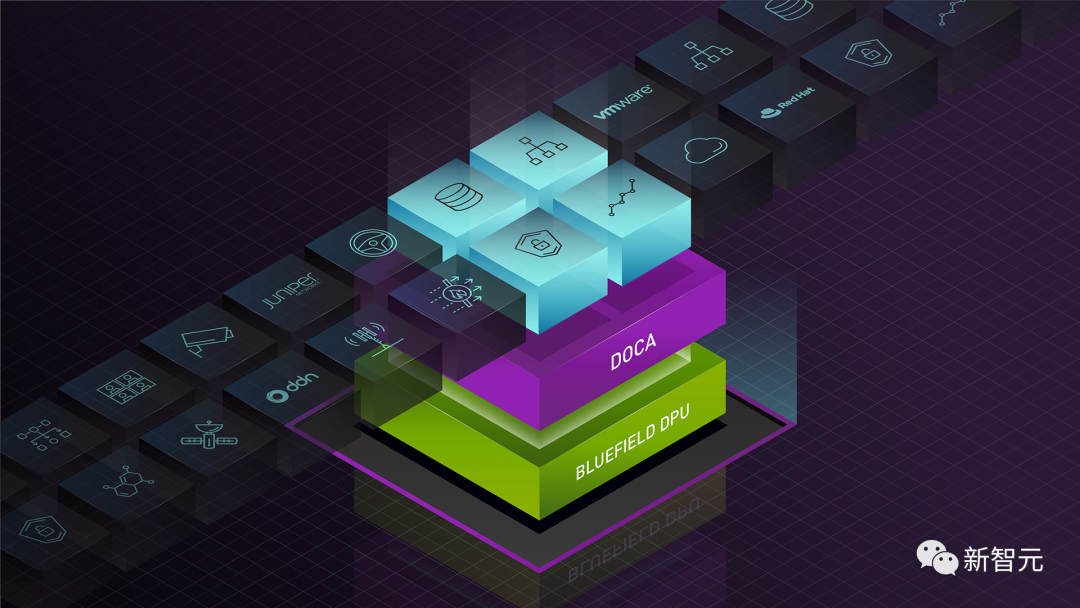

而英伟达的专有网络InfiniBand提供了当今最好的解决方案,以最大程度地减少延迟。许多其他产品不具备拥塞控制和功能,无法使工作负载发挥最佳性能。

而现在,AI初创公司都很担心:当他们取得商业成功时,或许无法拥有足够的GPU来让模型推理。

这种需求会让基础设施服务商兴奋,但是从初创公司战略的角度来讲,如何稳妥获取对算力的访问,几乎成了一种二元的风险业务。

英伟达GPU已陷短缺风暴

「谁将获得多少H100,何时获得H100,都是硅谷中最热门的话题。」

OpenAI联合创始人兼职科学家Andrej Karpathy近日也曾发文,阐述了自己对英伟达GPU短缺的看法。

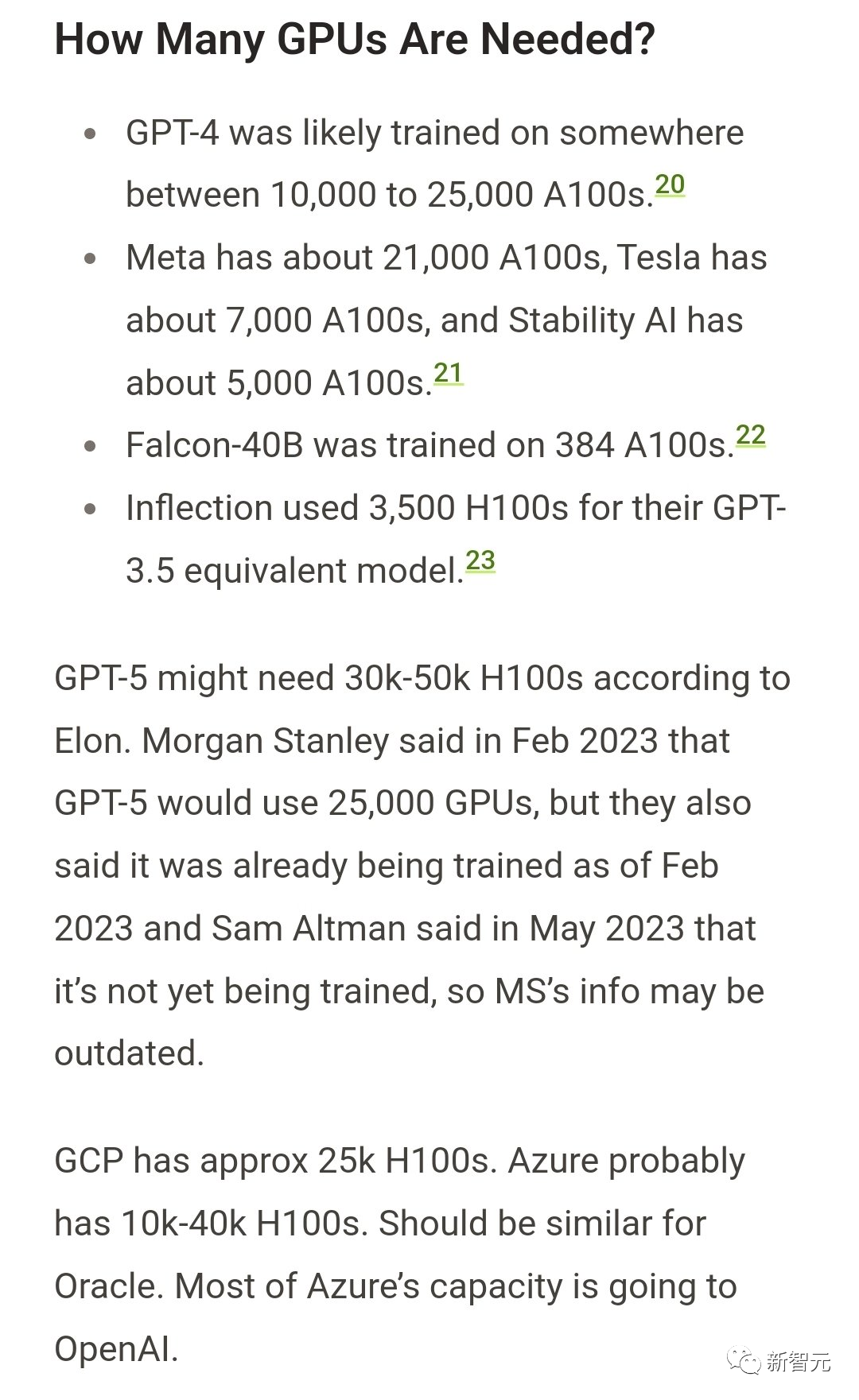

近来,社区广为流传的一张图「我们需要多少张GPU」,引发了众多网友的讨论。

根据图中内容所示:

- GPT-4可能在大约10000-25000张A100上进行了训练

- Meta大约21000 A100- Tesla大约7000 A100

- Stability AI大约5000 A100

- Falcon-40B在384个A100上进行了训练

– Inflection使用了3500和H100,来训练与GPT-3.5能力相当的模型

另外,根据马斯克的说法,GPT-5可能需要30000-50000个H100。

此前,摩根士丹利曾表示GPT-5使用25000个GPU,自2月以来已经开始训练,不过Sam Altman之后澄清了GPT-5尚未进行训。

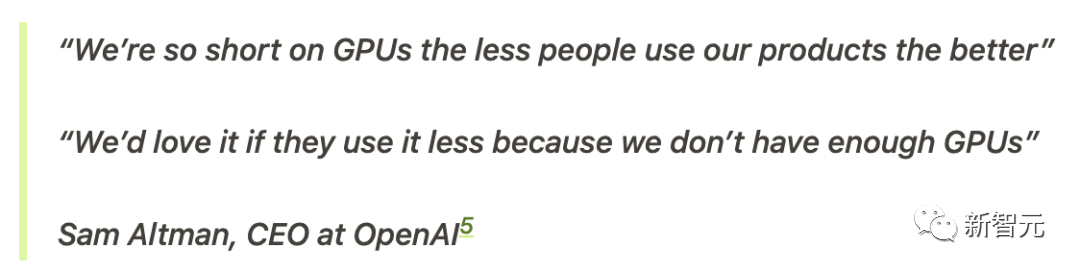

不过,Altman此前表示,

我们的GPU非常短缺,使用我们产品的人越少越好。

如果人们用的越少,我们会很开心,因为我们没有足够的GPU。

此前,在一篇热转的「Nvidia H100 GPU:供需」文章中,作者也曾深度剖析了当前科技公司们对GPU的使用情况和需求。

文章推测,小型和大型云提供商的大规模H100集群容量即将耗尽,H100的需求趋势至少会持续到2024年底。

总之,老黄是赢麻了。

参考资料:

https://twitter.com/firstadopter/status/1689606588506476545?s=46&t=iBppoR0Tk6jtBDcof0HHgg