一个小工具可以更快的写爬虫

你好,我是 somenzz,我想你应该写过爬虫吧,就是那个 requests 库,它太好用了,应该没有人不知道 requests。

通常我们使用谷歌浏览器的开发者工具(F12)查找网络请求,然后将网络请求里面的 url、headers、cookie、user-agent、请求的参数等等,记录下来,然后,用 requests 模拟浏览器发出的请求。

这些简单无脑复制操作,让我觉得写爬虫真的累,有没有一个工具,可以直接把这个请求转化为 Python 代码?

还真有!

那就是 curlconverter[1]

用法很简单:

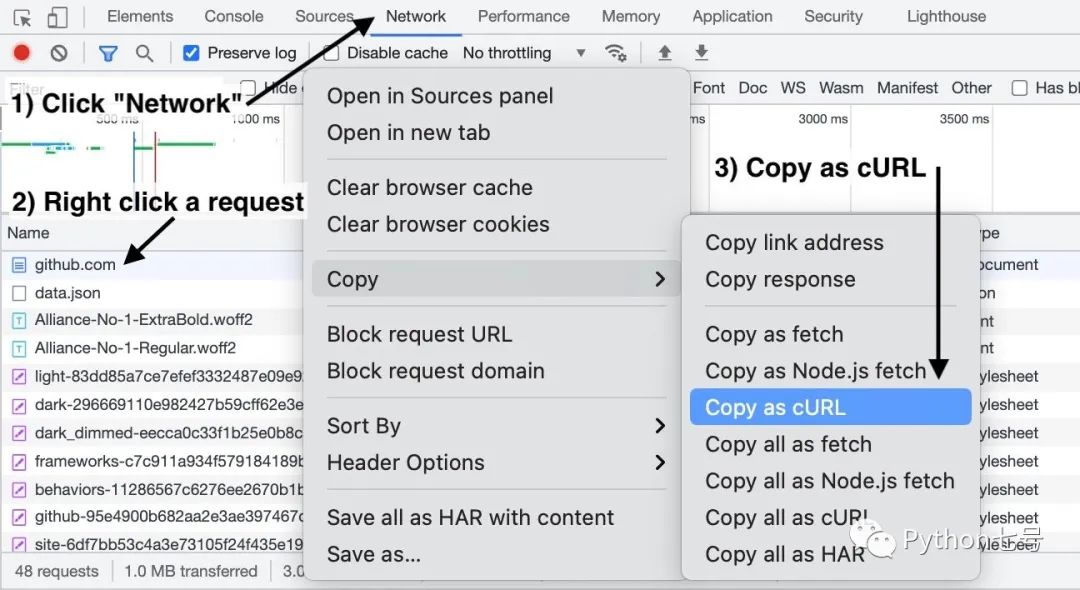

以谷歌浏览器为例:

1、在「开发者工具」中打开「Network」选项卡

2、右键单击(或按住 Ctrl 键单击)请求

3、点击 "Copy" → "Copy as cURL"

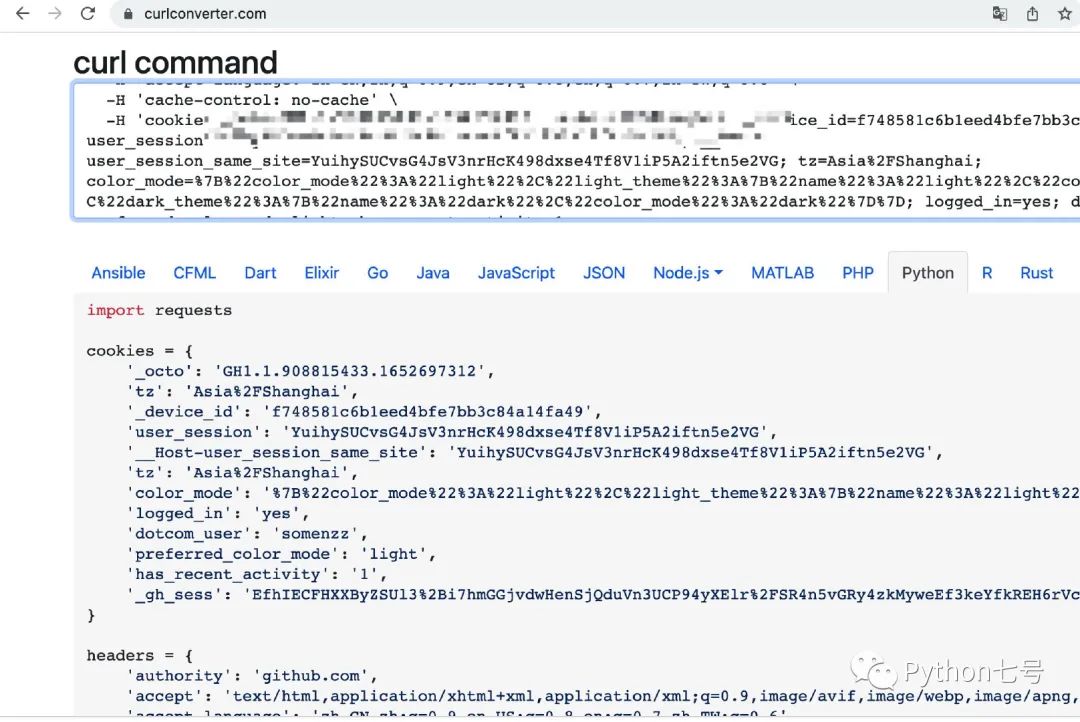

4、将其粘贴到上面的 curl 命令框中

选择需要转换语言(默认就是 Python),就可以复制代码了,非常方便:

最后的话

这个工具真是相见恨晚,可以大大节省你写爬虫花费的时间,请记住网址是:https://curlconverter.com/,如果觉得有帮助,请点在看扩散,如果有好的工具,也可以留言分享。

curlconverter: https://curlconverter.com/

评论