新视角:用图像分类来建模文字识别也可以SOTA!

极市导读

本文介绍了一个文字识别的新工作:CSTR,通过文字识别任务建模为图像分类,且不需要字符级别的标注。该模型像其他图像分类模型一样容易实现,因为是纯卷积所以训练、推理非常高效。 >>加入极市CV技术交流群,走在计算机视觉的最前沿

我们最近做了一个文字识别的工作:CSTR: A Classification Perspective on Scene Text Recognition(https://arxiv.org/abs/2102.10884),简单介绍如下。

当前文字识别有两种建模视角:seq2seq-based和segmentation-based。

seq2seq-based的方法首先将图片encode为特征序列(比如CNN、RNN、Transformer encoder或者它们的组合),然后对特征序列进行decode(比如CTC、RNN、attention based RNN、Transformer decoder等)。

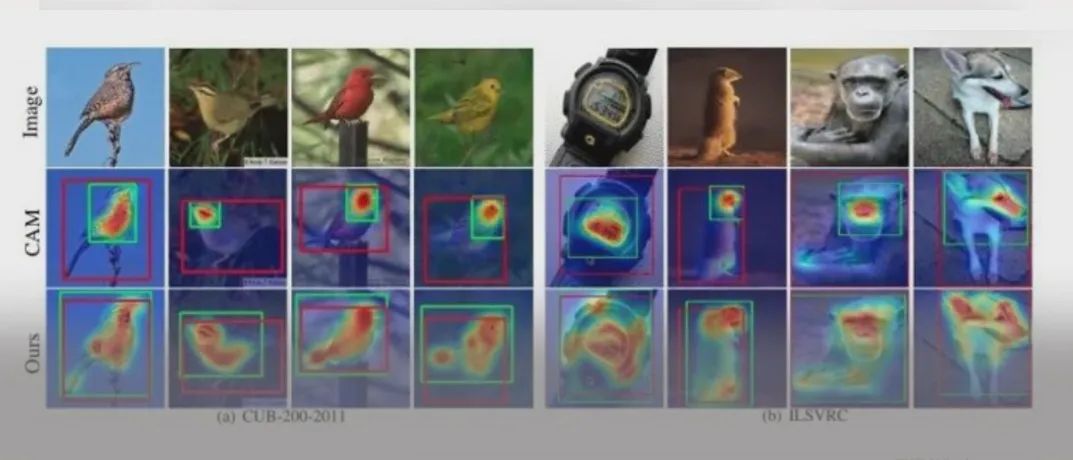

segmentation-based的方法首先定位出字符的位置,然后识别出各个位置的字符,最后将字符组合成字符串。

过去达到SOTA的文字识别方法大部分是seq2seq-based,但是seq2seq-based的方法pipeline复杂(大部分还需要STN模块来对图像进行矫正)。

segmentation-based的方法简洁很多,但是需要字符级别的标注,字符级别的标注成本高昂,在实际生产环境中不太可能使用这样精细的标注方式。

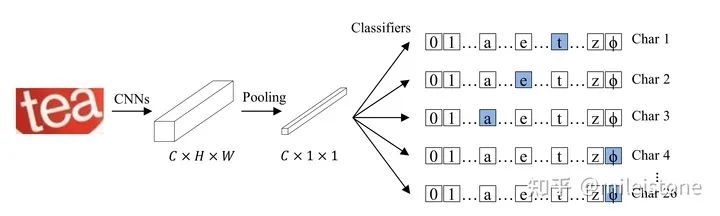

我们提出了一种图像分类的建模视角:classification-based。即将文字识别任务建模为图像分类,整体pipeline比segmentation-based的方法更简单,而且不需要字符级别的标注。classification-based的模型像其他图像分类模型一样容易实现,因为是纯卷积所以训练、推理非常高效。

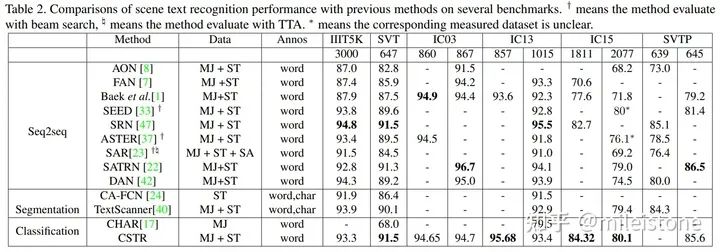

我们的classification-based模型即CSTR,在六个常用的公开数据集上的效果如下表所示。我们的模型没有STN模块,仅仅只有一个图像分类器,训练数据集为常用的两个合成的数据集SynthText (ST)和MJSynth (MJ),仅使用单词级别的标注,测试的时候没用任何TTA,整体效果基本达到SOTA。

CSTR与业界经典模型指标比较

代码将在我们的文字识别工具箱vedastr(https://github.com/Media-Smart/vedastr)中开源。

CSTR: A Classification Perspective on Scene Text Recognitionarxiv.org

https://arxiv.org/abs/2102.10884

Media-Smart/vedastr

https://github.com/Media-Smart/vedastr

推荐阅读

2021-02-12

2021-02-15

2021-02-16

# CV技术社群邀请函 #

备注:姓名-学校/公司-研究方向-城市(如:小极-北大-目标检测-深圳)

即可申请加入极市目标检测/图像分割/工业检测/人脸/医学影像/3D/SLAM/自动驾驶/超分辨率/姿态估计/ReID/GAN/图像增强/OCR/视频理解等技术交流群

每月大咖直播分享、真实项目需求对接、求职内推、算法竞赛、干货资讯汇总、与 10000+来自港科大、北大、清华、中科院、CMU、腾讯、百度等名校名企视觉开发者互动交流~