点击上方“小白学视觉”,选择加"星标"或“置顶”

重磅干货,第一时间送达

作者:Dr. Luo,东南大学工学博士,英国布里斯托大学博士后,是复睿微电子英国研发中心GRUK首席AI科学家,常驻英国剑桥。Dr. Luo长期从事科学研究和机器视觉先进产品开发,曾在某500强ICT企业担任机器视觉首席科学家。

来源:佐思汽车研究

《荀子 · 修身》曰“道虽迩,不行不至。事虽小,不为不成。”

ADS三十年之现状,可谓:“道阻且长,行则将至;行而不辍,未来可期”。《象传》故曰,“求而往,明也”。

自动驾驶ADS是新世纪产业革命即行业数字化AI化的第二个发力市场,近几年来具备L2/L2+功能的车型纷纷成功上市并占领市场,特定场景的L3/L4级功能的车型也开始落地。L3是有关安全责任归属的临界点,L3以上才可以被称为是自动驾驶,驾驶主体将变成车辆的自动驾驶系统,人类驾驶员只在必要时接管。随着AI技术与驾驶场景的深度融合,智能车AVs将按照大众的预期逐步实现从低速到高速、从载物到载人、从商用到民用的落地节奏。领航辅助驾驶(Navigation On Autopilot)做为L2+级功能也受到大众广泛的欢迎,在自动巡航控制ACC、车道居中控制LCC、匀速保持控制ALC等初级功能基础上,允许汽车根据导航信息,自主完成上下匝道、高速巡航、换道超车等智能化操作。半封闭、道路结构化的高速场景复杂度较低,易于智能驾驶功能量产落地,商业化落地主要为车道保持辅助LKA、ACC、车道居中辅助LCA、高速NOA等功能。城市路况复杂度高,行人、非机动车、机动车等道路因素较多,开发NOA功能挑战性显然更大。上述所说的针对L2的场景应用,可以解放人的双手和双脚,但驾驶员做为责任主体,必须负责监督路况并在需要时能够迅速接管驾驶任务,责任主体的分心或者打盹可以说仍是当前一个非常致命性的因素之一,需要车辆销售人员的正确宣传与算法的技术有效检测这类事件,并配合用户进行改善。大量的分析已经表明,目前在很大的程度上AVs的安全性能估计比人类驾驶(也可以说人类自身的最好能力或者是人类心理可接受的期望值)明显要差一个数量级以上,虽然可以适应仿真和简单低遮挡的约束真实场景,但仍难以应对城市的复杂道路交通场景,包括恶劣天气环境,定位信号缺失,目标高度遮挡,有限全局视野,人车交互,车车交互,以及小尺寸目标或干扰目标等。场景动态适应能力问题,即所谓“Long-Tail Challenge”长尾挑战,依旧是ADS当前待解决的主要难题之一。

为了提升ADS的时空4D感知能力和人身安全等特性,市场上AVs类似配置29个摄像头,6个Radar和5个LiDAR多模多传感器的设计已经非常常见。对比昂贵的LiDAR设备,摄像头一个最大的优势是高分辨率和低成本,纯视觉的多摄像头组合设计可以提供充分的场景语义信息。针对当前市场上所采用的纯视觉感知的产品设计,除了上述极端场景外,本文在这里将重点交流一下我们的总体深度洞察,尤其是包括应用的主力场景,即非恶劣天气下被大众认为不容易被干扰或者是认为目标不容被易漏检误检的行驶场景等等。

图1:交通事故现场 (online media, 2022)

对于ADS Auto-Pilot纯视觉感知产品应用,现有市场上频频爆发出来的严重或者致命的交通事故,反而多发生在这类比较正常的天气和一些认为很容易处理的交通场景下。如图1所示(备注:图片都来自官方报告或者官网新闻),事故原因大体包括:

-

(2022年7月) 台湾某市,天气良好,Auto-Pilot模式,与高速公路的路边桥墩相撞,导致车辆起火,人员重伤

-

(2022年7月) 美国佛州,天气良好,Auto-Pilot模式,与洲际公路的路肩停车位的卡车相撞,导致车辆起火,2人死亡

-

(2022年x月) 美国多州,夜晚行驶,Auto-Pilot模式,与抛锚车辆(抛锚现场设置有warning lights, flares, cones, and an illuminated arrow board)相撞,16次车祸中,15人伤1人亡

-

(2021年7月20日-2022年5月21日) 美国多州,Auto-Pilot模式,总共392起EV车祸,273次车祸来自纯视觉感知产品应用

-

(2018年3月) 美国加州,天气良好,Auto-Pilot模式,与高速公路的边界栅栏相撞,导致车辆起火,人员死亡

-

(2016年下月) 美国威州,天气良好,Auto-Pilot模式,(第一起)与洲际公路的路肩停车位的卡车相撞,导致车辆起火,1人死亡

如图1所示,事故分析原因比较复杂,人为疏忽因素猜测应该是主因(例如系统感知决策能力不满足应用场景时责任人主体未能及时接管车辆等等)。有关系统感知决策能力问题,目测分析有可能来自于感知层目标识别,其原因可能包括:未能准确识别倒地的货车、路边桥墩、可行驶的区域,或者摄像头脏污,器件突然失灵等等。从上述分析可以看出,从2016年的第一起,到2022年的相同事故发生,纯视觉方案未能有效识别路肩停车位的卡车还是有很大可能性的。我们的出发点是希望能够更好的解决ADS行业落地的众多难题,当然不希望这些前沿技术探讨误导了行业专家和消费者心理,也特别注明不会对文中任何敏感领域的问题探讨承担任何法律责任,完整的事故分析结果请读者以官方出台的报告为事实依据。

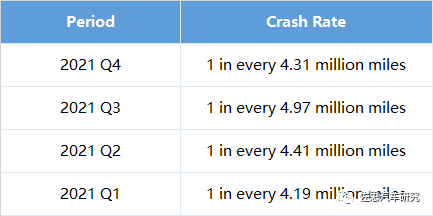

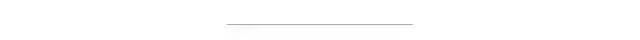

对比US全国1 in 484,000 miles的事故率,来自某著名T车厂发布的2021年自产车交通事故安全评估的分析数据如下:

可以看出十倍的提升,依旧满足不了大众对智能出行安全的期望值。如果定位在上百倍或上千倍的提升为目标值或者说大众可以接受的程度,对行业设计者来说,前方的路依旧是任重而道远,更需要上下而求索,在5-10年内交付一个比较完美的答案。

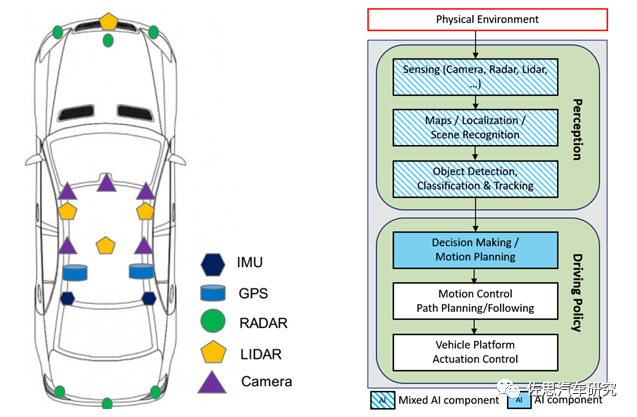

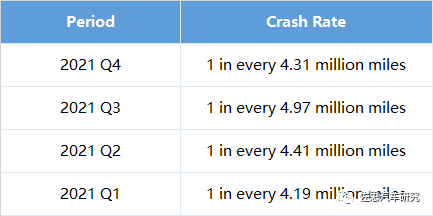

自动驾驶ADS主要是由高速场景向城市道路场景演进来落地领航辅助NOA功能,AI与场景的深度融合,推动ADS逐步实现从低速到高速,从载物到载人,从商用到民用,从阶段一提供L2高级辅助驾驶和L3拥堵高速公路副驾驶,发展到阶段二可以提供L3拥堵公路自动驾驶和L4高速公路自动驾驶,最终实现阶段三的L4城郊与市区自动驾驶和L5商用无人驾驶等等。ADS算法的典型系统分层架构如图2所示,一般包括传感层,感知层,定位层,决策层(预测+规划)和控制层。每个层面会采用传统算法模型或者是与深度学习DNN模型相结合,从而在ADS全程驾驶中提供人类可以认可的高可靠和高安全性,以及在这个基础上提供最佳能耗比、最佳用车体验、和用户社交娱乐等基本功能。

图2:ADS技术栈案例 (Nageshrao,2022)

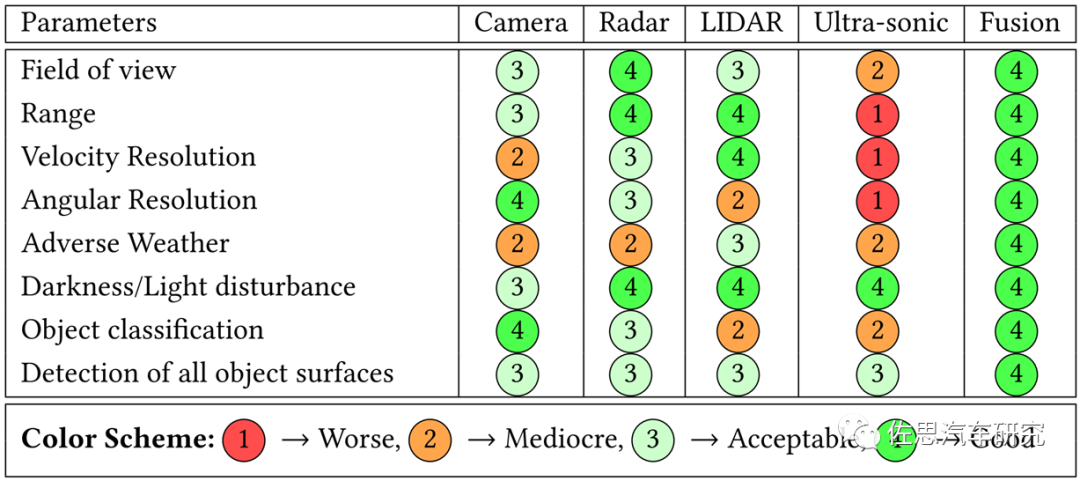

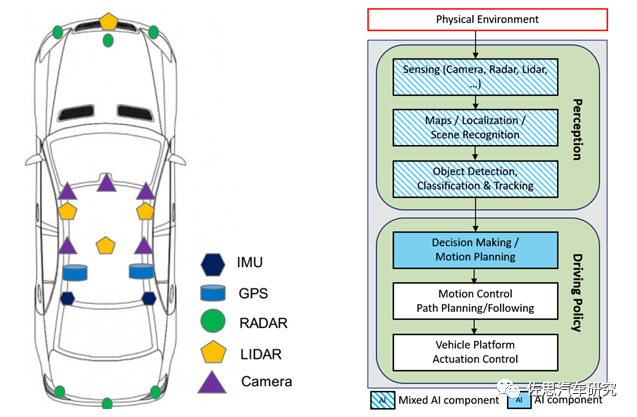

ADS部署的传感器在极端恶劣场景(雨雪雾、低照度、高度遮挡、传感器部分失效、主动或被动场景攻击等)的影响程度是不一样的。所以传感器组合应用可以来解决单传感器的感知能力不足问题,常用的多模传感器包括Camera(Front-View or Multiview; Mono or Stereo;LD or HD),毫米波Radar(3D or 4D)和激光雷达LIDAR(LD or HD)。如图3所示,ADS传感器特性可以总结如下:

-

-

单目和多目Camera可以提供一定程度的目标深度信息。

不足:

不足:

-

-

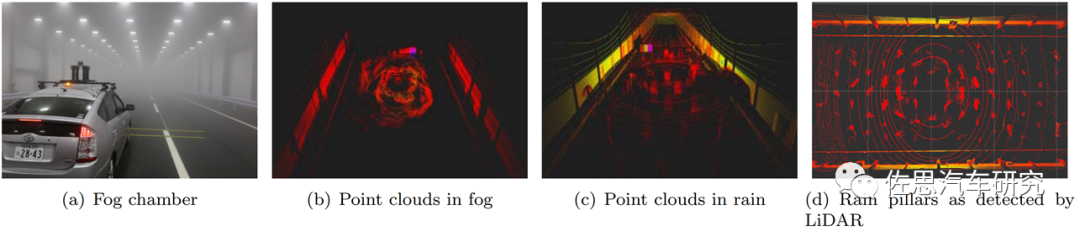

(如图5所示)当雨速高于40mm/hr到95mm/hr,信号反射密度严重损失并产生雨枕现象。

-

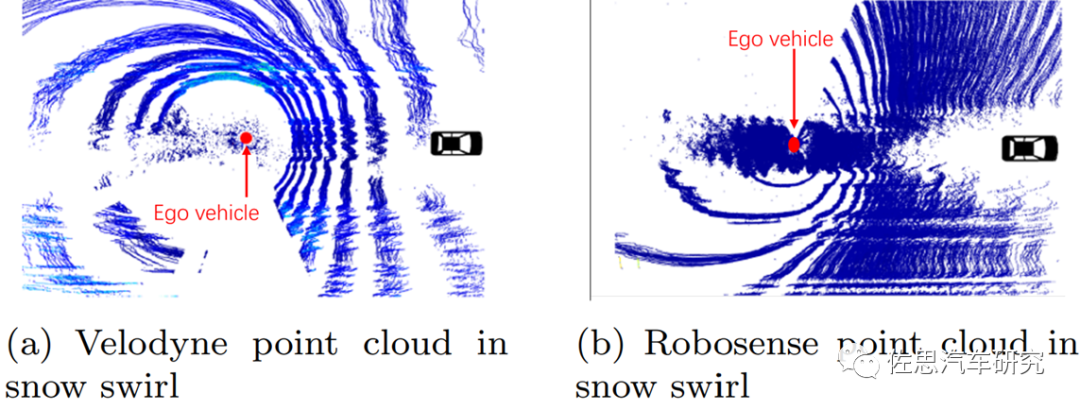

(如图5、图6所示)大雪天气下可视距离缩短并产生反射干扰波形。

-

-

优势:

不足:

-

-

-

(如图6所示)大雨浓雾和暴风雪会产生接收信号强衰减和斑点噪声。

图3:ADS传感层的不确定性与性能对比(Khan, 2022)

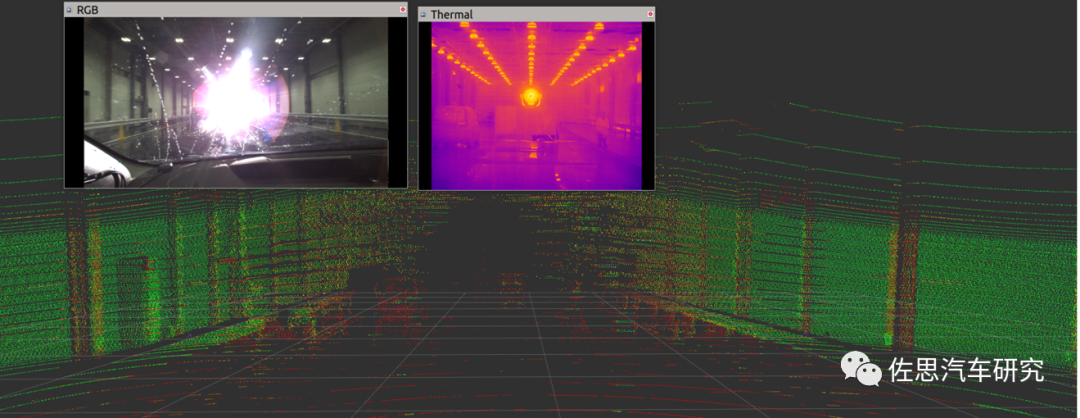

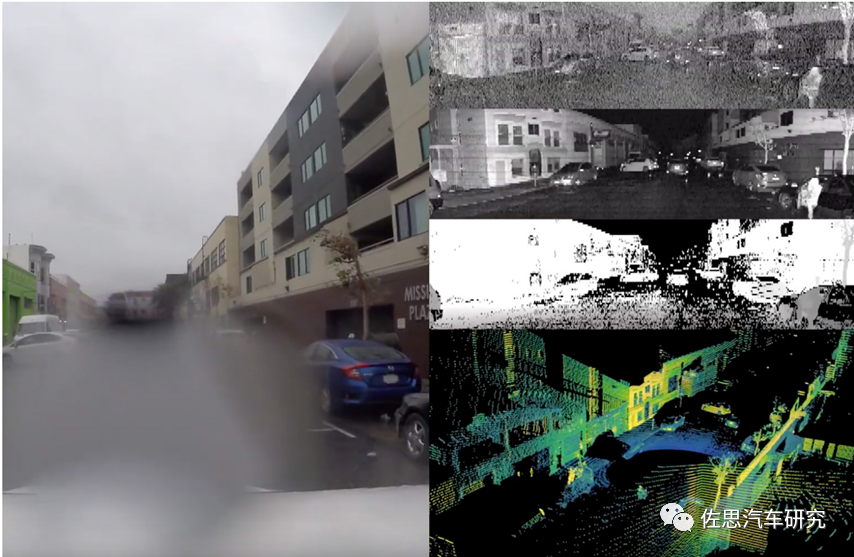

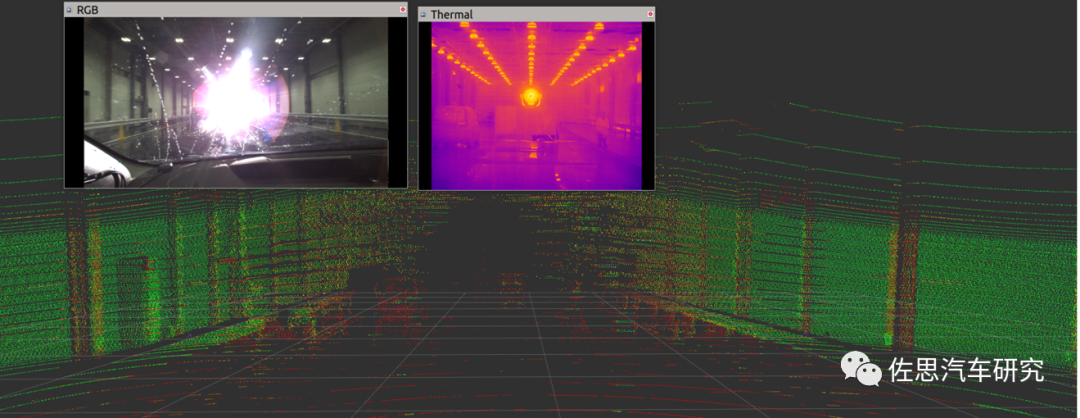

图4:Camera(RGB, Thermal) 和LiDAR的强光场景(Zhang 2022)

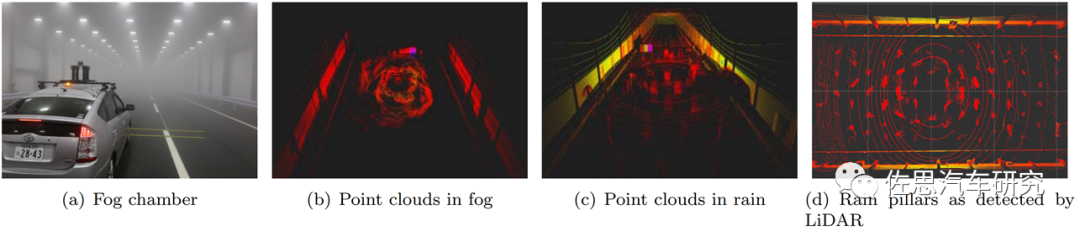

图5:Camera和LiDAR的浓雾暴雨场景(Zhang, 2022)

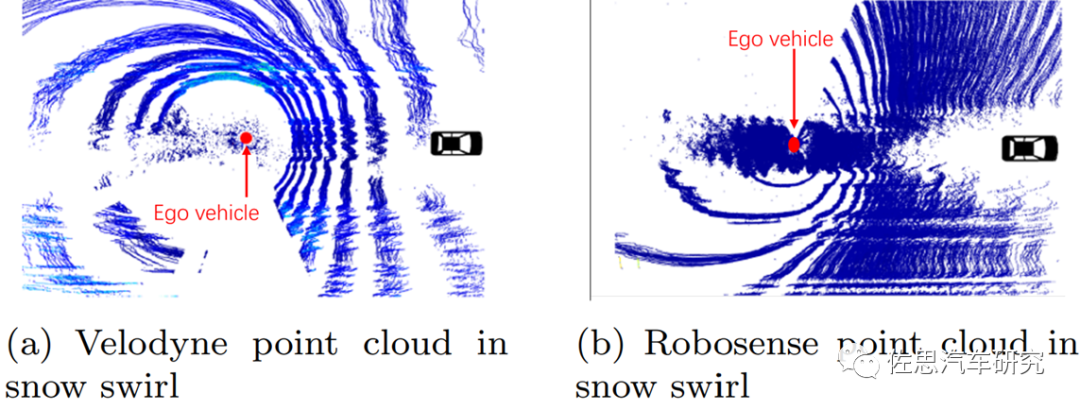

图6:LiDAR的暴风雪场景(Zhang 2022)

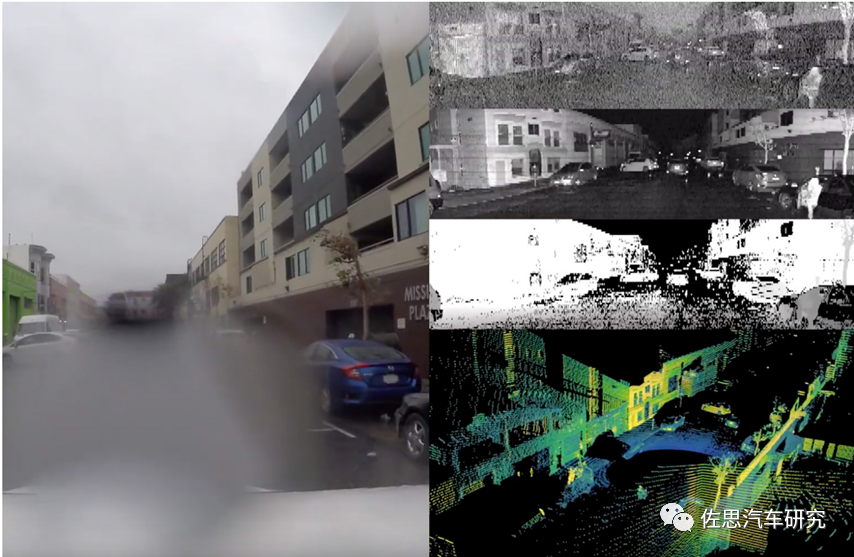

图7:Camera和LiDAR的雨天场景(Zhang 2022)

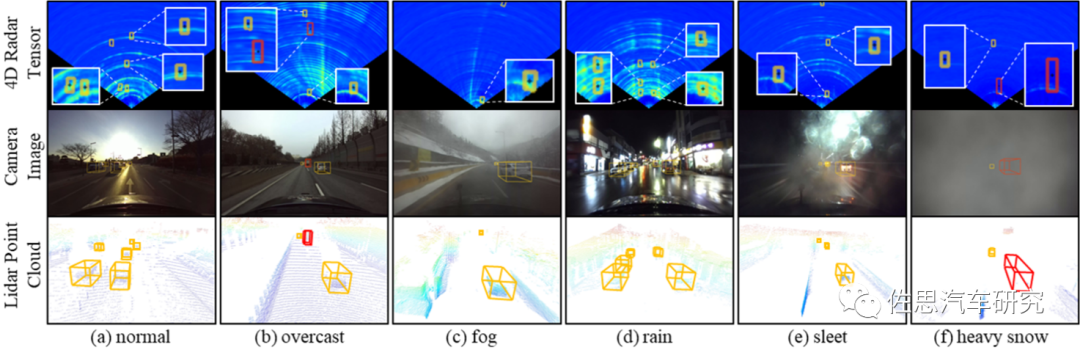

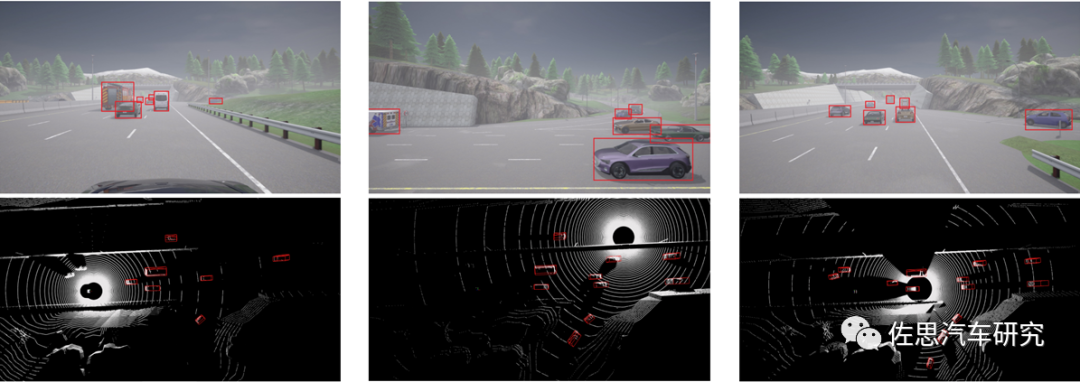

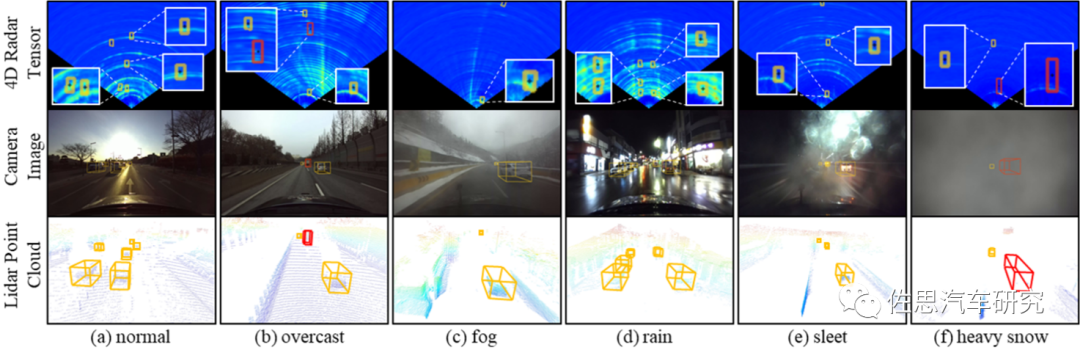

ADS感知层的一个主要挑战是恶劣场景的挑战。如图8所示,对比LiDAR和Camera,4D高清Radar发送的毫米波,可以有效穿越雨滴和雪花,不受低照与雨雪雾天气影响,但会受到多径干扰问题影响,总体来说对环境的适应性高,单独或者组合应用对2D/3D目标检测非常有优势,同时还可以提供高精度的目标高度和速度信息,可以有助于ADS的预测规划性能提升。

图8:4D Radar,Camera,LiDAR点云的3D目标检测识别对比案例 (Paek, 2022)

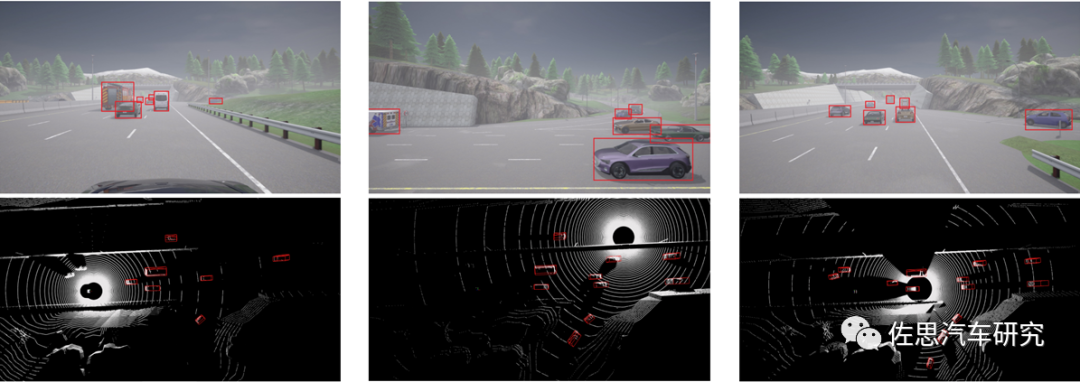

ADS感知层的主要应用场景包括高速公路,城郊与市区道路;十字路口,交通环岛,潮汐公路;隧道,停车场等,其主要任务是基于多模的2D/3D人车物目标识别,动态目标跟踪与速度识别,交通标志识别,车道线识别,红绿灯识别,路面可行驶区域语义分割,路面障碍检测,盲区检测,交通事件检测,司机打瞌睡检测等。与此对应的核心产品特性包括:碰撞预警,紧急刹车,车道偏离预警,传感部分失效预警;车道变道,车道并道,路口通行,行为预测,轨迹预测,轨迹规划;车速控制,转向控制等等。

ADS感知层的一个挑战是目标遮挡即感知盲区的挑战。单纯依赖AVs自身360全方位近距感知和远距感知,很难能够让ADS从理论上完全超越人类的驾驶水平,通过预测预警达到更低的交通事故率和提供更好的人身安全。如图9所示的典型前方遮挡场景,Camera画面相对影响较小,LiDAR前方有大片区域由于遮挡出现空白,严重影响感知决策。一个可行的策略是利用这类3D阴影特性进行障碍目标检测,即将阴影与遮挡目标关联,通过这种先验假定来降低目标漏检率(Haul, 2022)。

如图10所示的对比案例,可以看出车路协同可以有效解决盲区与上述所说的长距感知的挑战,但对应的缺点也不言而喻,部署的成本与长期可靠运营费用以及如何防网络攻击问题,这决定了对乡村和偏远地区的场景,需要寻求AVs自身的多模感知认知决策能力提升。

图10:独立感知与车路协同感知对比案例(Mao, 2022)

图11:多视觉的目标多模感知与融合识别案例(Mao, 2022)

如图11所示,V2X的可行解决方案包括交通要道部署的RSU Camera,LiDAR,或者Radar,对算法设计来说,需要解决海量点云数据的压缩与实时传输,以及针对接收数据的时间轴同步,多模感知与特征融合目标识别等。目前这个领域基于Transformer在BEV空间进行多任务多模态的融合感知已经有了一些长足进展,融合的方式也可以自由组合,包括多视觉的Camera视频融合,以及 Camera与LiDAR或者Radar的组合融合模式,对点云数据的超分变率会改善融合效果,但融合对延迟非常敏感。

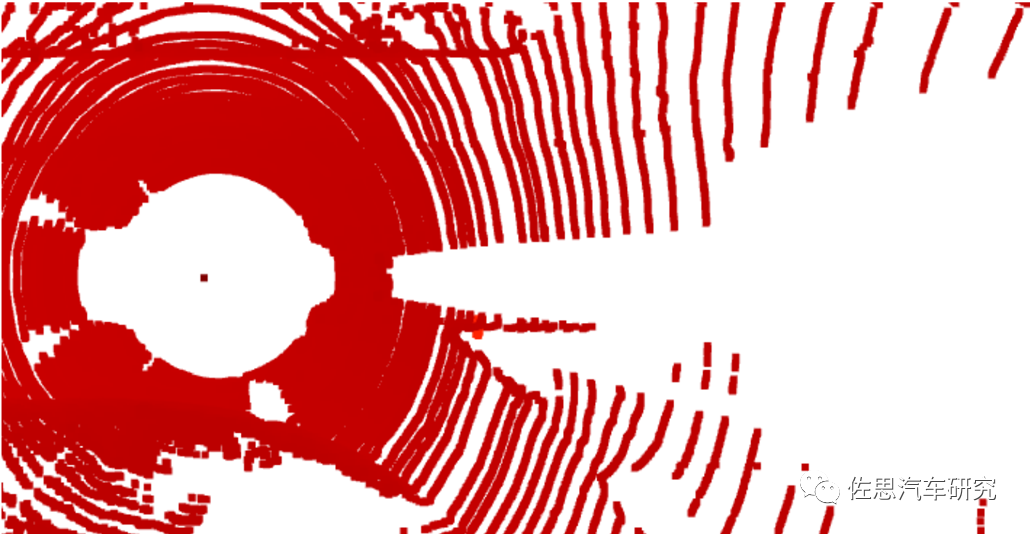

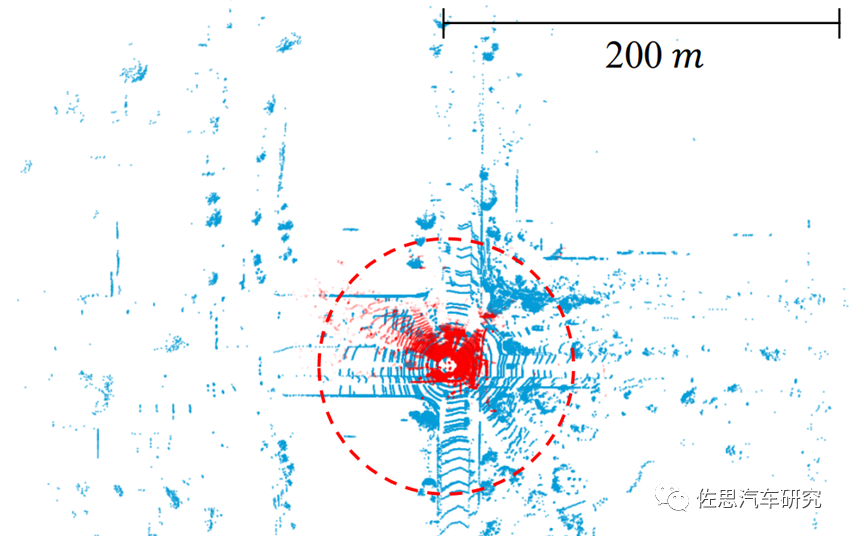

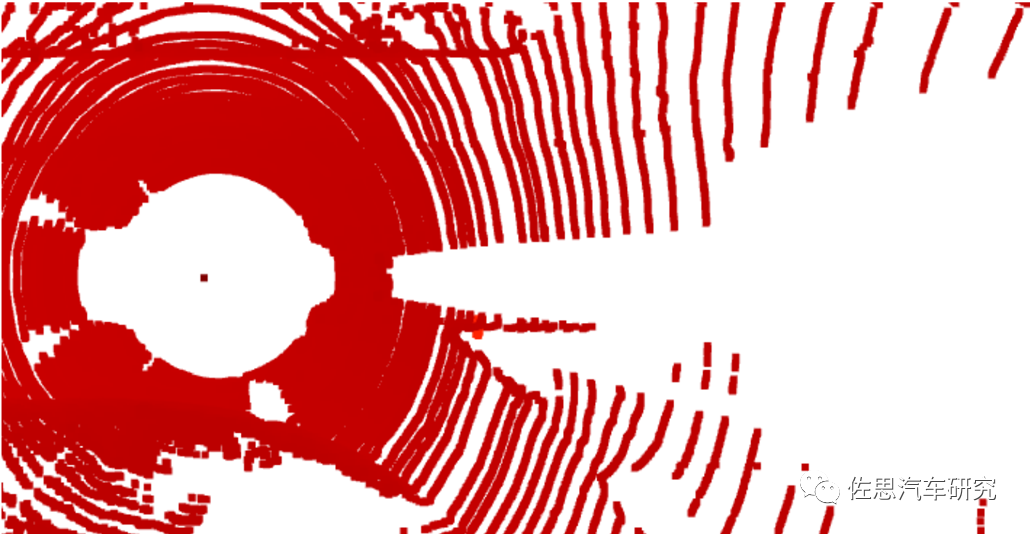

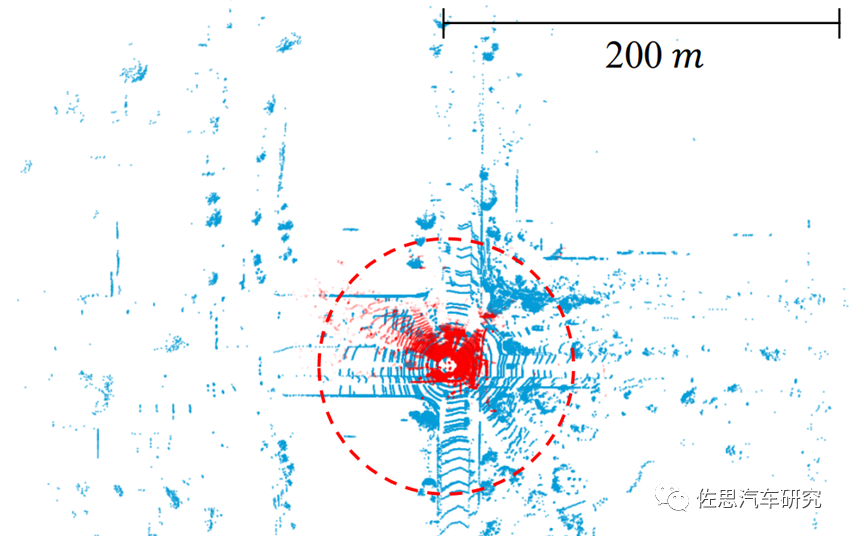

ADS感知层的一个挑战是可感知目标距离的挑战。远距离(250-300米)小目标感知任务对高速行驶AVs的安全响应速度是至关重要的。对3D目标识别等视觉任务可说,随着感知距离增加,抽取高密度特征的AI主干网络的计算复杂度会按照二次元速度增加,对算力需求也加速度增加。从图12的对比还可以看出,采用长距LIDAR可以提升感知距离,特征点可以覆盖更大的区域但更稀疏,同时也会产生”Centre Feature Missing(CFM)”即点云空心化或者叫黑洞的问题,极端场景包括近距离的超大车辆的中心特征缺失。解决CFM挑战问题的一般方法是在BEV特征空间依赖卷积操作通过特征发散来提供中心区域的感知场,或者通过点云中非空的区域来预测中间空心区目标,代价是目标预测误差和不确定性的输出结果,或者通过连通域打标签CCL进行Instance Point Group进行插值和滤波,以及整个点云的超分变率Super-Resolution来改善性能。

图12:短距LIDAR点云(红色,75米)与长距LIDAR点云(蓝色,200米)对比案例 (Fan, 2022)

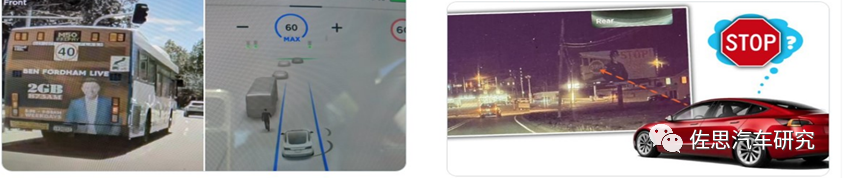

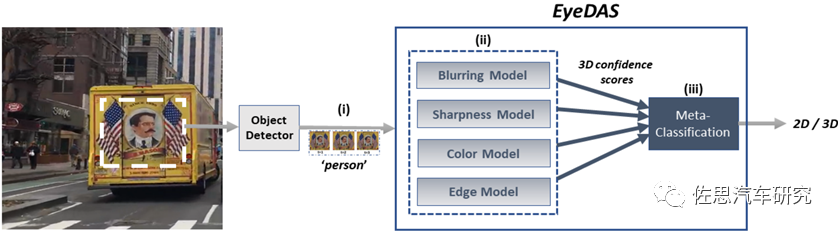

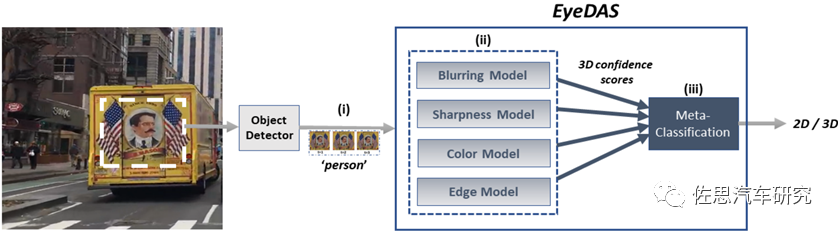

人类是通过双目视差来进行2D/3D目标的识别与定位,纯视觉感知设计,通过跨摄像头部署或者希望通过单目视频信息进行3D目标识别,总体性能在实际驾驶环境中有产品应用体验。立体盲的问题,可以对比参考一下这些场景分析来定义,如图13所示的两个事故案例:纯视觉感知算法错把2D宣传画当成真实的3D目标,不停地针对假想的在前方飞奔的行人进行紧急刹车,彻底是一种逻辑混乱状态,严重的话也会因为采取了错误决策导致车祸。设想一下,如果类似宣传画、交通障碍标志(宣传画或者实际物品)在行驶车辆上,也许通过点云来识别目标是否运动,纯粹靠单目或跨摄像头融合感知3D或者所谓活体目标,困难重重。一种解决的思路是采用Few-shot Learning-based的方法来消除立体盲问题带来的致命安全威胁。如图14所示,EyeDAS案例是对检测到的目标抠图进行四种属性的非监督概率估测,通过一个宏分类器来决策是否是2D/3D目标。类似这样的实现策略,相信如果有足够的数据,一个DNN网络同样可以基于单目做很好的活体或者3D目标识别,可以见到类似的这样设计,但立体盲问题需要重点评估。

图13:两个事故案例:错把2D宣传画当成真实目标(Levy 2022)

图14:EyeDAS 后处理算法案例(Levy 2022)

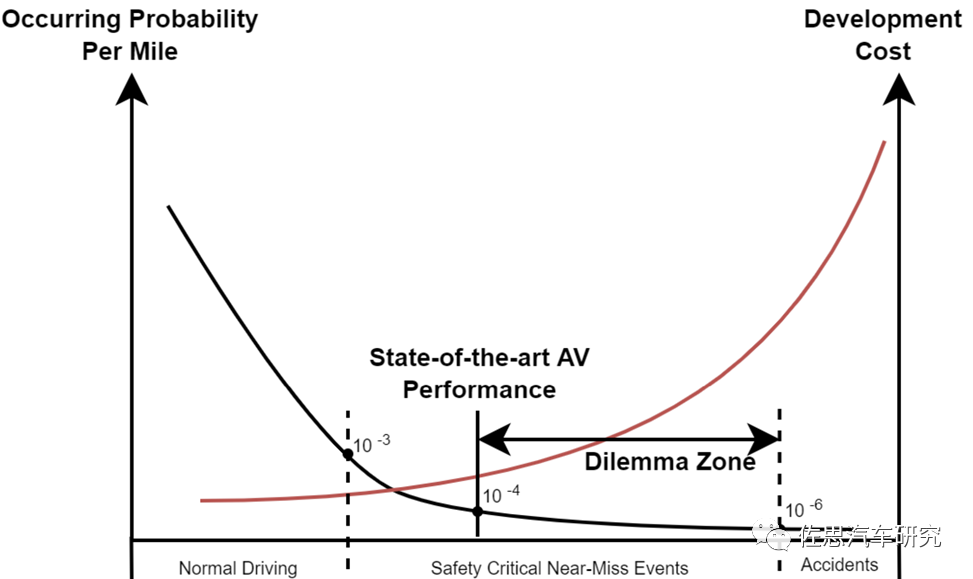

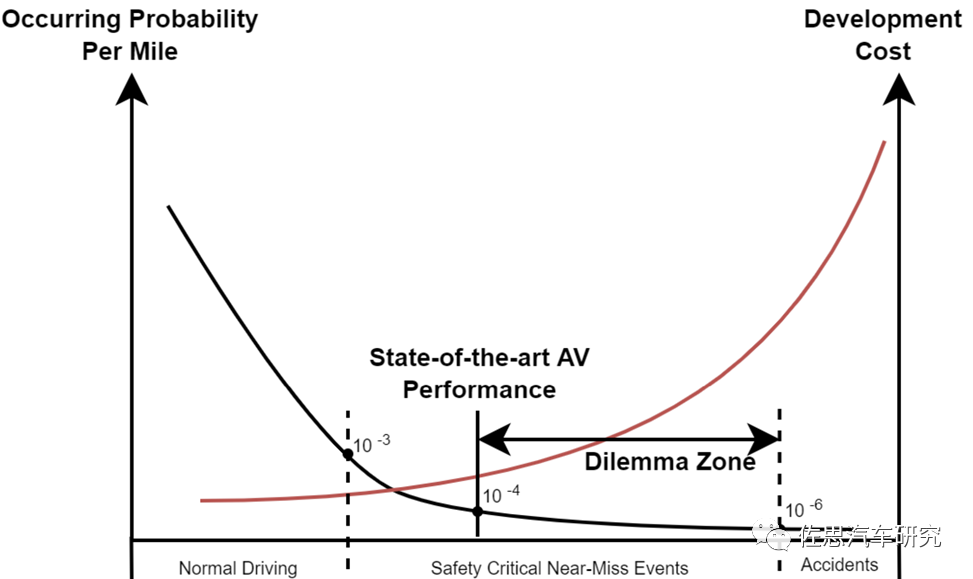

从UN的统计数据可以看到,全球每年道路交通事故都约有5000万人伤,125万人亡,经济损失可以高达约1.85万亿美元,而94%交通事故均来自可以避免的人为因素,且90%发生在中低收入的国家。研究表明,将有效预警提前1.9秒,事故率可下降90%,而提前2.7秒,事故率可下降95%,所以AI算法的感知认知领域的技术进展推动了辅助ADAS以及自动驾驶ADS技术的行业落地也是势在必然的。2021年统计数据表明,一个US司机在自然驾驶环境NDE下每英里的车祸发生平均概率约在百万分之一的水平。而2021年US加州自动驾驶车辆AVs最好的disengagement rate也只能做到十万分之一。由于篇幅原因,本文不准备全面展开讨论感知算法中众多不确定性问题。只重点讨论1-2个大家比较关注的技术难点。

“长尾问题”没有一个很明确的定义,一般指AVs即使经历了交通公路百万公里数的路况测试,对每个AI算法模块而言,包括感知层和决策层(预测+规划),仍不能完全覆盖各种各样的低概率安全至关重要的复合驾驶场景,即所谓的“Curse of Rarity(CoR)稀缺问题”。业界对如何实现一个通用的任意目标种类的检测器或者是一个通用的运动目标检测器,依旧是一个未解的技术难题。如何定义和分析这些稀有场景,也可以有助于更好理解目标检测识别语义理解预测决策算法性能的提升,从而加速安全可靠的ADS解决方案的开发与部署。

如同图15和本文开头所提到的交通事故原因分析所述,CoR问题中稀有(小样本)目标的场景比比皆是,这里简短罗列一些供大家参考:

Traffic Cone,Traffic Barrels, Traffic Warning Triangles未能被准确识别导致的二次车祸场景

不容易被检测到的公路上飘逸的塑料袋

山体滑坡导致公路路面障碍物

公路上行走的各类动物

车前方正常行驶交通车辆,如果装载了交通交通标志物体如何有效检测和决策

有一定坡度的路面如何有效进行2D/3D物体检测

图16:ADS中CoR问题的呈现图 (Khan, 2022)

如图16所示,CoR稀缺问题总体有很多中解决方法,但在机器人、ADS领域的一个关键挑战是系统安全性能的保证。一个解决的思路是采用仿真来产生上述所提的大量稀少的安全事件场景,但仍然远远不够,原因在于多数仿真环境采用手工设计的规则很难模仿现实驾驶场景的高复杂性与不确定性,安全相关的真实事件数据非常难以采集,实际路况中人车交互和车车交互也很难建模,安全度量和评估也同样异常艰难。从AI算法角度,可以在仿真数据基础上继续结合Importance Sampling和Importance Splitting方法,Importance Sampling方法可以根据输入的概率分布来对输出的Likelihood Ratio释然比进行加权来产生无偏置的估计,这只适合简单的场景。Importance Splitting方法强激励的通道可以继续分解,可以将稀有事件的估计分解成条件概率分布序列从而减少估计方差,但人工设置的阈值选取是一个挑战,也很难评估Policy空间的性能敏感性,尤其是针对near-miss事件和交通事故等各类不确定性。

涉及交通安全的事件场景数据是非常稀缺的。假定上亿英里里程数可能碰到一次AVs的致命事件,需要上万亿英里的里程数估计才能积累足够的数据。从工程实践来看是非常不现实的,虽然2022已有几个国家先后开通了ADS L4车辆上路的法规,但这个僵局严重影响了AVs安全性能的提升和部署进程。一个可行的方案是通过收集人驾驶的车辆数据,例如US交通部的统计,每年全国有3万亿英里的里程数累计,其中包括6百万次车祸,2百万人受伤,3万人致命伤亡事件。避开数据采集的隐私问题不谈,这类自然驾驶环境NDE海量车辆轨迹数据,可以有助于建立高保真NDE模型,从而通过仿真环境来构建大量合成数据,这样的思路在过去对其它行业感知类视觉任务已经证明是非常行之有效的。

业界第二种思路是将这类涉及交通安全事件的发生概率降低到人类可以接受或者可以忽略的水平。如图11所示,解决问题的途径包括协同CAV技术,即通过对道路基础设施部署大量的多模传感设备(Camera, LIDAR, Radar),通过 V2V,V2I(例如路边边缘计算设备RSD)和V2X通信技术来提供车车或者车路协同来实现知识与信息共享,有效解决单个AVs由于遮挡和有限视野问题产生的难决策的僵局。相对而言,单AV的多摄像头、多模融合感知多任务共享,以及CAV(V2V,V2I)之间跨摄像头、跨模感知融合技术目前已经有非常明显的进展。

对目标检测任务而言,一个主要的发展趋势,是从CNN(Compute-bound)向Transformer (memory-bound)演进。CNN目标检测方法包括常用的Two-Stage Candidate-based常规检测方法(Faster-RCNN)和One-Stage Regression-based 快速检测方法(YOLO, SSD, RetinaNet, CentreNet)。Transformer目标检测方法包括DETR, ViT, Swin Transformer, Detection Transformer (如Error! Reference source not found.所示)等等。两者之间的主要差别是目标感知场的尺寸,前者是局部视野,侧重目标纹理,后者是全局视野,从全局特征中进行学习,侧重目标形状。

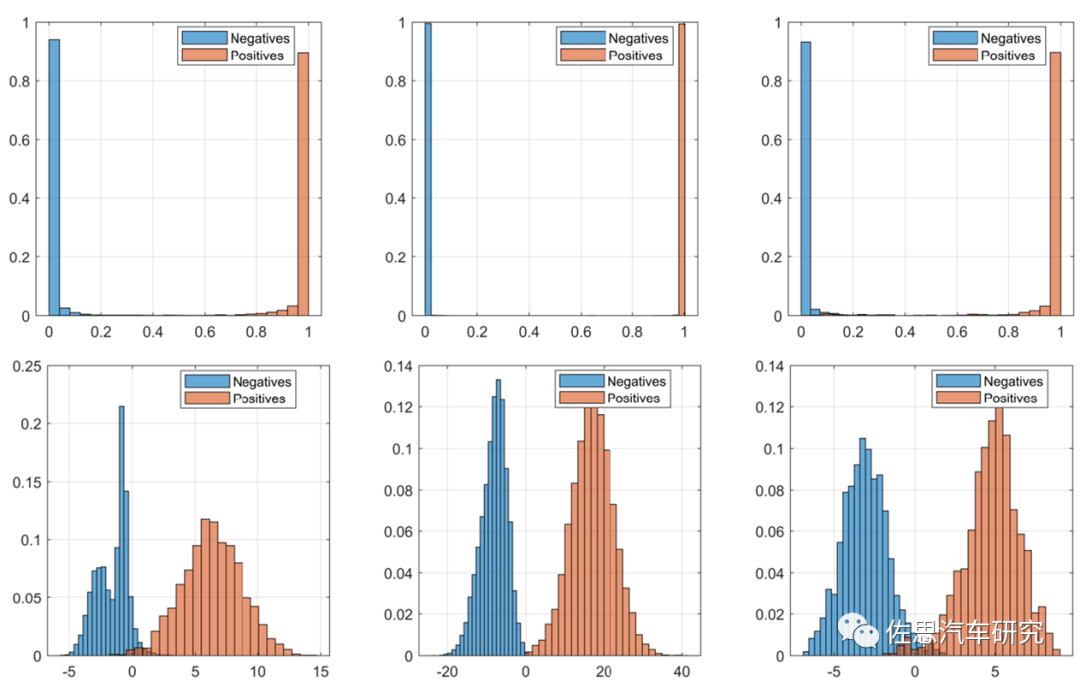

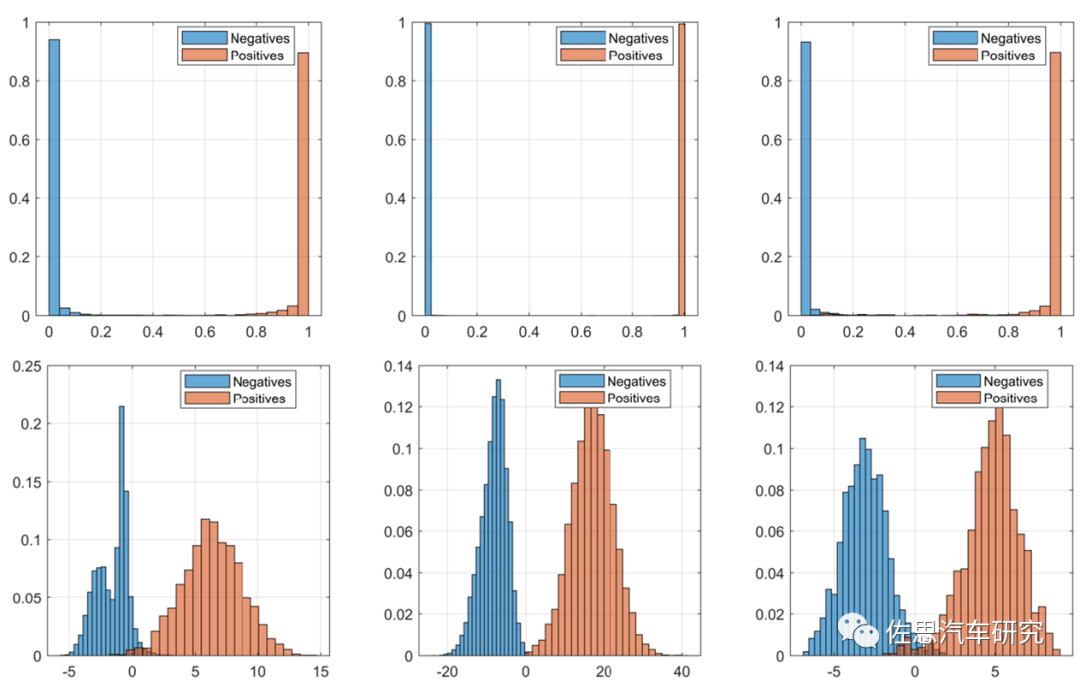

对于这些目标检测识别的SOTA深度学习DL模型而言,采用Softmax或者Sigmoid层做预测输出,一个常见的问题是,由于遮挡等多因素原因,会导致网络层产生过高的置信度预测,会远偏离实际的概率分布score,如图17所示。而且DNN网络越深,神经元越多,这种叫做Overconfidence的交叉效应也越明显。对应感知输出结果会极大影响ADS决策甚至会产生错误决策。一种可行的技术策略是在DNN中添加一个基于贝叶斯最大似然率ML或最大后验概率MAP的推理层,这种基于目标识别的概率特性可解释性强,更值得信赖。

图17:Softmax过高置信度分布VS概率密度分布的案例(Melotti 2022)

ADS算法设计的一个艰巨任务是如何减少Overconfidence预测,如何捕获这种预测的不确定性。然而这类不确定性估计和对应基于安全的设计是一个很大的挑战,不确定性与采用的算法形态(模块化的或者端到端的;多模态实现;深度融合或者部分模块联合建模的策略)、数据规模、不确定性的量化表征(熵、交互信息、KL Divergence、预测方差)、多智能体的交互状态和行为都非常相关,也不容易建模,所以有改善,仍待从理论的角度进行提高,这也是当前学术研究的一个最大热点,即如何有效对ADS系统进行概率估计,确保AVs车辆在行驶中保持在一个安全状态。一些有效的尝试包括采用Generalized Polynomial Chaos(GPC)混沌学GPC模型来取代感知模型中的复杂度感知分量,并用来评估加入不安全状态的状态分布或者是概率,评估的准确度很接近Monte Carlo仿真,并有几倍计算速度提升。

ADS感知的数据驱动DDM模型,其安全可信某种程度上其实是来自与训练数据中隐含的行为定义,这对实现ADS安全至上的感知带来了大挑战。实际行驶应用中(可以认为是随机的、部分可观察的交互环境)可以通过对当前运行状态的不确定性进行估计,进而调整系统随后的行为,和基于这些估计决定AVs的安全距离控制。

参考文献:

【1】Z. Wu and etc., “DST3D: DLA-Swin Transformer for Single-Stage Monocular 3D Object Detection”, https://ieeexplore.ieee.org/document/9827462

【2】W. Wang and etc., “Towards Data-Efficient Detection Transformers”, https://arxiv.org/abs/2203.09507

【3】S. Nageshrao and etc., “Robust AI Driving Strategy for Autonomous Vehicles”, https://arxiv.org/pdf/2207.07829.pdf

【4】M. Khan and etc., “Level-5 Autonomous driving – are we there yet?”, https://www.researchgate.net/publication/358040996

【5】D. Paek and etc., “K-Radar: 4D Radar Object Detection Dataset” https://arxiv.org/pdf/2206.08171.pdf

【6】R. Mao and etc., “perception Enabled Harmonious and Interconnected Self-Driving”, https://arxiv.org/pdf/2207.07609.pdf

【7】L. Fan and etc., “Fully Sparse 3D Object Detection”, https://arxiv.org/pdf/2207.10035.pdf

【8】Z. Hau and etc., “Using 3D Shadows to Detect Object Hiding Attacks on Autonomous Vehicle Perception”, https://arxiv.org/pdf/2204.13973.pdf

【9】Y. Zhang and etc., “Autonomous Driving in Adverse Weather Conditions: A Survey”, https://arxiv.org/pdf/2112.08936v1.pdf

【10】N. Li and etc., “Traffic Context Aware Data Augmentation for Rare Object Detection in Autonomous Driving”,https://arxiv.org/pdf/2205.00376.pdf

【11】G. Melotti and etc., “Reducing Overconfidence Predictions in Autonomous Driving Perception”, https://arxiv.org/pdf/2202.07825.pdf

【12】E. Levy and etc., “EyeDAS: Securing Perception of Autonomous Cars Against the Stereoblindness Syndrome”, https://arxiv.org/pdf/2205.06765.pdf

本文仅做学术分享,如有侵权,请联系删文。

下载1:OpenCV-Contrib扩展模块中文版教程

在「小白学视觉」公众号后台回复:扩展模块中文教程,即可下载全网第一份OpenCV扩展模块教程中文版,涵盖扩展模块安装、SFM算法、立体视觉、目标跟踪、生物视觉、超分辨率处理等二十多章内容。

在「小白学视觉」公众号后台回复:Python视觉实战项目,即可下载包括图像分割、口罩检测、车道线检测、车辆计数、添加眼线、车牌识别、字符识别、情绪检测、文本内容提取、面部识别等31个视觉实战项目,助力快速学校计算机视觉。

在「小白学视觉」公众号后台回复:OpenCV实战项目20讲,即可下载含有20个基于OpenCV实现20个实战项目,实现OpenCV学习进阶。

交流群

欢迎加入公众号读者群一起和同行交流,目前有SLAM、三维视觉、传感器、自动驾驶、计算摄影、检测、分割、识别、医学影像、GAN、算法竞赛等微信群(以后会逐渐细分),请扫描下面微信号加群,备注:”昵称+学校/公司+研究方向“,例如:”张三 + 上海交大 + 视觉SLAM“。请按照格式备注,否则不予通过。添加成功后会根据研究方向邀请进入相关微信群。请勿在群内发送广告,否则会请出群,谢谢理解~