AXM-Net:用于行人检测的跨模式上下文注意力网络

点击上方“小白学视觉”,选择加"星标"或“置顶”

重磅干货,第一时间送达

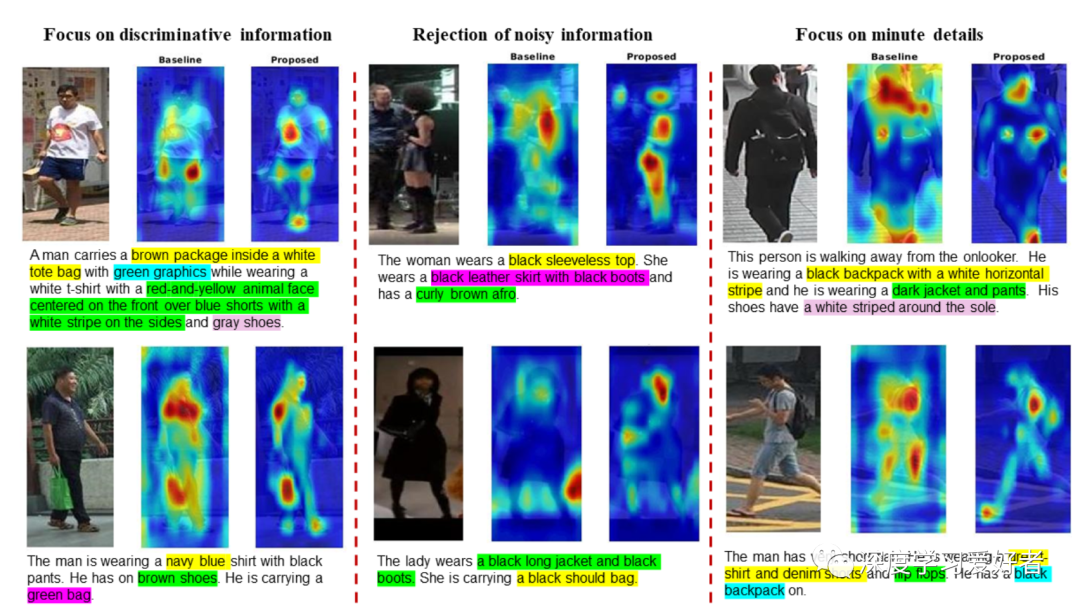

跨模式人员再识别(Re-ID)是现代视频监控系统的关键。关键的挑战是根据为一个人呈现的语义信息来对齐通道间表示,而忽略背景信息。在这项工作中,作者提出了一种新的基于CNN的结构AXM-Net,旨在学习语义对齐的视觉和文本表示。底层的构建块由多个来自视觉和文本形式的特征地图流和一个新的可学习的上下文共享语义对齐网络组成。作者还提出了互补的模内注意学习机制,以关注特征中更细粒度的局部细节,以及用于鲁棒特征匹配的跨模态亲和损失。作者的设计在从数据中隐式学习特征对齐的能力上是独一无二的。整个AXM-Net可以以端到端的方式进行培训。作者报告人员搜索和跨模式重新识别任务的结果。广泛的实验验证了所提出的框架,并通过显著地优于当前最先进的方法来证明其优越性。

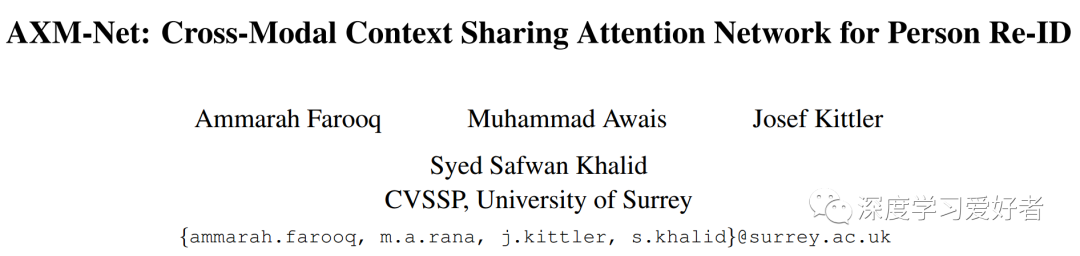

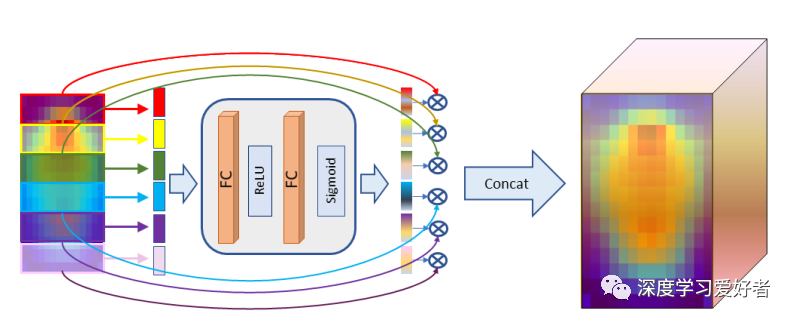

这篇论文的主要思想是将人的视觉和文本特征结合起来,以实现无缝的跨模式或多模式搜索。为了实现这一点,作者提出了AXM-Net,一种基于卷积神经网络(CNN)的新型架构,旨在应对上述挑战,并能够学习语义对齐的跨模态特征表示。该模型的基础构件包括从视觉和文本网络中获取可变数量的局部上下文的特征地图流和基于两种模式的关键线索学习的新的上下文共享语义对齐网络。因此,根据融合的信息参与输出特征映射。上下文共享语义对齐网络利用多尺度、多上下文的模内和模间语义信息,对信息通道进行提升,抑制含有噪声/背景信息的通道。

作者的主要贡献如下:

提出了自适应跨模态上下文共享语义对齐块(AXM-Block),用于捕获上下文感知的共享语义概念,抑制视觉模态和文本模态之间的噪声信息。据作者所知,这是第一个在人的再id设置中跨模式使用内隐语义对齐的工作。

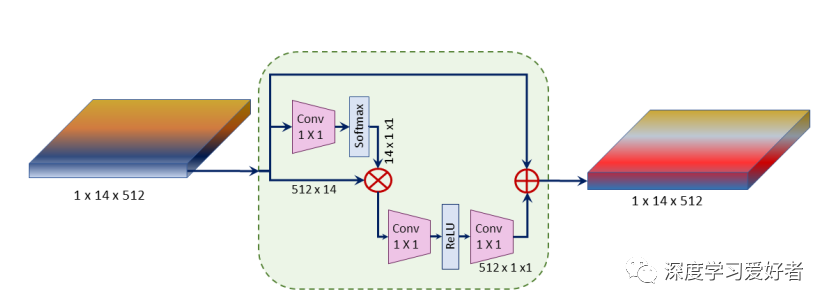

作者提出了有效的模内注意机制,以提取基于局部空间区域的视觉表示细节,同时利用半全局上下文共享和学习文本短语之间的相互依赖。

作者设计了一个跨模态亲和损失模型,该模型基于对齐特征之间的相似性对学习网络进行奖励和惩罚。

大量的实验表明,提出的AXM-Net优于香港中文大学pedes基准上的最先进的(SOTA)人员搜索模型,以及CrossRe-ID和香港中文大学sysu上的跨模式Re-ID。作者还针对著名的Market-1501数据提出了一种跨模态协议。

自适应跨模态上下文共享语义对齐(AXM)块

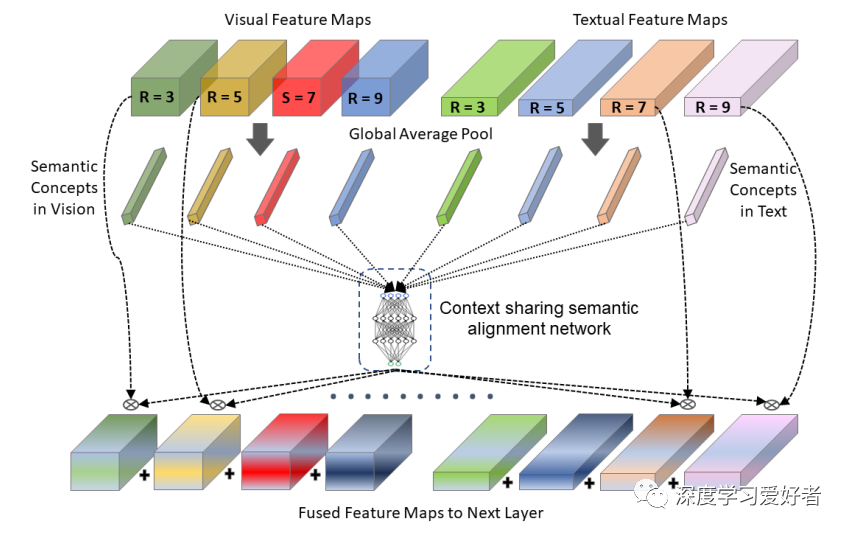

作者的跨模态AXM-Net的图示,它生成全局视觉特征VG,基于局部空间部分的视觉特征VP和文本特征T。用每个视觉特征的文本特征对匹配损失进行成对训练。

注意对视觉特征的局部特征学习

对文本特征的非局部注意

AXM-Net的注意力地图可视化。所提出的网络聚焦于歧视信息和拒绝背景。

在这篇论文中,作者提出了一个新的AXM-Net模型来解决跨模式的人员再识别和搜索问题。作者的创新涉及到来自视觉和文本模式和局部模态内关注的特征的上下文对齐。与现有的方法相比,本文提出的AXM-Net是第一个基于卷积特征学习块、axm -块和跨模态特征的隐语义对齐的框架。语境注意力是通过AXM-block内的共享可学习网络来学习的。实验结果表明,作者的网络在香港中文大学- pedes基准测试中定义了新的SOTA性能,同时也证明了作者所提出的网络在跨模式的重新身份识别应用中的潜力

论文链接:https://arxiv.org/pdf/2101.08238.pdf

交流群

欢迎加入公众号读者群一起和同行交流,目前有SLAM、三维视觉、传感器、自动驾驶、计算摄影、检测、分割、识别、医学影像、GAN、算法竞赛等微信群(以后会逐渐细分),请扫描下面微信号加群,备注:”昵称+学校/公司+研究方向“,例如:”张三 + 上海交大 + 视觉SLAM“。请按照格式备注,否则不予通过。添加成功后会根据研究方向邀请进入相关微信群。请勿在群内发送广告,否则会请出群,谢谢理解~