你的感知损失可能用错了,沈春华团队提出随机权值广义感知损失

极市导读

本文介绍了阿德莱德沈春华老师团队的工作,文章揭示了感知损失最关键的是其网络结构而非其预训练权重,并证实:基于随机权值的CNN可被用于建模输出的结构化依赖性。 >>本周六,极市CVPR2021线下沙龙即将举办,三位CVPR2021论文作者齐聚深圳!【报告三:戴志港-UP-DETR:针对目标检测的无监督预训练transformer】。点击蓝字即可免费报名,名额有限,先到先得!

本文是阿德莱德沈春华老师团队在“感知损失对于结构化输出依赖性建模影响”方面的一次有意思的探索之旅。从图像生成任务中的感知损失影响出发,揭示了感知损失的成功关键在于网络结构而非预训练权值;在此基础上,将其进一步扩展到更广义的稠密预测任务(比如语义分割、实例分割等)上,并通过实验验证了所提广义感知损失的有效性;甚至,当单阶段目标检测器配上Mask翅膀上,该损失还可以进一步提升目标检测的性能。原文链接:https://arxiv.org/abs/2103.10571

Abstract

感知损失作为一种有效损失已被广泛应用在图像生成类任务中,比如图像超分、风格迁移等,感知损失的成功往往被归因于预训练模型能够提取图像的高级感知特征。在这篇文章中,我们揭示了感知损失最关键的是其网络结构而非其预训练权重。无需任何学习,深度网络的结构足以捕获多层CNN所提取的多级统计信息之间的相关性。该发现移除了预训练与特定网络架构(通常为VGG)假设,因而引发了更广泛的应用。我们证实:基于随机权值的CNN可被用于建模输出的结构化依赖性。在多个稠密预测任务(比如语义分割、深度估计、实例分割)上,相比仅仅采用像素损失,采用扩展的随机感知损失可以进一步提升模型的性能。我们期望这种简单的、扩展感知损失可以作为一种广义结构输出损失用于结构输出学习任务中。本文的主要贡献包含以下几点:

证实感知损失的成功并非源于预训练权值,而是源于CNN结构; 将所提广义感知损失应用到多个结构化输出任务上可以看到显著性能提升; 探索了初始化与网络结构是如何影响所提感知损失的性能; 所提感知损失可以作为一种广义结构化输出损失应用到大部分结构化输出学习任务中。

Introduction

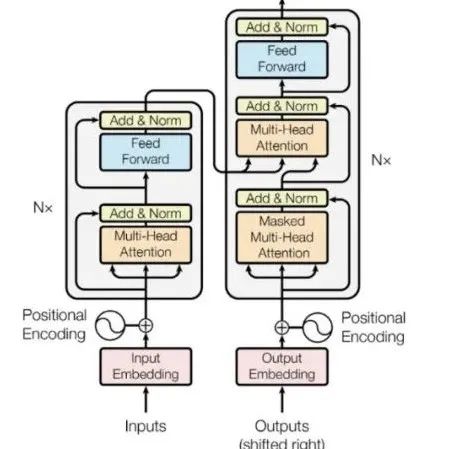

在之前的研究中,感知损失往往采用在ImageNet上预训练的模型提取图像的高级感知特征然后再计算损失,称之为感知损失。基于该假设,感知损失往往采用预训练VGG16/VGG19计算。

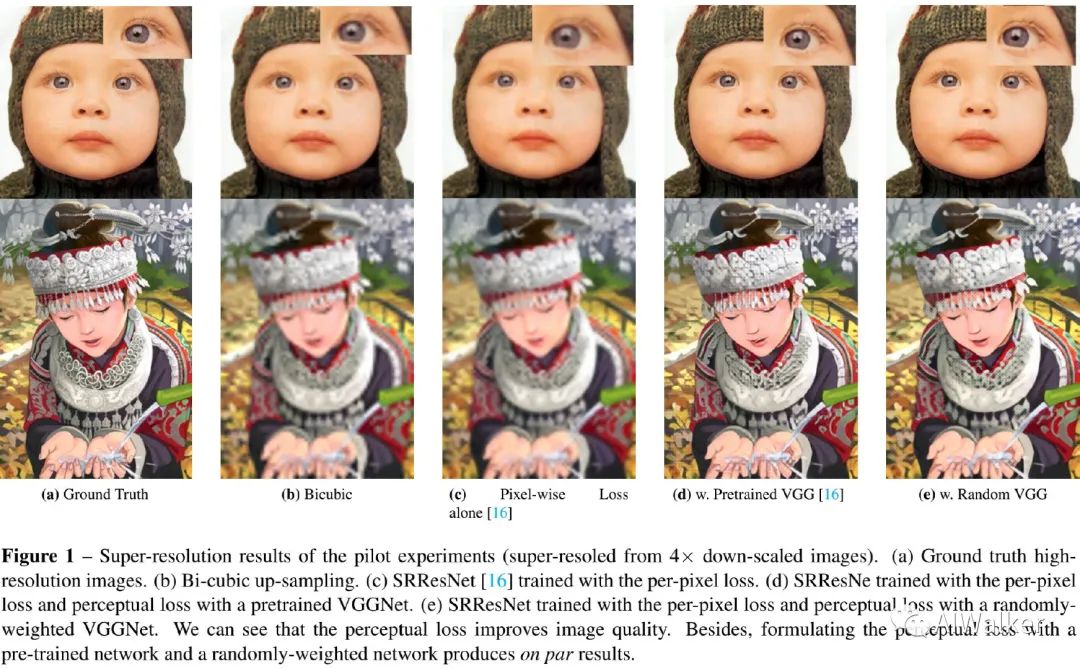

我们发现:不同于前述假设,感知损失的成功并非预训练模型而是多层CNN结构,它足大量输出的交互统计信息。为验证该结论,我们在图像超分任务上进行了一个简单的实验,结果见下图。

从上图可以看到:相比简单的像素损失,预训练VGG与随机权重VGG均取得了显著的视觉效果提升,且两者视觉效果相当。这就意味着:预训练权值并非感知损失成功的关键。

Method

前述实验结果表明:感知损失成功的关键是网络结构而非预训练权重。接下来,我们将对感知损失进行扩展以适用到更多结构化输出学习任务;然后我们深入分析了权值初始化的影响并设计了一种近似方案用于有效初始化。

Generic Perception Loss

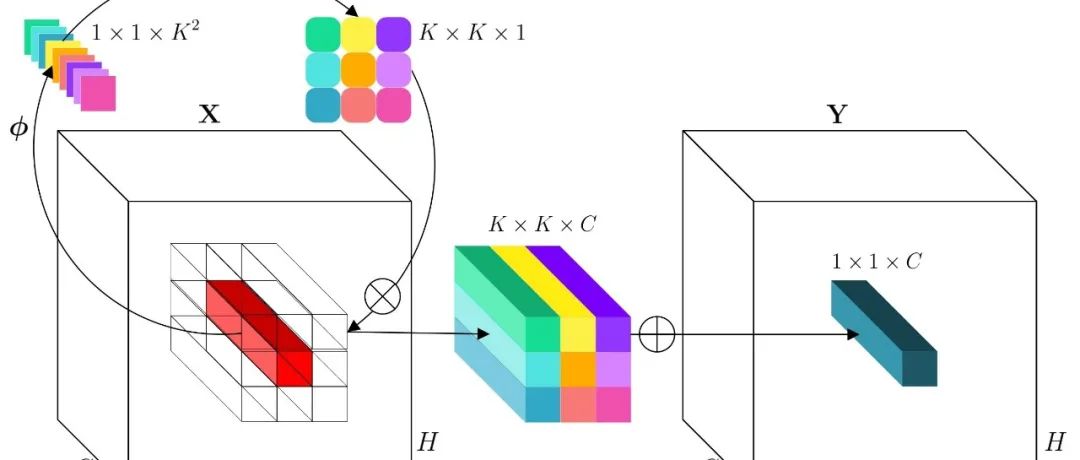

如果随机权值模型有助于捕获结构化信息,那么它同样对于稠密预测问题有效,由于不需要预训练权值,可以轻易的将其作为正则项用于任意任务并比较不同感知损失网络的性能。我们采用常规VGG网络作为出发点,采用表示最大值池化之间的卷积数量。

Semantic Segmentation。为将感知损失扩展到语义分割任务中,我们采用估计的分割图或者真值作为感知损失网络的输入,可以得到由CNN提取到的嵌入结构化特征,最后采用MSE最小化两者之间的距离。由于softmax输出与one-hot真值之间的域差异使得感知损失难以收敛。为解决该问题,我们参考《Structured Knowledge Distillation》采用大的老师网络生成软标签作为学习目标,此时整体损失函数定义如下:

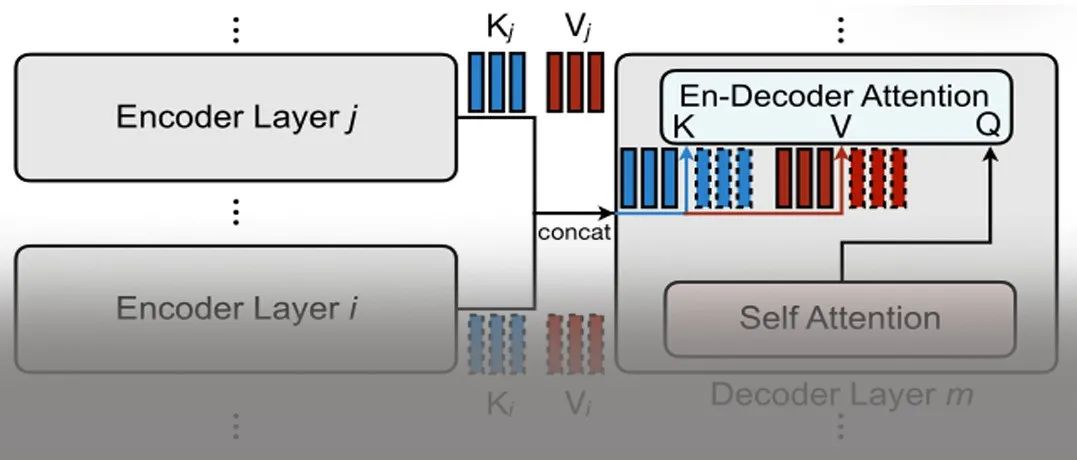

Depth Estimation。深度估计是一种回归问题,它用来图像中每个像素对应的目标与camera的距离,网络将输出一个深度图像。由于真值与预测图像具有相同的统计分布,因此它们可以直接作为感知损失网络的输入。 Instance Segmentation。实例分割是最具挑战的CV任务之一,它需要精确的预测每个像素对应的目标和语义信息。它采用了与语义分割类似的方式,将老师网络生成的软标签作为学习目标并送入感知损失网络中。

Devils in the Initialization

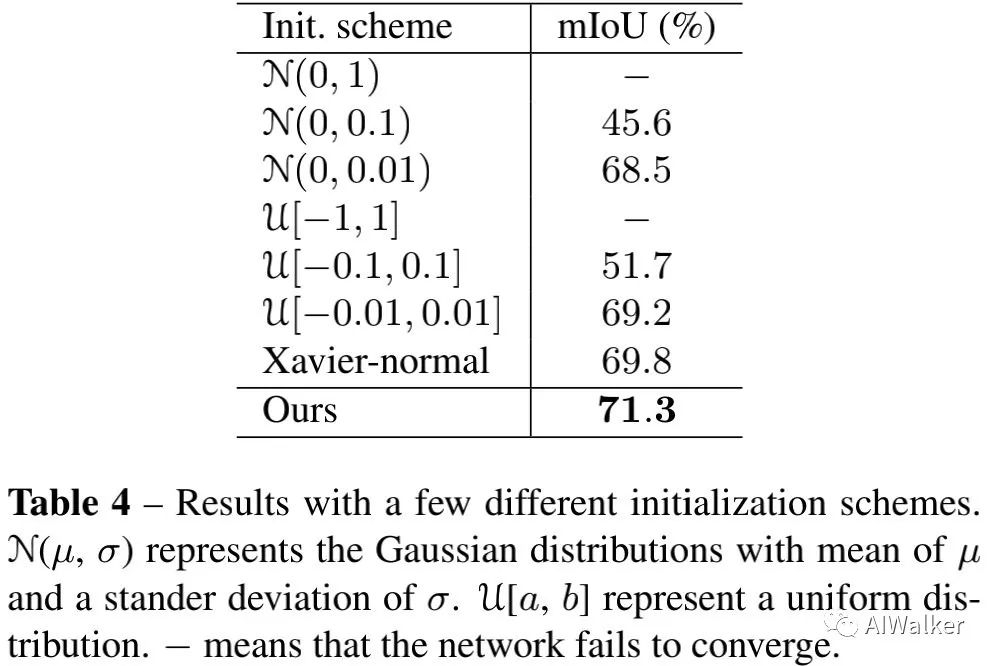

随机权值网络的初始化方式会影响广义感知损失的性能。由于我们采用结构化预测作为感知损失的输入并生成一个嵌入向量,不合理的初始化可能导致不稳定的结果。因此很有必要确保每一层的Lipschitiz接近1,因而确保了随机网络的梯度不会爆炸或者消失。我们对随机网络的梯度尺度进行了探索并得出一种鲁邦初始化方法。对于稠密预测任务来首,我们有预测结果与真值/软标签,随机权值感知损失网络会将两者变换到嵌入空间。那么广义感知损失定义如下:假设对应了卷积核的响应激活值,此时有:基于深度卷及网络,此时有,其中表示ReLU激活函数。如果我们采用零附近的对称分布对权值进行初始化,且,此时均具有零均值且对称分布。此时嵌入层的方差如下:

当L无限大时,就会导致爆炸或者消失。因此,我们采用标准差为的零均值高斯分布进行初始化。在优化开始时,之间的相关性很小;随着训练的进行,会朝着Y进行优化,两者之间的协方差朝着1进行优化,两者之间的嵌入距离则朝着0优化。

Experiments

我们先对感知损失的几个感兴趣问题进行探索;然后采用一种有效的结构作为感知损失并说明其在稠密预测任务上的性能提升。

Discussions

关于感知损失,有这样几个有意思的问题:

Will the trained filters help the perceptual loss in dense prediction problems? How does the depth/receptive filed/multi-scale losses affect the performance? How does the initializaton affect the performance?

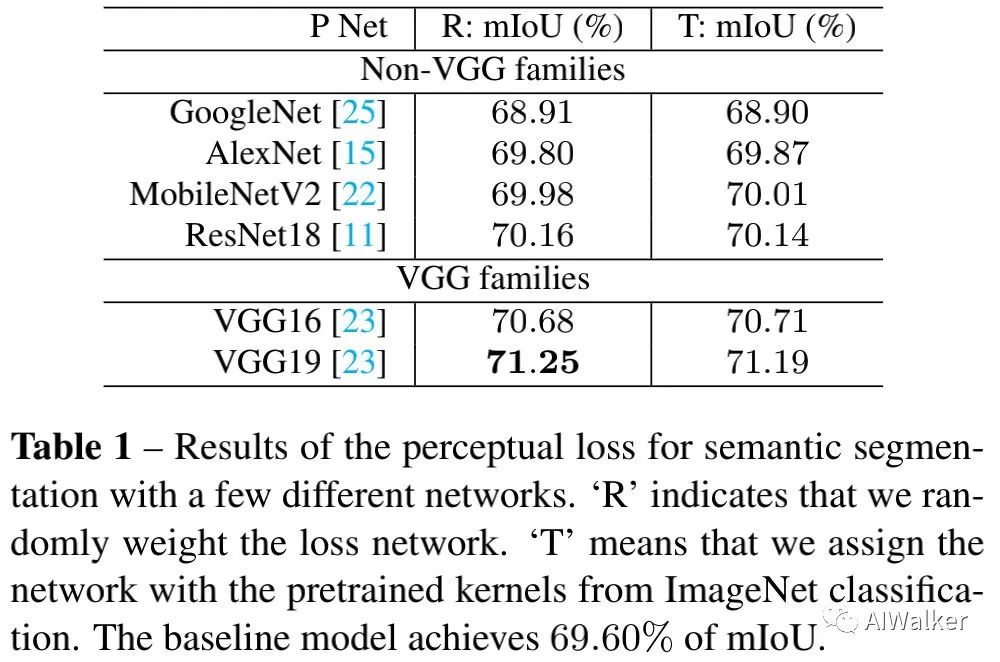

为说明第一个问题,我们基于语义分割任务做了一个简单的实验,结果见上表。从上表数据与对比可以看到:

随机权值与预训练权值在性能上几乎没有差异(差异范围在0.02%~0.06%之间);但是不同结构之间的差异非常大(从68.9%~71.25%)。这意味着:对于结构化输出学习任务来说,ImageNet上的预训练权值并非感知损失成功的关键,相反,网络结构才是其中关键因素。 VGG类架构明显优于其他结构。已有研究同样表明:在风格迁移任务上,VGG结构的效果要优化ResNet并解释了VGG要比ResNet更为鲁棒。

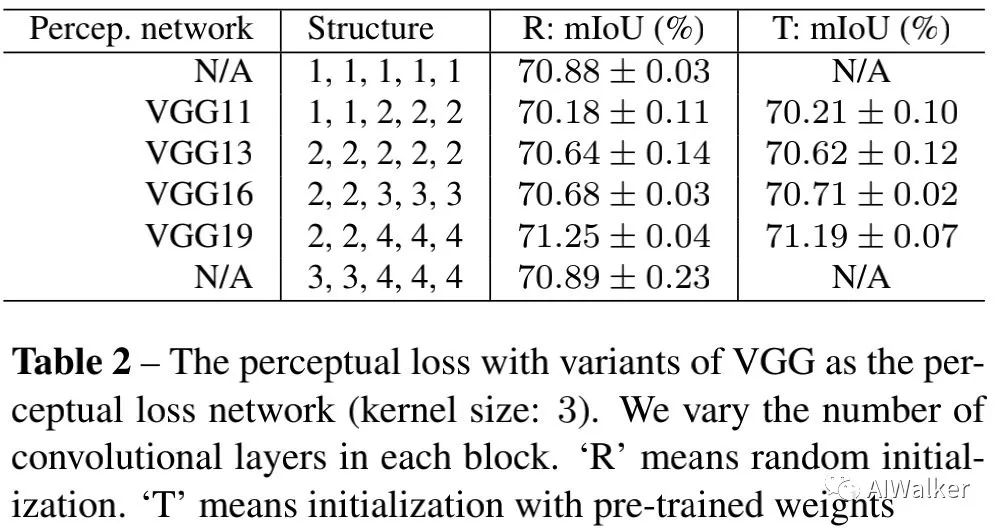

为回答第二个问题,我们设计了一系列实验,包含不同深度、不同卷积核的VGG网络结构。结果见下表,可以看到:(1)预训练核不会带来性能提升,相反网络结构影响很大;(2)VGG19为其中最佳感知损失函数;(3)考虑到有效性与高效性,1,1,1,1,1组合会是最佳选择。

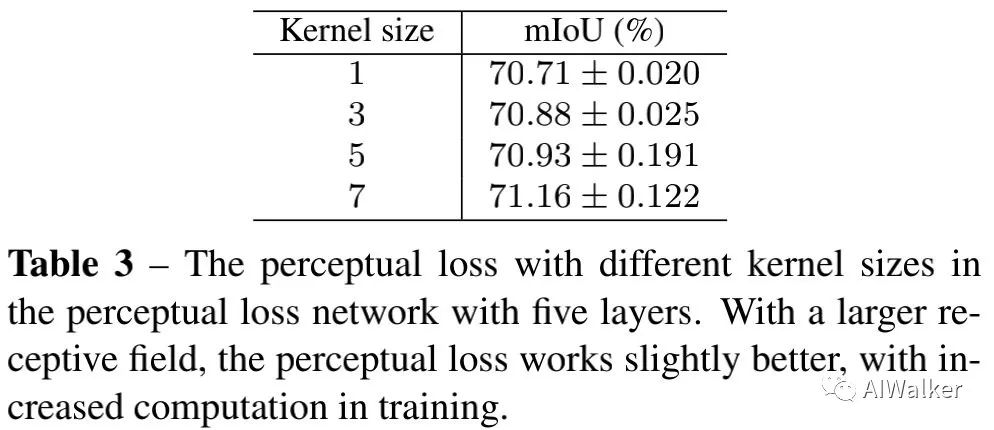

与此同时,我们还给出了感受野的影响性分析,见下表。更大的核尺寸可以带来稍好的性能(从70.71%提升到71.16%)。

为回答最后一个问题,我们采用不同的初始化方法进行了对比分析,结果见下表。

Application

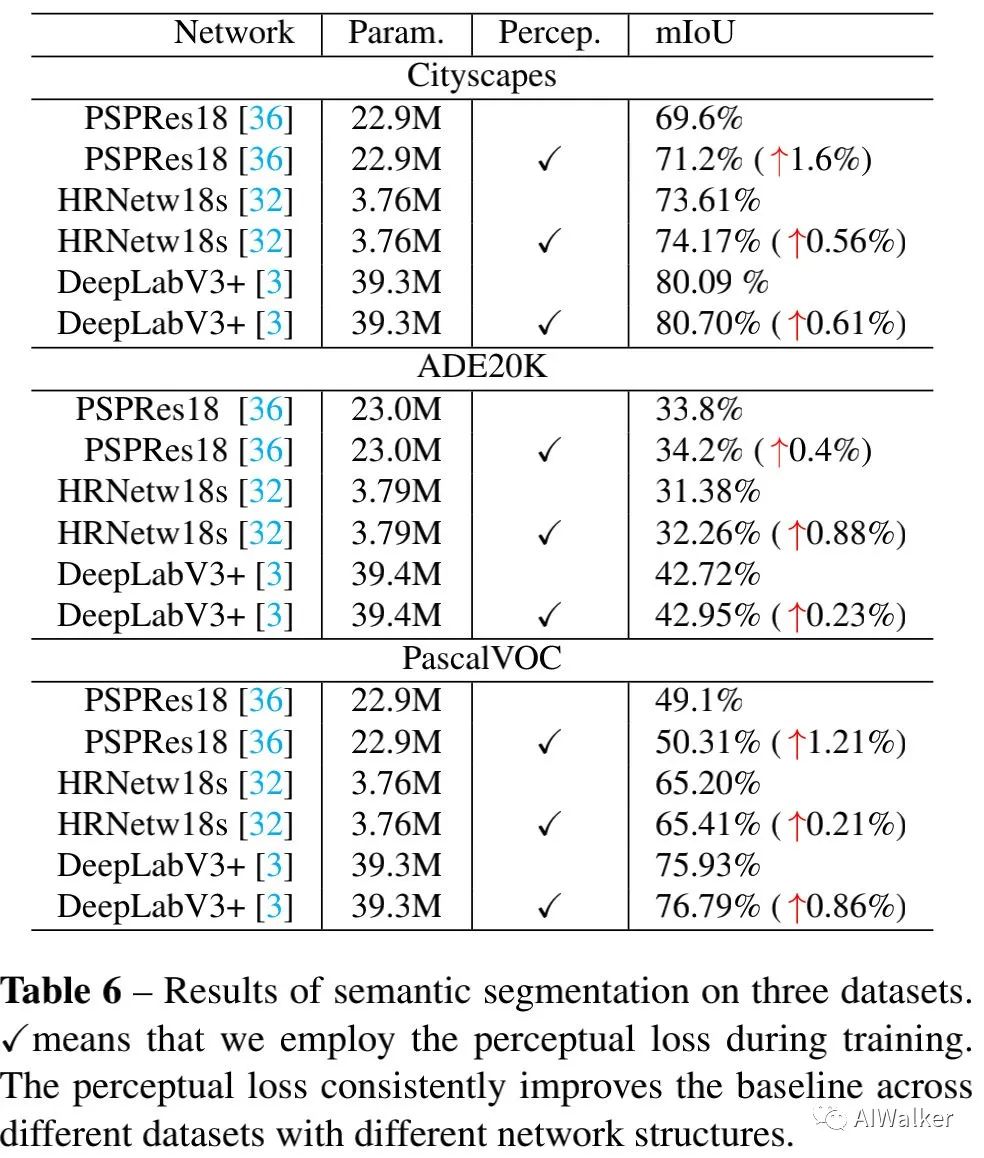

上表给出了不同语义分割数据集、不同分割网络添加该损失前后的性能对比。看一看到:广义感知损失可以一致性的提升现有语义分割网络的性能(0.21%~1.6%不等)。

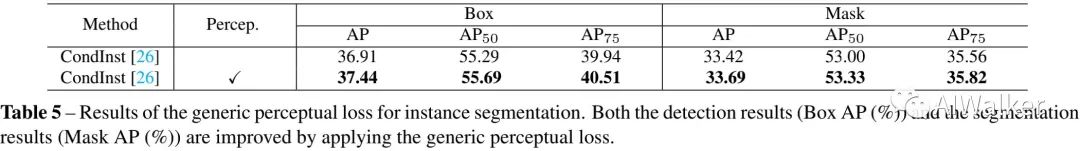

上表给出了实例分割任务上的性能对比。可以看到:广义感知损失对于两个任务咋所有质量上均有显著提升。该实验进一步说明:当类似CondInst将Mask分支添加到单阶段目标检测方法上时,广义感知损失甚至可以提升目标检测的性能。

推荐阅读

2021-03-23

2021-03-23

2021-03-22

# CV技术社群邀请函 #

备注:姓名-学校/公司-研究方向-城市(如:小极-北大-目标检测-深圳)

即可申请加入极市目标检测/图像分割/工业检测/人脸/医学影像/3D/SLAM/自动驾驶/超分辨率/姿态估计/ReID/GAN/图像增强/OCR/视频理解等技术交流群

每月大咖直播分享、真实项目需求对接、求职内推、算法竞赛、干货资讯汇总、与 10000+来自港科大、北大、清华、中科院、CMU、腾讯、百度等名校名企视觉开发者互动交流~