非LVM的xfs文件系统扩容

目录

1、LVM 的由来

2、为什么不用 LVM

3、扩容操作流程

1、LVM 的由来

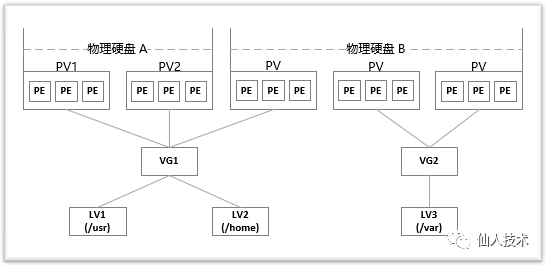

LVM(Logical Volume Manager),即逻辑卷管理,它是Linux环境下对磁盘分区进行管理的一种机制

一般来说,物理磁盘或分区之间是分隔的,数据无法跨盘或分区,而各磁盘或分区的大小固定,重新调整比较麻烦。LVM的出现就是将这些底层的物理磁盘或分区整合起来,抽象成容量资源池,以划分成逻辑卷的方式供上层使用,其最主要的功能即是可以在无需关机、无需重新格式化的情况下弹性调整逻辑卷的大小(准确地说,原来的部分无需格式化,只格式化新增的部分)

由此可见,LVM给磁盘管理带来了很大的便利性

2、为什么不用 LVM

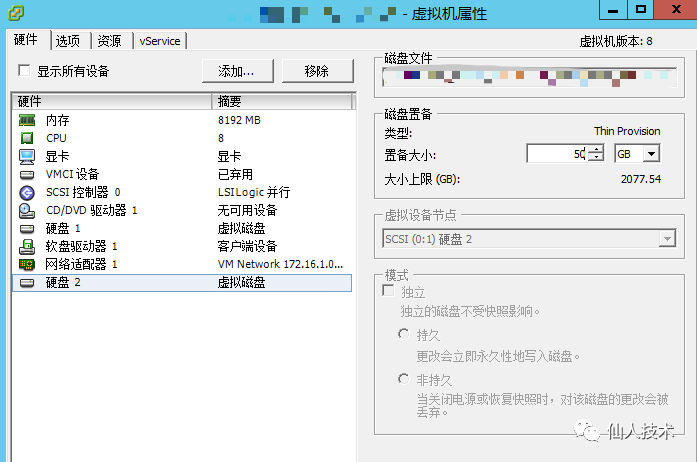

现如今,在虚拟化、公有云盛行的时代,有了更强大的底层平台支持,就不需要再基于每一块硬盘去操作维护LVM了,因为有了虚拟化、公有云、分布式存储等等多种可对底层存储硬盘操作的方式,例如公有云服务器如果想扩容,只需要在用户控制台界面上直接扩容云硬盘即可。虚拟化平台也是一样,只需要在虚拟机配置界面增加硬盘大小即可。至于底层由多少块硬盘、总共有多大的存储池,一般是不需要关心的

因此,如果基于私有云自建虚拟化平台、或是公有云平台创建的服务器再去做LVM,就没有必要了

另外一方面,存储扩容方便时,对挂载的硬盘做逻辑分区也是没有必要的了

我们只需要

添加硬盘——>格式化文件系统——>挂载到服务器挂载点

or

扩容硬盘——>扩容服务器磁盘

3、扩容操作流程

本文记录的是CentOS 7非LVM的xfs文件系统下对硬盘扩容的操作流程,底层虚拟化平台是VMware ESXi,具体操作如下

查看当前磁盘大小,/dev/sdb的存储总量是20G,是直接挂载的一块数据盘

# df -h

Filesystem Size Used Avail Use% Mounted on

...

/dev/sdb 20G 33M 20G 1% /mnt

首先停掉对挂载点/mnt有读写的服务或程序,卸载磁盘

# umount /mnt

关机扩容,扩容后再重新开机(新加磁盘时可以热添加新磁盘,这里是扩容操作,由于已有数据为了降低风险关机后进行操作)

开机后,可以对磁盘设备进行一下文件系统的修复

# xfs_repair /dev/sdb

Phase 1 - find and verify superblock...

Phase 2 - using internal log

- zero log...

- scan filesystem freespace and inode maps...

- found root inode chunk

Phase 3 - for each AG...

- scan and clear agi unlinked lists...

- process known inodes and perform inode discovery...

- agno = 0

- agno = 1

- agno = 2

- agno = 3

- process newly discovered inodes...

Phase 4 - check for duplicate blocks...

- setting up duplicate extent list...

- check for inodes claiming duplicate blocks...

- agno = 0

- agno = 2

- agno = 3

- agno = 1

Phase 5 - rebuild AG headers and trees...

- reset superblock...

Phase 6 - check inode connectivity...

- resetting contents of realtime bitmap and summary inodes

- traversing filesystem ...

- traversal finished ...

- moving disconnected inodes to lost+found ...

Phase 7 - verify and correct link counts...

done

扩容磁盘,xfs_growfs针对xfs文件系统,resize2fs针对ext2、ext3、ext4 文件系统

# xfs_growfs /dev/sdb

meta-data=/dev/sdb isize=512 agcount=4, agsize=1310720 blks

= sectsz=512 attr=2, projid32bit=1

= crc=1 finobt=0 spinodes=0

data = bsize=4096 blocks=5242880, imaxpct=25

= sunit=0 swidth=0 blks

naming =version 2 bsize=4096 ascii-ci=0 ftype=1

log =internal bsize=4096 blocks=2560, version=2

= sectsz=512 sunit=0 blks, lazy-count=1

realtime =none extsz=4096 blocks=0, rtextents=0

data blocks changed from 5242880 to 13107200

重新挂载

# mount /dev/sdb /mnt/

检查

# lsblk /dev/sdb

NAME MAJ:MIN RM SIZE RO TYPE MOUNTPOINT

sdb 8:16 0 50G 0 disk /mnt

# df -h|grep /mnt

/dev/sdb 50G 33M 50G 1% /mnt

查看目录下原有的数据,没有问题,至此扩容完成