【消息队列】常见5种消息队列介绍及入门教程!ActiveMQ、kafka、RabbitMQ等

消息队列是分布式应用间交换信息的重要组件,消息队列可驻留在内存或磁盘上, 队列可以存储消息直到它们被应用程序读走。 通过消息队列,应用程序可以在不知道彼此位置的情况下独立处理消息,或者在处理消息前不需要等待接收此消息。 所以消息队列可以解决应用解耦、异步消息、流量削锋等问题,是实现高性能、高可用、可伸缩和最终一致性架构中不可以或缺的一环。

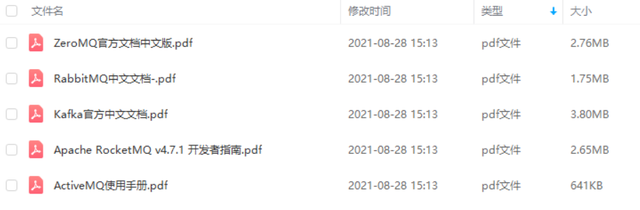

ps:学习资料已打包,文末领取!

1、ActiveMQ

pdf来源网络,侵删 最新使用文档请移步至官网:

https://activemq.apache.org/

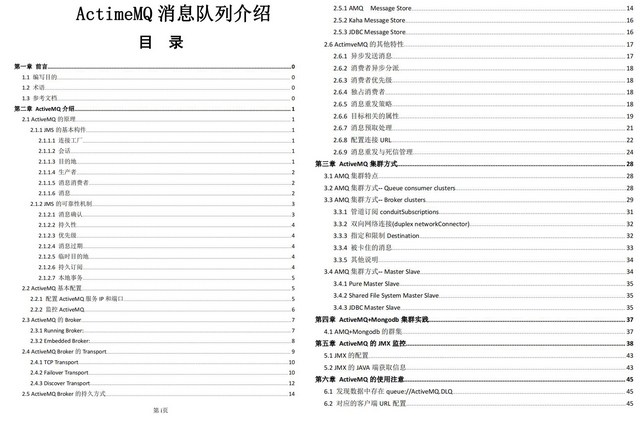

教程分享:《ActiveMQ使用手册》

教程分享:《ActiveMQ使用手册》

本文档第二部分介绍了 ActiveMQ 的原理和重要配置介绍,第三部门介绍群集搭建方式 , 分析各种集群方式的优缺点 ,第四部分实战搭建Master-Slave+Broker-Custer 的群集,第五部分是对 ActiveMQ 的监控,可以通过JMX 接口直接获取当前的消息情况,第六部分是对 ActiveMQ 使用要注意的情况。对于清楚 JMS 和 ActiveMQ 熟悉的,需要对 ActiveMQ 做集群处理,可以跳过第二、三章直接看第四章实践。

2、RabbitMQ

pdf来源网络,侵删 最新使用文档请移步至官网:https://www.rabbitmq.com

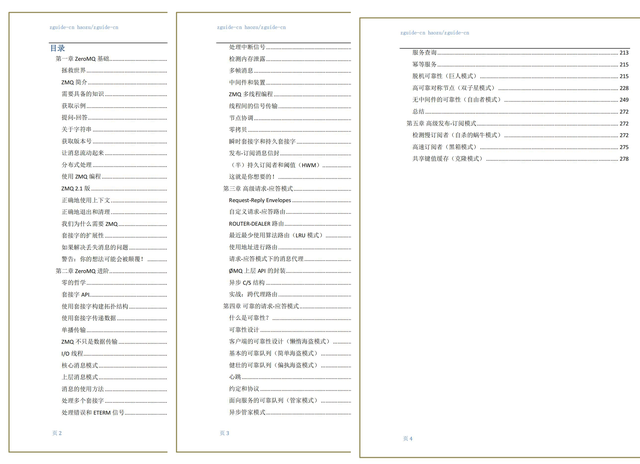

3、ZeroMQ

pdf来源网络,侵删 最新使用文档请移步至官网:https://zeromq.org/

本篇文档共300+页,五大章内容: 第一章 ZeroMQ 基础 第二章 ZeroMQ 进阶 第三章 高级请求-应答模式 第四章 可靠的请求-应答模式 第五章 高级发布-订阅模式

4、Kafka

pdf来源网络,侵删 最新使用文档请移步至官网:http://kafka.apache.org/

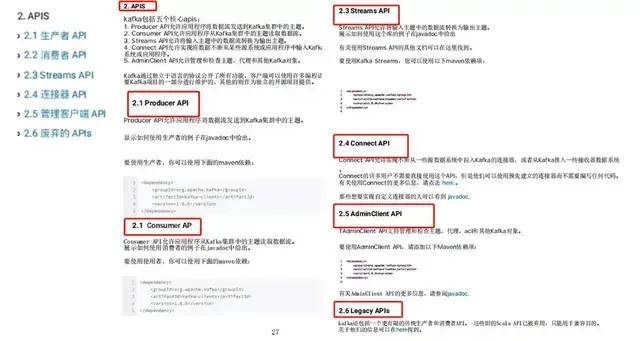

2. Consumer API允许应用程序从Kafka集群中的主题读取数据流。

3. Streams API允许将输入主题中的数据流转换为输出主题。

4. Connect API允许实现将数据不断从某些源系统或应用程序中输入Kafka的连接器,或从Kafka输入某些接收器系统或应用程序。

5. AdminClient API允许管理和检查主题,代理和其他Kafka对象。

5、 RocketMQ

教程分享:《Apache RocketMQ v4.7.1 开发者指南》

pdf来源网络,侵删 最新使用文档请移步至官网:

http://rocketmq.apache.org/

如何获取以上资源

▲▲▲

*声明:部分资料源自网络,PDF版仅做分享学习,侵删

评论