通俗解构语言大模型的工作原理

来源:OneFlow 本文约12000字,建议阅读5分钟

语言大模型内部究竟是如何工作的?本文用最少的数学知识和术语进行解释。

如今,几乎每个人都听说过LLM,并有数千万人用过它们,但是,了解工作原理的人并不多。你可能听说过,训练LLM是用于“预测下一个词”,而且它们需要大量的文本来实现这一点。但是,解释通常就止步于此。它们如何预测下一个词的细节往往被视为一个深奥的谜题。

其中一个原因是,这些系统的开发方式与众不同。一般的软件是由人类工程师编写,他们为计算机提供明确的、逐步的指令。相比之下,ChatGPT是建立在一个使用数十亿个语言词汇进行训练的神经网络之上。

因此,地球上没有人完全理解LLM的内部工作原理。研究人员正在努力尝试理解这些模型,但这是一个需要数年甚至几十年才能完成的缓慢过程。

然而,专家们确实对这些系统的工作原理已有不少了解。本文的目标是将这些知识开放给广大受众。我们将努力解释关于这些模型内部工作原理的已知内容,而不涉及技术术语或高级数学。

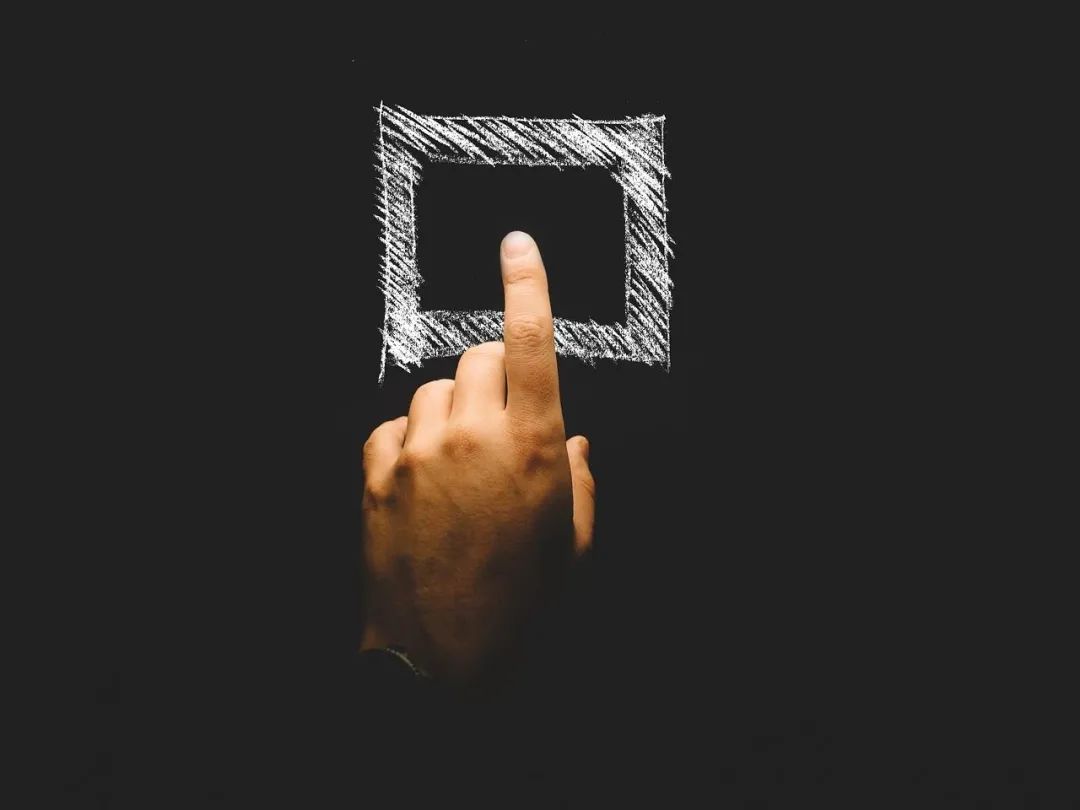

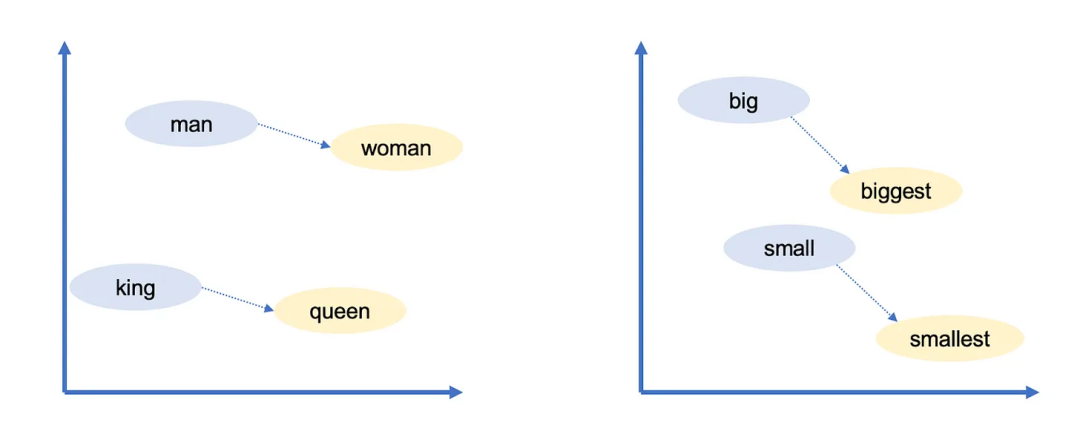

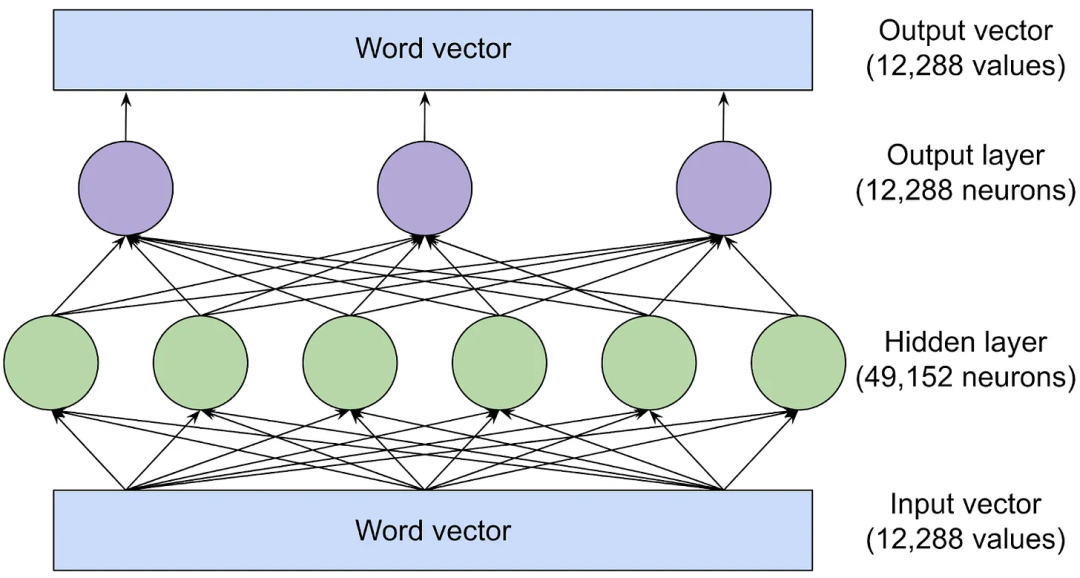

我们将从解释词向量(word vector)开始,它是语言模型表示和推理语言的一种令人惊讶的方式。然后,我们将深入探讨构建ChatGPT等模型的基石Transformer。最后,我们将解释这些模型是如何训练的,并探讨为什么要使用庞大的数据量才能获得良好的性能。

编辑:王菁

评论