【关于 逻辑回归】那些你不知道的事

贡献者:姚鑫、艾春辉,芙蕖,李玲

个人github:https://github.com/km1994/nlp_paper_study

论文标题:Self-training Improves Pre-training for Natural Language Understanding

论文地址:https://arxiv.org/abs/2010.02194

个人介绍:大佬们好,我叫杨夕,该项目主要是本人在研读顶会论文和复现经典论文过程中,所见、所思、所想、所闻,可能存在一些理解错误,希望大佬们多多指正。

【注:手机阅读可能图片打不开!!!】

一、介绍篇

1.1什么是逻辑回归

LR是Logistic Regression Classifier,本质上是线性回归,特殊之处在于特征到结果的映射中加入了一层逻辑函数g(z),即先把特征线性求和,然后使用函数g(z)作为假设函数来预测。g(z)可以将连续值映射到0 和1。逻辑回归使用的g(z)函数是sigmoid函数。因此逻辑回归=线性回归 + sigmoid。

逻辑回归的表达式为

图像

1.2逻辑回归的优势

逻辑回归的优点:

它是直接对分类可能性进行建模,无需实现假设数据分布,这样就避免了假设分布不准确所带来的问题;

它不是仅预测出“类别”,而是可得到近似概率预测,这对许多需利用概率辅助决策的任务很有用;

逻辑回归函数是任意阶可导的凸函数,有很好的数学性质,现有的许多数值优化算法都可直接用于求取最优解。

对于线性数据,(大部分时候)逻辑回归的拟合和计算都非常快,计算效率优于SVM和随机森林

二、推导篇

2.1逻辑回归推导

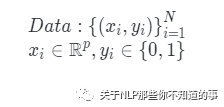

假设数据集为

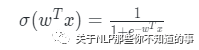

sigmoid函数为

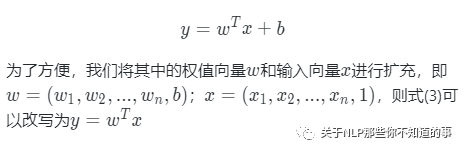

在线性回归中有

2.2求解优化

评论