菜鸟的系统架构师如何应对交易系统激增的系统流量

物流系统的难题

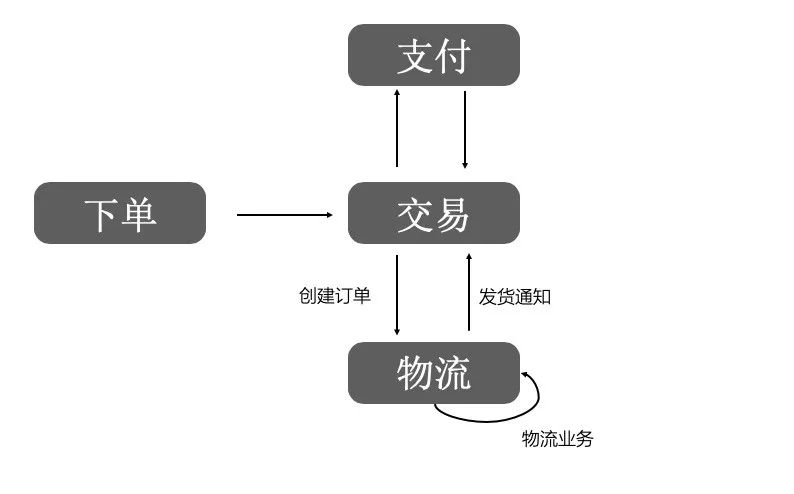

菜鸟的物流系统脱胎于天猫、共享交易,系统之间存在着"打断腿连着皮"的紧密的联系,多年来双方配合默契,承担着整个泛电商业务最核心的链路。

双十一的巨大成本压力

仅分析2015年双十一峰值背后的业务数据,其中0点起创建的订单,在前一个小时完成发货的订单仅有几十万,相比支付订单量可以说九牛一毛,可以看出,支撑大流量高并发的订单创建,并非物流领域自身业务的刚需驱动,而更多的是为了保障交易-支付-物流链路的稳定。

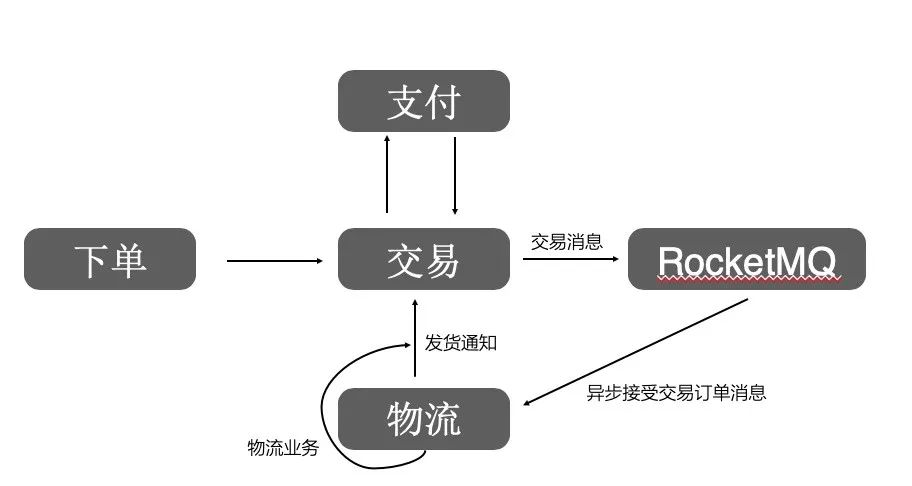

RocketMQ——菜鸟架构师的选择

这也是菜鸟的系统架构师王维在 2016 年双十一前面对的最大挑战,那一年双十一的订单创建峰值要从 15 年的 18 w 涨到 30 w。他要做一次意义重大的升级,让交易和菜鸟的业务能更清晰的划清业务模型和链路,让天猫快速激增的系统流量不再让菜鸟系统追赶,让菜鸟能专注去完成物流领域内的事情,让天猫交易能更专注的保障交易链路的稳定。

本文缩略图:icon by 白小强

推荐阅读:

喜欢我可以给我设为星标哦

喜欢我可以给我设为星标哦

评论