【论文解读】Graph Normalization (GN):为图神经网络学习一个有效的图归一化

极市专栏

论文推荐:在图神经网络里面,应该如何选择更好的归一化技术?本文将介绍一种为图神经网络学习有效的图归一化的方式。

摘要

Learning Graph Normalization for Graph Neural Networks

https://arxiv.org/abs/2009.11746

Source Code:

https://github.com/cyh1112/GraphNormalization

背景

核心思想介绍

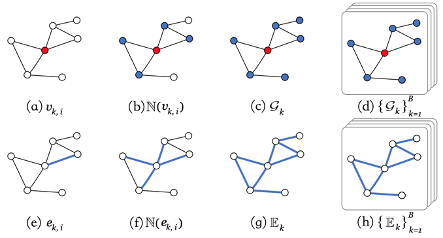

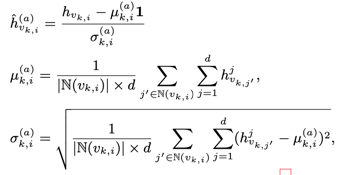

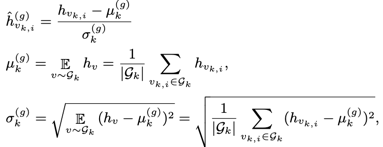

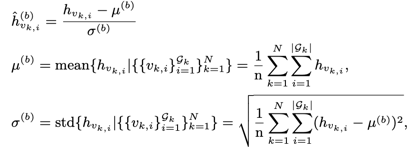

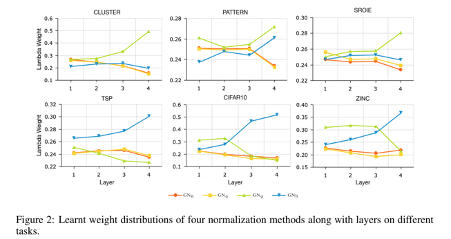

4种归一化方法分析

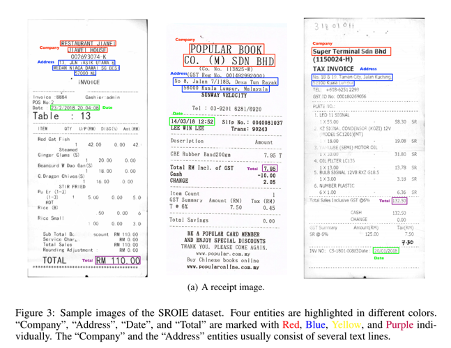

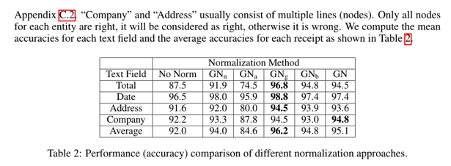

实验

结论

作者团队

往期精彩回顾

评论