未来50年:中国人工智能产业全景前瞻

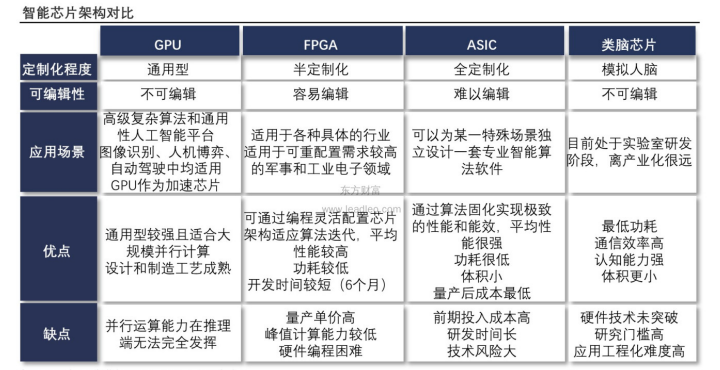

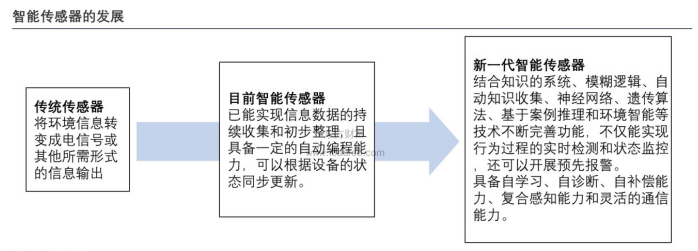

在计算需求的未来发展中,传统芯片已面临计算机硬件和架构的限制。类脑芯片跳出了冯·诺依曼架构的技术路线,或将成为未来海量数据处理的基础硬件。未来的工业生产中将更加依赖智能传感器解析和处理信息的能力。同时,智能传感器正逐步集成到日常物品中构建智能环境,与人互动产生数据,从基础层加速人工智能的发展。

下载链接:

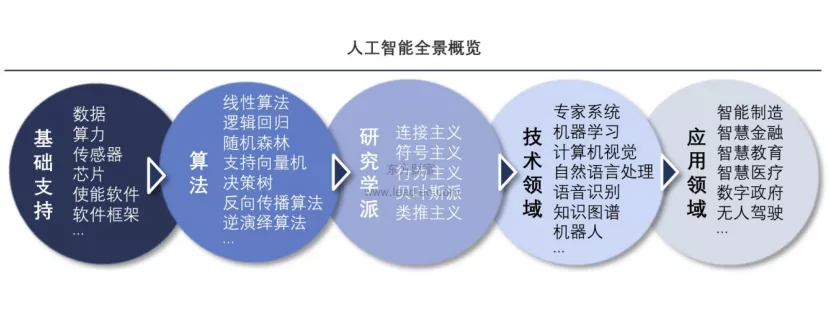

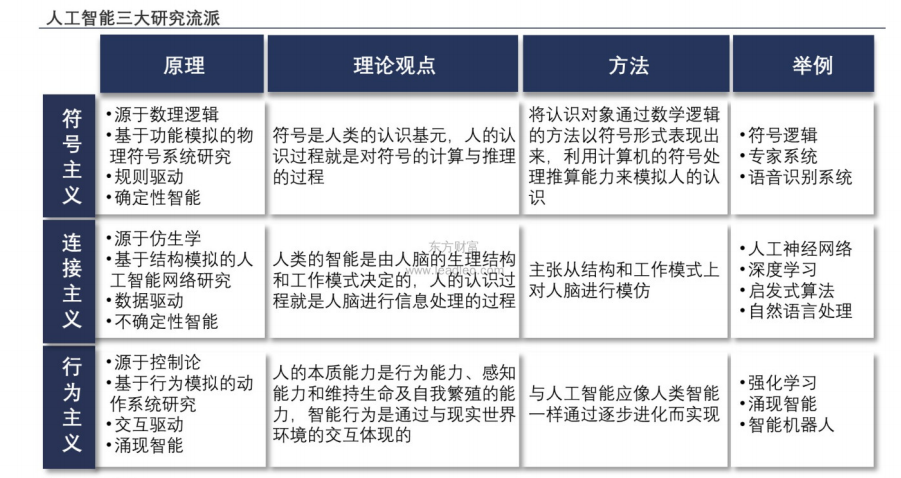

人工智能强调像人一样思考和行动,以符号主义、连接主义和行为主义为三大主流派系,分别从仿生学、数理逻辑和控制论来定义人工智能的发展路径。

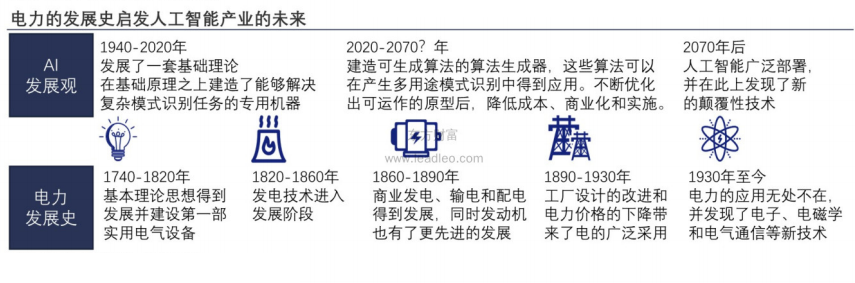

过去五十年中,人工智能从理论基础与算法基础逐步走向应用,对计算力的要求也从数值计算转向智能推演,但在人工智能产业的漫漫征途中,这仅仅只是跨出了第一步。

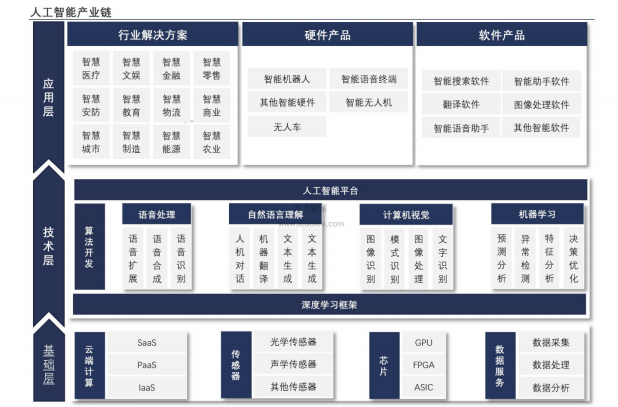

数据源、软件框架、算力等基础设施正在不断拓展人工智能算法的开发场景。日渐优化的人工智能开发环境下,Al算法和Al技术不断拓宽的 能力边界正在加速"Al+行业"的部署。人工智能正在逐步影响现实世界的生活与工作的方方面面。

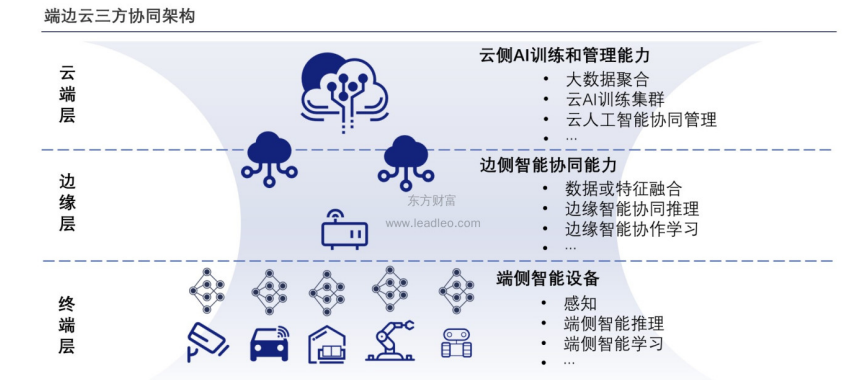

人工智能当前以数据和算力为驱动∶1.通过Al数据框架高效筛选和半自动标注进行数据预处理;2.在主流框架开发环境中通过预置模型算法提升开发效率;3.分布式集群加速模型训练; 4.端边云部署,支持各种线上场景;5.Al共享平台∶企业构筑内外部Al生态。

在计算需求的未来发展中,传统芯片已面临计算机硬件和架构的限制。类脑芯片跳出了冯·诺依曼架构的技术路线,或将成为未来海量数据处理的基础硬件。

未来的工业生产中将更加依赖智能传感器解析和处理信息的能力。同时,智能传感器正逐步集成到日常物品中构建智能环境,与人互动产生数据,从基础层加速人工智能的发展。

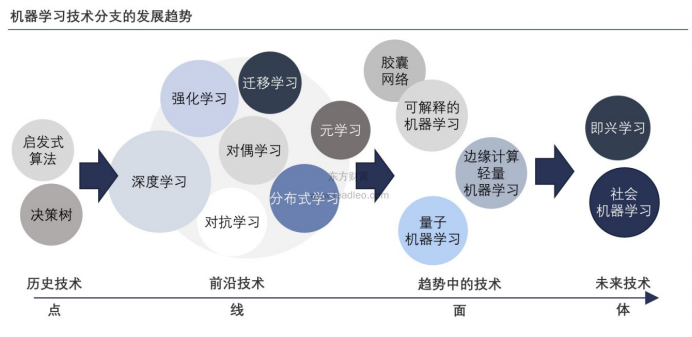

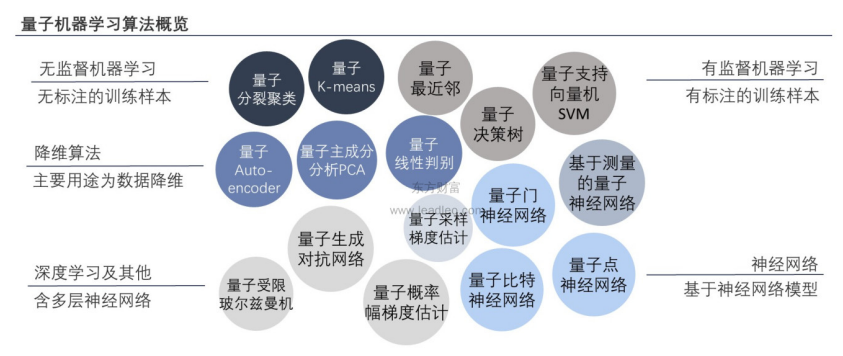

机器学习正在飞速发展,除了深度学习、强化学习还派生出了元学习等前沿技术,在趋势中向可解释的机器学习、边缘计算和量子机器学习发展 。

机器学习关注如何用计算的方法模拟类人的学习行为∶从历史经验中获取规律(或模型),并将其应用到新的类似场景中。机器学习的最新进展是由新的学习算法和理论的发展以及在线数据和低成本计算的持续爆炸所推动的。但机器学习领域还很年轻,它仍在迅速扩展。

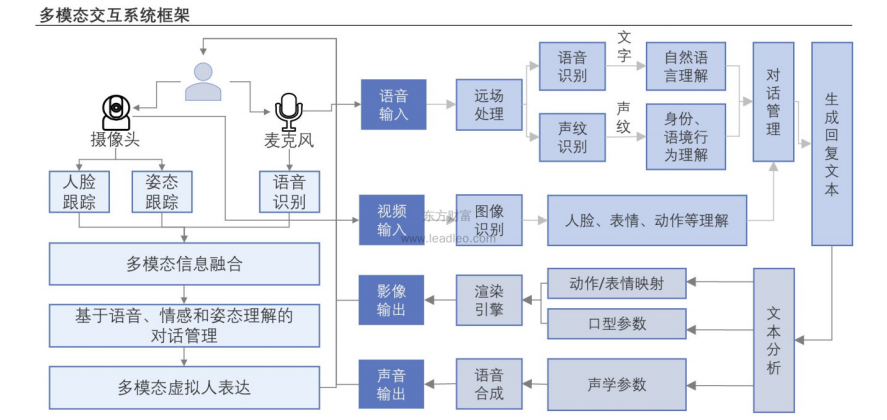

智能语音与计算机视觉的技术发展都已进入商业化应用阶段,智能语音市场竞争激烈,而计算机视觉市场仍然在打开市场空间。未来,语音与视觉等模态将相互融合发展。

随着人工智能的智能化程度提升,语音、图像、视频等模态将趋于融合,语音可视化将成为可能。深度学习神经网络的引进使语言模态、文字模态、图像模态、视频模态的编码和解码可在同一个深度学习框架下统一运行,不同模态的对象可被同一模式编码与解码,同一模式的编码与解码可使不同模态对象随意融合,语音分析结果可与图像分析结果结合应用。

由于深度学习模型参数量、计算量大,模型在计算资源受限的端侧设备上的嵌入式系统部署难,故需要对传统深度学习的方法进行调优。模型压缩包括网络剪枝、权值量化共享权重、霍夫曼编码、知识迁移浅层网络等方式,对神经网络模型进行无精度损失的压缩。

人工智能专用芯片与智能传感器的发展,大幅提高了端侧设备的计算资源容量。同时,模型压缩后的人工智能算法支持轻量化和低成本化部署。

Al+行业正在聚焦多元化的应用场景,不同产业及领域的智能化转型将大规模提高人工智能的用户基数为人工智能领域的发展提供巨大的空间,并逐渐向其他相关产业辐射。

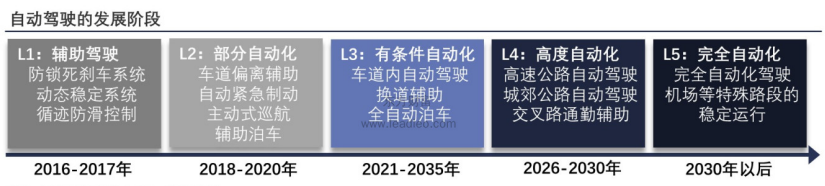

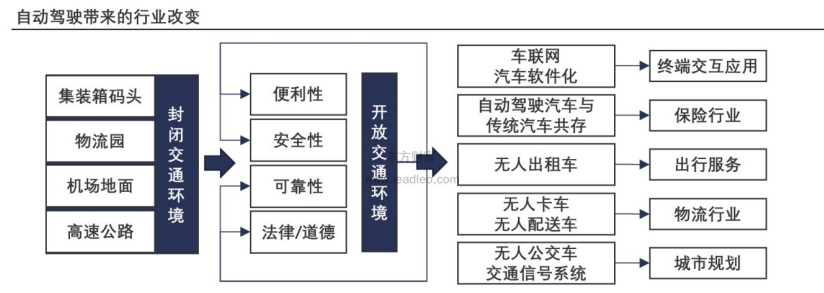

随着自动驾驶技术向完全自动化阶段发展,自动驾驶将对终端交互应用、保险行业、出行服务、物流行业、城市规划等领域产生破坏性影响。

量子人工智能(简称QAI)是量子力学与人工智能相结合的跨学科领域,分两种不同的途径与方法∶构建改善当前人工智能系统的量子算法;建立在量子计算机基础上的量子增强型人工智能算法。

量子计算和人工智能技术各自经历了起起落落、螺旋上升的发展历程,而现在正迎来二者深度交叉的最好时机。

人工智能正在加速对量子力学理论和量子材料科学的深层次理解,进而发展出能够发挥量子特性的计算机方从效率和能耗上打破摩尔定律的掣肘,使算力的发展曲线迎来全新的高峰爬坡期。而具备更高性能的量子计算机充分满足人工智能的计算需求,将赋能人工智能持续迭代。

下载链接:

2、信创产业研究框架

3、ARM行业研究框架

4、CPU研究框架

5、国产CPU研究框架

6、行业深度报告:GPU研究框架

本号资料全部上传至知识星球,更多内容请登录智能计算芯知识(知识星球)星球下载全部资料。

免责申明:本号聚焦相关技术分享,内容观点不代表本号立场,可追溯内容均注明来源,发布文章若存在版权等问题,请留言联系删除,谢谢。

电子书<服务器基础知识全解(终极版)>更新完毕,知识点深度讲解,提供182页完整版下载。

获取方式:点击“阅读原文”即可查看PPT可编辑版本和PDF阅读版本详情。

温馨提示:

请搜索“AI_Architect”或“扫码”关注公众号实时掌握深度技术分享,点击“阅读原文”获取更多原创技术干货。