快速回顾:U-Net Family方法汇总

极市导读

Unet作为FCN 的一种变体,因为其结构能够结合底层和高层的信息,成为大多做医疗影像语义分割任务的基础。本文是关于U-Net的体系结构一篇汇总,分别介绍了U-Net,Attention U-Net,UNet++的概念及详细分类。>加入极市CV技术交流群,走在计算机视觉的最前沿

1 Image Segmentation

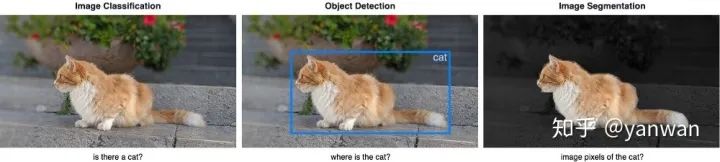

Image Classification: 帮助我们对图像中包含的内容进行分类。目标是通过预测是或否来回答“此图像中是否有猫?”。

Object Detectio: 指定对象在图像中的位置。目的是通过在感兴趣的对象周围绘制边框来识别“猫在此图像中的什么位置?”。

Image Segmentation: 为图像中的每个对象创建一个像素级掩码。目的是通过对每个像素进行分类来识别图像中不同对象的位置和形状。

2 Metrics

我们需要一组度量标准来比较不同的模型,通常有BCE,Dice系数和IoU。

Binary cross-entropy: 二分类的交叉熵损失;

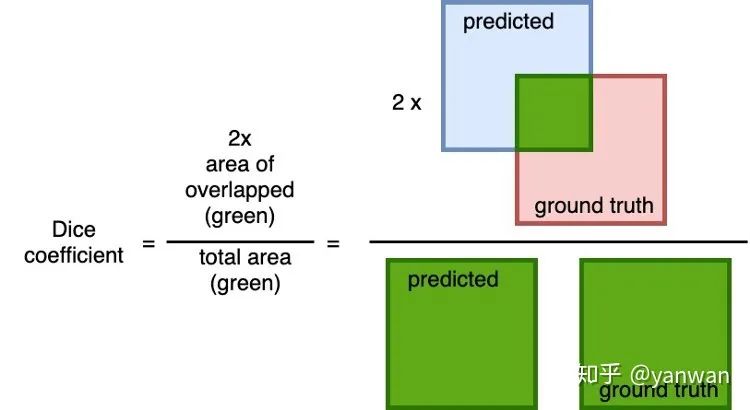

Dice coefficient: 是预测值与之间之间的重叠的通用度量标准。计算公式为2 *重叠面积(预测值和真实值之间)除以总面积(预测的和真实的基础相加)。此指标的范围是0到1,其中1表示完美和完全重叠。

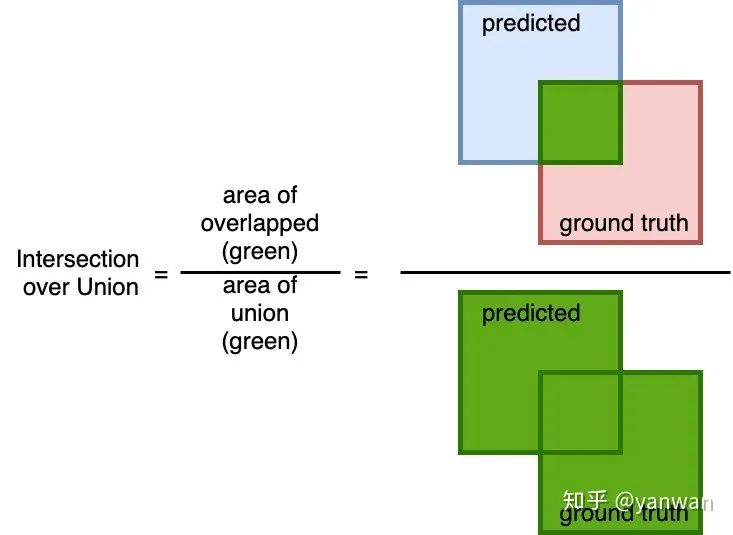

Intersection over Union: 一个简单的度量标准,重叠区域(在预测的和真实值之间)并除以并集的区域(在预测值和真实值之间)。与Dice系数相似,此度量范围为0到1,其中0表示无重叠,而1表示预测的和地面真实情况之间的完全重叠。

3 U-Net

U-Net发表在2015年MICCAI上。尽管U-Net也可用于自然图像的分割,但它在许多生物医学图像的图像分割任务中都得到不错得效果。

Requires fewer training samples

深度学习模型的成功训练需要成千上万的带注释的训练样本,但是获取带注释的医学图像是巨大的。U-Net可以使用更少的训练样本进行端到端训练。

Precise segmentation

精确的分割掩码在自然图像中可能并不重要,但是医学图像中的边缘分割错误会导致结果在临床环境中不可靠。尽管培训师样本较少,但U-Net仍可以产生更精确的细分。

Architecture

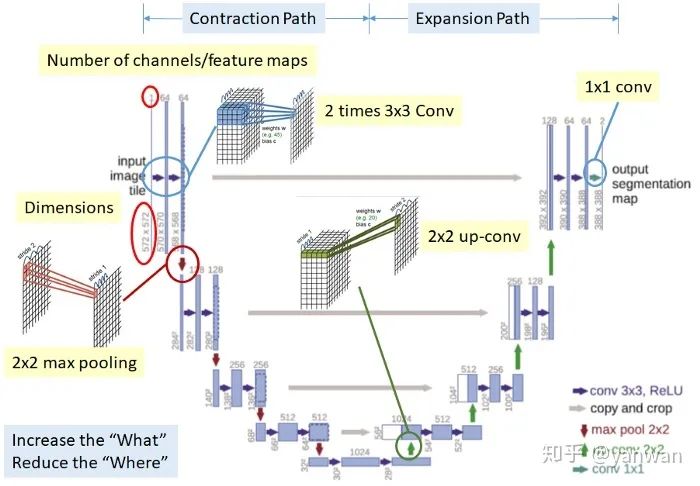

U-Net具有优雅的结构,网络是对称得,并形成U形的结构。

Contraction path (downsampling)

看起来像典型的CNN架构,通过连续堆叠两个3x3卷积(蓝色箭头),然后进行2x2最大池化(红色箭头)进行下采样。在每个下采样步骤,通道数量都会加倍。

Expansion path (up-convolution)

一个用于上采样的2x2向上卷积(绿色箭头)和两个3x3向上卷积(蓝色箭头)。在每个上采样步骤中,通道数减半。

在每次2x2向上卷积之后,由于每次卷积中边界像素的丢失,一系列特征映射从Contracting path(灰色箭头)到有相应的图层,以提供从contraction path 到 expansion path 的定位信息。

Final layer

1x1卷积以将要素映射映射到所需的类数。

4 Attention U-Net

论文:Attention Gates for Image Analysis

代码:ozan-oktay/Attention-Gated-Networks(https://github.com/ozan-oktay/Attention-Gated-Networks)

尽管U-Net具有良好的表示能力,但它依赖于多级级联卷积神经网络。这些级联框架提取感兴趣的区域并做出密集的预测。这种方法在重复提取低层特征时会导致计算资源的过度和冗余使用。

What is new in Attention U-Net?

UNet++在原来的U-Net基础上增加:Attention gates

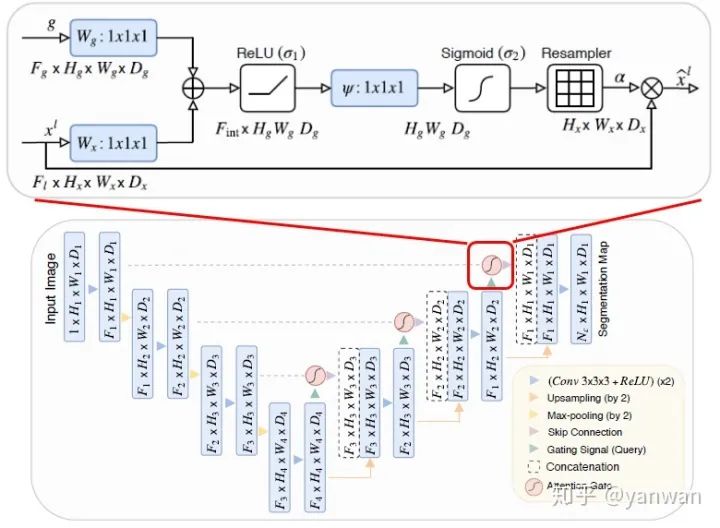

Attention gates的结构如上图顶部所示。

首先,输入分别经过2个1×1×1卷积,然后将其相加再使用ReLU。

其次,再次执行1×1×1转换,但是这次以Sigmoid作为激活函数。

然后,它会经过重采样器(实际上是三线性插值),以使特征图的大小与要乘元素的大小相同。

最后,使用较低级别的上采样特征图和原始特征进行Element-wise。

5 UNet++

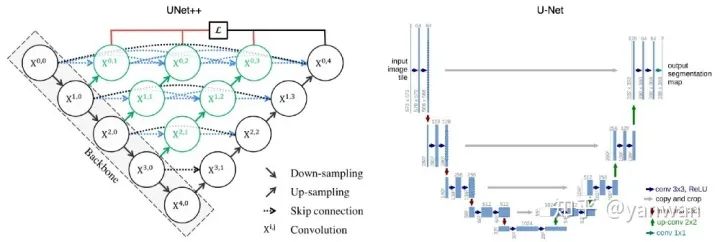

UNet++通过在编码器和解码器之间加入密集的块和卷积层来提高分割精度。

What is new in UNet++?

UNet++在原来的U-Net基础上增加了3项功能:

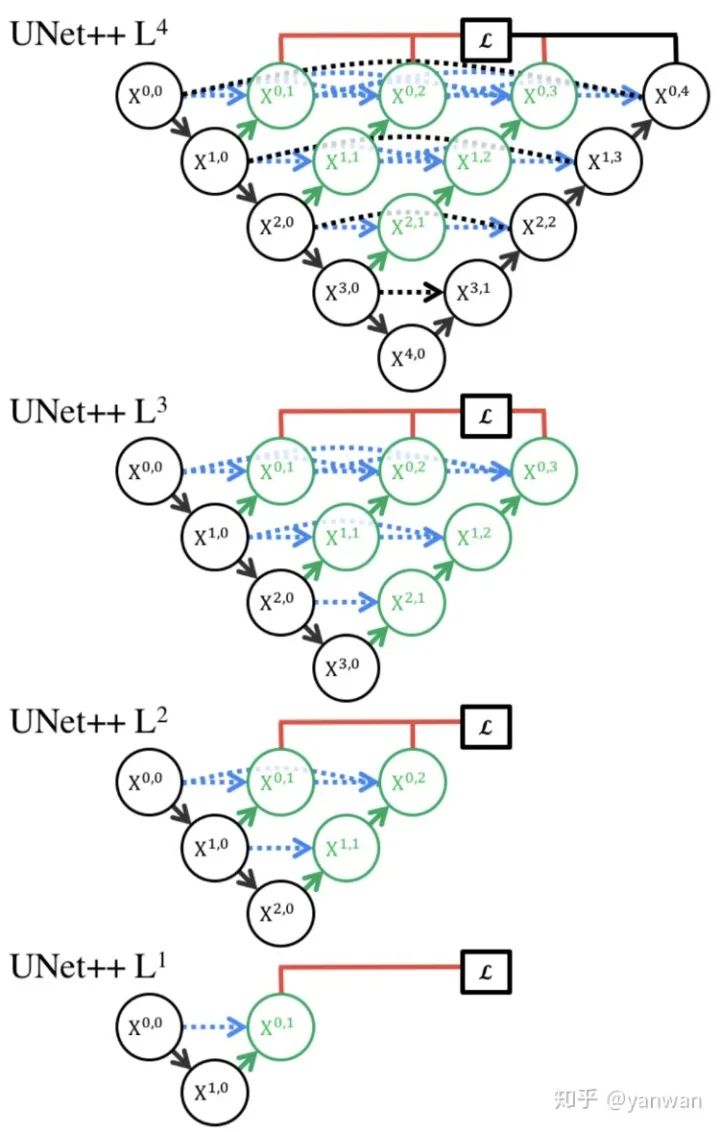

redesigned skip pathways(以绿色显示) dense skip connections(以蓝色显示) deep supervision(红色显示)

Redesigned skip pathways

在UNet++中,添加了Redesigned skip pathways(以绿色显示),从而导致语义上不同的特征映射的融合,以融合编码器和解码器子路径映射之间的语义差距。

Redesigned skip pathways的所有卷积都使用3×3大小的核。

Dense skip connections

UNet++中的Dense skip connections(蓝色显示)在编码器和解码器之间实现了跳跃连接。这些稠密块的设计灵感来自DenseNet,目的是提高分割精度和改善梯度流。

Deep supervision

在UNet ++中,添加了深度监督(以红色显示),以便可以修剪模型以调整模型的复杂性,从而在速度(推理时间)和性能之间取得平衡。对于精确模式,平均所有细分分支的输出。对于快速模式,从分割分支之一中选择最终的输出。

Conclusion

U-Net体系结构非常适合生物医学图像分割,尽管仅使用50张图像进行训练,但实现了非常好的性能,并且训练时间非常合理。

参考:

http://weixin.qq.com/r/-S50bE3EahAVrQkP93vv

推荐阅读