这不,就在几个小时前,谷歌AI伦理部门创始人Margaret Mitchell在社交媒体上表示,“我被开除了”。在对该经理的行为进行审查之后,我们确认其存在多次违反公司行为准则和安全政策的行为,其中包括泄露机密的业务敏感文件和其他员工的私人数据。

根据Axios报道称,早在1月份,谷歌就撤销了Margaret Mitchell的公司访问权限,原因是其使用自动脚本查找了公司“虐待”Timnit Gebru的相关证据。本月早些时候,Mitchell在推特上发布了一封电子邮件,邮件中谈到了Gebru被解雇的情况,以及该事件似乎“受到了种族主义和性别歧视者们的支持”,“如果AI系统被别有用心的人加以利用,也会受到同样的影响”。https://docs.google.com/document/d/1ERi2crDToYhYjEjxRoOzO-uOUeLgdoLPfnx1JOErg2w/edit

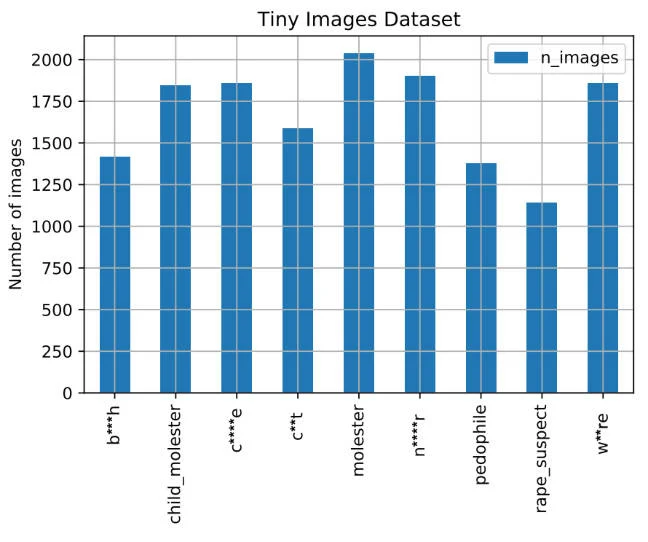

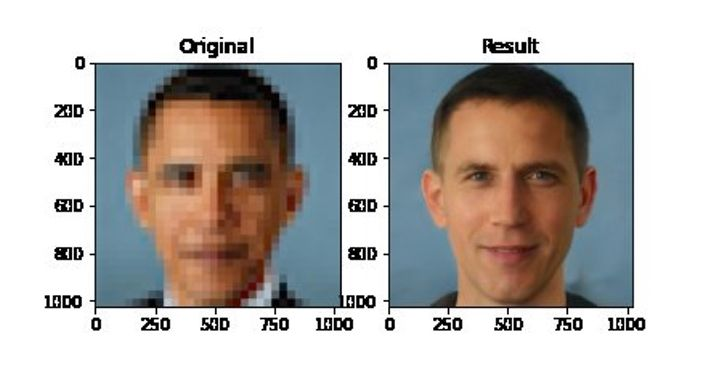

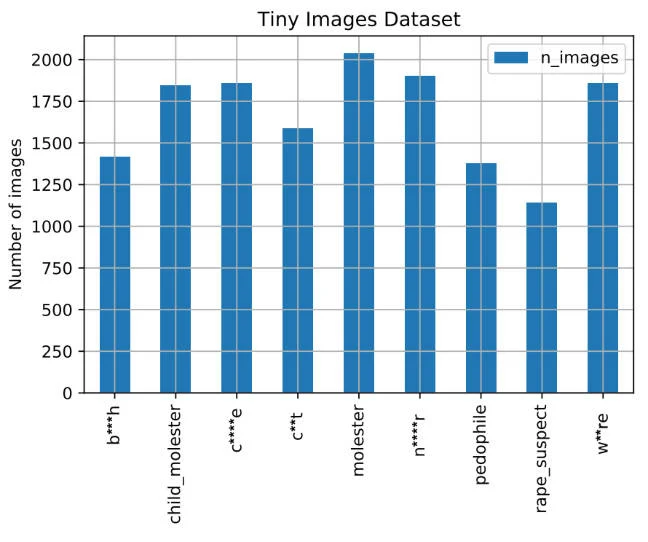

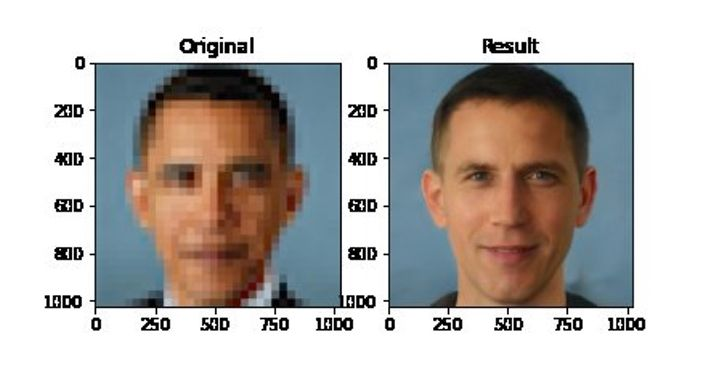

Mitchell认为,发生在Gebru身上的事情“似乎源于对于现代技术缺乏远见,因此该事件本身就是这个问题的显现”。也正如Axios之前所报道的那样,Mitchell被解雇发生在谷歌宣布对其AI伦理团队进行重组的后一天。谷歌工程组织副总裁Marian Croak现在领导着“谷歌研究中心一个负责任的人工智能新专业中心”。根据Mitchell的LinkedIn资料显示,她在2016年加入谷歌,担任高级研究科学家。两年后,她与Gebru一起成立了谷歌AI伦理团队。去年12月,Mitchell和Gebru正在撰写有关大型语言处理模型的危害的论文,当Google Brain副总裁Megan Kacholia要求撤回该文章时,Gebru却表示,谷歌需要更加开放,思考“为何这项研究不被接受”。这此后不久,Gebru便被解雇了,尽管谷歌将其描述为主动辞职。Gebru事件发生后,Mitchell便开始公开批评谷歌高管,包括谷歌AI部门负责人Jeff Dean和谷歌首席执行官Sundar Pichai。1月,在谷歌开始着手调查相关事宜时,Mitchell发现自己失去了公司电子邮件访问权限。对此,外界普遍猜测,Mitchell被解雇在很大程度上都是因为其与Gebru的关系,以及在后续一系列活动中对Gebru的声援。在对Gebru事件进行调查之后,谷歌宣布将对其研究和多元化政策进行更改。在一封内部电子邮件中,Jeff Dean向员工道歉,表示他对公司处理Gebru离职一事深表遗憾。“我听到并承认Gebru博士的退出对女性技术人员、黑人社区人员以及追求技术职业的其他代表性不足的群体以及对谷歌负责任地使用AI表示深切关怀的人代表着什么。这会使得这些人质疑他们在公司的位置,对此我感到遗憾。”自Gebru事件于去年12月发酵以来,谷歌的AI伦理团队就一直处于危机中。在宣布重组后,高级研究员Alex Hanna写道,直到周三晚上新闻报道后,团队才知道Croak的任命。“他们都让我们要相信他们的处理方式,相信Marian Croak这样的决策者,他们会把我们利益最大化,”她在推特上写到,“但所有的决定都是背着我们做出的”。谷歌连续曝出的解雇风波在业界引起巨大轰动,也引发了人们对谷歌对异议的容忍度的质疑。2018年至今,谷歌内部已经发生过多次大规模的抗议活动。最近,多位谷歌员工宣布共同成立Alphabet工会,希望在薪酬和伦理等问题上向公司施压。Mitchell以在人脸识别偏见的批评而闻名于世。这个数据库内,当黑人或猴子出现时,标签显示为N*gger这一对黑人的蔑称词汇;此外,身穿比基尼或抱着孩子的妇女的图片被标记为b*tch等这一侮辱性词汇。这在学术圈迅速引发广泛关注和激烈争议。得知消息后,MIT迅速下线了这一数据集,并发布公告称,由该数据集训练出的AI系统,会潜在地使用种族主义、厌女症和其他激进术语来描述对象,请所有研究员暂停使用和训练。下线该数据库后,MIT还表示,将敦促研究人员和开发人员停止使用培训库,并删除所有副本。ImageNet也有同样的问题,因为它也是使用WordNet进行注释的。一项名为“ImageNet Roulette”的实验允许人们将照片提交给由ImageNet训练出来的神经网络,该神经网络将使用数据集中的标签来描述这些图片。不出所料,人们在系统中输入的是他们最感兴趣的照片:自拍,而软件会输出一些种族主义和冒犯性的标签描述他们。在这些庞大的数据集中,有问题的图像和标签所占的比例很小,并且很容易将其作为异常现象清除掉。Prabhu和Birhane认为,如果将这些材料用于训练现实世界中使用的机器学习模型,则很可能导致真正的伤害。他们在论文中写道:“缺乏对规范数据集的规范,会对女性、种族和少数民族以及处于社会边缘的弱势个体和社区造成不成比例的负面影响。”少数群体在AI训练数据集中往往没有得到重视,这也是人脸识别算法在识别女性和肤色较深的人时遇到困难的原因。今年早些时候,底特律的一名黑人被面部识别软件误认为小偷嫌疑人,被警察错误逮捕。这也是为什么此前,一个有争议的人工智能算法从低分辨率的快照中生成高分辨率的图像,把一张奥巴马的模糊照片变成更像白人而不是黑人的原因。尽管随着技术的成熟,科技公司都在不同领域取得了不小的进步,但是与技术相伴生的伦理问题却并未得到相同程度的重视。谷歌的系列事件到底会成为导火索,还是伦理问题被提上台面的引线,我们将拭目以待。https://techcrunch.com/2021/02/19/google-fires-top-ai-ethics-researcher-margaret-mitchell/https://www.theverge.com/2021/2/19/22291631/google-diversity-research-policy-changes-timnet-gebru-firinghttps://www.nytimes.com/live/2021/02/19/business/stock-market-today

下载APP

下载APP