性能爆涨:搭载1536MB缓存霄龙的GPU服务器实测

Milan-X 7773X是AMD今年上市的处理器,其基于Milan第三代EPYC处理器7003系列升级,主要特点包括:

采用3D堆叠技术(3D V-Cache),增加了额外的L3缓存芯片(SRAM),使得单个处理器可用L3缓存总数增大三倍,达到768MB; 仍由多芯片模块(MCM)封装而成,包含8个CCD和1个大型IO芯片。3D V-Cache 使用台积电N7工艺,在原有的32MiB芯片顶部增加一个64MiB芯片; 与当前LGA 4094主板兼容,每个插槽支持8个DDR4-3200 MT/s内存模块,最大支持内存容量为4TB,双路插槽共8TB。

图1 AMD Milan-X 7773X处理器

Milan-X对应用的性能提升能发挥多大的作用?特别是对计算性能有极致需求的高性能计算(HPC)应用。可以看到,近年来尽管CPU性能不断提升,但是访存系统性能几乎维持不变,越来越多的软件性能瓶颈从计算过程转移到数据访存过程。我们知道,HPC应用通常是采用当前最先进的超算集群来完成一系列复杂物理模型的计算过程,对集群整体性能有极高的需求,包括浮点计算速度、内存带宽、网络带宽等。最新推出的Milan-X 中包含了超大L3缓存,理论上可以将更多的数据缓存在CPU中,提供更高的数据访问能力,进而提升HPC应用的性能。

为了评估Milan-X对HPC应用的性能提升效果,我们选取常见的气象应用WRF和计算流体力学应用OpenFOAM,使用浪潮NF5468A5 GPU服务器分别搭载2颗AMD Rome 7742、Milan 7543、Milan-X 7773X处理器,进行了实测对比分析。

一、平台简介

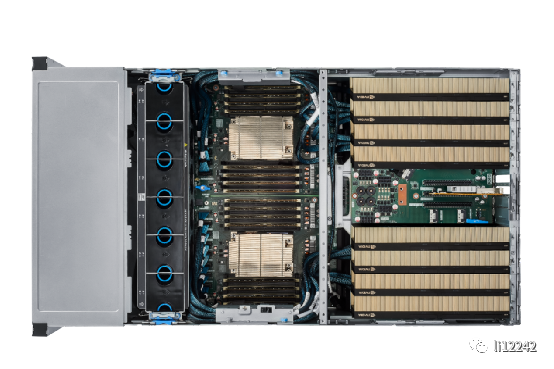

本次拿到的浪潮信息NF5468A5是一款4U支持2颗AMD EPYC处理器和8颗双宽GPU卡,面向AI训练、推理、视频编解码等多种应用场景的GPU服务器。

图2 浪潮NF5468A5服务器

NF5468A5采用分区散热设计,内置独立的CPU和GPU主板,且分别安装在不同的平面。从机箱内部结构来看,设计者将发热量高的的GPU放在了机箱上3U空间,CPU板处于机箱下1U,内置6对12个6056风扇模组配合导风罩,实现机箱内风道分流,正是基于这种独特分层散热设计,使得送测的NF5468A5服务器可以支持280W最高功耗的Milan-X 7773X。系统设计支持32条DDR4 ECC内存,支持LRDIMM/RDIMM,提供高达8T的本地内存,实现与1536 MB超大L3 cache间的高速数据交互。

图3 浪潮NF5468A5开箱俯视图

从浪潮官网发布的信息来看,NF5468A5采用了CPU直连GPU架构设计,率先支持PCI-E 4.0技术,最大限度提升CPU与GPU间的带宽,降低通信延迟,达到最佳效能,为客户提供极致优化的算力。系统提供丰富的IO扩展能力,提供10个PCIe 4.0 X16扩展槽位,支持8个全高全长的GPU加速卡。提供灵活存储方案,可选前置12×3.5英寸硬盘或24×2.5英寸硬盘,提供超大的本地存储能力,同时最大可支持8个热插拔NVMe SSD全闪配置,提供存储到内存到L3 cache的高速访存,可实现十倍于高端企业级SATA SSD的IOPS性能,带来极致IO存储性能飞跃。

二、性能测评

在本次测试中,我们选取了在气象和CFD领域应用最广泛的两款应用软件WRF和OpenFOAM进行测试。测试时,基于浪潮NF5468A5 GPU服务器,选配了AMD Rome 7742、Milan 7543和Milan-X 7773-X三种型号CPU进行对比,同时配备16条DDR4 3200MT/s内存条,保证使用全部内存通道。在测试过程中将分别使用节点内1/8、1/4、1/2和全部核心对应用运行时间进行测试,考察应用扩展性能。在软件安装和运行中使用的操作系统、编译器和MPI并行环境如下表所示。

表1 测试安装软件和对应版本

软件环境 | 软件版本 |

操作系统 | RedHat Enterprise Linux 8.3.2011 x86_64 |

编译器 | Intel Compiler 2021.2.0 |

并行环境 | Intel MPI 2021.2.0 |

应用软件 | WRF-v3.9.1,OpenFOAM-v1906 |

1. WRF性能测试

中尺度预报模式WRF(Weather Research and Forecasting model)模式是由美国国家大气研究中心(NCAR)、美国大气海洋局(NOAA)和美国空间气象局(AFWA) 等共同开发的,可用于数值天气预报的研究与业务化、物理参数化方案研究、数据同化、驱动空气质量模式、中小尺度气候模拟以及海洋大气模式的耦合等。

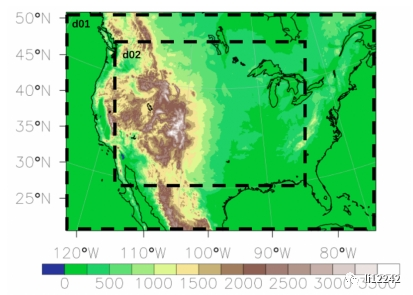

本次WRF测试采用两层嵌套网格计算,包括d01和d02。水平分辨率分别为 12 km 和 4 km,对应水平网格数分别为425 300和1150

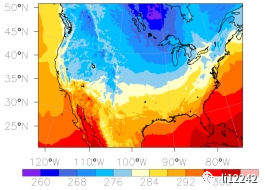

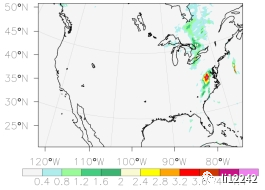

300和1150 802,垂向网格数为35层,积分时间步长为 30 s 和 10 s,模拟总时间为3h。模拟结束后可以获得计算区域内包括气温和累积降水量等结果,如下图所示。

802,垂向网格数为35层,积分时间步长为 30 s 和 10 s,模拟总时间为3h。模拟结束后可以获得计算区域内包括气温和累积降水量等结果,如下图所示。

图4 模拟区域海拔高度图(单位:m)

图5 WRF模拟结束时刻气温分布(左,单位:K)和3小时累积降水量分布(右,单位mm)

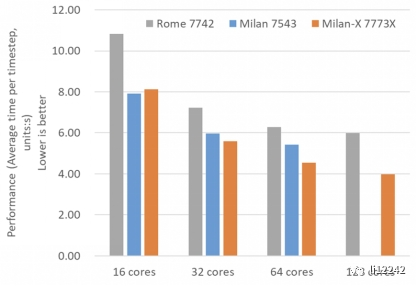

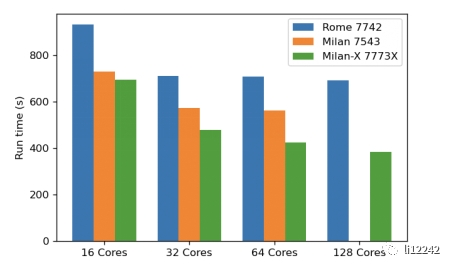

在测试过程中,采用相同核心数运行WRF时间对比如图所示。以Rome 7742处理器运行时间为基准,使用Milan 7543时WRF运行速度提升至1.14至1.27倍左右,在Milan-X 7773X 处理器上运行速度则提升到1.23到1.34倍左右。

图6 使用相同核心数时,WRF在不同AMD处理器上的性能对比

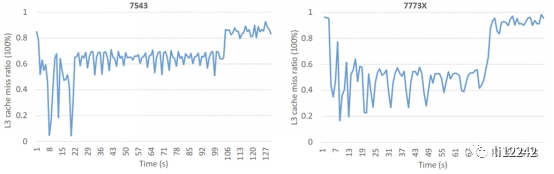

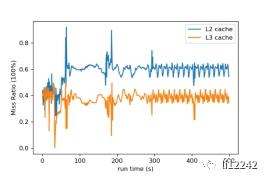

使用AMD Milan-X CPU对WRF运行性能提升显著,其主要原因就是超大L3缓存缓解了数据访问需求。以满核心运行时L3缓存不命中指标为例,在Milan 7543 CPU运行过程中为50%到70%左右,而在Milan-X平台则下降到25%到55%左右。

图7 WRF 在 Milan 7543 和 MilanX 7773X 处理器上单节点满核心运行时的实时 L3缓存不命中率

2. OpenFOAM性能测试

计算流体力学领域应用OpenFOAM 是使用 C++ 编写的数值离散函数库,具有很高的抽象性,能很好地支持复杂偏微分方程求解器的建立和线性方程组求解等功能,同时支持大规模并行计算。

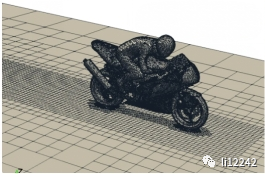

在本次测试中,使用OpenFOAM基准算例motorBike进行测试。motorBike算例使用求解器simpleFoam计算,模拟摩托车和骑手周围空气的运动情况。在simpleFoam 计算过程中,使用的是不可压形式控制方程进行求解,紊流模型采用的是 SST 𝑘-𝜔方程。

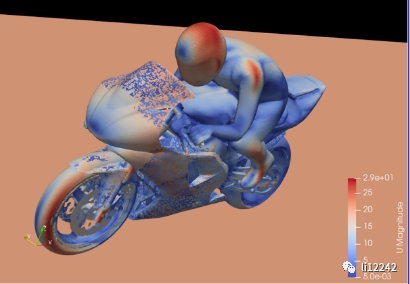

测试前首先需要使用blockMesh工具构建背景计算网格,随后使用snappyHexMesh工具根据输入STL文件对摩托车外形进行细分,得到计算所需的摩托车计算网格。细分结束后,计算区域内总单元总数达到1030万。在并行计算前,使用decomposePar工具将计算单元按照并行计算进程数将计算区域进行拆分,最后使用simpleFoam求解器并行求解。计算结束后,可以采用后处理工具paraview获得恒定状态下摩托车手周围空气流速分布信息等,如下图所示。

图8 motorBike 算例STL文件和划分网格示意图

图9 motorBike 算例结果中摩托车手周围空气流速分布

在OpenFOAM测试过程中,使用相同核心运行时间如下图所示。以Rome 7742处理器为基准,OpenFOAM在Milan 7543处理器上使用单节点相同核心测试时性能提升至1.23 至 1.28 倍左右。在Milan-X 7773X处理器上性能提升至1.34 至1.80倍左右。

图10 motorbike算例在不同AMD处理器上的性能对比

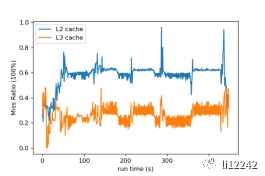

与WRF类似,OpenFOAM在Milan-X平台性能提升也是受益于超大L3缓存影响。从缓存不命中指标来看,在Milan平台L3缓存不命中比率约为40%左右,而在Milan-X平台则降低至20%至30%左右,显著提升了内存系统性能。

图11 Milan(左)和 Milan-X平台(右)满核运行时缓存不命中比率(L2:蓝色,L3:橙色)

三、总结

根据WRF和OpenFOAM测试性能和结果可以看出,采用选配超大L3缓存的AMD Milan-X CPU可以大幅提升内存系统工作性能,降低L3缓存不命中的比率。与AMD Rome平台相比,Milan-X CPU可以将WRF和OpenFOAM运行速度最高提升至1.34和1.80倍左右,大幅度缓解由于内存系统引起的运行瓶颈。

在本次测试中由于环境限制,仅使用了单台NF5468A5服务器进行模拟。对于多节点并行环境下Milan-X性能将在未来进一步研究。

最后,提供一下NF5468A5 GPU服务器的配置建议,如下表。

表2 浪潮NF5468A5 GPU服务器配置建议

类别 | 配置 |

2* AMD 7773X/7663/7453 | |

32* 64GB | |

2* 480GB M.2 SSD系统盘, 3* 3.84TB数据盘 | |

8* NVIDIA A100 / A30 / A40 | |

双口 HDR 200G / 100G | |

面向推理和中小规模训练场景,以及高频高核、内存高带宽需求的应用 |

本文转载于:公众号li12242