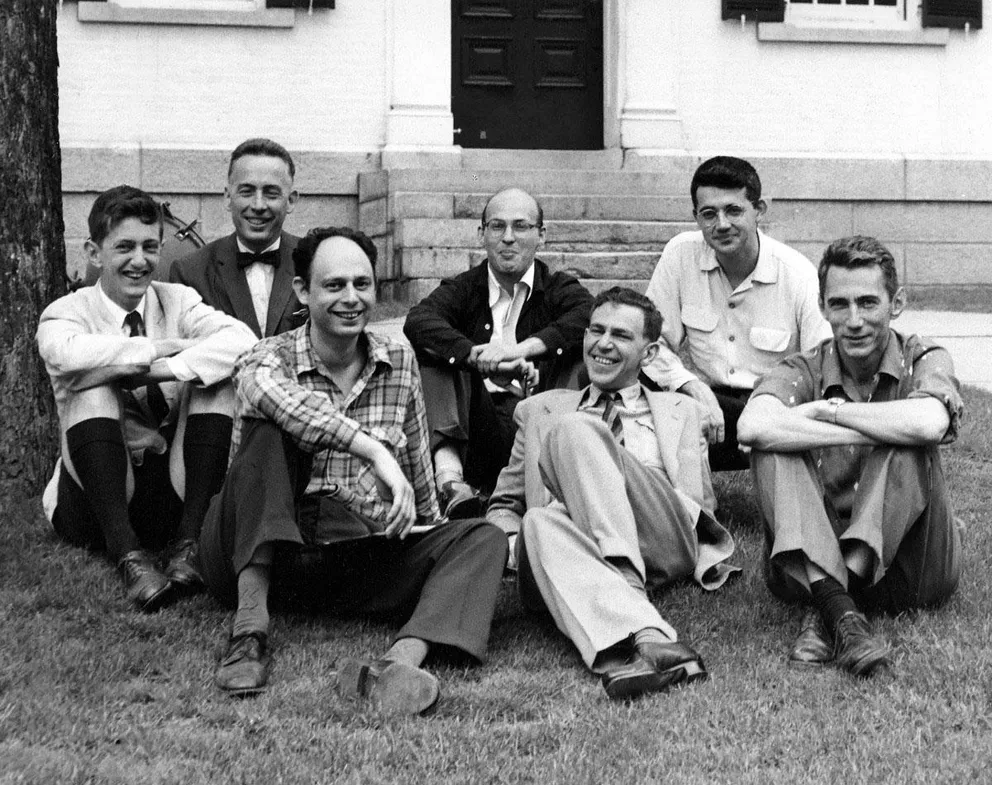

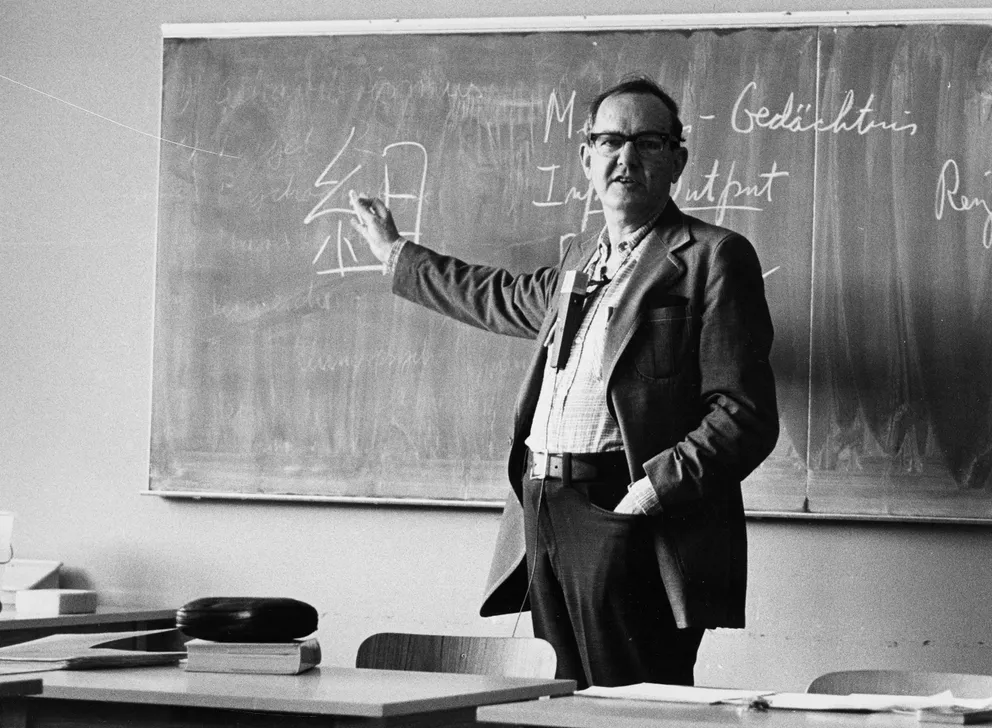

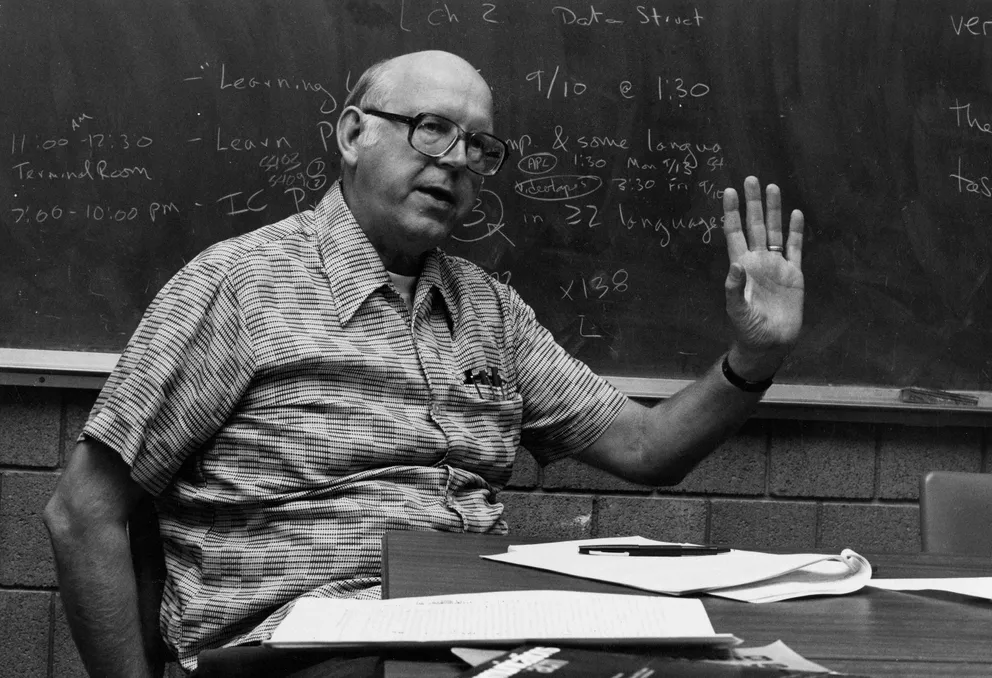

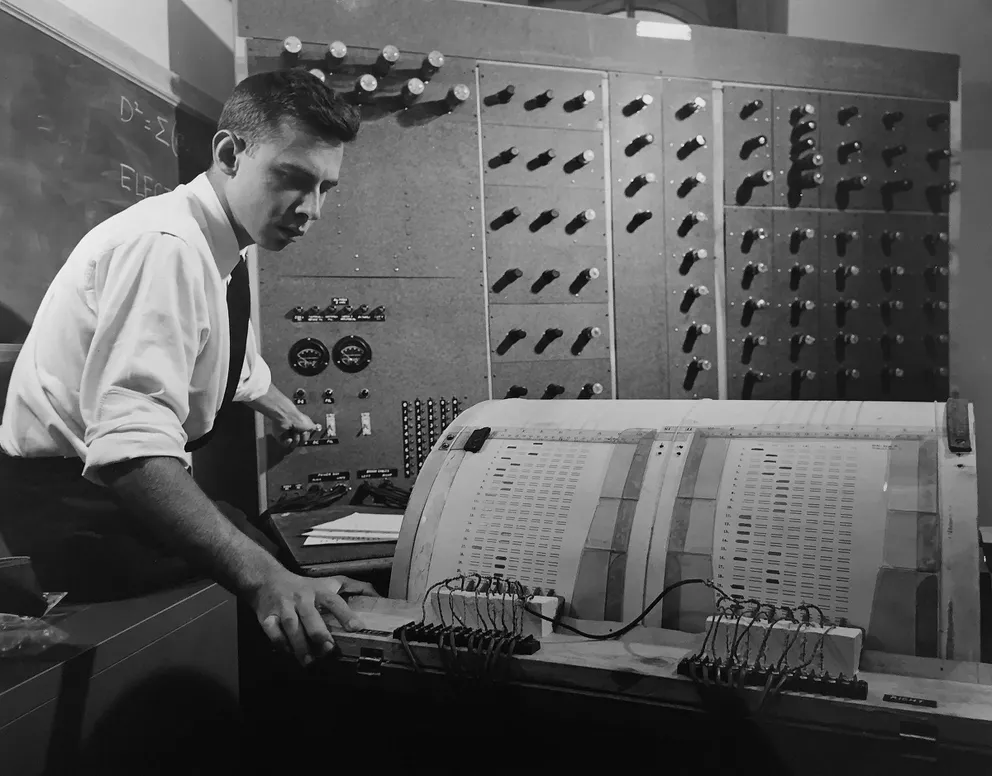

【行业资讯】人工智能65年简史:从麦卡锡到Hinton,人类追求的AI究竟是什么?

正文共:4014-15图

预计阅读时间:11分钟

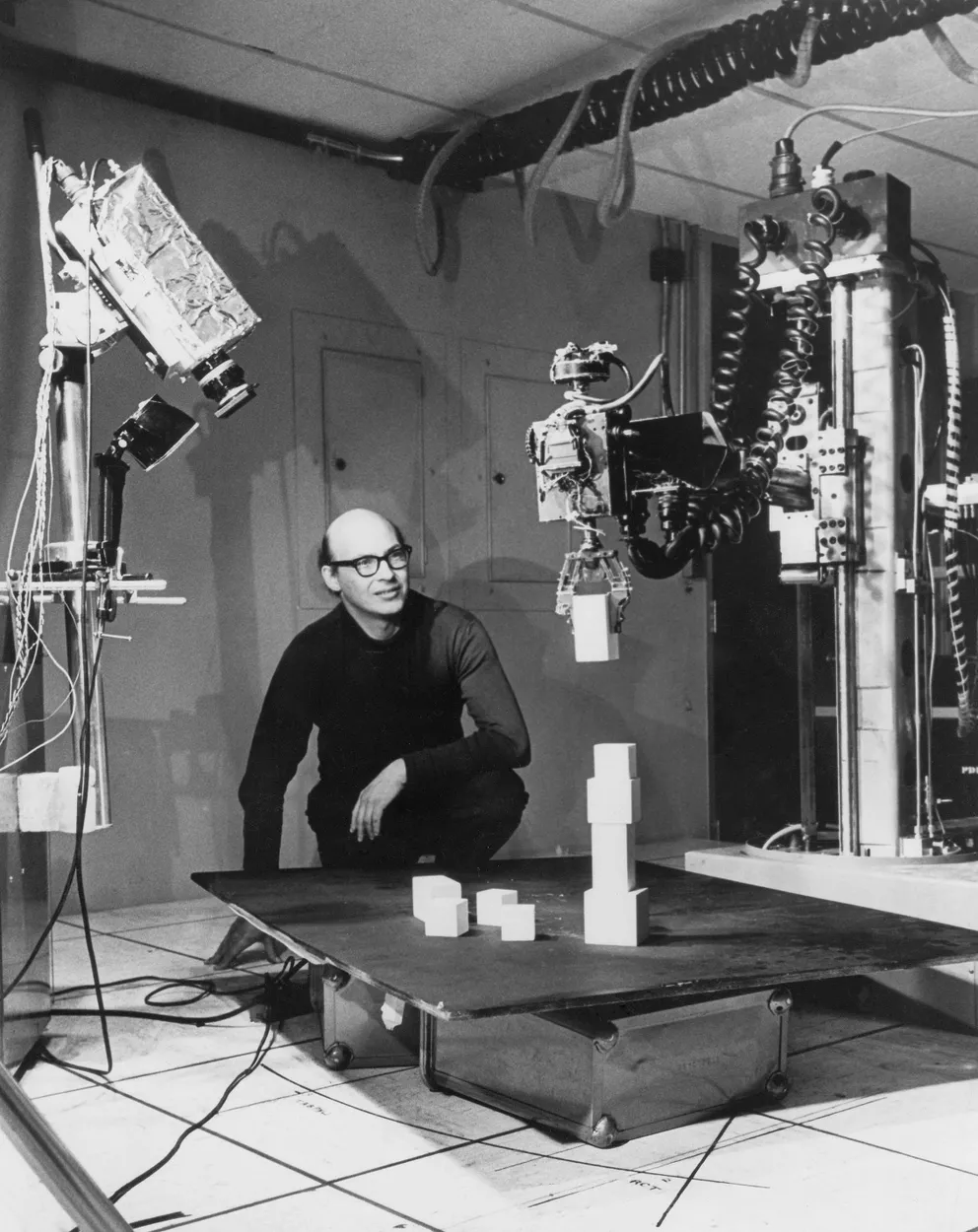

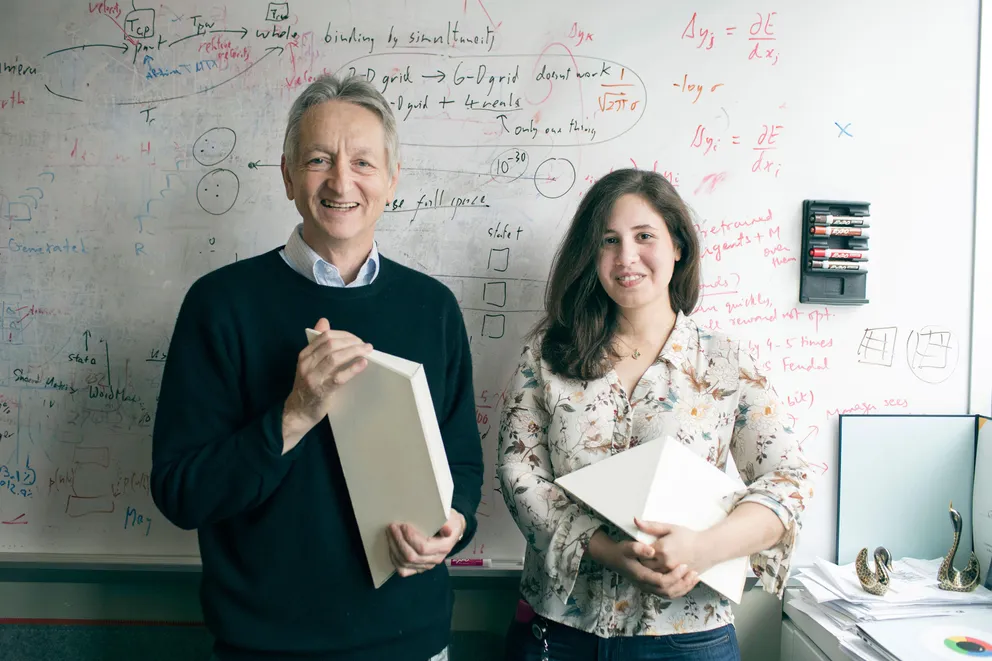

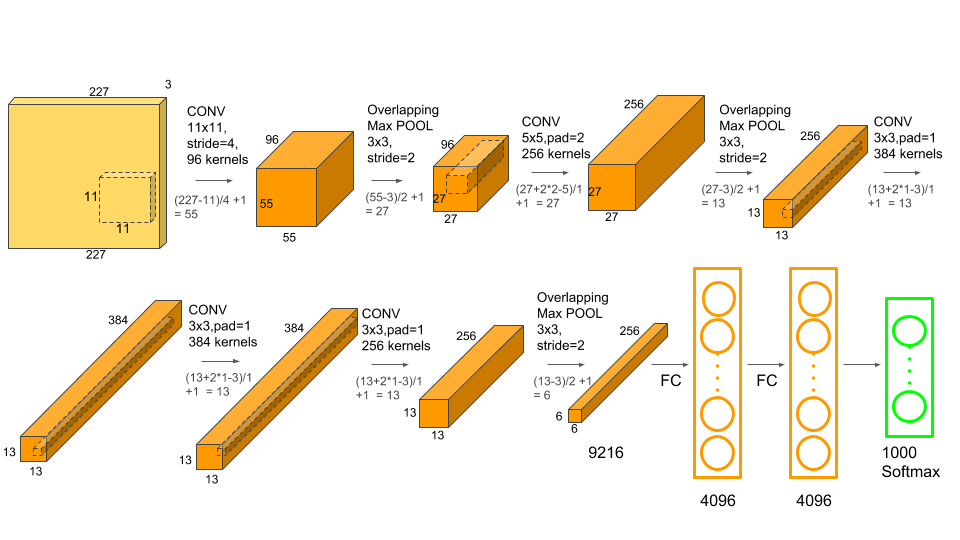

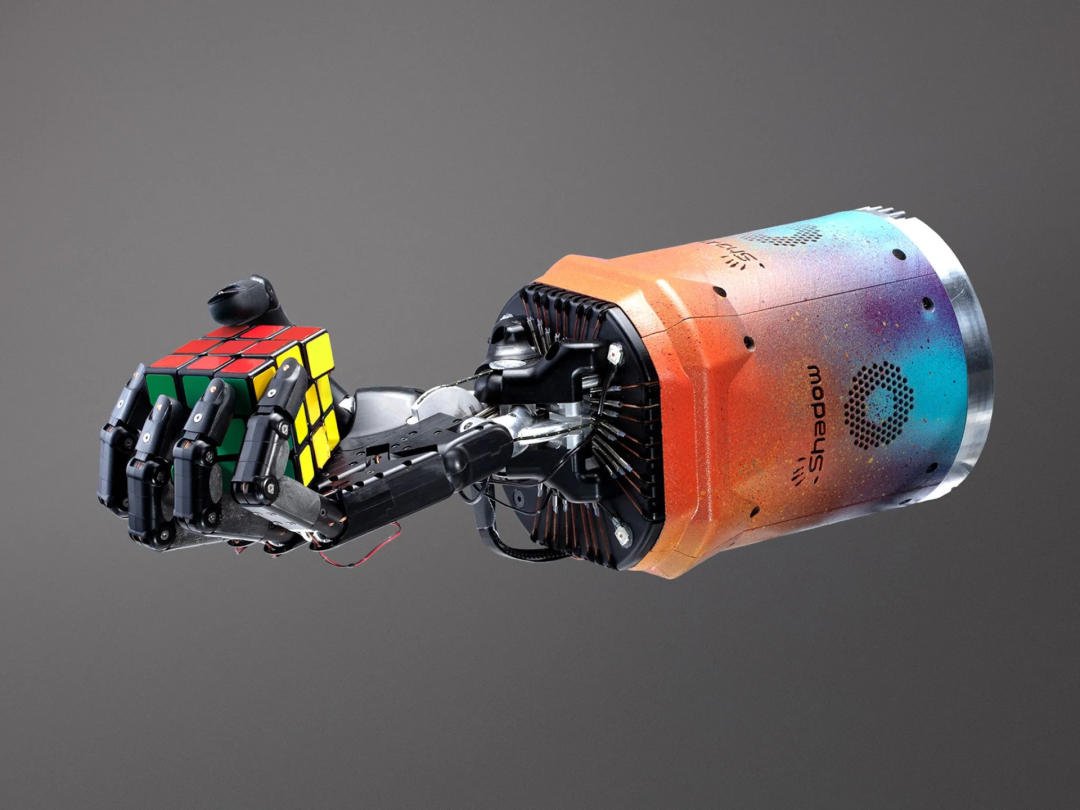

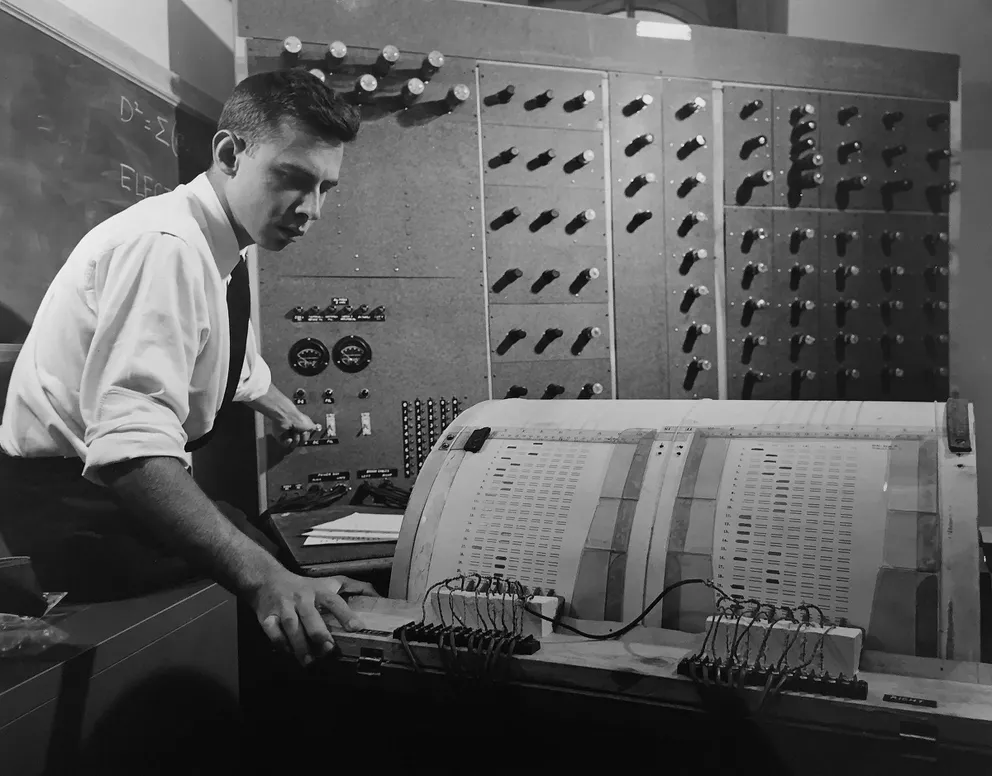

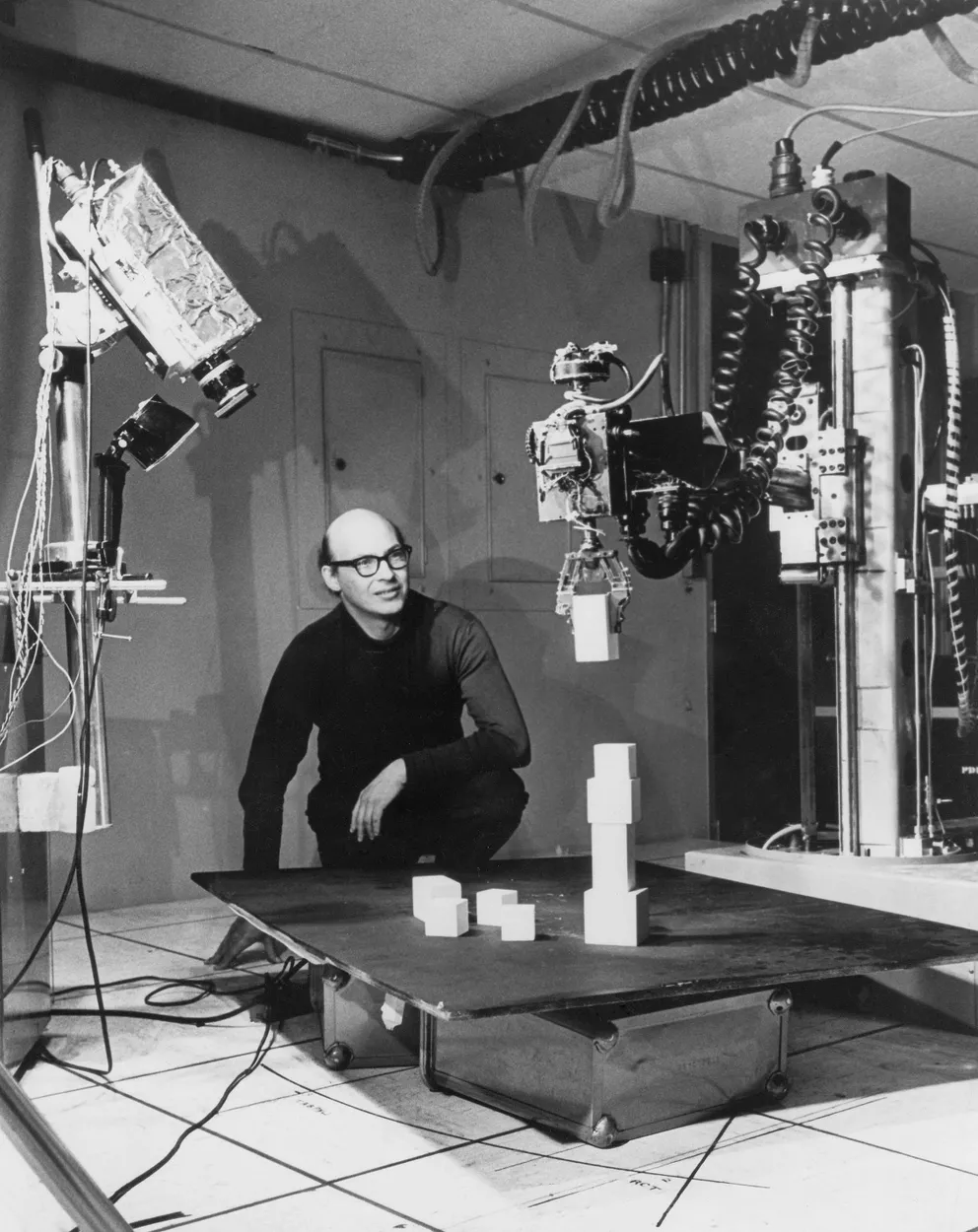

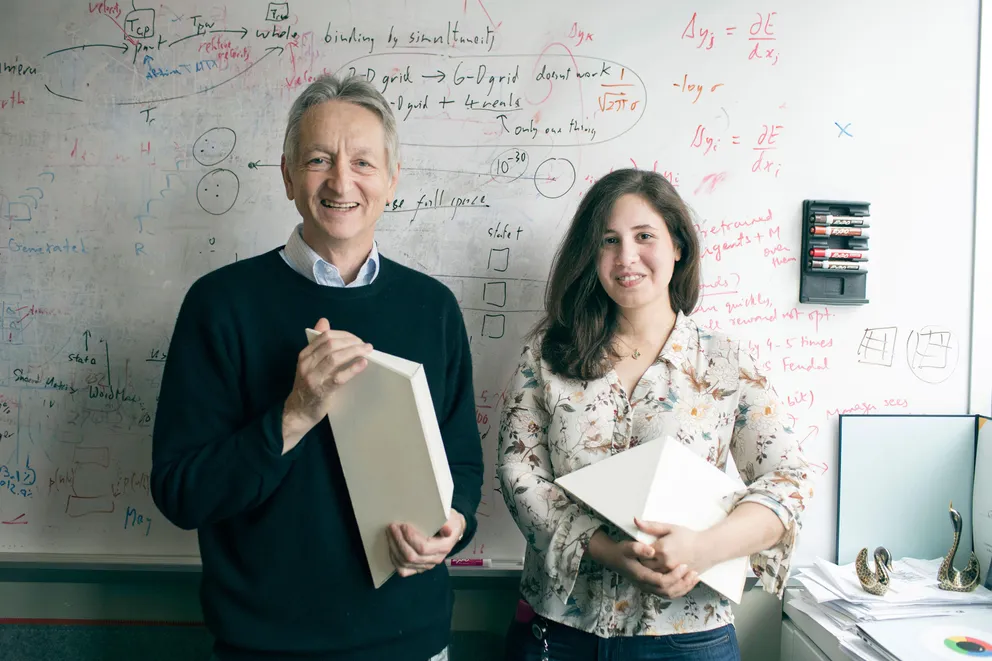

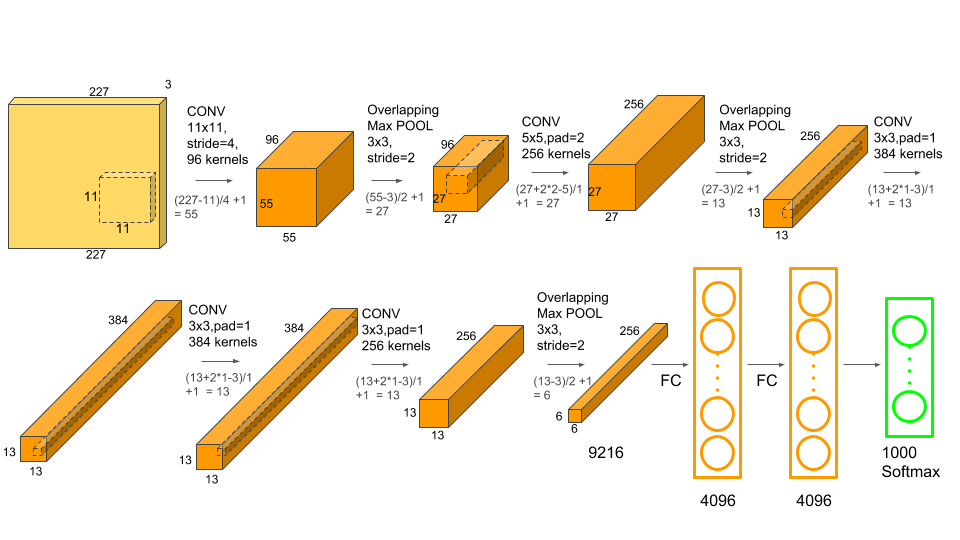

【导读】人工智能的发展已有65年的历史,曾经历过寒冬,也经历过辉煌。从符号主义的专家系统到现在所向披靡的神经网络,不少人担心是否寒冬会再来,也有乐观的人表示人工智能的春天也要来了。回到人工智能发展的开端,也许会有答案。

THE END

来源 | 新智元

版权声明:本号内容部分来自互联网,转载请注明原文链接和作者,如有侵权或出处有误请和我们联系。

评论

下载APP

下载APP正文共:4014-15图

预计阅读时间:11分钟

THE END

来源 | 新智元

版权声明:本号内容部分来自互联网,转载请注明原文链接和作者,如有侵权或出处有误请和我们联系。