知乎好物自动化(一)

一行

读完需要

速读仅需 1 分钟

大家好,我是一行

上一篇文章和大家一起分享了自动化赚钱的可能性,这让大家对 python 的热爱又燃上心头。

当然,很多人觉得自动化赚不可能,在我看来这就是归因于认知问题和技术问题。认知不够永远不了解某些玩法居然还能赚钱,技术不够就算知道也没用(当然技术够了,也很容易走上计算机信息破坏罪,需要谨慎)。

这里给大家举一些自动化副业例子:

python 基于各种币的涨跌一致性和时间差异自动交易 ( https://github.com/edeng23/binance-trade-bot?fileGuid=vHx8qp3T9WPjCwrj )

这些就是认知带来的用自动化玩法

自动化副业

所以用 python 自动化赚钱目测起来还是非常的有意思,可以长期更新下去。

这里一行的自动化副业先尝试在知乎好物这个点进行攻破。

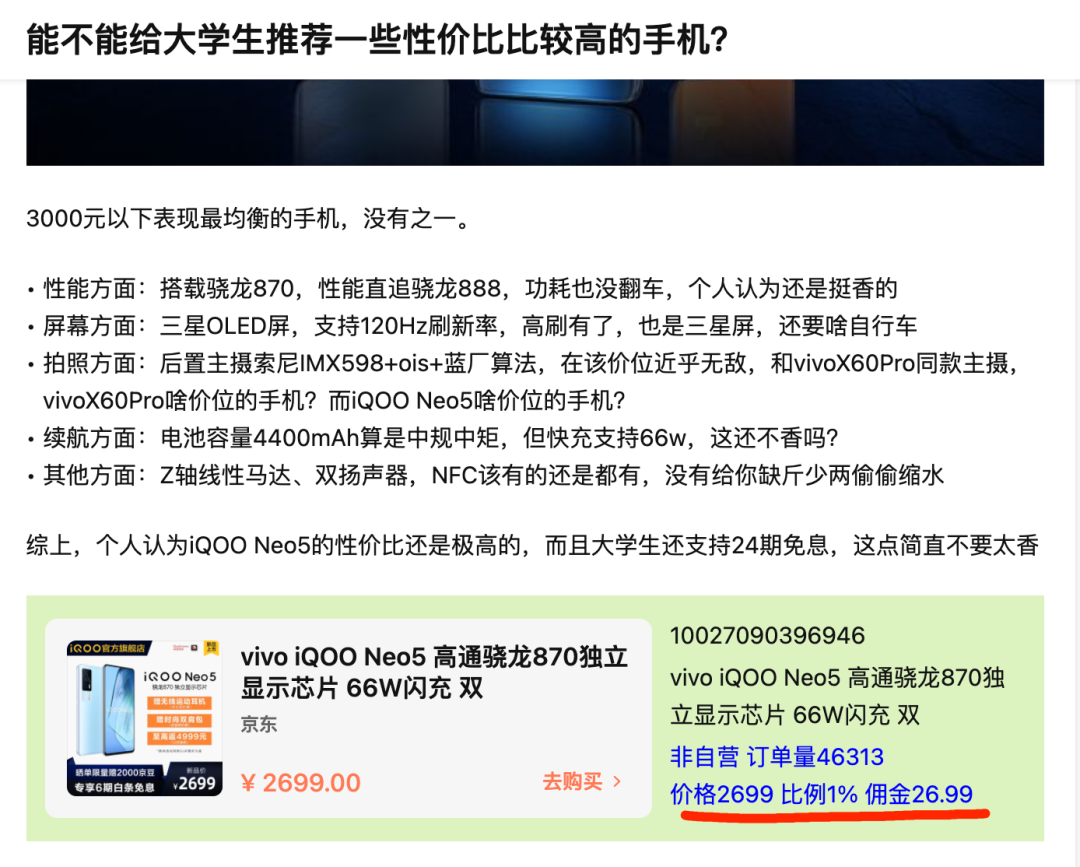

它的底层逻辑很简单,淘客带货的一种。通过在知乎这个平台上介绍这个物品的好处,让人进行购买,并从中获得佣金。

例如我下载过一个插件,可以直接在回答页面展示好物的佣金和订单量,就能大概了解此类商品的收益如何。

那如何进行自动化知乎好物呢?

下面我们可以进行拆解,知乎好物的细节动作如下

自动养号,提升账号权重

自动找到合适的问题列表

自动下载内容,获取素材

自动分析内容绘制图表

将图表插入到指定的文案模版中

自动找到问题并进行回答

自动预测热榜等等

所以对应「自动化知乎」细节问题,只需要一一攻破就好。

Python 自动下载知乎回答

使用 Python 自动下载知乎回答之前已经给大家介绍过具体的使用方法,具体可以点击👇的文章查看

具体的原理就是使用知乎提供的接口进行访问,并提取出其中所需要的信息即可。

接口如下:

# qid:知乎问题号# offset:第几页url = "https://www.zhihu.com/api/v4/questions/{}/answers?include=content&limit=20&offset={" "}&platform=desktop&sort_by=default".format(qid, offset)

举例:知乎篇篇阅读 10w+的回答

这里用一些工具,通过知指数进行筛选,例如下面这个问题,仅仅 26 个回答,确有上千万的阅读量 👇「真心话有什么劲爆的问题?」

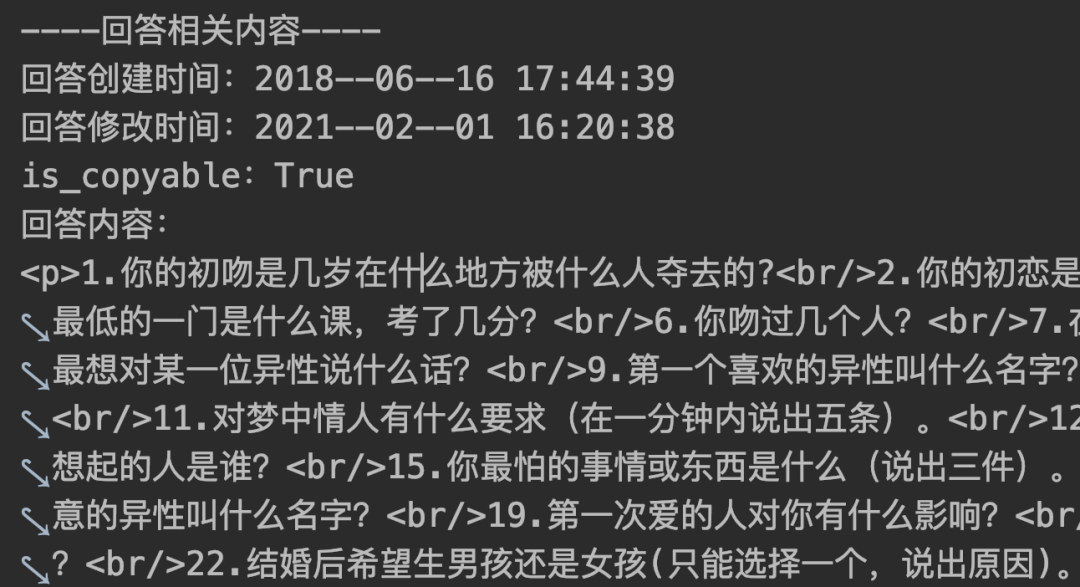

爬虫获取之后,可以采集每个回答的内容

当然,对于每个回答的可信度,除了内容本身,作者的流量动作也很相关,所以在上次代码改良之后又加入了提取作者信息的代码块

进一步可以进行数据分析,将这些文档自动归纳在一起,合理组成图文,便可以设置在一起。

最后

据说每一个自动化副业的都会经历下面这张图的历程,还好还好,毕竟我这个「这个创意真牛逼」。

所以目前「自动化知乎好物」已完成:

自动养号,提升账号权重

自动找到合适的问题列表

自动下载内容,获取素材

自动分析内容绘制图表

将图表插入到指定的文案模版中

自动找到问题并进行回答

自动预测热榜等等

日拱一卒,我们下期见!