用Python一次性把论文作图与数据处理全部搞定!

共

1917字,需浏览

4分钟

·

2021-01-21 17:31

年底将近,“防脱发用生姜还是黑芝麻?”,研究僧们又开始为自己所剩无几的头发发愁了。置顶了一页实验组微信群、QQ群,想追踪前沿文献,了解跟自己课题组相关的科研潮流,拿到好的课题走上人生巅峰。关注了几十个相关学术话题,打开知乎想搜搜大佬们的回答,却刷了半个小时热门推送——好吧,那去知网和Web of Science一篇一篇看吧。可是同一个文献网站用的多了,往往会发现会有重复文献出现。文献量庞大的话,还得手动剔除已经检索过的文献,分辨哪些是后来更新的文献。每天除了吃饭睡觉做实验外,干的最多的活莫过于阅读文献了。文章看得多了头晕眼花,还影响做实验的时间,不知不觉就成了——这些时间如果能拿来休息,参加学术会议,和大牛们交流,学习新知识该多好~犹记得我初入实验室,一拿到数据就想要跟师兄师姐邀功。“学妹这样不行的呀,共聚焦显微镜下拍摄的两个探针的信号,需要做共定位分析,去算一下共定位系数和 Pearson 相关系数吧。数据图除了做单因素方差分析还要重点看有没有显著性差异。”以为拿到好数据就可以喘口气,没想到统计和作图又开始让人头秃。作为一名科研人,不管愿意不愿意,总是读文献、做实验、写论文三点一线的。于是就遇到一个难题,论文的数据都必须进行统计学处理。90% 国际 SCI 临床医学杂志会对投稿文章进行统计学审稿,影响因子越高的期刊对统计学审稿要求也越严格。看见师兄文章里明了高端的 PPI 图、热图、富集图、韦恩图、和弦图、火山图和主成分分析图,自己和他们的差距一目了然,发表SCI感觉遥不可期。大数据时代,只要找准科研方向,没有什么是一波优质数据搞不定的?如果有,那就再配上信息挖掘和数据分析工具。Python作为一款效率工具,在人工智能和数据分析等领域表现非常突出,像自动抓取资料、分析数据、自动下载,提取关键词等这样的功能都是分分钟完成。

- 以前需要打开各类学术网站,然后手动一个一个下载需要的文献,然后再手动进行分类,得用上半天的时间才能够解决这项重复的事情。

- 而用Python,不仅能1 秒定位目标文献,还能自动对应下载相关领域的关键文章、重要作者和科研热点,追溯文献引证关系。

这中间省下的时间,可以去学习(打球)、做实验(谈恋爱)......科研生活一下子就变得明亮了!- 在数据处理方面,我们可能要面对上万条序列的文件,由于文件过大,不要说进行处理了,连打开文本都会直接卡死。

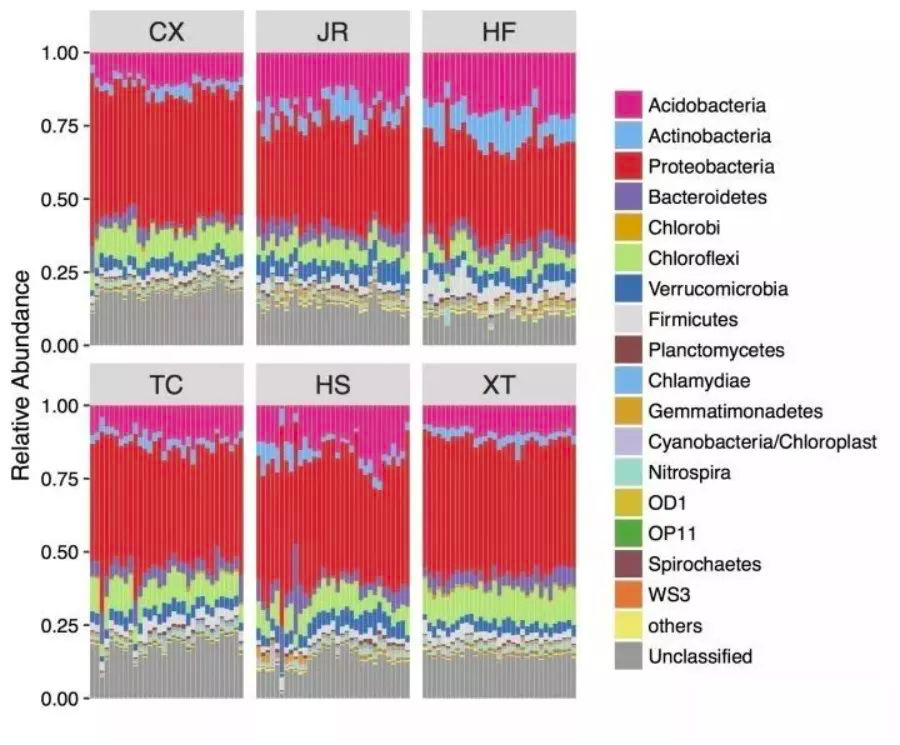

- 而通过Python输入原始数据后,不仅能自动统计分析海量数据,还能得到满足论文发表的高质量图片。

这样的效率和质量,是不是又让我们离发表SCI论文更近了一步?这也是为什么,我这次想把扇贝的Python编程课推荐给大家的原因!一个让我改变对编程固有认知的地方,也希望这一次,能够帮助到你。很多人一提起Python,第一反应就是,计算机?编程?太难了我学不会。其实学Python,不用你英语数学有多好,不用你是理科生,你只需要:以前一提起学软件,大家第一印象就是:好麻烦,要自己下各种东西、还不确定能不能下载到正确的软件。

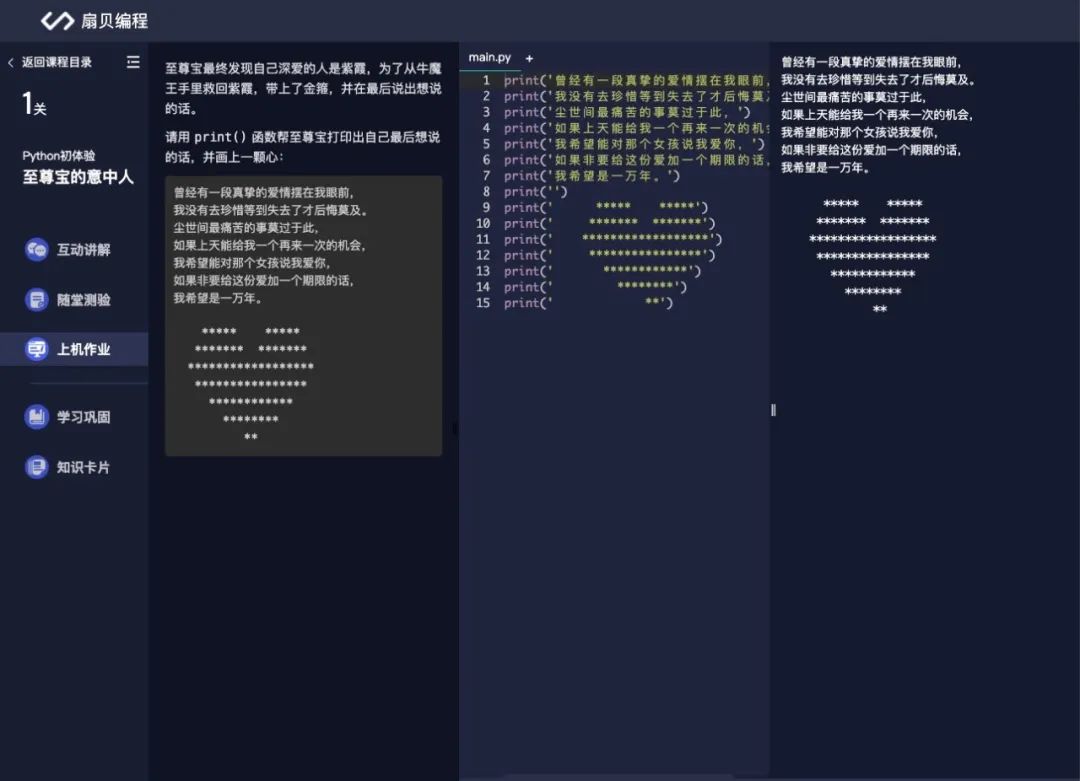

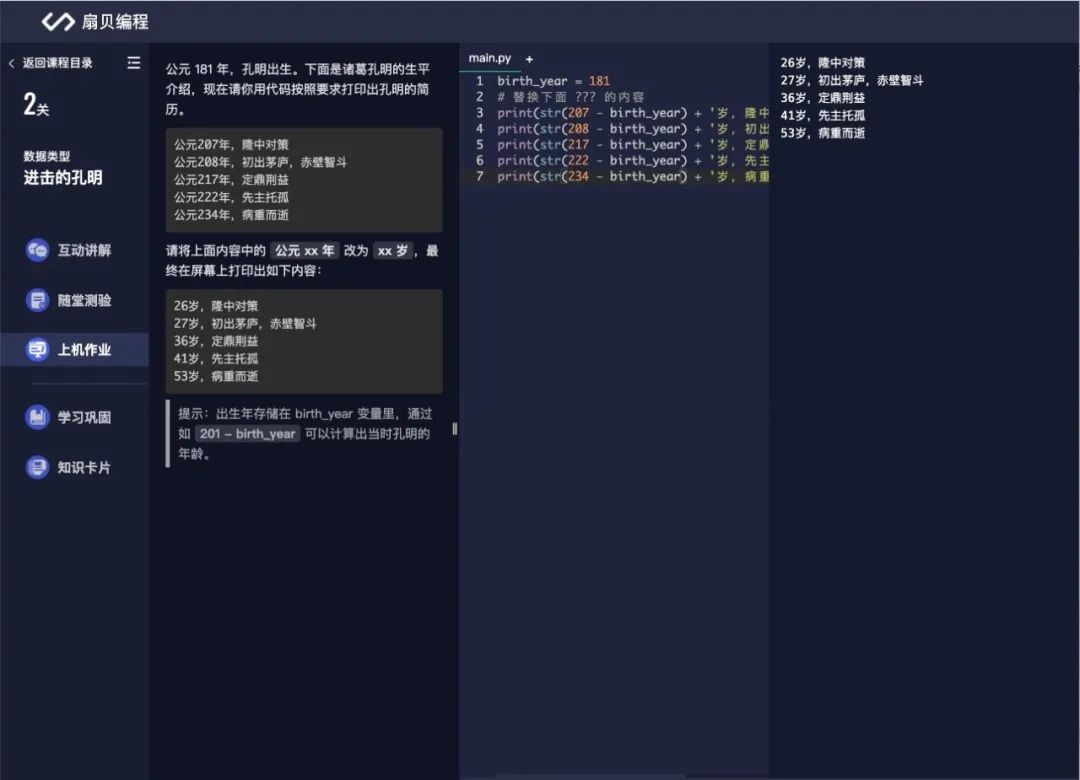

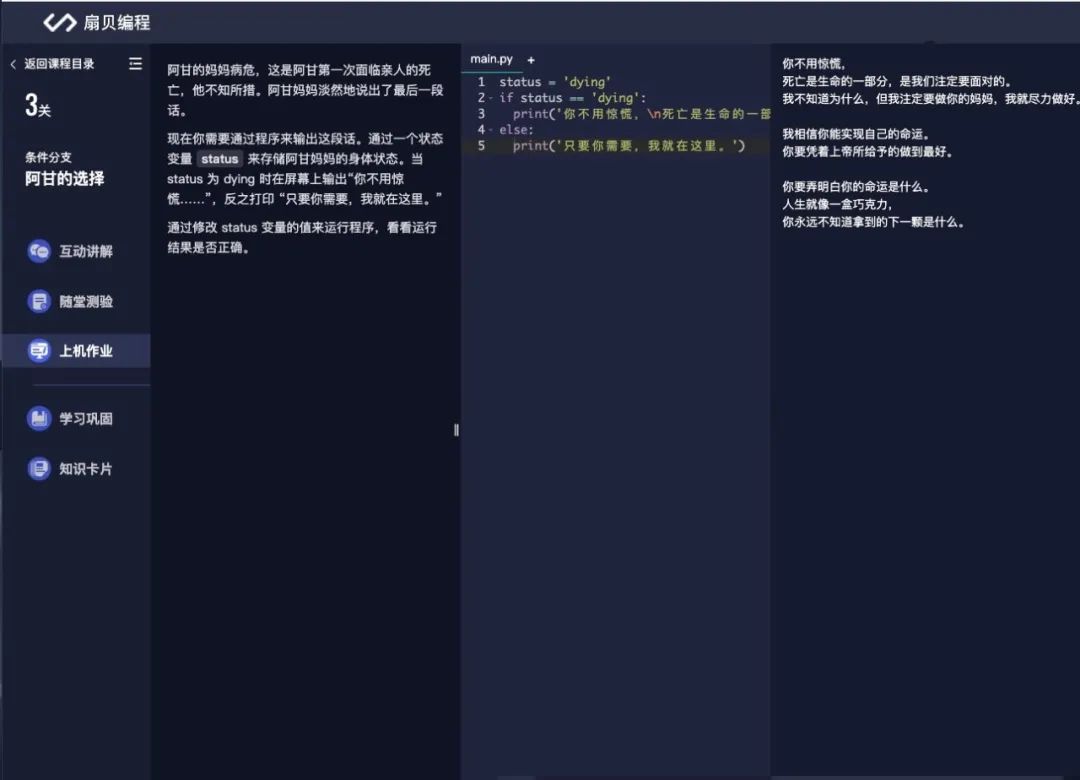

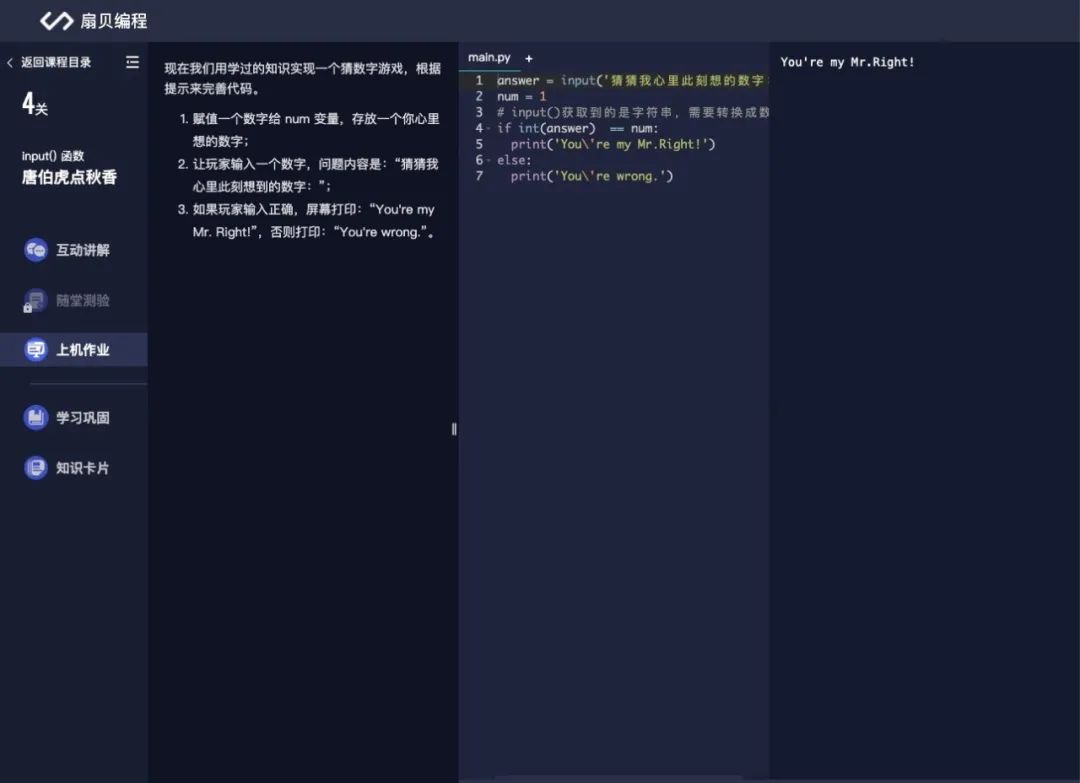

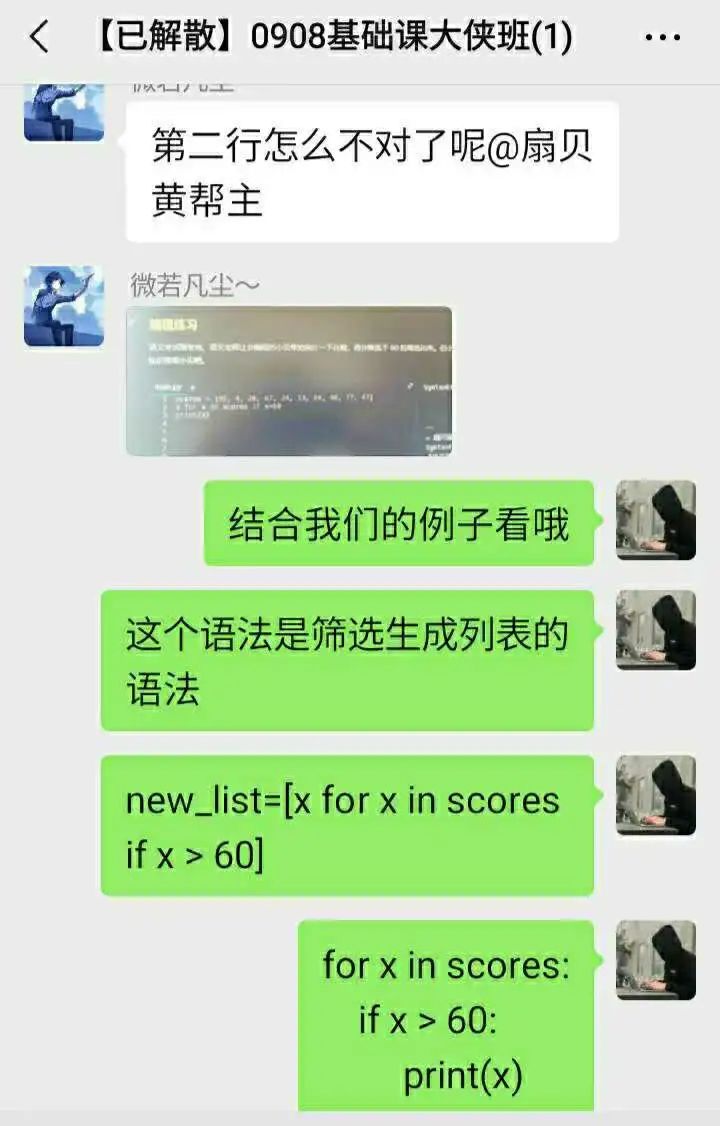

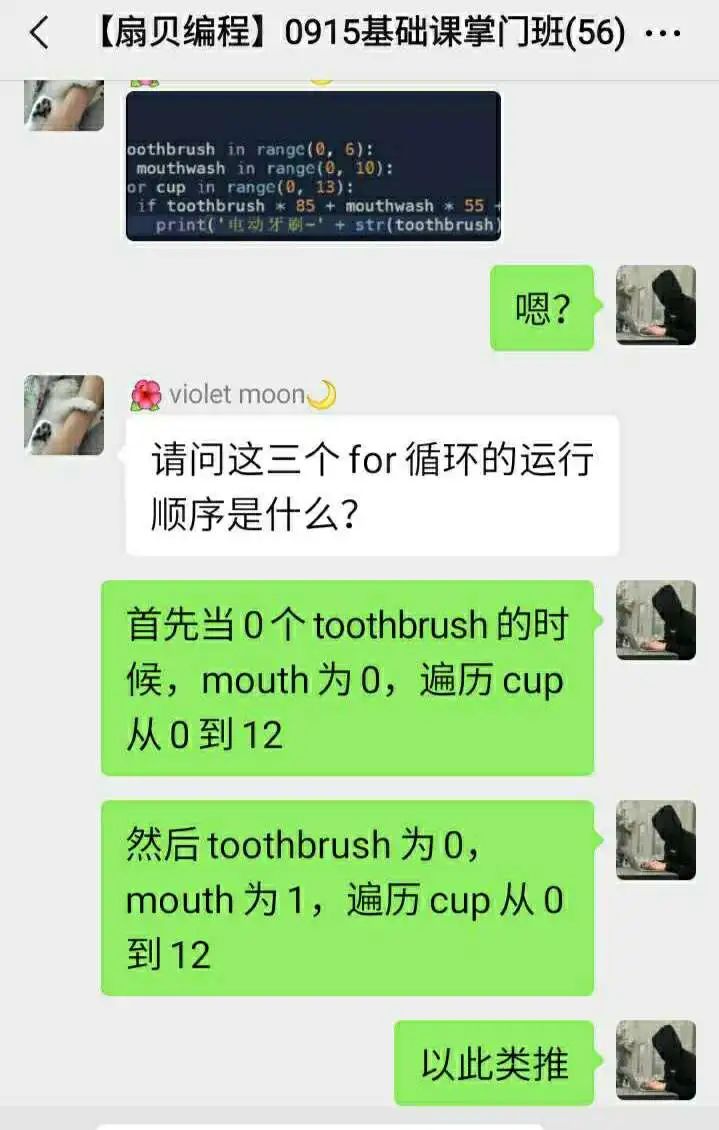

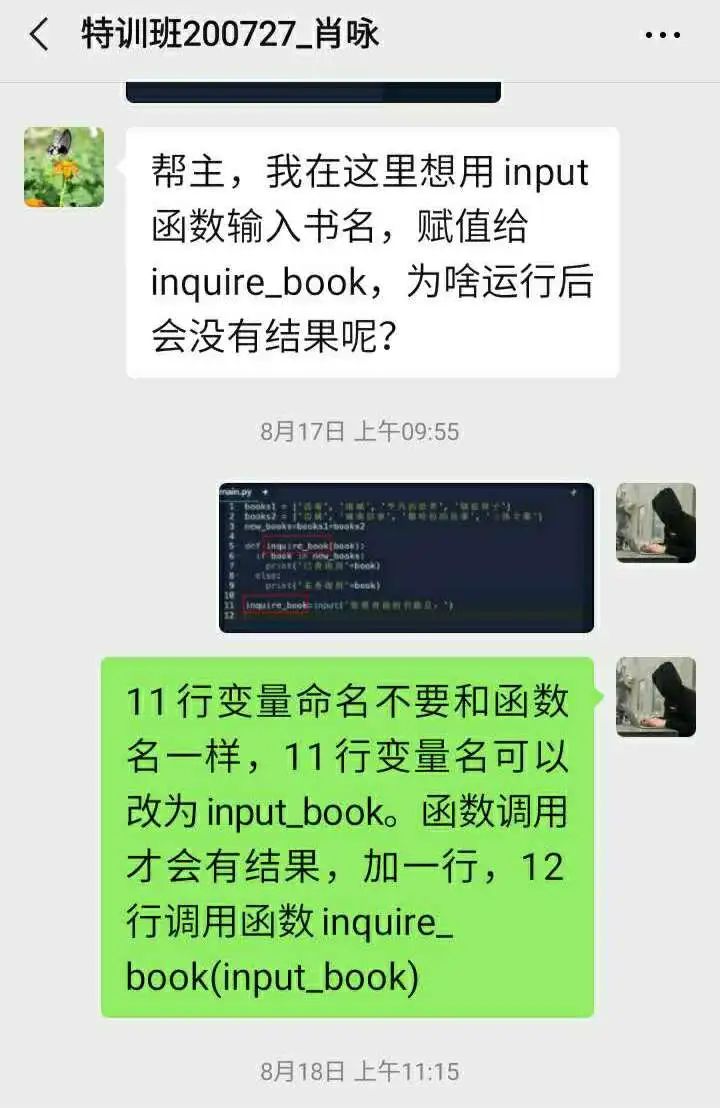

第一天,在至尊宝的带领下,学习print函数、换行和转义字符,拿代码画 ❤ 也太酷了!第二天,带着孔明的智慧,学习浮点数、变量、类型转换;第三天,用新学的条件结构和 if...else 语句,为阿甘选择;第四天,用 input 语句为唐伯虎找出他的秋香!同时拉你入班级群,和小伙伴们一起交流进步,让你学习路上不孤单。👇 戳“阅读原文”, get✨ 2021最强科研技能!

点赞

评论

收藏

分享

手机扫一扫分享

举报

点赞

评论

收藏

分享

手机扫一扫分享

举报