Shikra:新一代多模态大语言模型,理解指向,说出坐标

本文来源 arXiv每日学术速递 侵删

卧剿,6万字!30个方向130篇!CVPR 2023 最全 AIGC 论文!一口气读完

“

Shikra:解锁多模态语言模型参考对话的魔法 🪄 ”

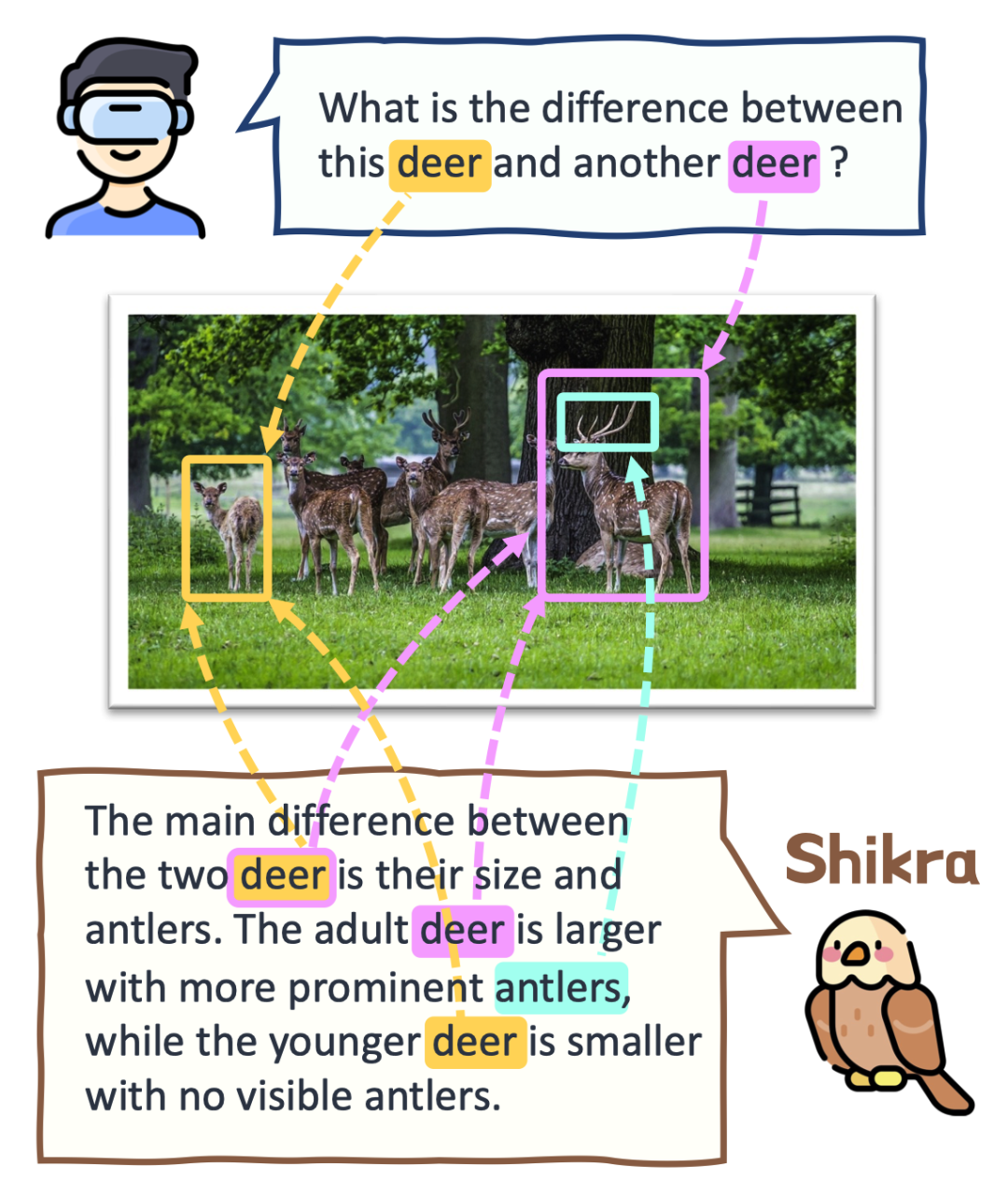

Shikra和用户的对话案例

-

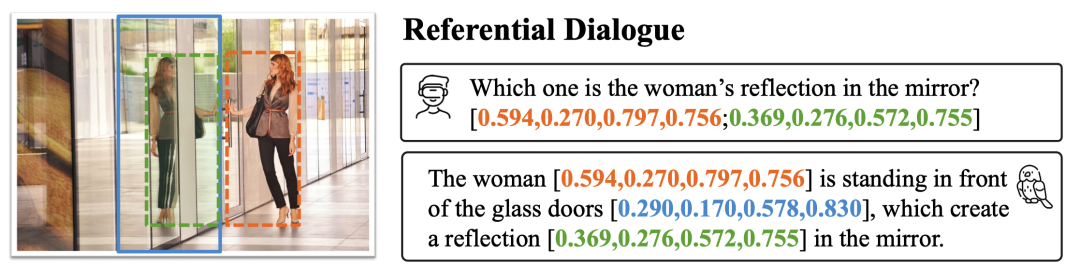

在人类的日常交流中,经常会关注场景中的不同区域或物体, 双方 都可以通过说话并 指向 这些区域来进行高效的信息交换。我们将这种对话模式称为 参考对话(Referential Dialogue)💬 ;

-

如果多模态大语言模型(MLLM) 擅长这项技能,它将带来许多令人兴奋的应用。例如,将其应用到 Apple Vision Pro 等混合现实 (XR) 眼镜中,用户可以使用 视线注视 指示任何内容与AI对话。同时AI也可以通过 高亮等形式来提示某些区域 ,实现与用户的高效交流;

-

本工作提出了 Shikra 模型,赋予了MLLM这样的参考对话的魔法,既可以理解 位置输入 ,也可以产生 位置输出 。

📃论文链接:http://arxiv.org/abs/2306.15195

⚙️代码链接:https://github.com/shikras/shikra

01

—

工作亮点

- Shikra 能够理解用户 输入 的 Point/Box,并支持 Point/Box 的 输出 ,可以和人类无缝地进行参考对话;

- Shikra 设计简单统一,采用非拼接式设计,直接使用 数字 表示坐标, 不需要 额外的位置编码器、前/后目标检测器或外部插件模块,甚至 不需要 额外的词汇表。

02

—

模型效果

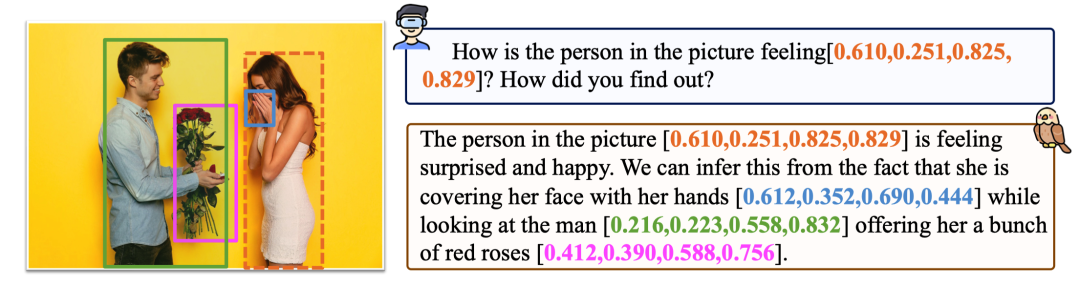

比如上图,用户指着右边的女生问 Shikra:“这个人[bbox]的感受如何?” Shikra 回复说:“这个人[bbox]感觉到惊喜和高兴。我们可以根据:她用手[bbox]捂着脸,看着这个男人[bbox]送她一束花[bbox]推断出来。” Shikra 不仅推理正确,并且在提到关键视觉线索的时候还会提供在图上的坐标,这让沟通更加准确高效;

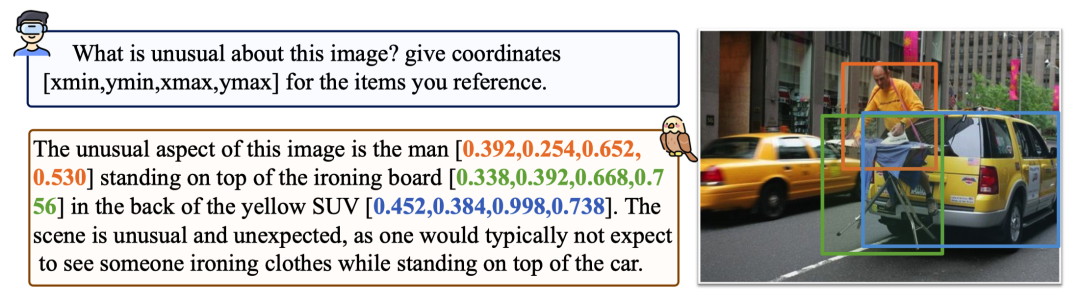

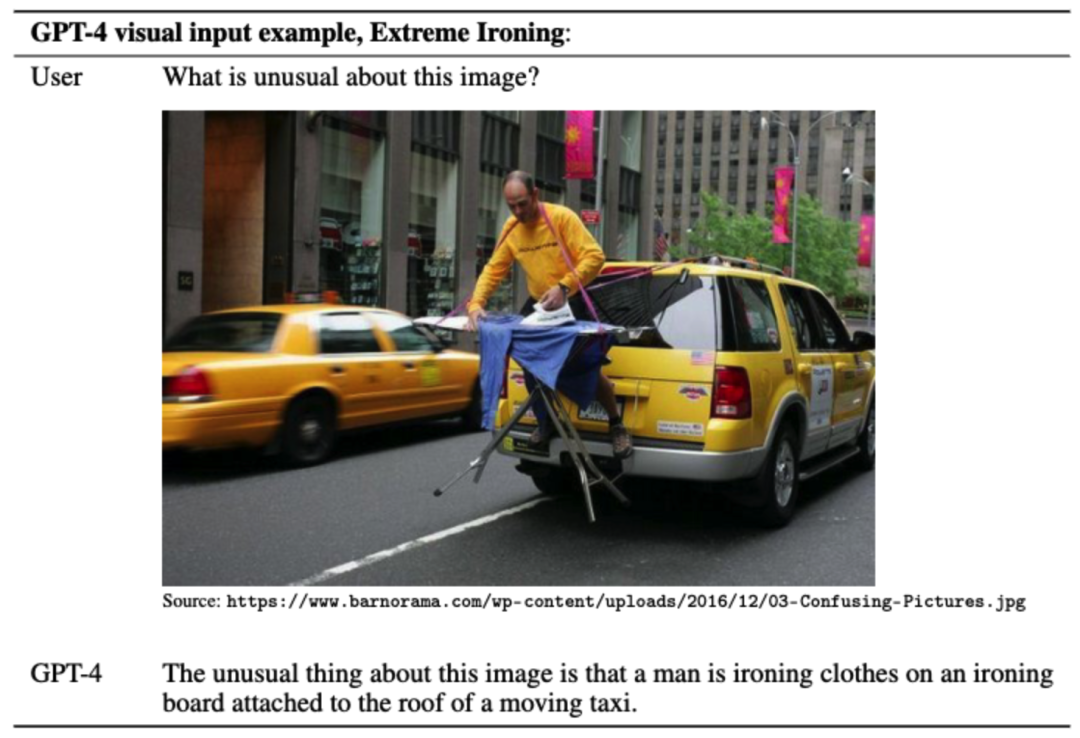

我们来看来自GPT4论文中的网红图片。相比GPT4的回复,Shikra 的回复不光 Get 到了图片的诙谐之处,还更确切地指出了每个需要被关注的目标的具体位置。作为对比,下面是GPT4的回答:

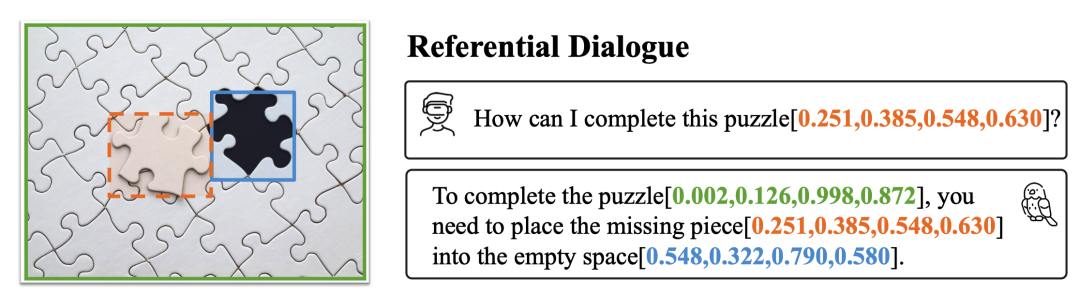

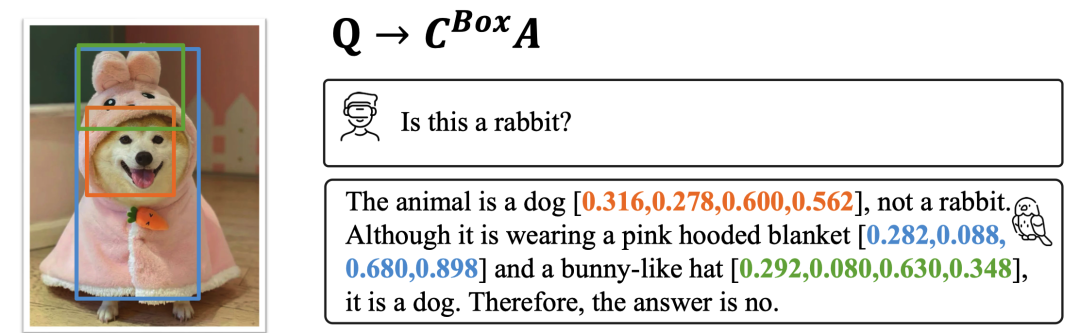

我们在下面再展示几个例子,更多的例子可以查阅 Paper。

比如 Shikra 会拼拼图,知道用户指出的拼图块应该拼到哪里。

比如 Shikra 会拼拼图,知道用户指出的拼图块应该拼到哪里。

03

—

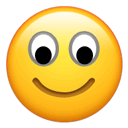

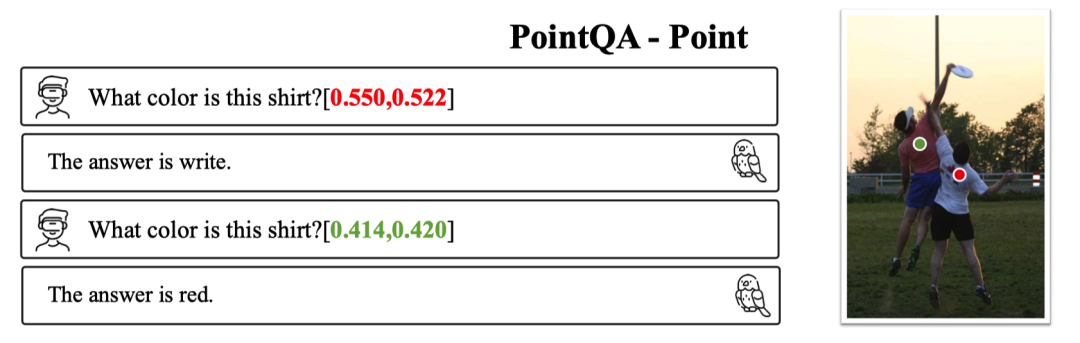

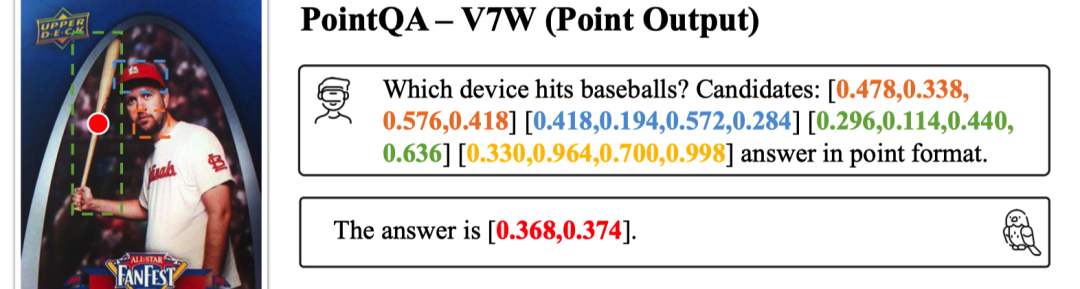

Box/Point 都行

04

—

传统任务

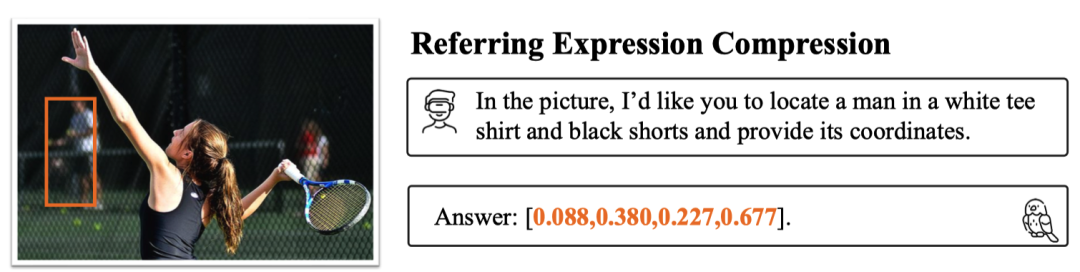

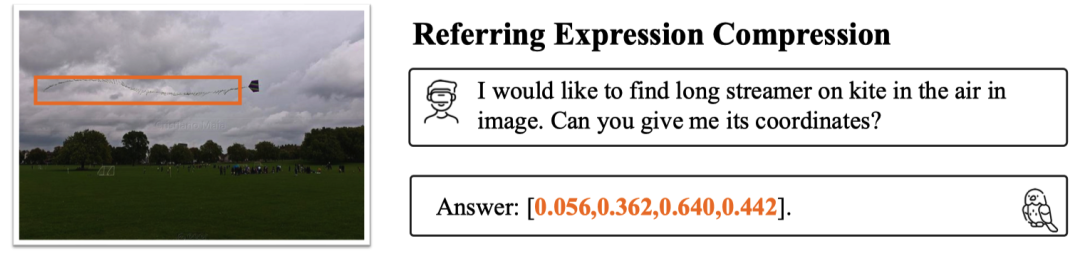

定位出背景中的人,定位出风筝的线,都没有问题。示例看的不过瘾?可以看看的在REC上的定量指标,Shikra 取得了很不错的成绩:

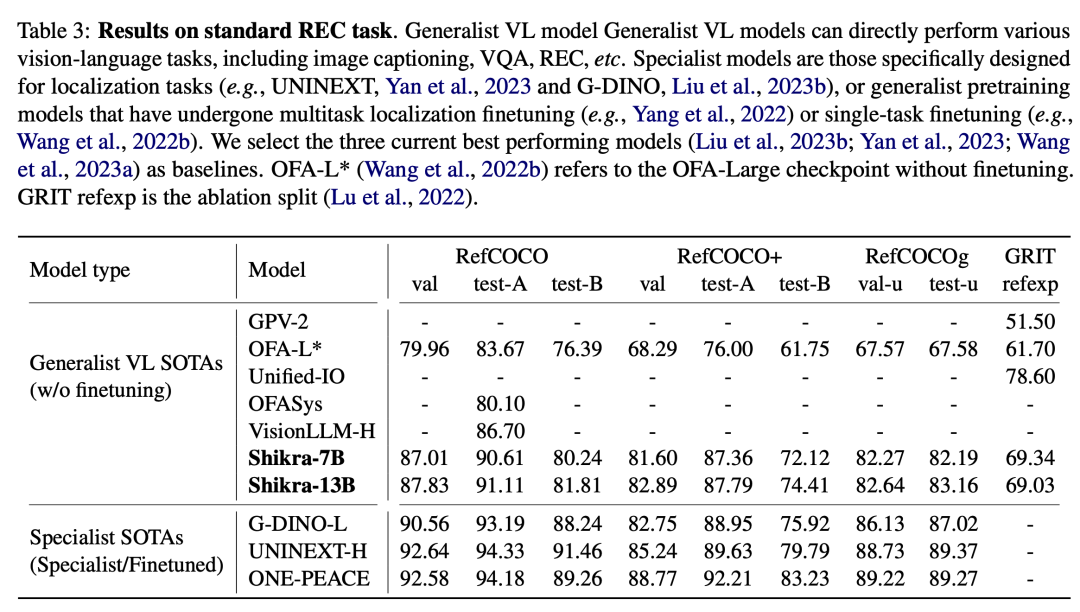

Shikra 也有一定的OCR能力,尽管没有专门在相关的数据上训练:

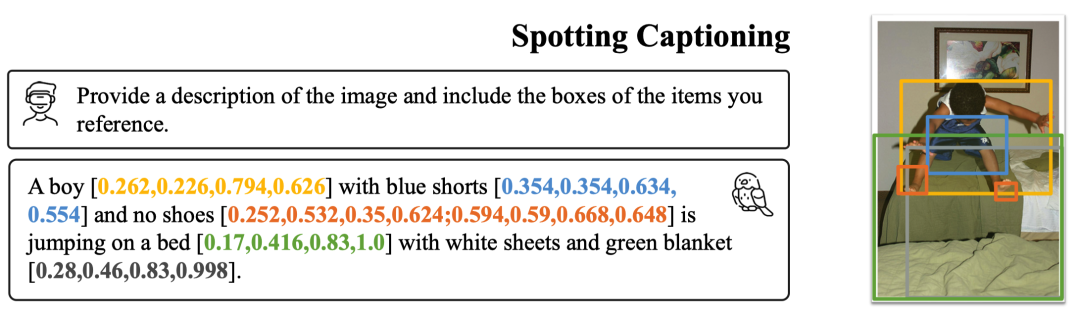

还有本工作定义的新任务,Spotting Captioning 任务,模型需要边描述图片边写出提到的物体的坐标,效果就像这样:

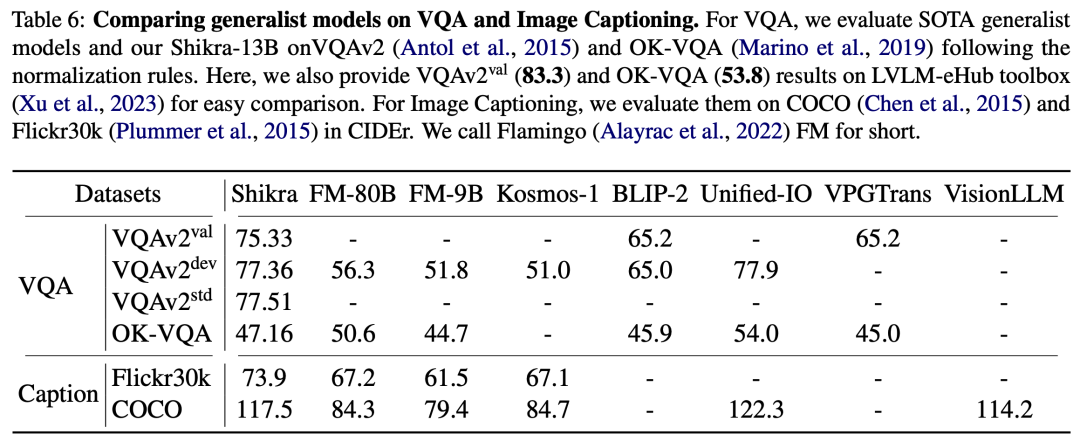

在最经典的 VQA 和 Image Captioning 的定量评价上,Shikra也取得了 promising 的结果:

05

—

Shikra 原理

模型架构采用CLIP ViT-L/14 作为视觉主干,Vicuna-7/13B 作为语言基模型,使用一层线性映射连接CLIP和Vicuna的特征空间。

Shikra 直接使用自然语言中的 数字 来表示物体位置 ,使用[xmin, ymin, xmax, ymax] 表示边界框,使用[xcenter, ycenter]表示中心点,xy 坐标根据图像大小进行 归一化 , 每个数字默认保留 3 位小数 , 这些坐标可以出现在模型的输入和输出序列中的任何位置,记录坐标的方括号也自然地出现在句子中。在论文中,本工作也尝试使用其他方式进行数值表示,并做了定量的对比实验,感兴趣的朋友可以查看论文。

06

—

新思维链形式

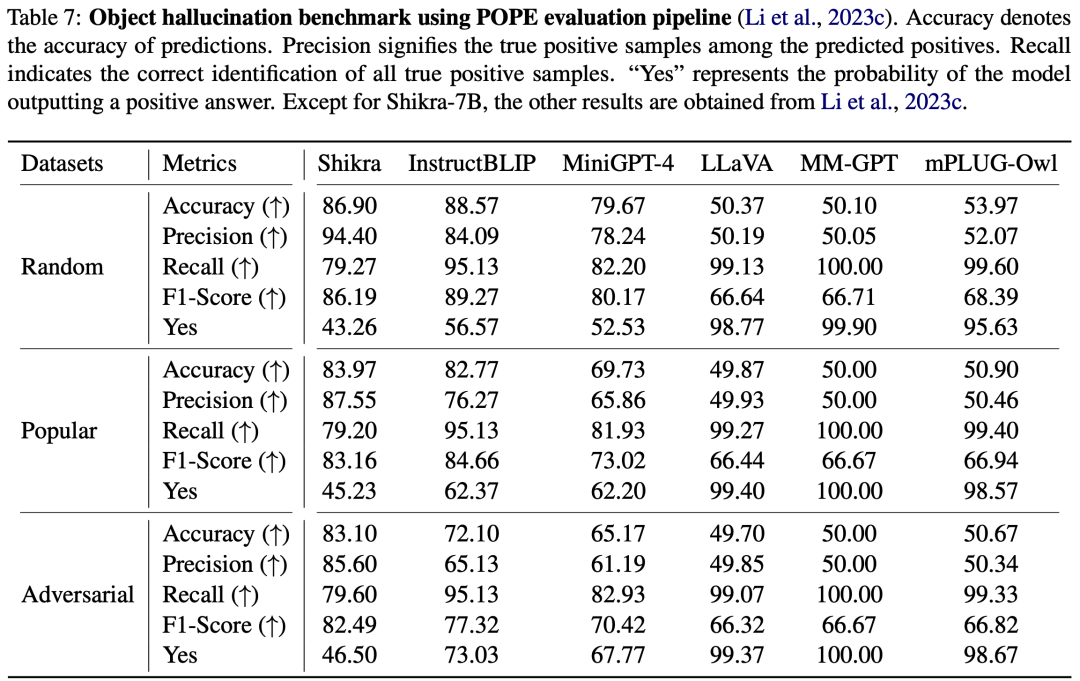

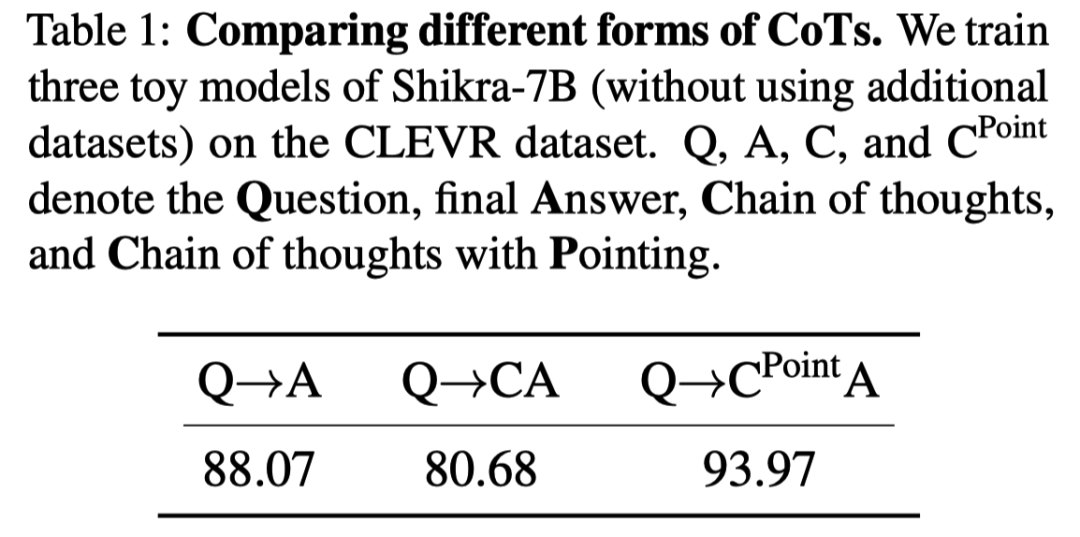

思想链(CoT),旨在通过在最终答案前添加推理过程以帮助LLM回答复杂的QA问题。这一技术已被广泛应用到自然语言处理的各种任务中。目前的MLLM还存在严重的幻视问题,CoT也经常会产生幻觉,影响最终答案的正确性。通过在合成数据集CLEVR上的实验,本工作发现,使用带有位置信息的CoT时,可以提升模型回答的准确率。

如果只用纯文本的CoT,模型性能反而会降低,甚至不如不用CoT的结果。但是在CoT中包含坐标信息,性能得到了提升,我们将这种新的 CoT 方式称为 Grounding-CoT(GCoT) 。不过该探究仍然比较初步,仍是值得去论证的方向。

07

—

总结

关注公众号【机器学习与AI生成创作】,更多精彩等你来读

深入浅出stable diffusion:AI作画技术背后的潜在扩散模型论文解读

深入浅出ControlNet,一种可控生成的AIGC绘画生成算法!

戳我,查看GAN的系列专辑~!

一杯奶茶,成为AIGC+CV视觉的前沿弄潮儿!

戳我,查看GAN的系列专辑~!

一杯奶茶,成为AIGC+CV视觉的前沿弄潮儿!

最新最全100篇汇总!生成扩散模型Diffusion Models ECCV2022 | 生成对抗网络GAN部分论文汇总

CVPR 2022 | 25+方向、最新50篇GAN论文

ICCV 2021 | 35个主题GAN论文汇总

超110篇!CVPR 2021最全GAN论文梳理

超100篇!CVPR 2020最全GAN论文梳理

附下载 |《TensorFlow 2.0 深度学习算法实战》

《礼记·学记》有云:独学而无友,则孤陋而寡闻

点击 一杯奶茶,成为AIGC+CV视觉的前沿弄潮儿! ,加入 AI生成创作与计算机视觉 知识星球!