来源:B站

编辑:LRS

【新智元导读】B站一个技术Up把70年前的纪录片《抗美援朝》恢复成彩色4K60帧,让广大网友又重新真切地回到那个年代,致敬最可爱的人!用到的技术主要包括视频插帧、照片着色、图像超分辨率。

受到技术限制,以前(很久以前)的老电影、老照片、历史记录都是黑白色的,在看惯了彩色电视的今天,虽然黑白视频有着历史感,但代入感不如彩色强。

随着AI技术的发展,如超分辨率、自动着色技术在深度学习加持下,这些珍贵的影像也能够重新以彩色的形式出现在大众的面前。

一位B站up主修复了1951年北京电影制片厂摄制的纪录片《抗美援朝》,其中包括我国志愿军将士跨过鸭绿江的珍贵镜头。

网友评论中表示自己的先辈就是志愿军,如今能看到这些彩色的视频,十分感动,致敬这些最可爱的人,在那个充满理想的年代为了我们的和平而奋斗!

1950年7月10日,抗美援朝运动开始。10月,中国人民志愿军赴朝作战,拉开了抗美援朝战争的序幕。1953年7月,双方签订《朝鲜停战协定》,从此抗美援朝胜利结束。1958年,志愿军全部撤回中国。

可能受当时拍摄技术限制,修复后的视频在曝光上控制的不太理想。

由于修复后的视频是60FPS彩色4K的,并且上色模型在静止镜头上有更好的表现,所以第一步需要对原始视频增加更多的参考帧,即根据两帧之间的变化来预测中间缺失的帧画面。

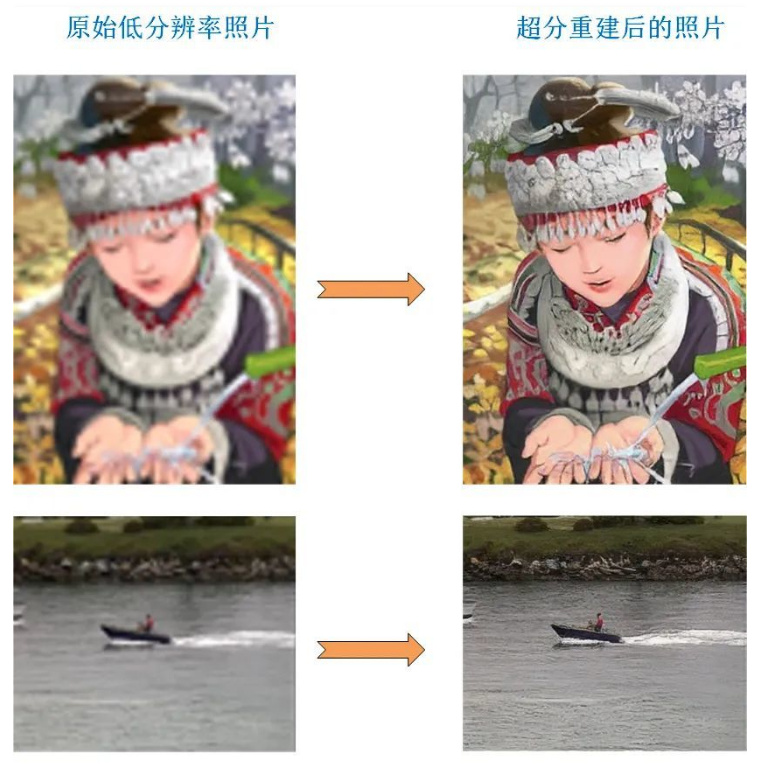

院线电影通常使用每秒24格的帧率拍摄及播放,而电视传统上则是使用每秒25格(PAL制式)或每秒30格(NTSC制式)的帧率拍摄及播放,直到近现代720p的HDTV出现后,才改以每秒50格或每秒60格的帧率播放。在电影中使用超过每秒24格、或是在电视中使用每秒超过30格的帧率拍摄及播放,就可称为高帧率了。人的大脑视觉处理中心,大约会看到的影像视觉暂留100-400毫秒,因此,当眼前的画面每秒变换15次以上的时候,人的大脑就会有了连续动作的错觉。所以一般来说30 帧每秒(frame per second, fps)就是可以接受的,但是将性能提升至60fps则可以明显提升交互感和逼真感,但是一般来说超过75fps一般就不容易察觉到有明显的流畅度提升了。在提升帧率后,融合了两步上色模型,让视频的颜色还原更加真实。黑白图像主要使用一个颜色通道来保存图片,而RGB彩色图片包含三个通道(红绿蓝三个值表示一个颜色)。通常恢复颜色采用GAN模型,训练一个生成器G,从灰度图生成彩色图,再训练一个判别器D,专门辨别这张图和原图的差距是多少,训练完成后就可以得到一个还原颜色的模型。上色模型的效果与训练数据密切相关,如果训练数据和预测数据不同,就会产生非常诡异的结果。原图(左)与上色图(右)之间存在明显差异,模型没有从数据中学到每个食物应有的颜色。最后一步就是提升视频的分辨率。图像的超分辨率重建技术指的是将给定的低分辨率图像通过特定的算法恢复成相应的高分辨率图像。

2014年,Dong等人首次将深度学习应用到图像超分辨率重建领域,他们使用一个三层的卷积神经网络学习低分辨率图像与高分辨率图像之间映射关系,并将他们的设计的网络模型命名为SRCNN(Super-Resolution Convolutional Neural Network)。2017年,Christian Ledig等人从照片感知角度出发 ,首次通过对抗生成网络来进行超分重建,在论文Photo-Realistic Single Image Super-Resolution Using a Generative Adversarial Network中描述了SRGAN算法。之前的深度学习使用MSE损失函数会导致重建的图像过于平滑,缺乏感官上的照片真实感。英伟达之前推出的DLSS(大力水手),即深度学习超级采样(Deep Learning Super Sampling)功能也有类似的效果。在RTX显卡上,载有专用于神经网络的计算单元Tensor Core,能支持较小的深度学习模型的实时处理。DLSS就是载入英伟达预先在超级计算机上训练好的模型载入到Tensor Core中,输出更高分辨率的图像。在旧显卡中的运算都是在CUDA core中,深度学习计算会占用主线程资源,导致得不偿失。DLSS 2.0 为用户提供质量(Quality)、平衡(Balanced) 和性能(Performance) 3 种画质模式来控制游戏的内部渲染分辨率,在《赛博朋克2077》还拥有“超高性能”(Ultra Performance)画质模式。启用性能(Performance) 模式后,可实现高达 4 倍的超高分辨率(即从 1080p 到 4K)。有了这些AI技术,快看看你有没有以前的黑白视频,把它们也恢复成高清彩色吧!

2014年,Dong等人首次将深度学习应用到图像超分辨率重建领域,他们使用一个三层的卷积神经网络学习低分辨率图像与高分辨率图像之间映射关系,并将他们的设计的网络模型命名为SRCNN(Super-Resolution Convolutional Neural Network)。2017年,Christian Ledig等人从照片感知角度出发 ,首次通过对抗生成网络来进行超分重建,在论文Photo-Realistic Single Image Super-Resolution Using a Generative Adversarial Network中描述了SRGAN算法。之前的深度学习使用MSE损失函数会导致重建的图像过于平滑,缺乏感官上的照片真实感。英伟达之前推出的DLSS(大力水手),即深度学习超级采样(Deep Learning Super Sampling)功能也有类似的效果。在RTX显卡上,载有专用于神经网络的计算单元Tensor Core,能支持较小的深度学习模型的实时处理。DLSS就是载入英伟达预先在超级计算机上训练好的模型载入到Tensor Core中,输出更高分辨率的图像。在旧显卡中的运算都是在CUDA core中,深度学习计算会占用主线程资源,导致得不偿失。DLSS 2.0 为用户提供质量(Quality)、平衡(Balanced) 和性能(Performance) 3 种画质模式来控制游戏的内部渲染分辨率,在《赛博朋克2077》还拥有“超高性能”(Ultra Performance)画质模式。启用性能(Performance) 模式后,可实现高达 4 倍的超高分辨率(即从 1080p 到 4K)。有了这些AI技术,快看看你有没有以前的黑白视频,把它们也恢复成高清彩色吧!

参考资料:

https://b23.tv/iLPjdv