新闻聚源集成 BBC News

idea of startproject

对于 web 开发者而言,目前各大新闻门户网站,新浪新闻,百度新闻,腾讯新闻,澎湃新闻,头条新闻并没有提供稳定可用的 feed api。

对于 nlper,缺乏足够的新闻语料数据集来供训练。

对于新闻传播/社会学/心理学等从业者,缺乏获取新闻数据的简单易用途径来供分析。

如果上面三点是某见识所限,其实并不存在的话,第 4 点,则是某的私心,某以为互联网的记忆太短了,热搜一浪盖过一浪,所以试图定格互联网新闻的某些瞬间,最后会以网站的形式发布出来。

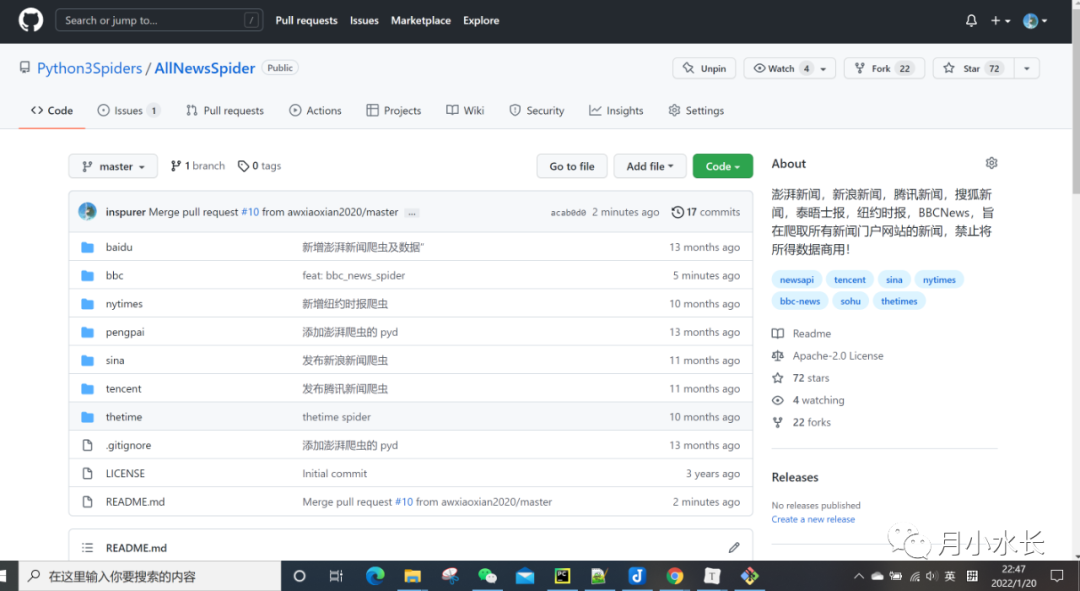

https://github.com/Python3Spiders/AllNewsSpider

restart

https://github.com/Python3Spiders/AllNewsSpider/tree/master/bbc| 字段 | 说明 |

|---|---|

| title | 新闻标题 |

| link | 新闻链接 |

| summary | 新闻概述 |

| head_img | 头图 |

| publish_time | 发布时间 |

| tags | 标签 |

| content | 正文 |

single keyword

from bbc_news_spider import BBCNewsKeywordSearchsearch_worker = BBCNewsKeywordSearch()search_worker.setKeyword("mykeyword")search_worker.crawl()

batch keyword

from bbc_news_spider import BBCNewsKeywordSearchsearch_worker = BBCNewsKeywordSearch()keywords = ['mykeword1', 'mykeyword2', 'mykeyword3']search_worker.setKeywordListandRun(keywords)

todo

评论