斯坦福新书《决策算法》发布,全文400多页PDF免费下载!

最近,斯坦福大学发布了一部新书:《决策算法》( Algorithms for Decision Making),该书主要由Mykel J.Kochenderfer教授编撰。

Mykel J.Kochenderfer教授带领的斯坦福智能系统实验室(SISL)实验室,每年在计算机领域各大顶级会议和期刊上收获颇丰,仅在2021年这一个月里,实验室已经有9篇论文于AAAI2021,AAMAS2021,AIAA Journal等顶级会议和期刊上发表。

在这里简单介绍下,斯坦福智能系统实验室(SISL)的研究主要是关于用于设计鲁棒决策系统的先进算法和分析方法。

其中,实验室特别感兴趣的细分领域有:系统的空中交通管制,无人驾驶飞机和其他需要在不确定动态环境下,在保持安全和效率的同时,需要做决策的航空航天应用。

SISL主要集中在对高效的计算方法的研究上,重点关注如何从高维、概率的问题中推导出最优的策略决策。

图:SISL成员合照

图:SISL成员合照

这本新书《决策算法》主要介绍了在不确定情况下的最优决策算法:

该书涵盖了与决策相关的各种主题,介绍了问题中隐含的数学公式以及解决它们的算法。此外,本书中添加了许多举例和练习题,来传达各种方法下蕴含的直觉。

此书是为高年级本科生和研究生以及专业人员准备的。要学习这本书的内容,阅读者需要有一定的数学功底,并接触过多变量微积分,线性代数,和概率的概念。

这本教科书的基础是算法,并都用Julia编程语言实现。除此之外,附录中还提供了一些复习材料。

从这本书受益最大的学科有数学、统计学、计算机科学、航空航天、电气工程和运筹学。

先对本书的部分章节进行详解:

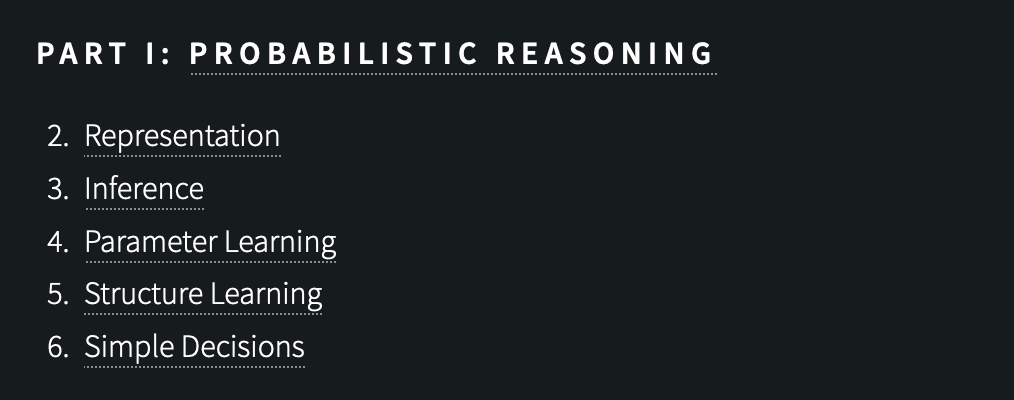

第一章:概率推理

主要讲述了概率推理(Probabilistic Reasoning),主要包括以下小节:

表示(Representation) 推理(Inference) 参数学习(Parameter Learning) 结构学习(Structure Learning) 简单决策(Simple Decisions)

从讨论如何用概率分布表示不确定性开始,作者将讨论如何构建模型,如何使用模型进行推断,以及如何从数据中学习模型的参数和结构。

之后,作者介绍了效用理论的基础,并展示了它是如何在不确定性下形成理性决策的。效用理论可以被纳入概率图形模型,形成所谓的决策网络。该章节将重点放在单步决策上,对连续决策问题的讨论将留到本书的下一部分。

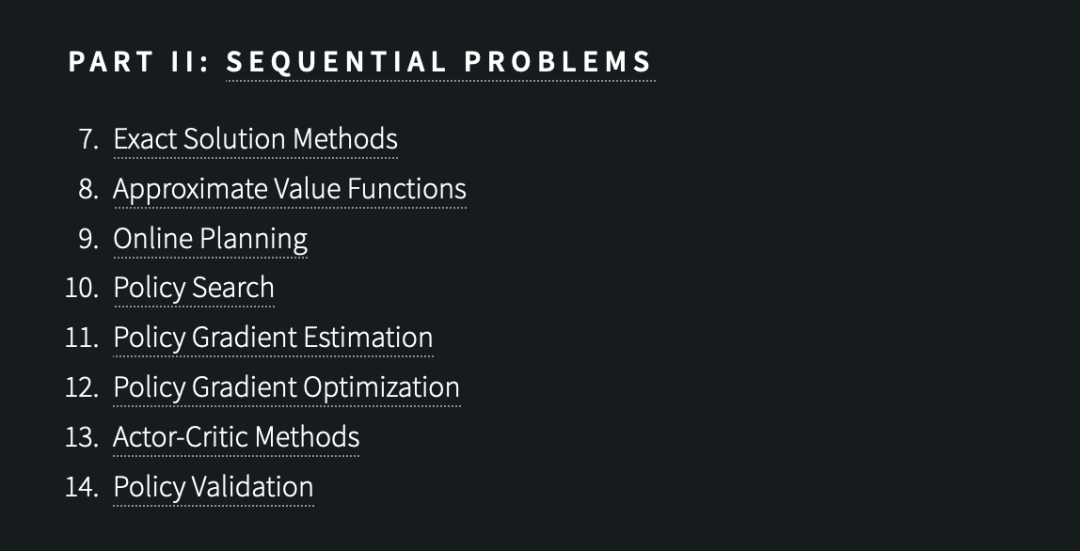

第二章:序列问题

书的第二章主要讲述了序列问题(Seqential Problems),主要包括以下小节:

确切解决方法(Exact Solution Methods) 近似值函数(Approximate Value Functions) 在线规划(Online Planning) 策略搜索(Policy Search) 策略梯度估计(Policy Gradient Estimation) 策略梯度优化(Policy Gradient Optimization) Actor-Critic算法(Actor-Critic Methods) 策略验证(Policy Validation)

此前的章节都假设在某个时刻所需要做的是单一的决定,但许多重要的问题需要我们做出一系列的决定。

在此情况下,最大期望效用原则仍然适用,但是在序列环境下的最优决策需要对未来的序列操作和观察进行推理。

这本书的这一章节将讨论随机环境中的顺序决策问题。作者将在模型已知和环境完全可观察的假设下,关注顺序决策问题的一般公式。在之后的章节中,作者将会放松这两个假设。

本章的讨论将从引入序列决策问题的标准数学模型——马尔可夫决策过程开始,主要讨论了几种求精确解的方法、离线和在线近似解决方法的集合,以及一种涉及直接搜索参数化决策策略空间的方法。

第三章:模型不确定性

主要讲述了模型不确定性(Model Uncertainty),主要包括以下小节:

探索和利用(Exploration and Exploitation) 基于模型的方法(Model-Based Methods) 脱离模型的方法(Model-Free Methods) 模仿学习(Imitation Learning)

在讨论顺序决策问题时,本书假设转移模型和报酬模型是已知的。然而,在许多问题中,这些模型并不是完全已知的,而且代理必须通过经验学会进一步的操作。

通过观察状态转换奖励形式的行为结果,代理选择能够最大化其长期奖励积累的行为,解决这种存在模型不确定性的问题是强化学习领域的主题,也是本书这一部分的重点。

在该章中,作者讨论了解决模型不确定性的几个挑战:

首先,代理必须谨慎地掌握探索环境和利用基于经验的知识的平衡。

第二,奖励可能是在重要决定做出很久之后才得到的,所以较晚的奖励必须分配给较早的决定。

第三,代理必须从有限的经验中进行概括。对此,作者回顾了解决这些挑战的理论和一些关键的算法。

第四章:状态不确定性

主要讲述了状态不确定性(State Uncertainty),主要包括以下小节:

信念(Beliefs) 确切信念状态规划(Exact Belif State Planning) 离线信念状态规划(Offline Belief State Planning) 在线信念状态规划(Online Belif State Planning) 控制器抽象(Controller Abstractions)

前几章包括了过渡函数中的不确定性,包括结果状态和模型中的不确定性。在本章中,作者将不确定性扩展到状态领域。

第19章展示了如何根据过去的观察和行动序列更新信念的分布。第20章概述了优化策略的精确方法。

第21章回顾了各种离线逼近方法,它们在处理更大的问题时比精确的方法有更好的伸缩性。

第22章扩展了在线近似方法以适应部分可观测性。

第23章介绍了有限状态控制器,来表示优化策略和方法。

第五章:多代理系统

主要讲述了多代理系统(Multiagent Systems),主要包括以下小节:

多代理推理(Multiagent Reasoning) 序列问题(Squential Problems) 状态不确定性(State Uncertainty) 协作代理(Collaborative Agents)

到目前为止,本书主要是从单个代理的角度来进行决策。现在,讨论的核心概念将会扩展到涉及多个代理的问题。

在多代理系统中,我们可以将其他代理模拟为潜在的盟友或对手,并随着时间的推移相应地进行调整。

第24章介绍了博弈中的多代理推理,并概述了如何从简单的交互作用中计算均衡。

第25章讨论了如何为随着时间的推移而交互的多个主体设计算法,描述了偏向于理性适应而非均衡收敛的学习算法。

第26章表明,状态不确定性显著增加了问题的复杂性,并强调了这些领域的独有的挑战和困难。

第27章重点介绍了协作代理的各种模型和算法。

以上就是全书大概的介绍啦,感兴趣的小伙伴可以下载全书哦

获取的方式很简单,直接扫描下方公众号回复关键字「决策算法」,即可获取!

长按下面的二维码,关注公众号“后端面试那些事”

回复 “决策算法” 四字自行领取吧

往期推荐