AAAI 2021最佳论文Informer:效果远超Transformer的长序列预测神器!

新智元推荐

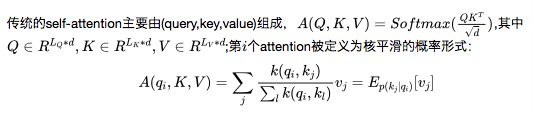

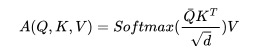

ProbSparse Self-Attention,在时间复杂度和内存使用率上达到了,在序列的依赖对齐上具有相当的性能。

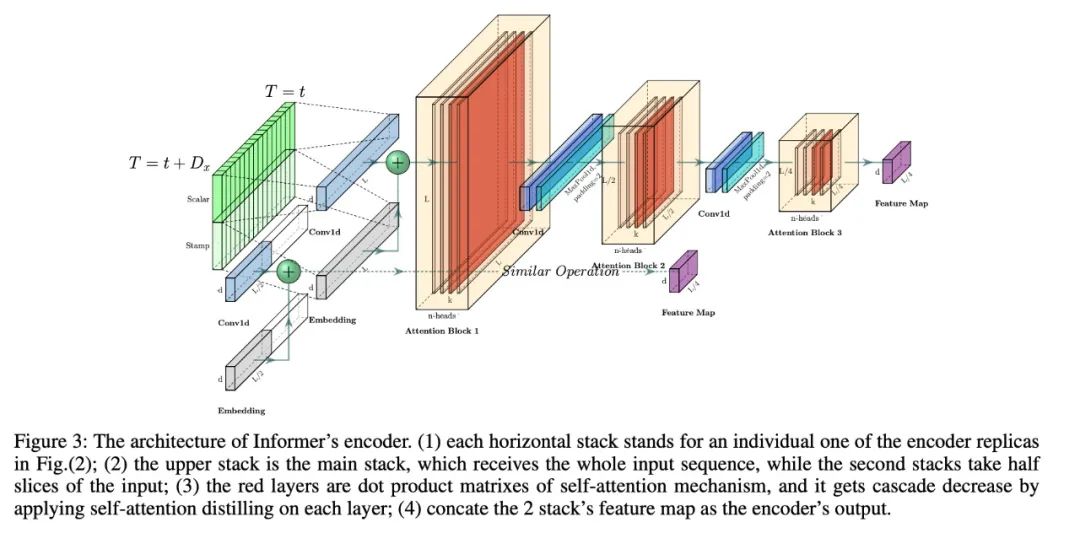

self-attention 提取通过将级联层输入减半来突出控制注意,并有效地处理超长的输入序列。

产生式decoder虽然概念上简单,但在一个正向操作中预测长时间序列,而不是一步一步地进行,这大大提高了长序列预测的推理速度。

Intuition:Transformer是否可以提高计算、内存和架构效率,以及保持更高的预测能力?

self-attention的二次计算复杂度,self-attention机制的操作,会导致我们模型的时间复杂度为;

长输入的stacking层的内存瓶颈:J个encoder/decoder的stack会导致内存的使用为;

预测长输出的速度骤降:动态的decoding会导致step-by-step的inference非常慢。

提出Informer来成功地提高LSTF问题的预测能力,这验证了类Transformer模型的潜在价值,以捕捉长序列时间序列输出和输入之间的单个的长期依赖性;

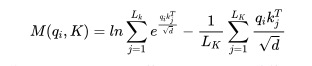

提出了ProbSparse self-attention机制来高效的替换常规的self-attention并且获得了的时间复杂度以及的内存使用率;

提出了self-attention distilling操作全县,它大幅降低了所需的总空间复杂度;

提出了生成式的Decoder来获取长序列的输出,这只需要一步,避免了在inference阶段的累计误差传播;

Encoder-decoder框架:许多流行的模型被设计对输入表示进行编码,将编码为一个隐藏状态表示并且将输出的表示解码.在推理的过程中设计到step-by-step的过程(dynamic decoding),decoder从前一个状态计算一个新的隐藏状态以及第步的输出,然后对个序列进行预测; 输入表示:为了增强时间序列输入的全局位置上下文和局部时间上下文,给出了统一的输入表示。

ProbSparse Self-attention

Encoder: Allowing for processing longer sequential inputs under the memory usage limitation

Self-attention Distilling

2. Decoder: Generating long sequential outputs through one forward procedure

Generative Inference

Loss Function

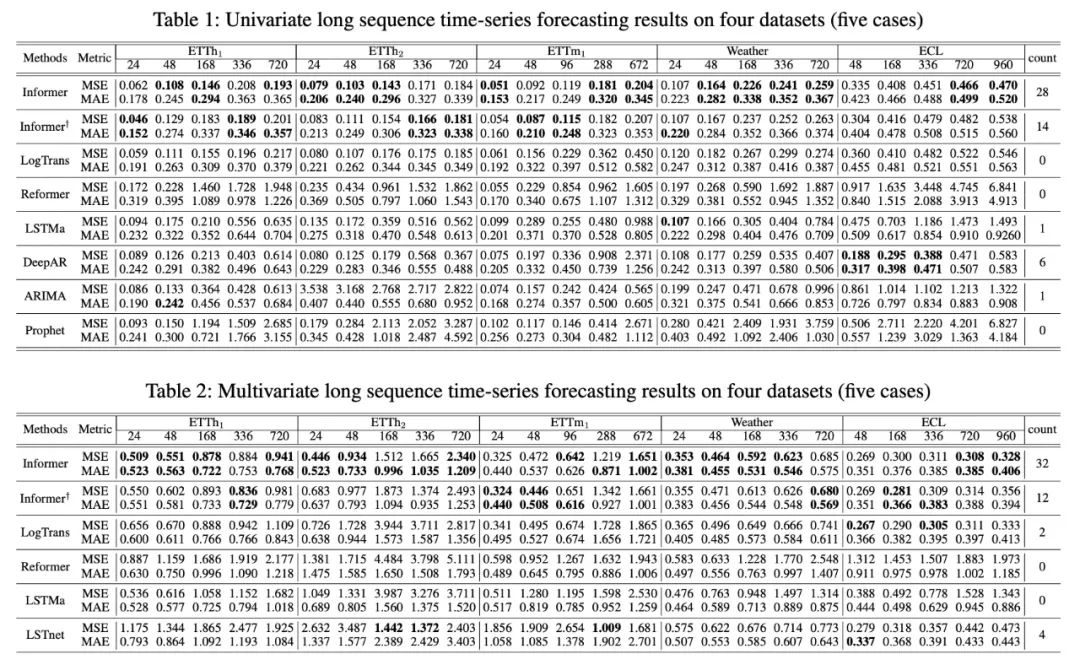

1. 实验效果

所提出的模型Informer极大地提高了所有数据集的推理效果(最后一列的获胜计数),并且在不断增长的预测范围内,它们的预测误差平稳而缓慢地上升。

query sparsity假设在很多数据集上是成立的;

Informer在很多数据集上远好于LSTM和ERNN

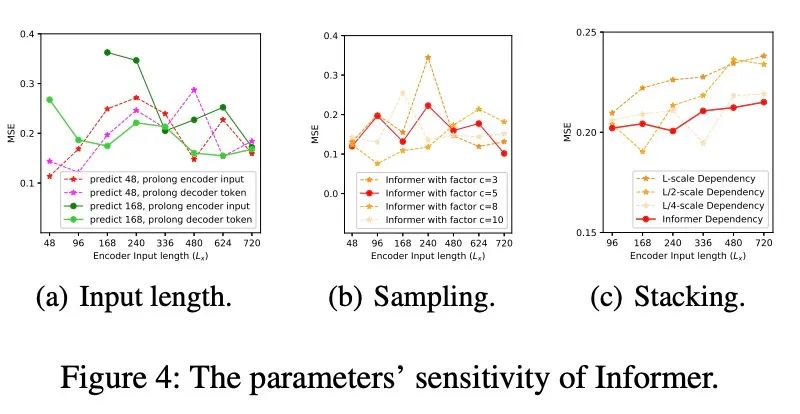

2. 参数敏感性

Input Length:当预测短序列(如48)时,最初增加编码器/解码器的输入长度会降低性能,但进一步增加会导致MSE下降,因为它会带来重复的短期模式。然而,在预测中,输入时间越长,平均误差越低:信息者的参数敏感性。长序列(如168)。因为较长的编码器输入可能包含更多的依赖项;

Sampling Factor:我们验证了冗余点积的查询稀疏性假设;实践中,我们把sample factor设置为5即可,即

Number of Layer Stacking:Longer stack对输入更敏感,部分原因是接收到的长期信息较多

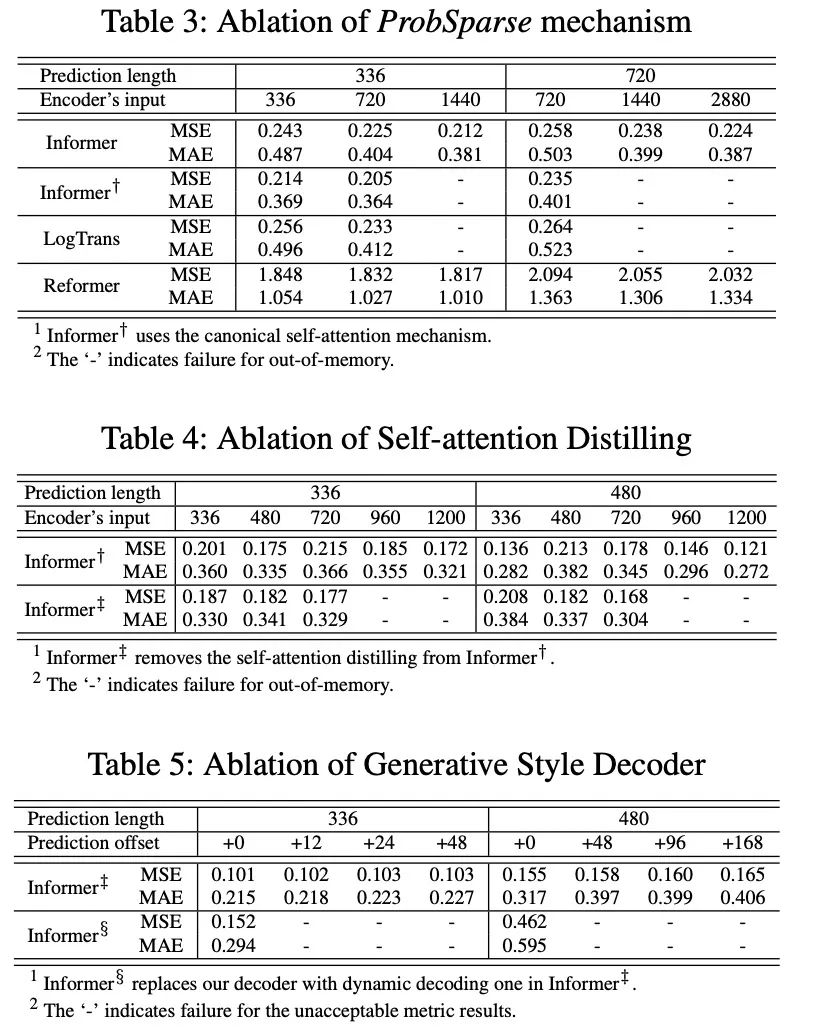

3. 解耦实验

ProbSparse self-attention机制的效果:ProbSparse self-attention的效果更好,而且可以节省很多内存消耗; self-attention distilling:是值得使用的,尤其是对长序列进行预测的时候; generative stype decoderL:它证明了decoder能够捕获任意输出之间的长依赖关系,避免了误差的积累;

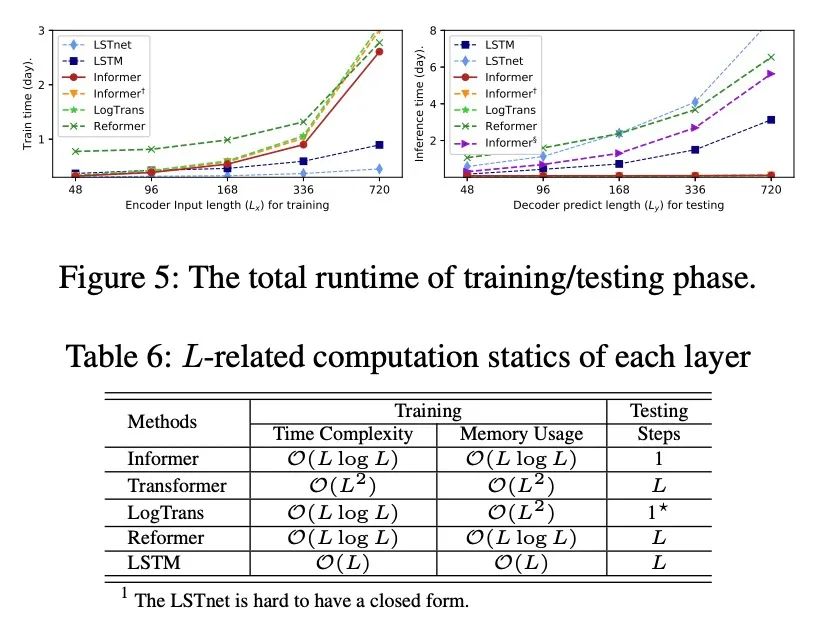

4. 计算高效性

在训练阶段,在基于Transformer的方法中,Informer获得了最佳的训练效率。 在测试阶段,我们的方法比其他生成式decoder方法要快得多。

设计了ProbSparse self-attention和提取操作来处理vanilla Transformer中二次时间复杂度和二次内存使用的挑战。 generative decoder缓解了传统编解码结构的局限性。 通过对真实数据的实验,验证了Informer对提高预测能力的有效性

Informer: Beyond Efficient Transformer for Long Sequence Time-Series Forecasting:https://arxiv.org/pdf/2012.07436.pdf