本文约2300字,建议阅读6分钟

本文为你介绍构建GNN模型的“四步”框架。

近年来,由于图的强大表达能力,利用机器学习分析图的研究越来越受到关注。图(graph)作为一种数据结构,由节点(node)和边(edge)组成,如果赋予节点和边不同的含义,那么看似简单的图就可以组成非常庞大的信息。例如,若图中的节点代表商品,边表示购买顺序,那么连起来就代表了一个用户的购物网络。

图 | 一个最简单的图包含节点和边(箭头表示关系方向)

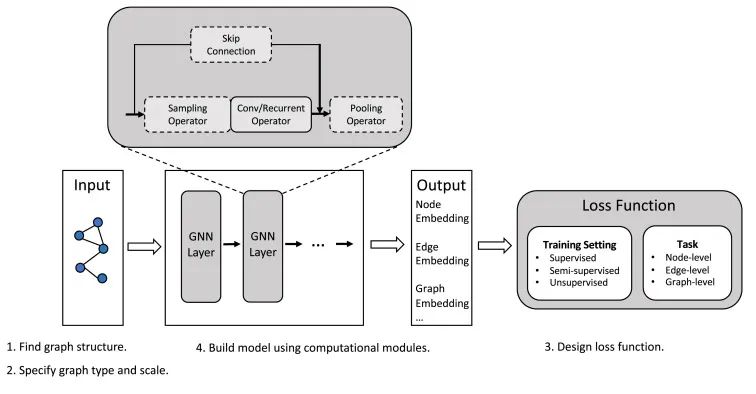

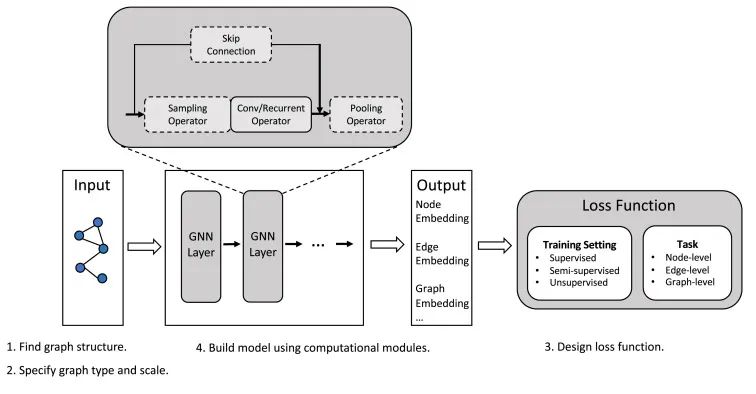

如今,在图领域机器学习中,图神经网络(Graph Neural Network,简称 GNN)又成为新的研究热点。由于 GNN 对图节点之间依赖关系进行建模的强大能力,它在社交网络、知识图、推荐系统甚至生命科学等各个领域都得到了越来越广泛的应用。近日,清华大学研究团队就针对 GNN 的最新发展,于 AI OPEN 发表了题为 “Graph neural networks: A review of methods and applications” 的研究综述。文中详细总结了构建 GNN 模型的 “四步” 框架并作理论分析,展示了 GNN 在各学科中常见的应用,并最后提出四个开放性问题,表明了图神经网络的主要挑战和未来研究方向。GNN 是基于图的深度学习方法,作为神经模型的一种,它通过图节点之间的消息传递来捕获图的依赖性。GNN 的设计流程通常包含四个步骤:找出相应的图结构、指定图类型与规模、设计损失函数、使用计算模块构建模型。

图 | GNN 的设计流程图(来源:论文)

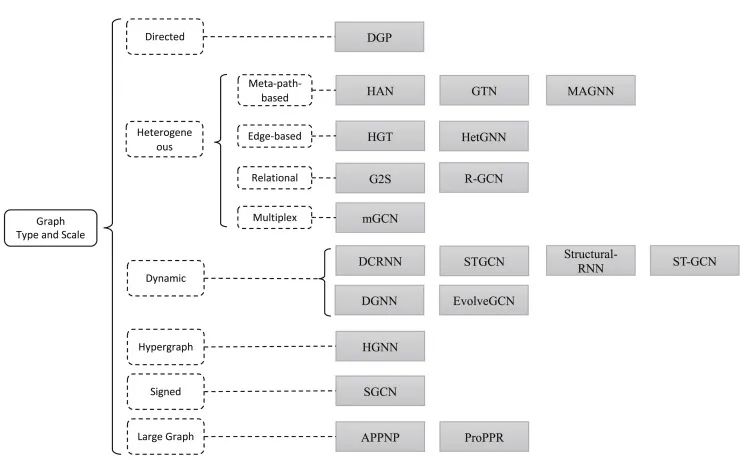

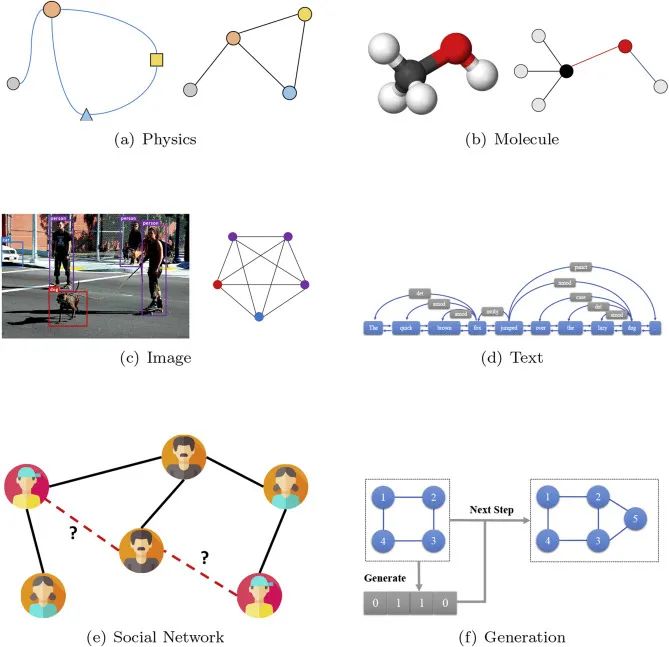

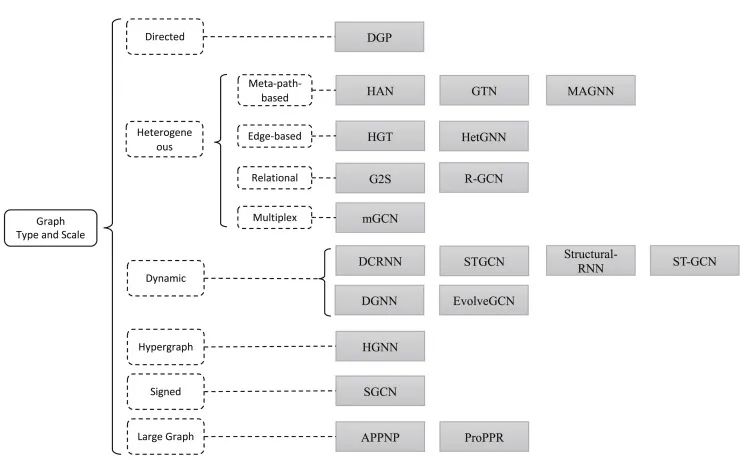

在此次的研究中,作者就详细描述这四个步骤的操作框架。(1)找到与目标相适应的图结构:通常可以分为结构化场景和非结构化场景。在结构化场景中,图结构在应用中比较明确,例如在分子、物理系统、知识图等上的应用。而在非结构化场景中,图是隐含的,因此首先要从任务中构建图,例如为文本构建一个完全连接的 “词” 图或为图像构建一个场景图。(2)指定图类型和规模:在获得图形后,需要找出图形类型及其规模。图通常分为有向 / 无向图、同构 / 异构图(同构图中的节点和边具有相同的类型,而异构图中的节点和边具有不同的类型)、静态 / 动态图(当输入特征或图的拓扑随时间变化时,该图被视为动态图)。

图 | 图类型与规模及其详细分类(来源:论文)

(3)设计损失函数:对于图学习任务,通常有节点级任务、边级任务、图级任务三种。而从训练设置的角度来看,图学习任务分为监督设置(为训练提供标记数据)、半监督设置(给出少量标记节点和大量未标记节点用于训练)、以及无监督设置(仅提供未标记的数据)。(4)使用计算模块构建模型:常用的计算模块有传播模块、采样模块、池化模块。传播模块用于在节点之间传播信息,以便聚合信息可以捕获特征和拓扑信息。当图很大时,通常需要采样模块对图进行传播。如果需要高级子图或图的表示,则需要池化模块从节点中提取信息。

图 | 三种计算模块及其详细操作(来源:论文)

接下来,作者们还对当前 GNN 的热点应用一一进行阐释,并根据结构化场景和非结构化场景对其进行分类。结构化场景 GNN 应用包括:图挖掘(如图匹配、图分类、图聚类)、物理(即模拟现实世界的物理系统,如电磁系统、机器人系统等)、化学和生物学(如分子指纹、化学反应预测、生物工程等)、知识图谱(knowledge graph,表示现实世界实体的集合以及实体对之间的关系事实,例如问答、信息检索和知识引导生成)、生成模型、组合优化、交通网络(例如预测交通状态)、推荐系统(如社交网络自动推荐功能)、其他应用(如预测股票未来趋势、预测市场指数走势、优化路由性能、在文本生成任务的抽象含义表示等)。非结构化场景 GNN 应用则主要包括图像和文本上的任务,如机器视觉推理、语义分割、文本分类、神经机器翻译、关系抽取、事件验证、阅读理解等等。图 | GNN 应用场景(来源:论文)

尽管 GNN 在不同领域取得了巨大成功,但值得注意的是,GNN 模型还不足以为大多图任务提供令人满意的解决方案。于是,研究人员通过综述已有研究,总结了以下四个未解决的问题:稳健性:作为一种基于神经网络的模型,GNN 也很容易受到对抗性攻击。而且与仅关注特征的对图像或文本的对抗性攻击相比,对图的攻击进一步考虑了结构信息。可解释性:可解释性也是神经模型的一个重要研究方向,不过目前 GNN 如同黑箱,仍缺乏解释。因此,将 GNN 模型应用于具有可解释性的实际应用非常重要。图预训练:基于神经网络的模型需要大量的标记数据,但是获得大量人工标记的数据成本很高。因此,用自监督方法来指导 GNN 模型从未标记数据中学习从而进行预训练无疑是一种创新,但该领域仍有许多开放性问题需要研究、。复杂的图结构:图结构在现实生活的应用中灵活又复杂,而且随着互联网上社交网络的快速发展,肯定会出现更多的问题、挑战和应用场景,需要更强大的模型。AI OPEN 于 2020 年 3 月创刊,专注于分享有关人工智能(AI)理论及其应用的可行知识和前瞻性观点。期刊主编为智源研究院学术副院长、清华大学计算机系唐杰教授。网址:

https://www.sciencedirect.com/journal/ai-open

论文链接:

https://www.sciencedirect.com/science/article/pii/S2666651021000012#!

The release of ELMo, BERT and GPT in 2018 indicated the success of pre-trained language models (PLMs), and was followed by a great breakthrough in natural language understanding and generation. Many works have been done to explore more efficient and effective architectures for pre-training; for example, methods to improve pre-trained language models with cross-modal data, cross-lingual data, and structured knowledge, etc., or to innovatively apply PLMs in various NLP-related tasks.This special issue is devoted to gathering and presenting cutting-edge reviews, research and applications of PLMs, providing a platform for researchers to share their recent observations and achievements in this active field.Novel architectures and algorithms of PLMs* Fine-tuning and adaptation of PLMs* Multi-tasking and continual learning of PLMs* Cross-lingual or multi-lingual PLMs* Knowledge distillation and model compression of PLMs* Analysis and probing of PLMs* Applications of PLMs in various areas, such as information retrieval, social computation, and recommendation* Submission deadline: 31 August 2021Papers submitted to this journal for possible publication must be original and must not be under consideration for publication in any other journals. Extended work must have a significant number of "new and original" ideas/contributions along with more than 30% "brand new" material.Please read the Guide for Authors (http://www.keaipublishing.com/en/journals/ai-open/guide-for-authors/) before submitting. All articles should be submitted online (https://www.editorialmanager.com/aiopen/default.aspx); please select SI: Pre-Trained Language Models on submission.* Dr. Zhiyuan Liu, Tsinghua University, China. Email: liuzy@tsinghua.edu.cn

* Dr. Xipeng Qiu, Fudan University, China. Email: xpqiu@fudan.edu.cn

* Dr. Jie Tang, Tsinghua University, China. Email: jietang@tsinghua.edu.cn