图灵奖得主Yann LeCun的六十年

极市导读

本文介绍了Yann LeCun——纽约大学终身教授、纽约大学数据科学中心的创始人、Facebook人工智能研究院首席科学家,以及2018年图灵奖的得主,他的精彩人生60年。 >>加入极市CV技术交流群,走在计算机视觉的最前沿

1 从“2001太空漫游”到单板机

2 两本启蒙书

3 与Hinton、Bengio相遇

4 LeNet的诞生

图注:32年前Yann LeCun当初演示用CNN识别数字的视频,视频中,参与这项实验的研究人员还有实验室负责人Rich Howard,和计算机专家Donnie Henderson。

图注:32年前Yann LeCun当初演示用CNN识别数字的视频,视频中,参与这项实验的研究人员还有实验室负责人Rich Howard,和计算机专家Donnie Henderson。

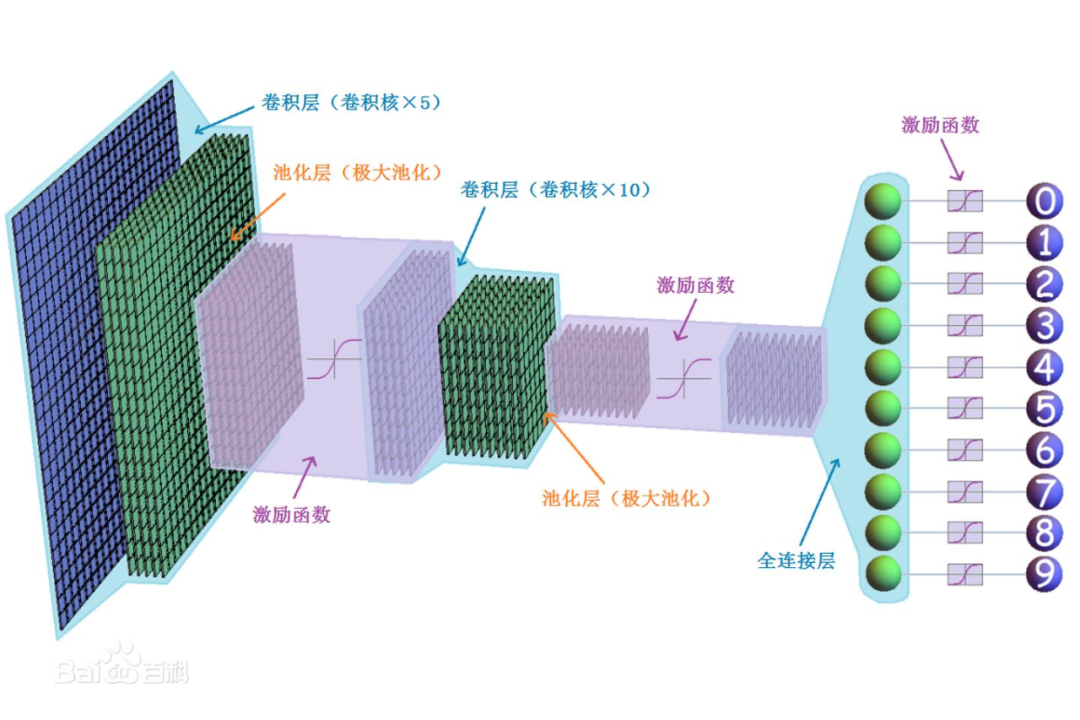

图注:Lenet-5 在线识别手写数字

图注:Lenet-5 在线识别手写数字

而最近一年多来Transformer模型的出现以及在视觉模型上的成功应用似乎对CNN的垄断地位构成了严峻的挑战,至于是哪个模型能笑到最后,还需更多的时间来检验。

而最近一年多来Transformer模型的出现以及在视觉模型上的成功应用似乎对CNN的垄断地位构成了严峻的挑战,至于是哪个模型能笑到最后,还需更多的时间来检验。5 产学两栖

6 学术之道&人生之道

我认为,一旦突破了那堵砖墙,我们将在AI系统功能开发上取得重大进步。但事实是,它后面可能会还有一堵砖墙。我们现在不知道,是因为它隐藏起来了。因此,我们不知道要达到老鼠级别的智能、猫级别的智能、人类级别的智能,还需要经过多少堵砖墙。我们甚至不知道要花多长时间才能突破第一堵墙。

我的秘诀是钻到一群比我聪明的人里面去,所以在很多方面我都根本没觉得自己有什么天赋。反倒是,我经常为别人感到惊叹。比如我和 Léon Bottou 有过很长时间的联系和合作,在机器学习界他是一个知名人物,而且几乎每个方面他都比我强! 我喜欢做的事,就是一直向下挖掘,去发现一个疑问背后真正的问题是什么。「如何才能让机器学习」,类似这种。有点像是考虑大方向、考虑哪些是真正重要的问题。把问题简化、再简化,直到达到真正的核心问题。 有时候一个想法或者一个概念显得很复杂,因为其中用到了很多很麻烦的数学知识,但是它真正的核心往往就是一个很简单的想法。我觉得我还没法和 Richard Feynman 相提并论,但是这种思考方式真的和他的很像。就是要问最基本的问题、摒弃一切表面上的东西,直到得到一个简单得不可思议的问题。不过我做得还没有他那么好。 当然,也有些人觉得自己成功的秘诀在于专注,比如Yoshua Bengio,Yoshua 是非常自律的、井井有条的人。我不是那样的人,我活得乱糟糟的。

推荐阅读

评论