「撩妹神器」不灵了!OpenAI重磅发布官方「ChatGPT检测器」

新智元报道

新智元报道

【新智元导读】终于,AI检测器总算是被OpenAI给憋出来了。

左右互搏:OpenAI发布ChatGPT检测器

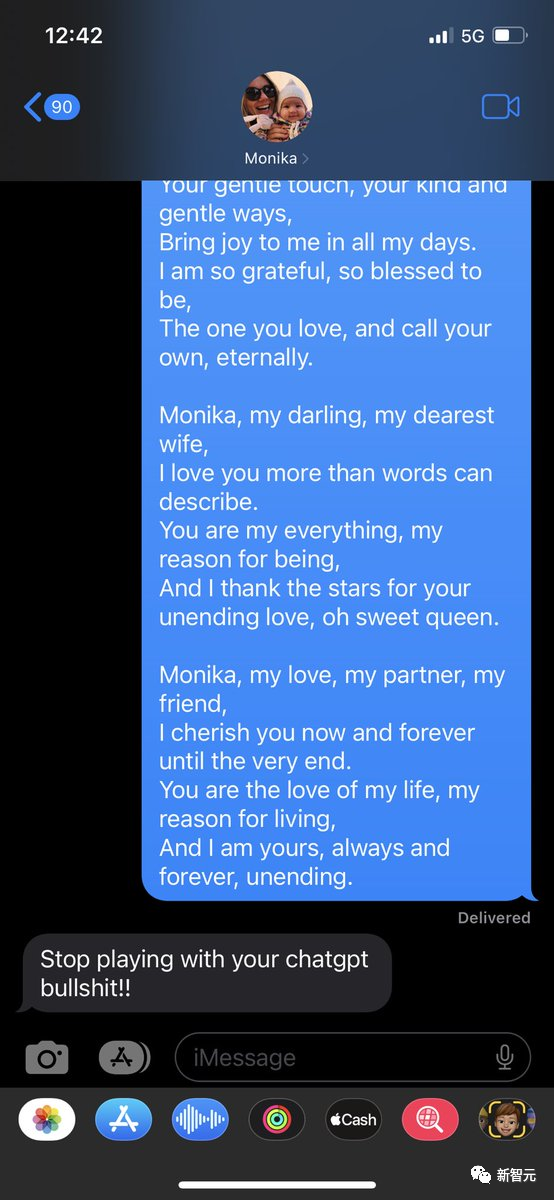

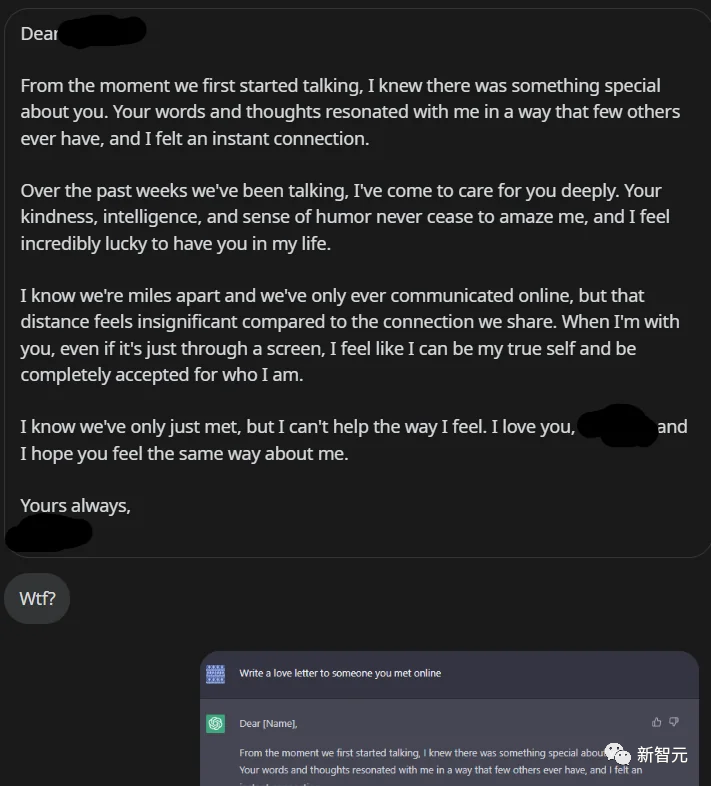

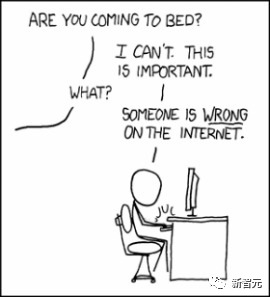

「撩妹神器」还灵不?

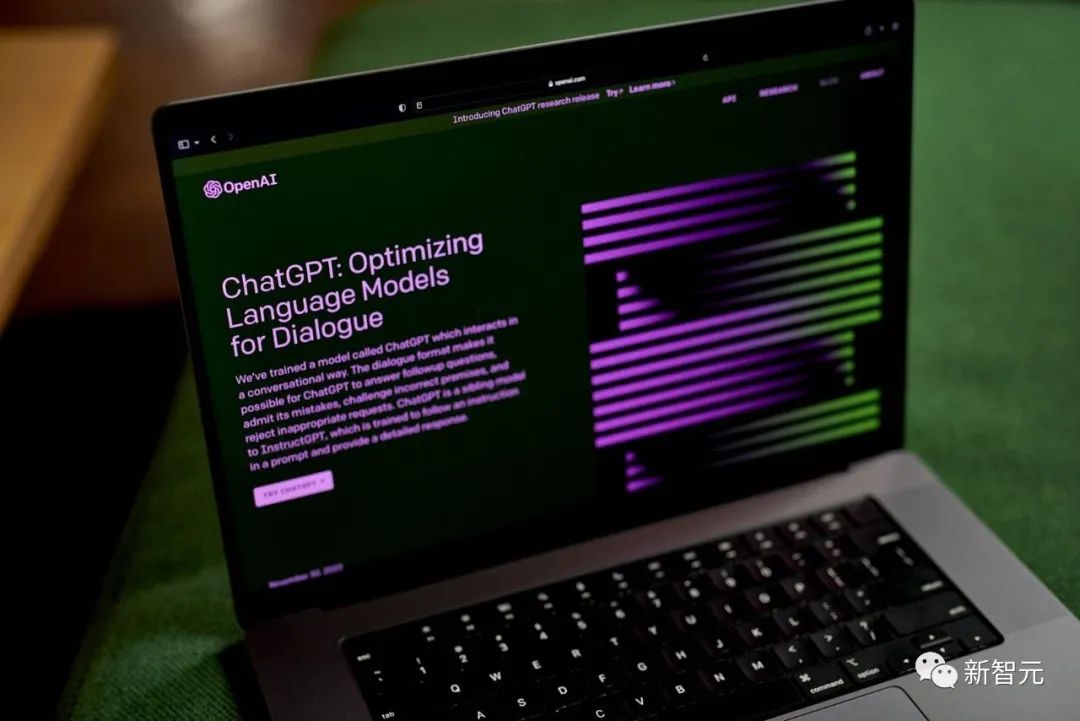

毫无疑问,ChatGPT正在全世界掀起一股飓风。

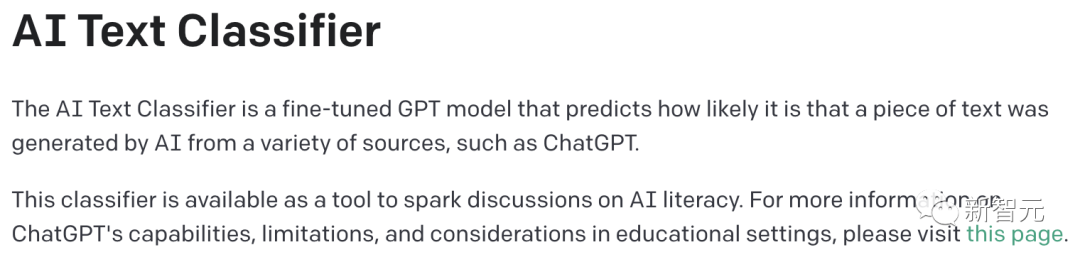

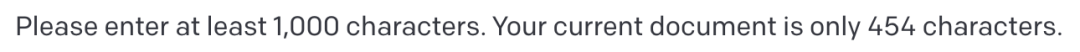

分类器并不总是准确的,它可能会错误地标记AI生成的和人类写的文本,并且语气很自信 建议仅对英文文本使用分类器。它在其他语言上的表现要差得多,并且在代码上不可靠 它无法可靠地识别非常可预测的文本。例如,无法预测前1000个素数的列表是由AI还是人类写的,因为正确答案总是相同的 AI生成的文本,经过编辑之后很可能会规避掉分类器的检测 如果输入与训练集中的文本有很大的区别,分类器会做出错误判断

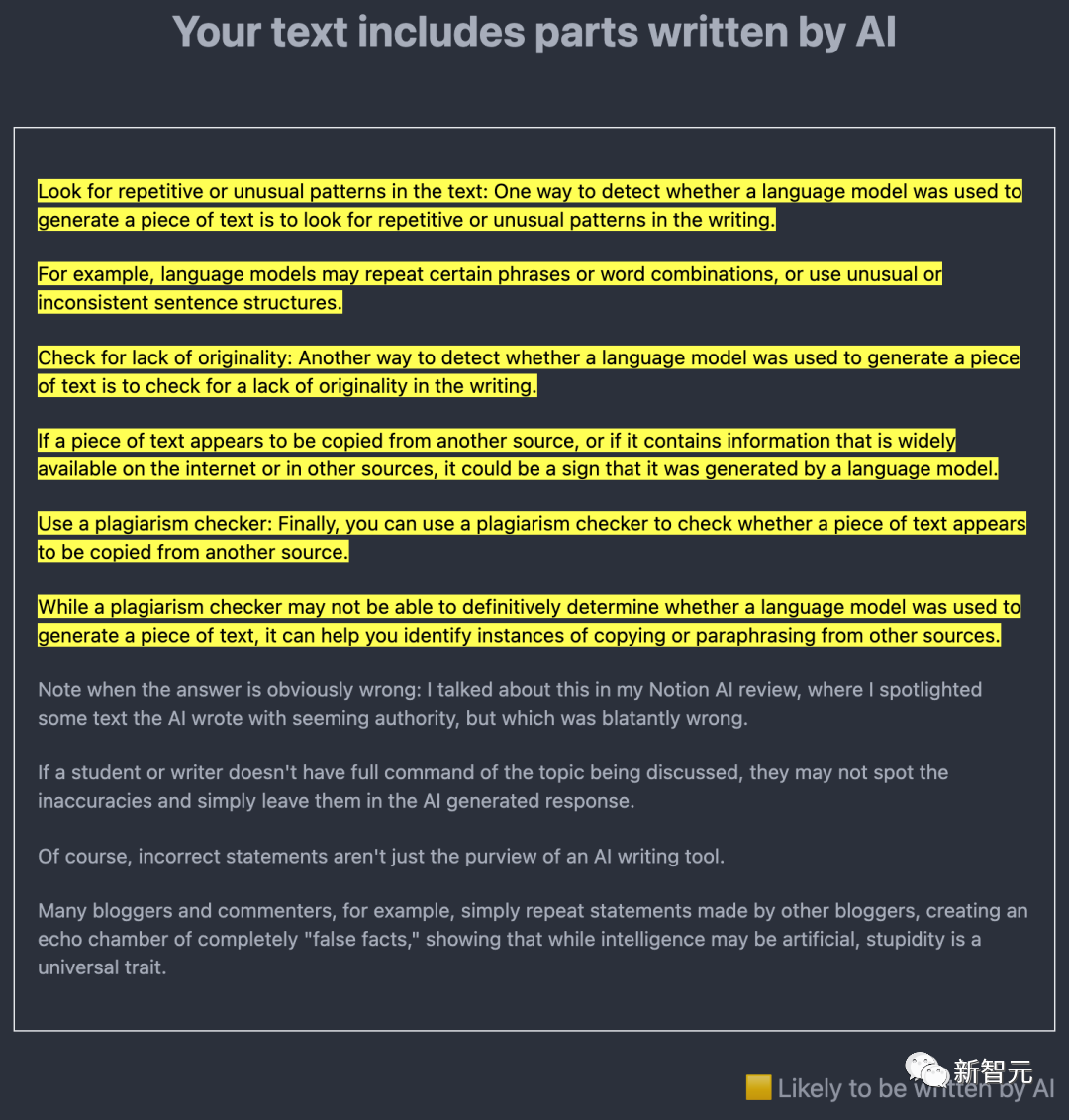

结果的划分超细

「非常不可能是AI生成的」(Very unlikely to be AI-generated)

「不太可能是AI生成的」(Unlikely to be AI-generated)

「不清楚是否是AI写的」(Unclear if it is AI writte)

「可能是AI生成的」(Possibly AI-generated)

「很可能是AI生成的」(Likely AI-generated)

可靠性有待加强

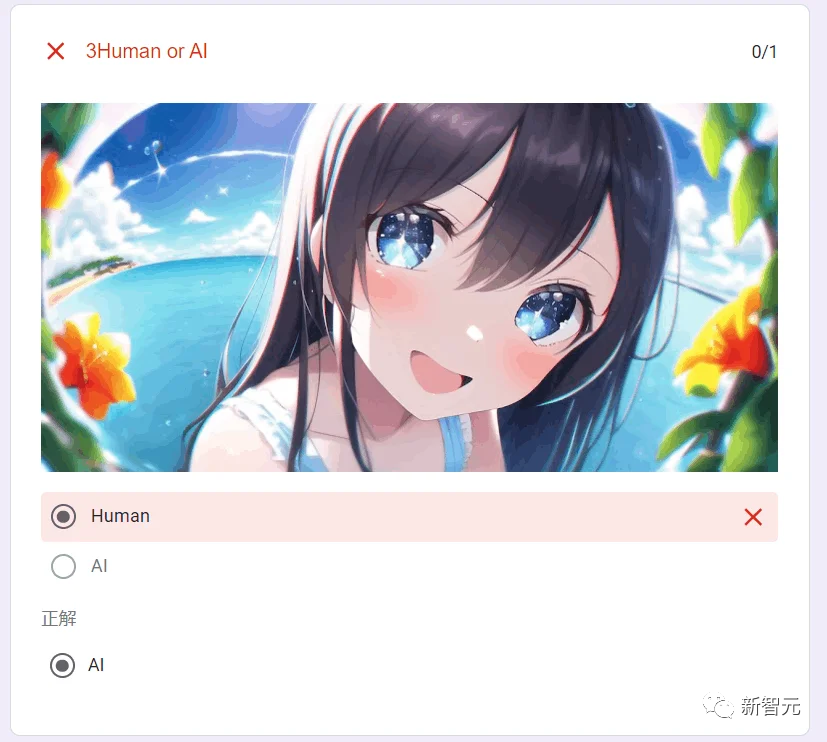

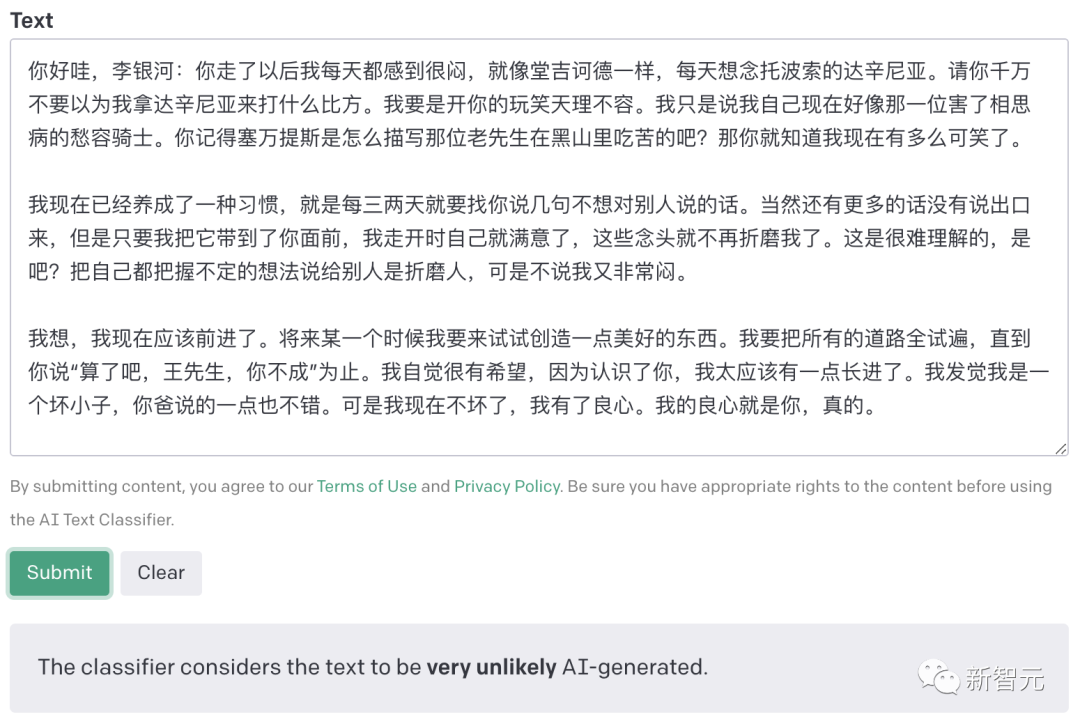

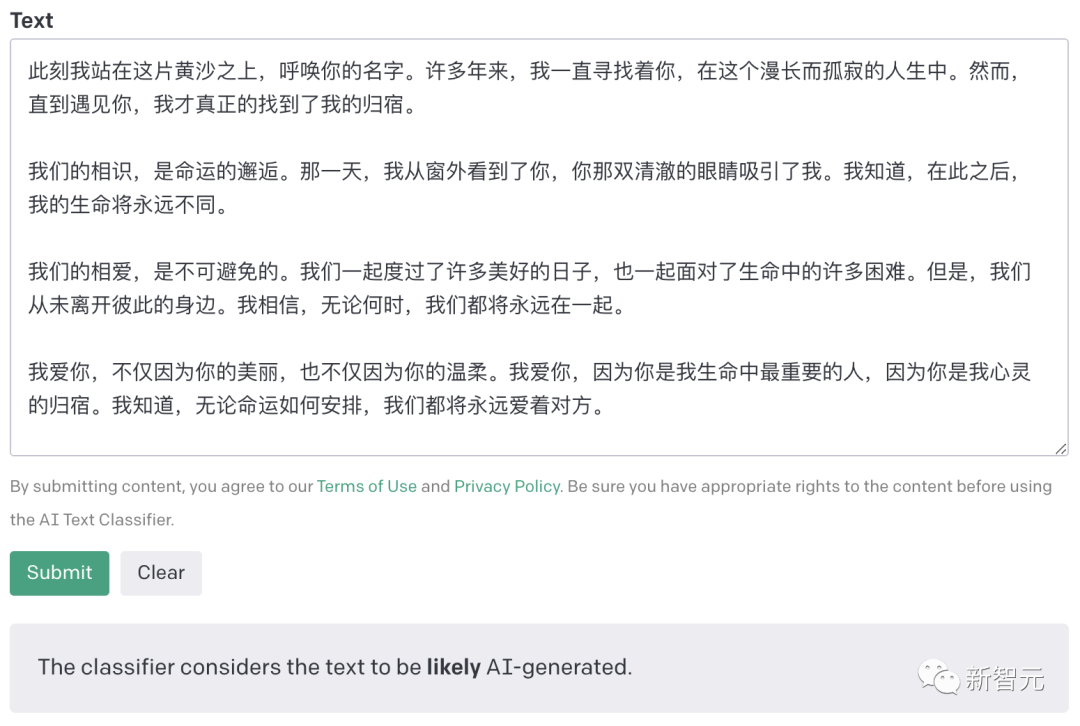

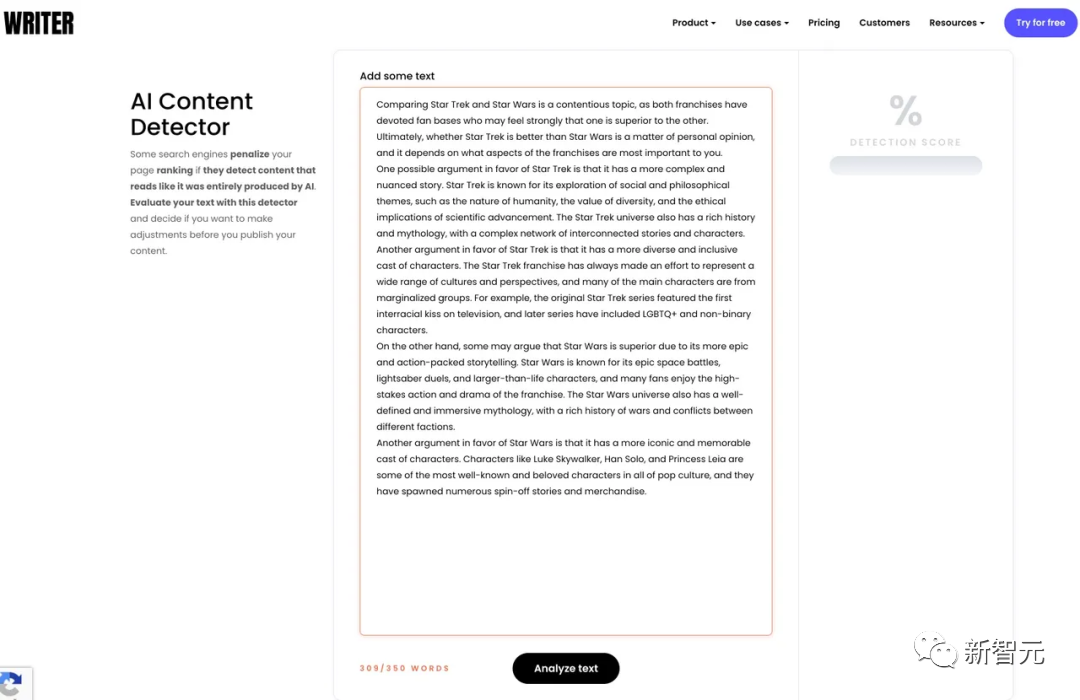

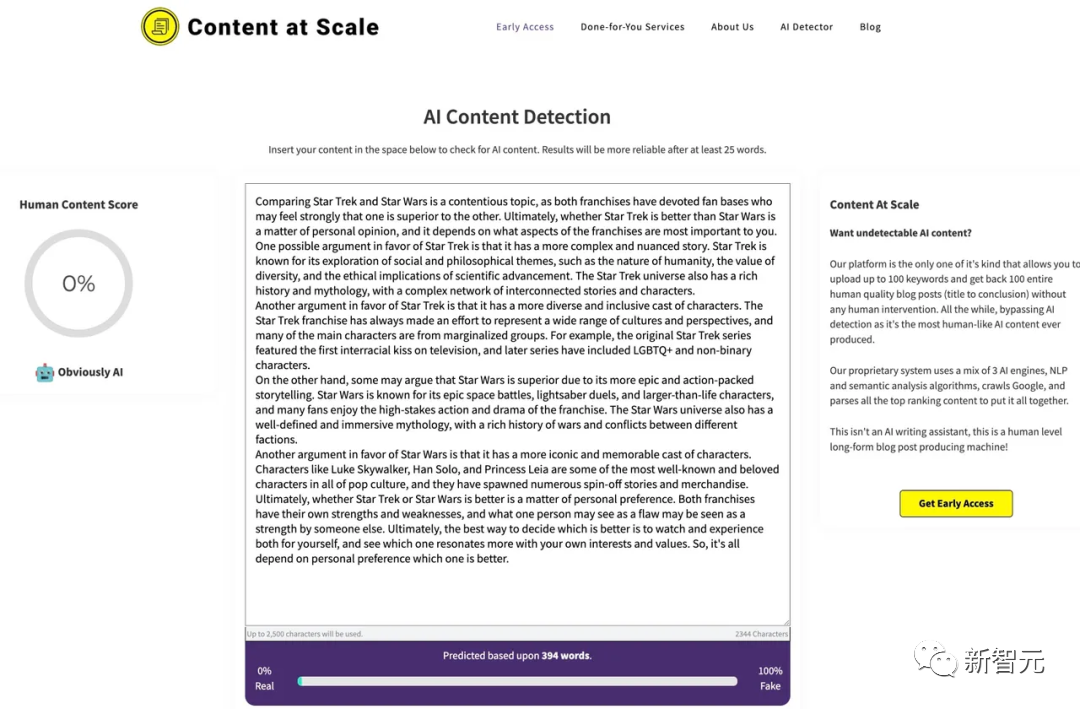

AIGC大厂自研「AI检测器」实测

测试开始!

结果评价

OpenAI此前针对GPT-2打造的检测器,时不时会被新模型生成的内容欺骗。

由那些贩卖AI生成内容的公司打造的「检测器」,基本上都不咋靠谱。

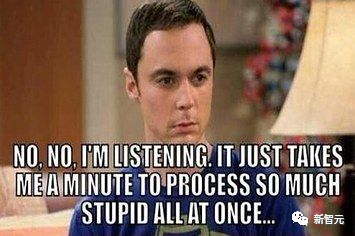

一些思考(AI也有参与lol)

评论