Kubernetes 中网站无法访问,深入排查实战

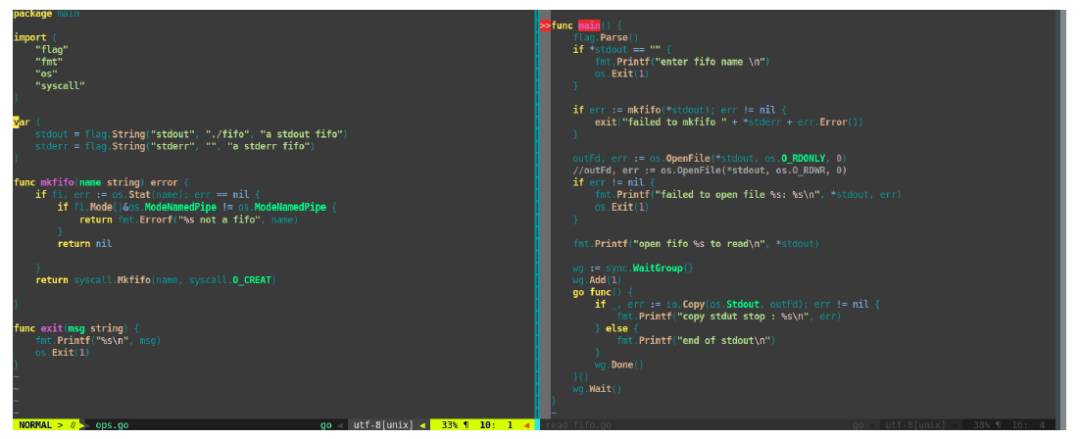

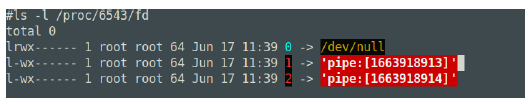

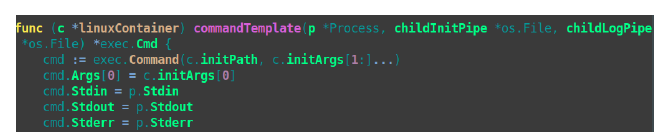

pouch run -d nigixpouch创建容器与初始化IO

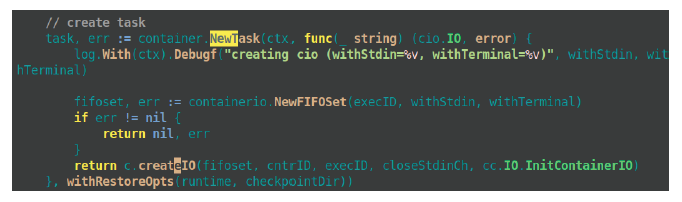

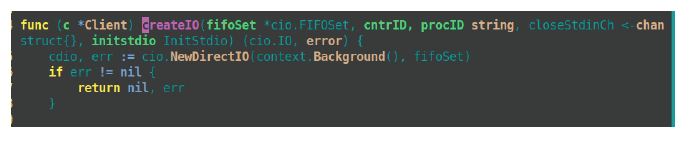

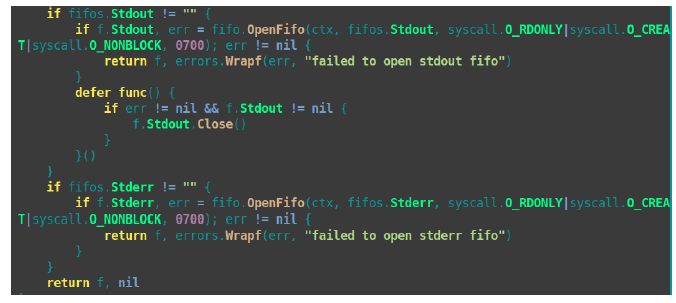

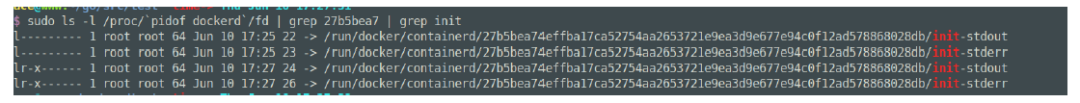

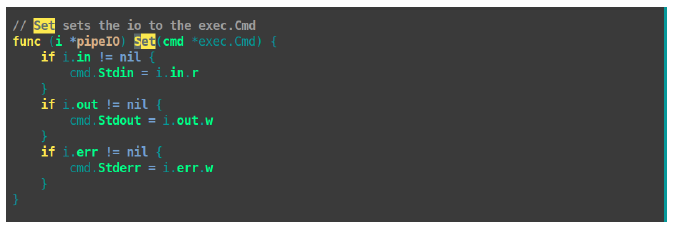

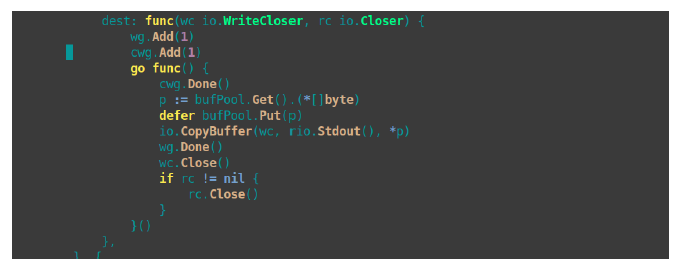

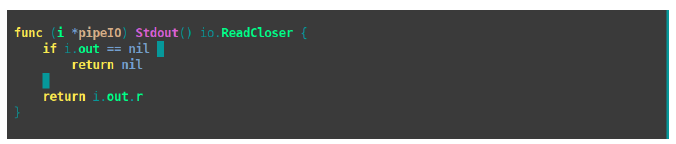

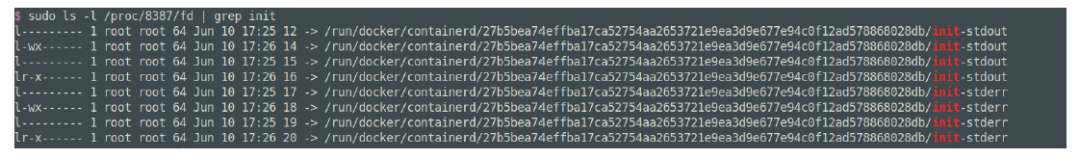

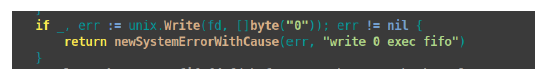

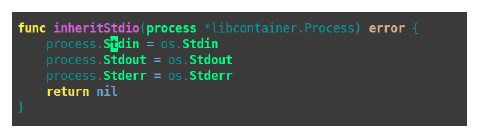

containerd创建容器与初始化IO

- END -

推荐阅读 Kubernetes实战指南:从零到架构师的进阶之路 Nginx 常用配置清单 Prometheus + Thanos 多集群架构监控 Jenkins 流水线自动化部署 Go 项目 最强整理!常用正则表达式速查手册 运维的工作边界,这次真的搞明白了! Linux 这些工具堪称神器! Prometheus + Granafa 构建高大上的MySQL监控平台 搭建一套完整的企业级 K8s 集群(v1.20,kubeadm方式) 12年资深运维老司机的成长感悟

点亮,服务器三年不宕机

评论