2021年的第一盆冷水:有人说别太把图神经网络当回事儿

日期 : 2021年01月10日

正文共 :4610字

图神经网络(GNN)是目前热门的研究方向,但我们是否应把注意力过多地放在这上面?数据科学家 Matt Ranger 从模型的本质、性能基准测试、实践应用等方面陈述了自己的观点。

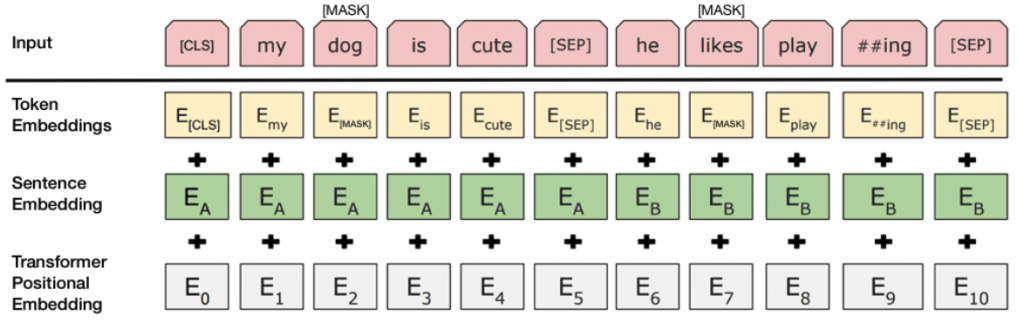

人类语言和语言建模具有无限的统计复杂度,但可以在较低层次上得到很好地近似。这一观察结果有两层含义: 我们可以使用相对较小的模型获得不错的结果; 扩大模型具备很大潜力。 语言模型解决了很大的问题空间,以至于从柯氏复杂性(Kolmogorov Complexity)角度来看,它们可能近似压缩了整个语言。庞大的语言模型可能记住了很多信息,而不是压缩信息。

使用已有的算法;

添加新的层 / 超参数,用数学形式描述其重要性;

对超参数执行网格搜索,直到该新方法打败被模仿的那个基线方法;

绝不对在「实验结果」部分中进行对比的方法执行网格搜索;

给新方法起个不错的缩写名称,不公布 Python 2 代码。

利用算力的一般方法最终是最有效的方法。

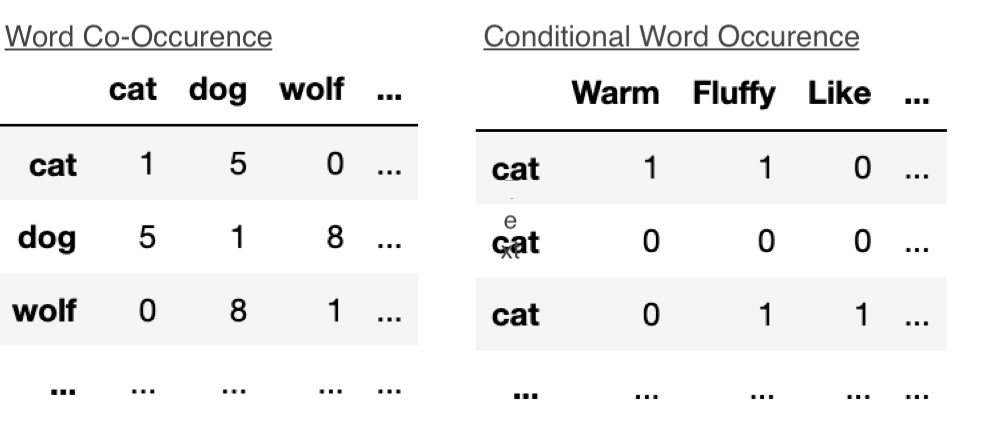

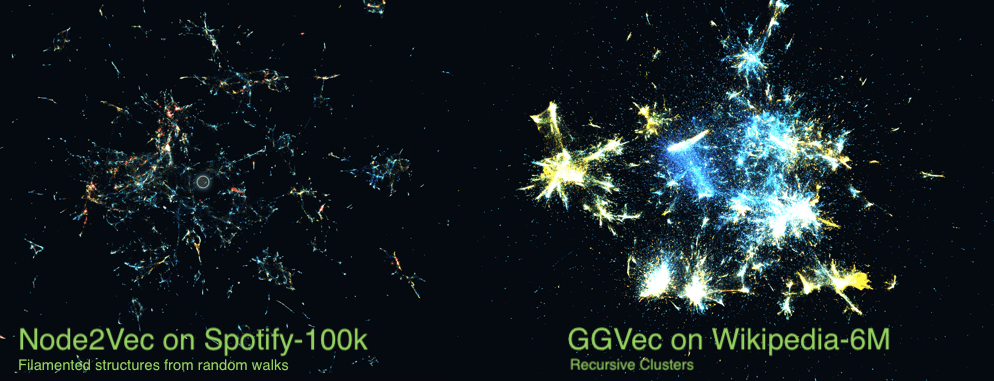

Edgewise 局部方法。我所知道的能做到这一点的算法只有 GloVe 和 GGVec,它们通过一个边列表,并在每一步上更新嵌入权重。这种方法的问题在于,它们很难应用于更加高阶的方法。但其优点也很明显:很容易进行扩展,即使是在一台计算机上也不例外。此外,逐渐增加新的节点也很简单,只需要获取现有的嵌入,添加一个新节点,然后在数据上执行一个新的 epoch。

随机游走采样。采用这一方法的包括 deepwalk 及相关的后续工作,通常用于嵌入而不是 GNN 方法。这在计算上可能非常昂贵,添加新节点也很困难。但它是可以扩展的,Instagram 就用它来为自己的推荐系统提供信息。

邻接采样。这是目前 GNN 中最普遍的一种采样方法,低阶、高阶都适用(取决于 neighborhood 的大小)。它的可扩展性也很好,尽管很难高效执行。Pinterest 的推荐算法用的就是这种方法。

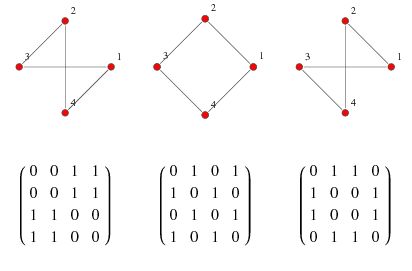

图类型和图方法之间是什么关系?

统一的基准测试,如 OGB。

我们把随机的模型扔给随机的基准,却不知道为什么或者什么时候它们表现得更好。

更基础的研究。我很好奇:其他表示类型(如 Poincarre 嵌入)能否有效地编码定向关系?

— THE END —

评论