自拍照被拿去训练AI?这款AI工具帮你「骗」过人脸识别算法

来源:新智元 本文约1600字,建议阅读6分钟 本文介绍了美国的一家面部识别公司从网络上获取多达30亿张照片为其面部搜索引擎提供训练数据所引发的争议。

[ 导读 ]尽管公众监督的呼声很高,然而面部识别AI已悄然地被机构用作监视的手段。魔高一尺,道高一丈,科学家们也在如火如荼地开发阻止上传到社交网络的自拍被AI训练的工具。

近期,纽约警察局(NYPD)在使用机器狗方面引发了很大的争议。然而,另一件事你不得不也关注起来:他们已经使用面部识别工具(Clearview AI)超过两年时间。

全国数百万人被Clearview AI锁定

公众自拍成训练数据

Clearview AI是一家美国面部识别公司,为执法部门,大学等公共机构提供软件。

他们已经从网络上获取多达30亿张照片为其面部搜索引擎提供训练数据。讽刺的是,政策并不允许NYPD创建一个供脸识别系统使用的无监督学习照片库,而Clearview AI正是依赖于来自社交媒体的庞大公共照片库。

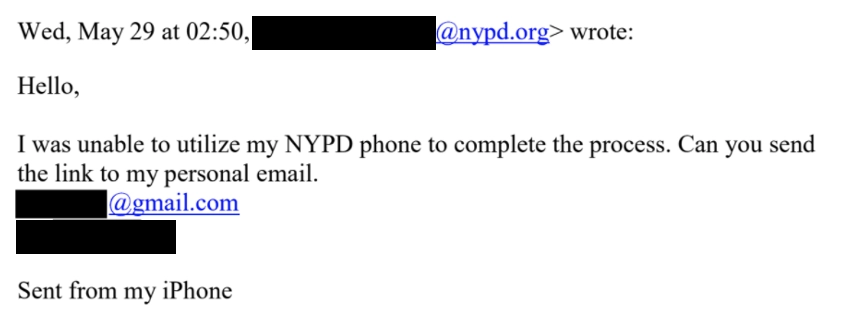

政策还包括将面部识别技术限制在特定的团队中,而现在则是将权限开放给了更多不相关的警员,甚至知情人士的邮件还指出有警员违规将软件下载到了个人设备上并随意使用。

通过Buzzfeed News发布的一个包含1800多个实体的数据库发现,来自全国近2,000个公共机构的7,000多人已经使用Clearview AI搜索了数百万人的面孔,其中包括轻微案件的嫌疑人及其家人和朋友。但这可能仅仅是开始。

现在,任何具有基本编码技能的人都可以开发面部识别软件,这意味着滥用技术的潜在可能性都比以往任何时候都大。

媲美数千人的数据攻击,你也能实现

许多AI研究人员正在开发确保AI无法从个人数据中学习的工具。

众所周知,数据攻击已经不是什么新奇的事物,诸如删除目标公司所拥有的数据,或使用假样本污染数据集从而更难训练准确的机器学习模型。

但是,这些通常需要需要数百或数千人参与才能得以实现。而新的技术和传统的数据攻击的区别在于它可以让个人用户去处理自己的照片。

「这种新的技术可以用作个人锁定数据的密钥,」澳大利亚迪肯大学的Daniel Daniel说, 「这是在AI时代保护人们的数字权利的一种新的前线防御。」

小工具一:超过五十万下载!「Fawkes」把AI耍得团团转

Fawkes提供了Mac,Windows和Linux的安装包:「sandlab.cs.uchicago.edu/fawkes/」。

芝加哥大学的Emily Wenger与同事们便开发出了首个实现这一目标的工具:Fawkes。Fawkes对图像进行微小的改动,这些更改很难用人眼察觉,但却可以欺骗AI,导致它无法正确识别在照片中看到的人或物。

这项技术非常接近一种对抗性攻击,在这种攻击中,对输入数据进行小的更改可能会迫使深度学习模型犯下错误。

在Fawkes中导入照片,它将为图像添加像素级扰动,从而阻止先进的面部识别系统识别照片中的人物。与以前的做法不同,例如戴着AI欺骗的面部彩绘,它所生成的图像在肉眼看来没有明显变化。

Wenger针对几种广泛使用的商业面部识别系统(包括亚马逊的AWS Rekognition,微软的 Azure)测试了他们的工具。在一个包含50个图像的数据集的小型实验中,Fawkes对所有图像均具有100%的有效性,在经过Fawkes调整的人像上训练的模型无法从新的图像中识别出这些人。

小工具二:「LowKey」让AI根本发现不了你

LowKey可以在线上进行直接使用「lowkey.umiacs.umd.edu」。

与基于对抗性攻击的Fawkes不同,LowKey对图像的处理并不是去导致AI犯错,而是更进一步的将图像转化为无法被学习的样本,有效地使AI在训练过程中完全忽略经过处理的图片。

在之后将其提供给模型时,AI对其中内容的评估并不会比随机猜测的更好。这种无法被学习的样本比对抗攻击更有效,因为模型无法利用它们进行训练。

在网络上的图像(上)

经过处理使面部识别系统忽略的无法学习的样本(下)

AI学习的对抗性的样本越多,它的识别能力就越强。但是由于LowKey从一开始就阻止了AI进行图像训练,因此也就不会发生AI越来越强,越来越难以欺骗的情况。

这并不是杞人忧天,在今年早些时候微软的Azure就通过更新升级,使部分版本的Fawkes的效果出现明显的下降。不过值得高兴的是,上个月Fawkes完成了1.0版本的更新,解决了这个问题。

编辑:黄继彦

校对:林亦霖