OpenAI开源Point-E,可在Nvidia V100 GPU上1-2分钟生成3D模型

来源:AI科技大本营 本文约800字,建议阅读5分钟

OpenAI的Point-E是3D模型的DALL-E,这个速度极快的系统可以从文本中生成3D点云。

在推出针对文本和图像的生成人工智能模型之后,OpenAI现在展示了下一步可能出现的东西:一个从文本到三维模型的生成器。通过文本描述,Point-E生成了3D点云,可以作为虚拟环境中的模型。除OpenAI之外,已经有其他用于3D生成的工智能模型,如谷歌的Dreamfusion或Nvidia的Magic3D。

然而,据说OpenAI的开源Point-E速度明显更快,在一个Nvidia V100 GPU上可以在一到两分钟内生成3D模型。

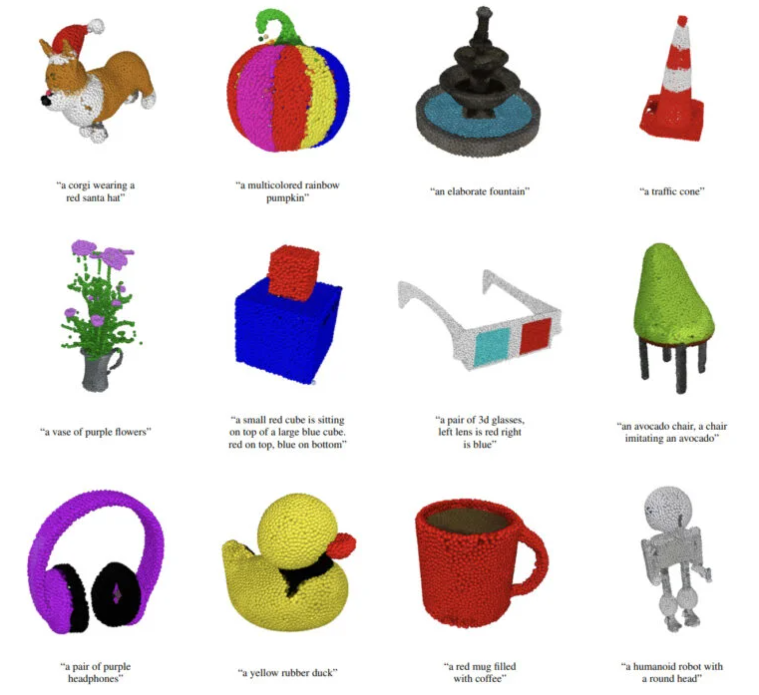

OpenAI的Point-E生成点云

实际上,Point-E并不生成传统意义上的3D模型,而是代表3D形状的点云。相比之下,谷歌的Dreamfusion生成NeRFs(Neural Radiance Fields)——需要更多的时间,但与点云相比,NeRFs可以呈现出更多明显的细节。很显然,Point-E的质量相对较低,因而使得该系统的效率很高。

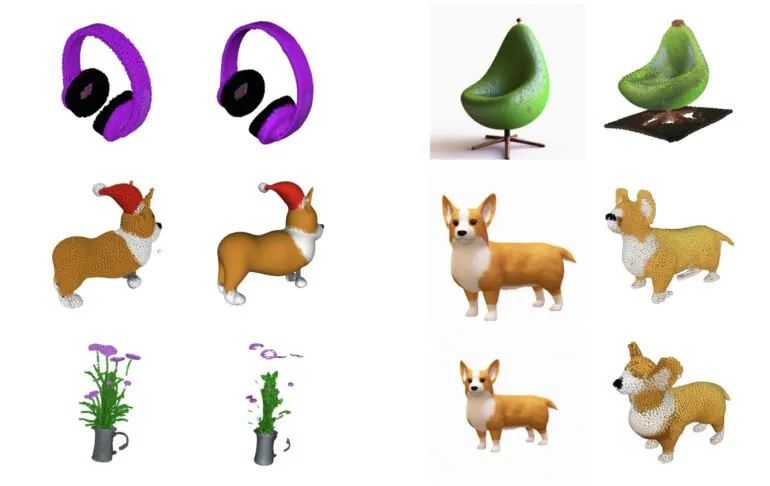

Point-E从文本描述中生成的点云的一些例子

当Point-E生成点云后,再由另一个作为三维建模和设计标准的模型将其转化为网格。根据OpenAI的说法,这个过程还不能完全避免出错:在某些情况下,云的某些部分会被错误地处理,导致生成错误的网格。

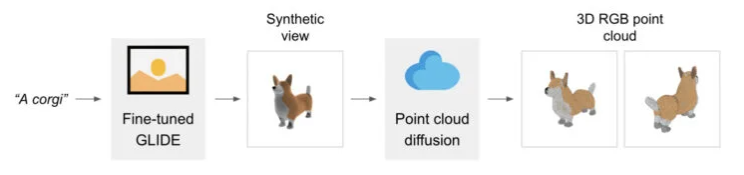

Point-E中的两个生成模型

具体来看,Point-E本身由两个模型组成:一个GLIDE模型和一个image-to-3D模型。前者类似于DALL-E或Stable Diffusion等系统,可以从文本描述中生成图像。第二个模型由OpenAI对图像和相关3D目标物体进行训练,学习从图像中生成相应点云。为了更好地训练,OpenAI使用了数百万个3D目标和相关的元数据。

通过GLIDE模型在 A corgi 中创建一个图像,然后通过点云扩散模型创建一个3D corgi

该团队报告说,“这两步过程可能会失败”。但它是如此之快,以至于生成目标的速度比Dreamfusion快近600倍。"这可能让它在某些应用上更加实用,或者发现更高质量的3D对象,"该团队表示。

“我们已经推出了Point-E,一个用于文本条件合成3D点云的系统。它首先生成合成视图,然后根据这些视图生成彩色点云。我们发现Point-E能够有效地产生以文本提示为条件的多样化和复杂的3D形状。”

据OpenAI称,Point-E是公司未来展开文本到三维合成业务的起点,目前已在Github上开放了源代码。Point-E 2可能最早在明年撼动3D市场。

参考链接:

https://the-decoder.com/point-e-openai-shows-dall-e-for-3d-models/