(附代码)ICCV 2021 Oral | 百度&南大提出神经绘画网络:Paint Transformer

点击左上方蓝字关注我们

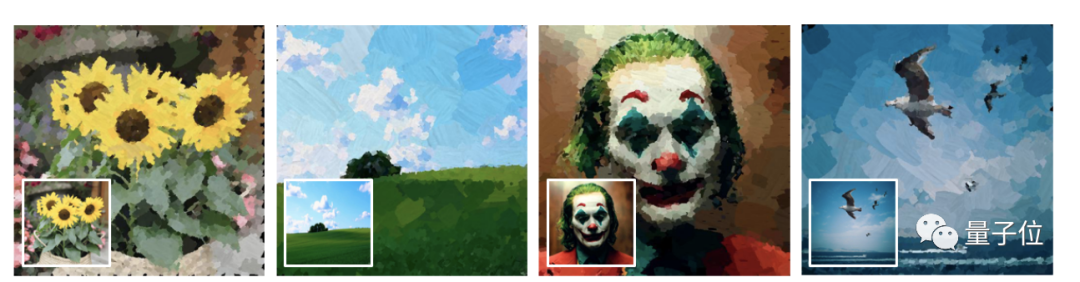

随便给一张图,笔画序列秒秒钟呈现。

比如世界名画蒙娜丽莎。

亦或是写实类的小鸟。

还有极具氛围感的河灯。

总之什么风格都可以驾驭。

这项技术在Reddit上21小时内就已经有600+的点赞量。

究竟是如何打造的呢?

用前馈网络预测笔画

神经绘画,就是为给定的图像生成一系列笔画,并使用神经网络进行绘画式的真实再现过程。

研究团队提出了一个基于Transformer的框架,叫做Paint Transformer,用前馈网络来预测笔画的参数。

由于当前没有可用的数据集来训练Paint Transformer,受物体检测启发,研究人员设计了一个自训练Pipeline。

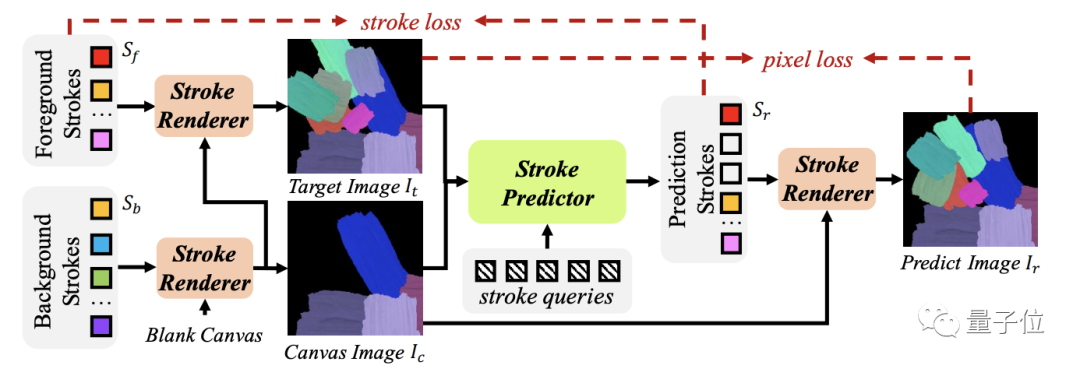

整个模型由两个模块组成:笔画预测器和笔画渲染器。

给定目标图像和中间画布图像,笔画预测器,生成一组参数以确定当前笔画集。

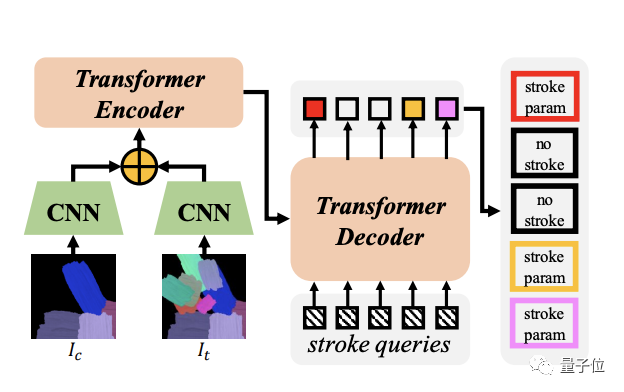

预测器包含了两个用于特征嵌入的CNN网路和一个用于参数预测的Transformer。

随后,笔画渲染器为笔画集汇总的每个笔画,生成笔画图像,并将它们绘制到画,产生结果图像,大小为512*512。

在DETR(用Transformer进行对象检测)的基础上,增加了二进制神经元来预测笔画是否应该被保留。

这样它就可以在没有任何现成的数据集的情况下进行训练,同时还能实现出色的泛化能力。

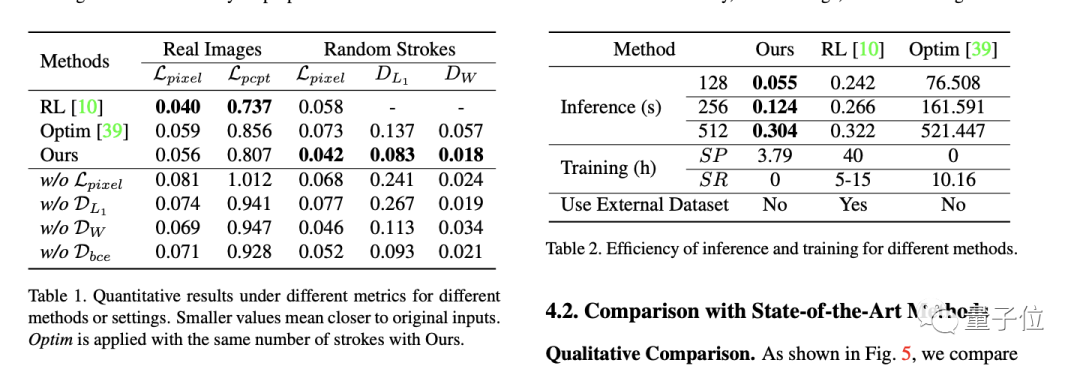

实验表明,这一方法比以前的方法取得了更好的绘画性能,而且训练和推理成本更低。

百度南大团队打造

这项技术由百度、南京大学、罗格斯大学共同打造。

Paint Transformer: Feed Forward Neural Painting with Stroke Prediction

目前代码已经开源,并在一刻相册App上应用。

论文地址:

https://arxiv.org/abs/2108.03798

GitHub网址:

https://github.com/wzmsltw/PaintTransformer

END

点赞三连,支持一下吧↓