20年磨一剑!南京大学周志华教授团队重磅新作出版

点击下方“AI算法与图像处理”,一起进步!

重磅干货,第一时间送达

关注我们丨文末赠书

关注我们丨文末赠书

关注我们丨文末赠书

— 01 —

周志华教授团队深耕演化学习

周志华教授

俞扬教授

钱超副教授

功夫不负有心人,在理论、算法和应用效果明朗之后,演化学习不再是冷板凳。2019年4月周志华、俞扬、钱超的英文书Evolutionary Learning: Advances in Theories and Algorithms出版,反响热烈,引发了出版中文版的呼声,在Springer电子书平台下载量迄今也已超过三万。

在英文书出版商签返中文版权后,周志华团队开始利用疫情下各种活动减少的窗口期,推敲出了中文版书稿,几经校改,终于快要和读者见面:《演化学习:理论与算法进展》。该书还在预售期间时,媒体首发文章的阅读数就超过了2.7万。本文将对其主要内容做个梳理介绍。

— 02 —

《演化学习:理论与算法进展》一书内容

这本书由四部分组成:预备知识、分析方法、理论透视、学习算法。

第一部分简要介绍演化学习和一些关于理论研究的预备知识,对机器学习、演化学习、多目标优化、演化算法、伪布尔函数及一些衡量标准和分析工具等进行简单介绍。

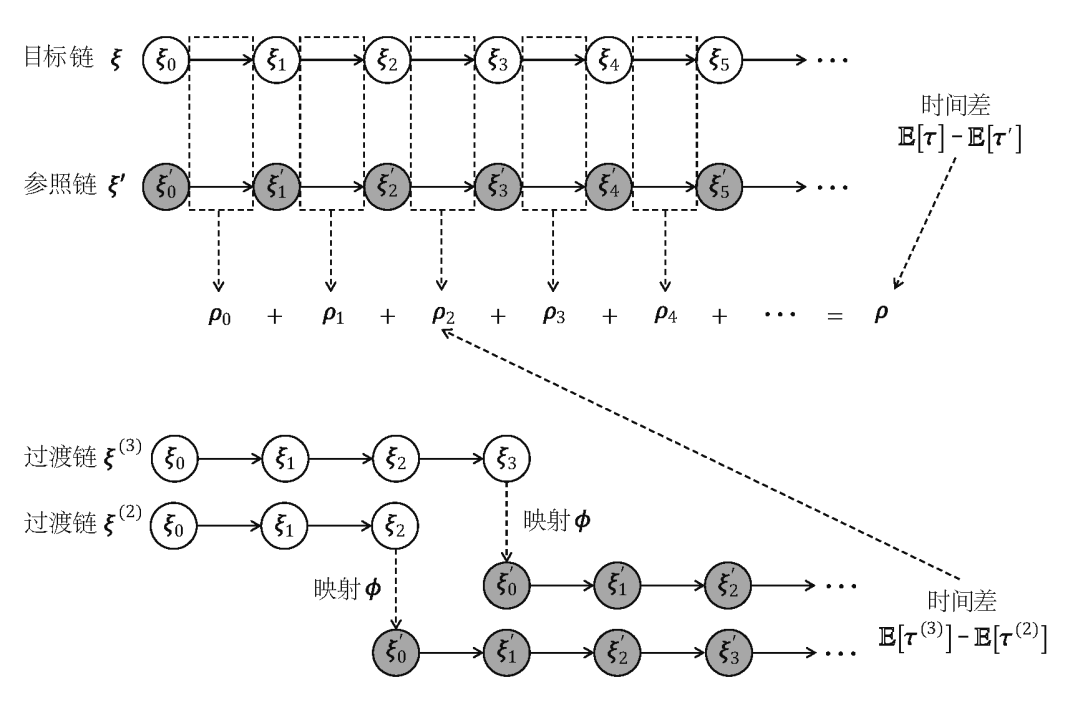

为了分析运行时间复杂度(running time complexity)和近似能力(approximation ability)这两个关于随机搜索启发式(randomized search heuristics)的最重要的理论性质[Neumann and Witt,2010; Auger and Doerr,2011],本书第二部分给出了分析演化算法运行时间界(bound)的两种通用方法,即收敛分析法(convergence-based analysis)和调换分析法(switch analysis),以及刻画演化算法近似性能的一般框架SEIP。这些为获得本书后续介绍的一些理论结果提供了通用工具。

第三部分给出了关于演化算法的一系列理论结果。本书先探讨了如何辨识一个问题类(problem class)中关于某个给定演化算法的边界问题(boundary problem),即找到对于这个算法最简单和最困难的问题。然后,本书探讨了演化算法关键技术要素对其性能的影响,包括交叉算子、解的表示、非精确适应度评估(fitness evaluation)和种群的影响等。最后,本书考察了演化算法在求解机器学习任务中常见的约束优化(constrained optimization)问题时的性能。

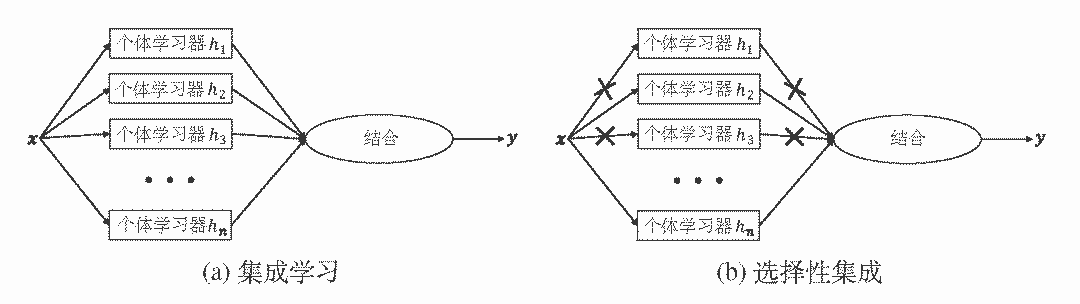

第四部分给出了一系列基于理论结果启发的具有一定理论保障的演化学习算法。本书先考虑选择性集成(selective ensemble)任务,即尝试选择出个体学习器子集以获得更好的泛化性能,给出的帕累托优化(Pareto optimization)算法在优化泛化性能的同时最小化学习器数目,其性能显著优于其他著名的选择性集成算法。然后,本书研究了更具一般性的子集选择(subset selection) 问题,即选择有限项来优化一个给定的目标函数。本书给出的帕累托优化算法可获得目前已知的最佳多项式时间近似保证(polynomial-time approximation guarantee)。本书进一步为两个扩展子集选择问题给出了帕累托优化算法的变种,均可获得目前已知的最佳多项式时间近似保证。最后,考虑到实际学习任务通常是带噪的且规模很大,本书还为子集选择问题给出了相应的容噪和并行算法。

— 03 —

演化学习前景展望

在机器学习领域,“启发式”应用演化算法的研究人员和工程人员大有人在,也有不少人将其视为机器学习和人工智能领域的“Next Big Thing”。比如2018年8月,来自麻省理工学院计算机科学与人工智能实验室(MIT CSAIL)的Una-May O'Reilly教授、密歇根大学Erik Goodman教授、德克萨斯大学奥斯汀分校Risto Miikkulainen教授,以及来自佛蒙特大学、法国国家信息与自动化研究所、Google AI等研究机构的十余位知名学者,对演化学习在机器学习中的前景专门进行了讨论,认为演化学习和机器学习结合,将会推动更具创造性的新AI能力的产生。不过那个时候,这方面的理论框架尚不明朗,算法和应用的发展仍旧受限。正如原英国诺丁汉大学计算机科学教授、副校长Graham Kendall博士2018年在“对话”(The Conversation)网站撰文指出的,(包含演化算法在内的)演化计算需要有人建立易用的框架把底层的复杂性封装起来,才能从学术界推广到业界,发挥更大的作用。

周志华教授团队在演化学习领域做出的原创性、系统性的探索,相关成果这些年来已经陆续在AAAI、IJCAI、NIPS等国际顶级人工智能学术会议和期刊上发表。现在《演化学习:理论与算法进展》一书英文版、中文版均已上市且受到高度关注,更是为有志于进入该领域的人士提供了全面、集中的学习材料。相信其中的理论框架、分析方法、算法思想和实现,以及对应用的示例和展望,将极大推动演化算法在机器学习领域的应用,使演化学习成为机器学习中的重要方向,最终催生一个真正的“Next Big Thing”。同时,周志华教授团队认定一条道路二十年如一日甘坐冷板凳、把冷板凳坐热的科研精神,相信对广大科研工作者带来启发。