做边缘智能,要摒弃“拿着锤子找钉子”

物联网智库 原创

转载请注明来源和出处

导 读

想搞边缘智能容易,想搞好边缘智能却很难,想用边缘智能创造出可观的商业价值更是难上加难。

试想,一辆正在急速前进的自动驾驶汽车,前方突然遇到障碍需要紧急刹车,这时它不可能把相关信息送到云端处理再反馈,否则等刹车指令下达的时候很可能已经发生撞车事故了。

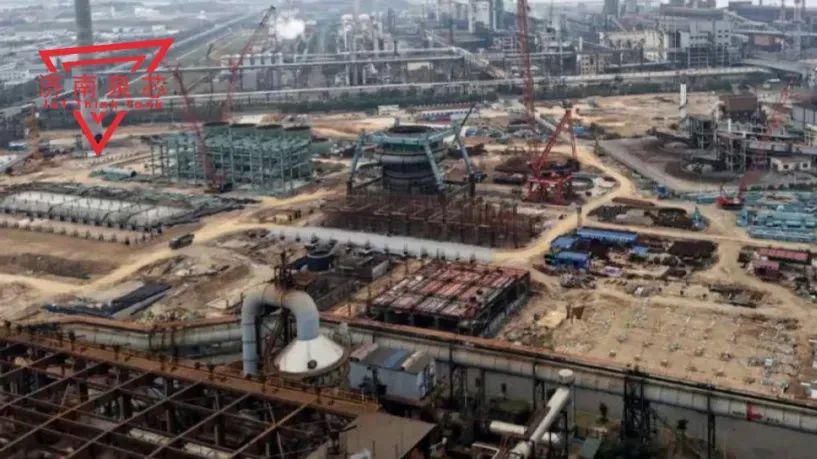

类似的,在轧钢这样的工业场景中,轧机需要依靠多个伺服电机协同驱动轧制过程,电机不能出现丝毫的偏差,否则可能导致整块钢板报废。为了保证轧制精度,需要以毫秒级的数据采集频率来监测电机的运转是否正常,实时数据上云显然也是来不及的。

除了时延,隐私安全近年来也成为个人和企业越发关注的问题。比如,在传统的人脸识别场景下,智能终端需要将收集到面部信息上传到云服务器进行处理,从而为数据泄露或被滥用埋下了隐患。而对企业来说,商业隐私甚至关乎其生死存亡,因此大多数企业都不愿意把核心数据放在云平台厂商的服务器上。

出于对时延和隐私的需求,边缘智能的概念在近年来受到越来越高的认同。正是看到了如此广阔的市场机遇,包括互联网厂商、IT企业、工业巨头在内的玩家纷纷入局该领域,Edge AI相关解决方案也在各行各业落地开花。

然而,想搞边缘智能容易,想搞好边缘智能却很难,想用边缘智能创造出可观的商业价值更是难上加难。

在此前的2021联想创新科技大会上,联想大脑Edge AI正式发布。近日,物联网智库等媒体和联想集团副总裁、联想研究院人工智能实验室负责人范建平博士以及联想商用IoT业务总经理王磊就Edge AI的构成机制、行业价值和布局思路进行了深入沟通。

通过他们的分享,我们知道,要想让Edge AI真正赋能千行百业,需要踩过技术、场景、商业等数个“大坑”,尤其要摒弃“拿着锤子找钉子”的行为。

踩过“技术”的坑:从云端到边缘

首先,每家每户用水量的增加(数据量激增)使得水厂(云端)有些不堪重负;其次,水从水厂流到水龙头需要一定的延迟时间(时延);最后,一旦供水厂出现问题,就会影响到整张供水网络的运作(隐私安全)。而边缘智能则很像在靠近家庭水龙头的地方安装了一个“应急水箱”,来应对云端负载、时延和隐私等方面带来的挑战。

据范博士所述,Edge AI的部署需要先在云端预训练模型(Pre-train model),然后再下发到边缘侧,这就会涉及第一个技术难题——当把在云端预训练的模型部署在边缘侧时,预训练模型和边缘设备之间可能不是完全匹配。

形象点儿来说,云端“水厂”的储量很大,边缘侧“水箱”的储量很小,部署Edge AI的过程需要涉及模型的量化、压缩等操作。

至于模型和硬件相匹配的问题,据悉,基于智能推荐算法,联想如今已经可以通过Edge AI平台,给客户提供最优的AI模型和与硬件相匹配的方案,将硬件和软件进行良好的适配,让软硬件之间实现真正的协同。由此,客户在开发过程中甚至可以不用真正的硬件,而是通过仿真软件去实现软硬件的适配。

当模型被部署到边缘侧以后,第二个技术难题又不约而来。这是因为,科学家在云端预训练模型的时候,收集的都是历史数据,但实际应用场景却是千变万化的。也就是说,训练数据和测试数据可能完全不一样,模型的训练环境和实际的运行环境也可能完全不相同——如何在边缘侧更新模型成了关键。

显然,任何模型的更新都需要数据作为支撑,但糟糕的是,在边缘侧却往往很难收集到足够多有效的样本数据。以智能工厂的瑕疵检测场景为例,我们不能指望产线80%都是废品,如果这样工厂早倒闭了。实际的废品率可能只有千分之一甚至万分之一,所以模型能拿到的缺陷样本数是非常少的。在这种情况下,AI必须能够像人一样,从小样本中去学习。

为了解决这个问题,联想创新地将“数据增强”和“元学习”结合,打造了“小样本终身学习技术”。

举个通俗易懂的例子,学开车。比如,你会开小轿车,但需要学习开大卡车。两者虽然存在不少差异,但会开小轿车的话,学开大卡车总比从零开始学更容易,因为有些基础可以借鉴。这就是meta learning(元学习)的原理。通过借鉴不同任务的相似之处,来实现任务层面的学习能力泛化,提升模型不断适应新任务的能力。

此外,联想还通过原始样本空间增强、模型特征空间中数据扩充、风格迁移等方式,扩充了样本容量,丰富了数据分布,进一步提升了模型的学习能力,从而实现终身学习。

踩过“场景”的坑:摒弃“拿着锤子找钉子”

而在场景方面,联想天然具备优势。作为一家智能制造企业,联想打造了全球化的生产基地布局,集团在全球拥有35家制造工厂。过去几年,联想的各个工厂致力推进产线的自动化和数字化,积累了丰富的实践经验,这正是Edge AI落地最好的土壤。

范博士也分享了一些联想的实践案例。

在联想深圳工厂为微软生产服务器的时候,客户的一个基本要求是生产区域不能有外部人员随意进入。传统的做法是依靠人工坐在门口进行监控,但这种做法显然费时费力,而且人总会有疲惫和需要休息的时候。Edge AI的解决方案则能轻易替代人工,实时监控是否有非授权的人员进入,而且由于数据保留在本地,也不会侵犯员工的隐私安全。

除了联想自己的工厂,越来越多的客户也正受益于此。例如,为保障印刷业的领军企业高斯中国的顺畅运行,联想从以前只卖PC,到后来提供边缘计算设备,以及Leap IoT平台等,实现了高斯中国的远程云管理,使得其设备故障率降低了50%,高斯员工的出差成本降低了65%,售后服务的客户满意度提升了80%。

“是历史机遇选择了联想,而不是联想在做选择。”范博士如此形容联想在边缘智能的布局。

根据Gartner的预测显示,截止到2025年将会有75%的数据在数据中心和云之外的边缘侧产生。同时,未来边缘计算市场规模将超万亿,成为与云计算平分秋色的新兴市场。在这样的背景下,联想入局边缘智能恰逢其时——这是“天时”。

其次,联想作为制造企业,自己有很多应用场景,客户也有很多应用场景,联想在服务客户的过程中积累了许多洞察与经验——这是“地利”。

最后,以范博士为代表的科学家团队始终专注于AI技术的研究,正如范博士所说,“我们不是最聪明的一群人,也不是配置的最高的一群人,但是我们确实始终以客户为己任。”——这是“人和”。

“天时地利人和”,赋予了联想做好Edge AI的底气。

踩过“商业”的坑:破解碎片化难题

即使是同一台设备,在不同工况下其劣变程度都有可能不同,更何况是“隔行如隔山”的千行百业呢。边缘智能的场景碎片化程度很强,需求非常复杂,随定制化而变化,导致很多边缘解决方案的通用性和复用性不够强。

“如果一个场景一个场景(case by case)的去做,一定是死路一条。”范博士直言,“联想破解碎片化难题的做法是80%的底层技术依靠平台实现,剩下20%左右是场景化的东西。”

从这个角度来说,Edge AI更像是一个应用商店,其中包含各种算法和模型,客户可以灵活选择,极大地减少开发、设计等人力成本。

面向对AI技术本身有一定了解的客户,联想为其提供人员检测、车流监测、语音识别等基本模块,开发人员能够以拖拽的方式如同搭积木一般快速组合自己的解决方案;面向没有AI背景知识的客户,集成商只需将自己的预算和场景输入平台,形成约束条件,平台依然可以自动生成相应的解决方案。

换言之,联想提供的只是底层的基础能力,上层的应用还需要生态系统里的万千客户去依据需求构建。

王磊则从另一个角度阐述了如何从定制化走向通用化:“最开始我们在做项目,在做项目的过程中会有一些工具产生,当把这样的工具用于更多的项目时,工具就会变成通用的产品。产品再往上迭代,就是平台了。客户虽然是不同的,但我们会把共性的东西抽象出来,形成平台和生态。”

目前,联想Edge AI平台已经通过联想企业科技集团实现了产品化,推出了LiCO AI、AI一体机等功能强大的AI产品与解决方案,被广泛应用于人工智能数据中心、智能制造、工业物联网、智慧城市、智能零售、智能音箱和智能家居等各个方面。在自动驾驶领域,可以做到行人识别、车辆识别、信号灯识别等。

结语

往期精选