计算机视觉知识点总结

点击上方“小白学视觉”,选择加"星标"或“置顶”

重磅干货,第一时间送达

本文转自:AI算法与图像处理

本文转自:AI算法与图像处理

目录:

1 经典卷积网络

2 卷积、空洞卷积

3 正则化

4 全卷积网络

5 1*1卷积核

6 感受野

7 常见损失

8 优化算法

9 concat 和 add的区别

10 注意力机制

11 CNN(卷积神经网络)、RNN(循环神经网络)、DNN(深度神经网络)

12 边框回归

13 非极大值回归(NMS, Soft NMS)

14 激活函数

15 评价指标

16 batch size的选择

17 Graph Convolutional Network(GCN)

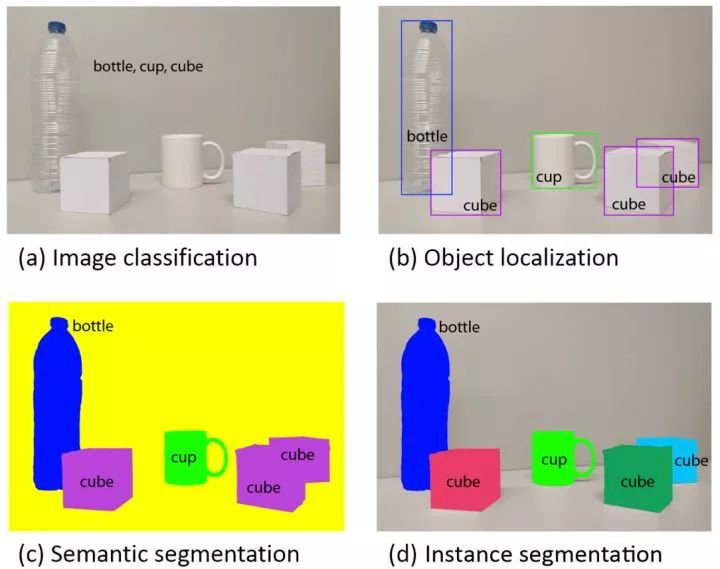

计算机视觉四大基本任务(分类、定位、检测、分割)

https://zhuanlan.zhihu.com/p/31727402

目标检测解读汇总

https://zhuanlan.zhihu.com/p/36402362

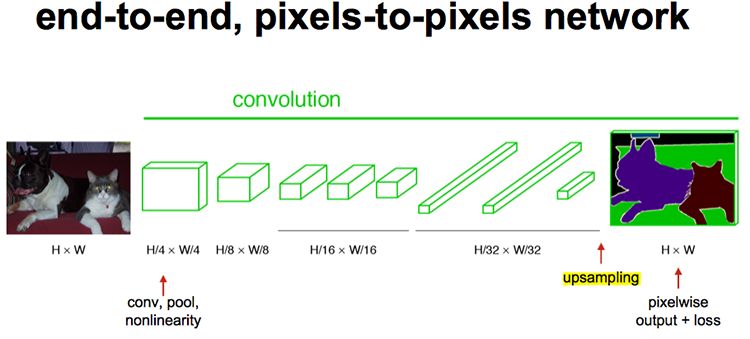

图像语义分割综述

https://zhuanlan.zhihu.com/p/37801090

AlexNet:https://blog.csdn.net/chaipp0607/article/details/72847422

VGG:https://blog.csdn.net/briblue/article/details/83792394

GoogleNet:https://blog.csdn.net/loveliuzz/article/details/79135583

ResNet:

https://blog.csdn.net/lanran2/article/details/79057994

https://blog.csdn.net/lanran2/article/details/80247515

Xception:https://blog.csdn.net/u014380165/article/details/75142710

DenseNet:https://blog.csdn.net/u014380165/article/details/75142664/

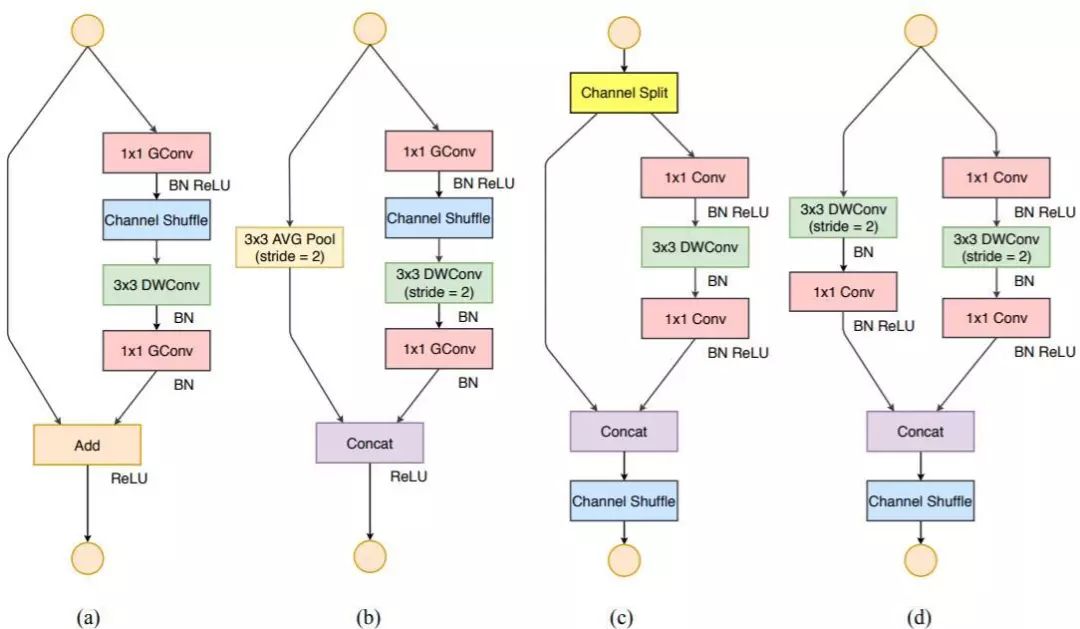

shufflenet:https://zhuanlan.zhihu.com/p/48261931

卷积神经网络中十大拍案叫绝的操作【点击可以跳转】

卷积:https://www.zhihu.com/question/22298352

https://blog.csdn.net/kklots/article/details/17136059

https://blog.csdn.net/bea_tree/article/details/68954650

空洞卷积:https://www.zhihu.com/question/54149221/answer/323880412

https://zhuanlan.zhihu.com/p/50369448

batch normalization、group normalization:

https://blog.csdn.net/malefactor/article/details/51476961

https://zhuanlan.zhihu.com/p/43200897

https://zhuanlan.zhihu.com/p/56219719

dropout:https://blog.csdn.net/stdcoutzyx/article/details/49022443

L1、L2:

https://blog.csdn.net/zouxy09/article/details/24971995

https://blog.csdn.net/jinping_shi/article/details/52433975

https://www.cnblogs.com/gujianhan/p/6030639.html

https://zhuanlan.zhihu.com/p/40050371

https://www.zhihu.com/question/56024942

https://blog.csdn.net/chaipp0607/article/details/60868689

6 感受野

深度神经网络中的感受野(Receptive Field):

https://zhuanlan.zhihu.com/p/28492837

损失函数改进方法总览:

https://blog.csdn.net/u014380165/article/details/76946358

请问faster rcnn和ssd 中为什么用smooth l1 loss,和l2有什么区别? https://www.zhihu.com/question/58200555/answer/621174180

focal loss:https://zhuanlan.zhihu.com/p/32423092

交叉熵:https://blog.csdn.net/yimingsilence/article/details/52740638

https://blog.csdn.net/u014380165/article/details/77284921

对比损失(Contrastive Loss):

https://blog.csdn.net/autocyz/article/details/53149760

三元组损失(Triplet Loss):

https://blog.csdn.net/jcjx0315/article/details/77160273

Momentum:https://zhuanlan.zhihu.com/p/21486826

Nesterov Accelerated Gradient:https://zhuanlan.zhihu.com/p/22810533

如何理解神经网络中通过add的方式融合特征?

https://www.zhihu.com/question/306213462/answer/562776112

计算机视觉中的注意力机制:

https://zhuanlan.zhihu.com/p/32928645

https://zhuanlan.zhihu.com/p/56501461

CNN(卷积神经网络)、RNN(循环神经网络)、DNN(深度神经网络)的内部网络结构有什么区别?

https://www.zhihu.com/question/34681168/answer/84061846

边框回归(Bounding Box Regression)详解

https://blog.csdn.net/zijin0802034/article/details/77685438

NMS:https://blog.csdn.net/shuzfan/article/details/52711706

Soft NMS:

Soft NMS算法笔记

https://blog.csdn.net/u014380165/article/details/79502197

深度学习中的激活函数导引:

https://zhuanlan.zhihu.com/p/22142013

如何理解ReLU activation function?

https://www.zhihu.com/question/59031444/answer/177786603

请问人工神经网络中的activation function的作用具体是什么?为什么ReLu要好过于tanh和sigmoid function?

https://www.zhihu.com/question/29021768/answer/43488153

目标检测mAP

https://github.com/rafaelpadilla/Object-Detection-Metrics

语义分割(PA、MPA、MIoU、FWIoU)

https://zhuanlan.zhihu.com/p/61880018

https://link.zhihu.com/?target=https%3A//arxiv.org/abs/1704.06857

怎么选取训练神经网络时的Batch size?

https://www.zhihu.com/question/61607442/answer/440401209

深度学习中的batch的大小对学习效果有何影响?

https://www.zhihu.com/question/32673260/answer/71137399

如何理解 Graph Convolutional Network(GCN)?

https://www.zhihu.com/question/54504471/answer/332657604

交流群

欢迎加入公众号读者群一起和同行交流,目前有SLAM、三维视觉、传感器、自动驾驶、计算摄影、检测、分割、识别、医学影像、GAN、算法竞赛等微信群(以后会逐渐细分),请扫描下面微信号加群,备注:”昵称+学校/公司+研究方向“,例如:”张三 + 上海交大 + 视觉SLAM“。请按照格式备注,否则不予通过。添加成功后会根据研究方向邀请进入相关微信群。请勿在群内发送广告,否则会请出群,谢谢理解~