ResNet潜力都挖掘出来了吗?

点击下方“AI算法与图像处理”,一起进步!

重磅干货,第一时间送达

基线:我要是用上最新的训练流程,性能还能涨一波。

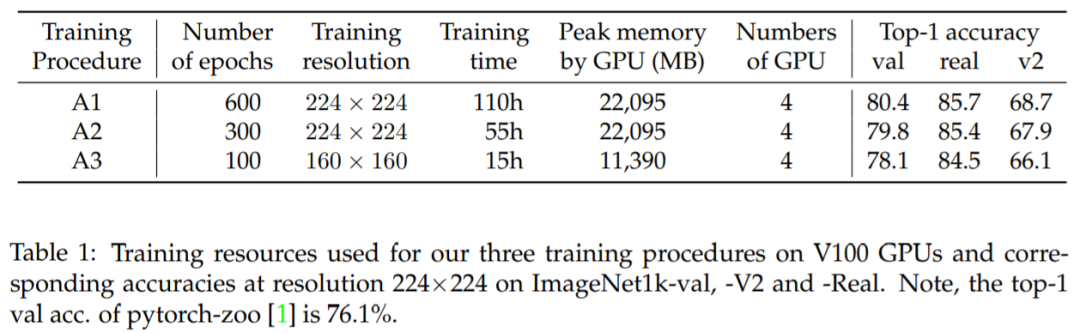

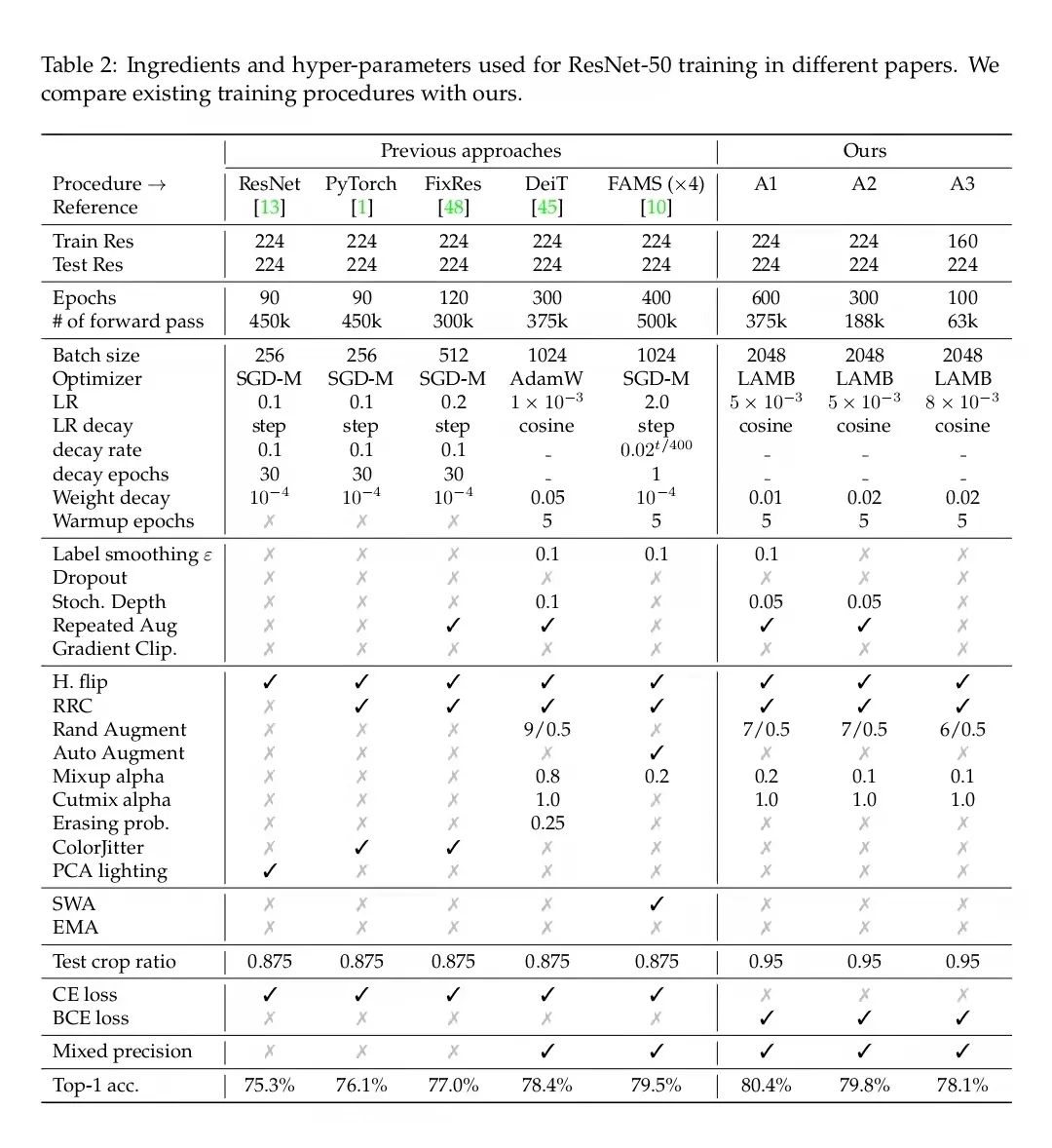

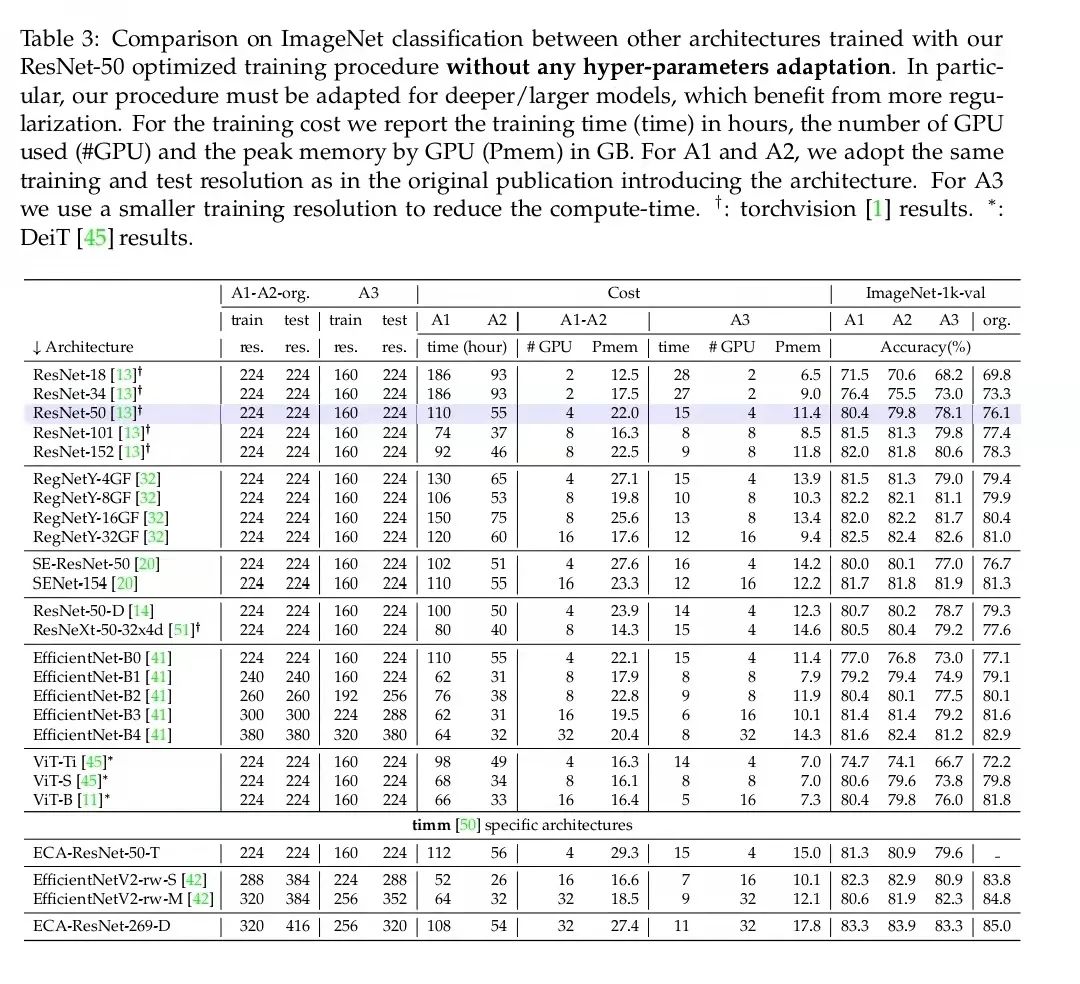

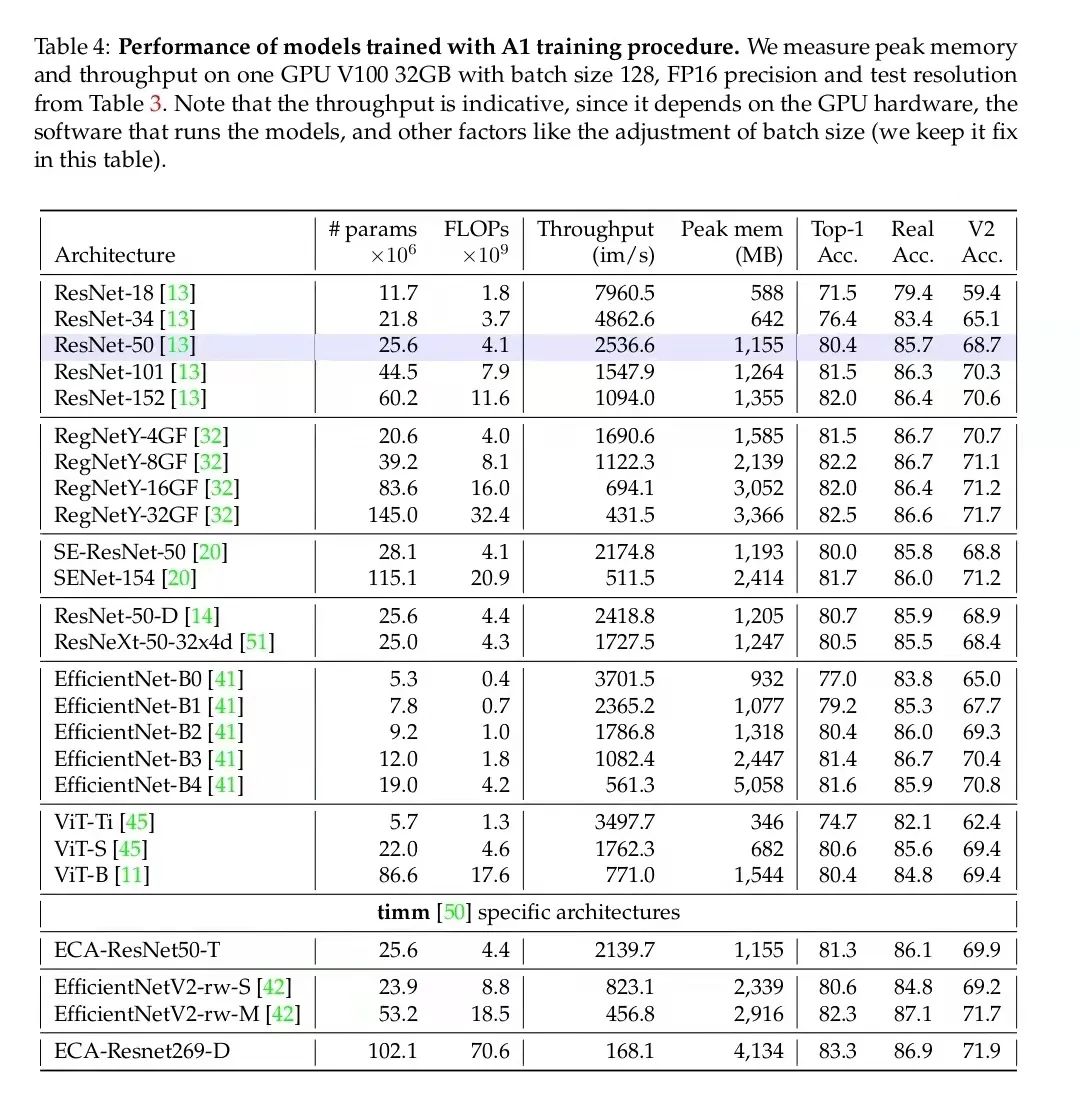

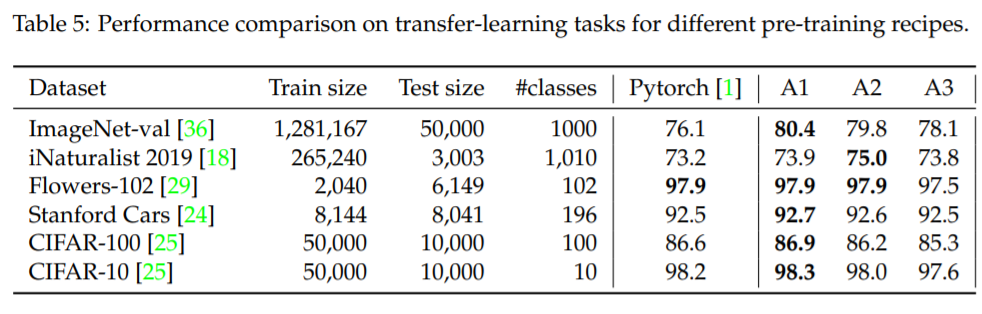

流程 A1 旨在为 ResNet-50 提供最佳性能,因此 epoch 数量最多(600),训练时间最长(在一个配有 4 个 V100 32GB GPU 的节点上训练 4.6 天)

流程 A2 的 epoch 数量为 300,可与 DeiT 等其他几个优秀训练流程媲美,但批大小更大(2048)。

流程 A3 旨在通过 100 个 epoch 和 2048 的批大小超越普通 ResNet-50 的流程,它在 4 个 V100 16GB GPU 上训练了 15 个小时,并且可能是探索性研究的良好设置。

交流群

欢迎加入公众号读者群一起和同行交流,目前有美颜、三维视觉、计算摄影、检测、分割、识别、医学影像、GAN、算法竞赛等微信群

个人微信(如果没有备注不拉群!) 请注明:地区+学校/企业+研究方向+昵称

下载1:何恺明顶会分享

在「AI算法与图像处理」公众号后台回复:何恺明,即可下载。总共有6份PDF,涉及 ResNet、Mask RCNN等经典工作的总结分析

下载2:终身受益的编程指南:Google编程风格指南

在「AI算法与图像处理」公众号后台回复:c++,即可下载。历经十年考验,最权威的编程规范!

下载3 CVPR2021 在「AI算法与图像处理」公众号后台回复:CVPR,即可下载1467篇CVPR 2020论文 和 CVPR 2021 最新论文

评论