视频程式化的基于帧差异的时间损失

点击上方“小白学视觉”,选择加"星标"或“置顶”

重磅干货,第一时间送达

神经样式传递模型已经被用来将普通的视频程式化为特定的样式。为了保证程式化视频帧间的时间不一致,一种常用的方法是估计原始视频中像素的光流,并使生成的像素与估计的光流匹配。这是通过最小化模型训练过程中的光流(OFB)损失来实现的。然而,光流估计本身就是一项具有挑战性的任务,特别是在复杂场景下。此外,它会导致较高的计算成本。为了解决时间不一致的问题,作者提出了一种更简单的时间丢失方法,称为基于帧差异的丢失(FDB)。它被定义为程式化帧之间的差值与原始帧之间的差值之间的距离。在卷积神经网络指定的像素空间和特征空间中测量两帧之间的差异。一组涉及62名受试者25600张选票的人类行为实验表明,所提出的FDB损失的性能与OFB损失的性能相匹配。在两种典型的视频风格化模型上,通过主观评价生成视频的稳定性和风格化质量来衡量性能。结果表明,提出的FDB损失是一个强大的替代,通常使用的OFB损失的视频程式化。

根据经验,作者发现这个简单的方法产生了很好的稳定性结果,但也导致了程式化质量的下降。然后在神经网络指定的特征空间中引入帧差,并将其与像素空间中的帧差结合作为损失函数。这种损失称为基于帧差异的(FDB)损失。它制作的程式化视频具有与基于光流(OFB)损耗类似的视频稳定性和程式化质量。与OFB损失相比,本文提出的FDB损失可以显著降低计算成本,因为它不需要在训练前对训练视频进行光流估计,而一般的数据集训练通常需要几天的时间。

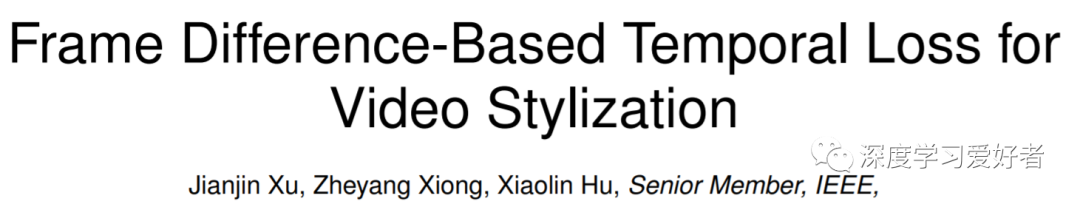

SFN和RNN的培训管道。P-FDB损耗和F-FDB损耗定义在(6)中,分别对应于l = 0和l >分别为0。作者注意到,在任何一种情况下,时间损失需要四个输入:It, It+1, It和It+1。对于SFN,在推理中,在每个时间步长t,只使用来自原始视频的一帧It,并输出一个程式化帧It。对于RNN,在训练和推理中,使用以前的程式化输出It(或者在第一帧为0)和当前帧It+1来产生程式化输出It+1。

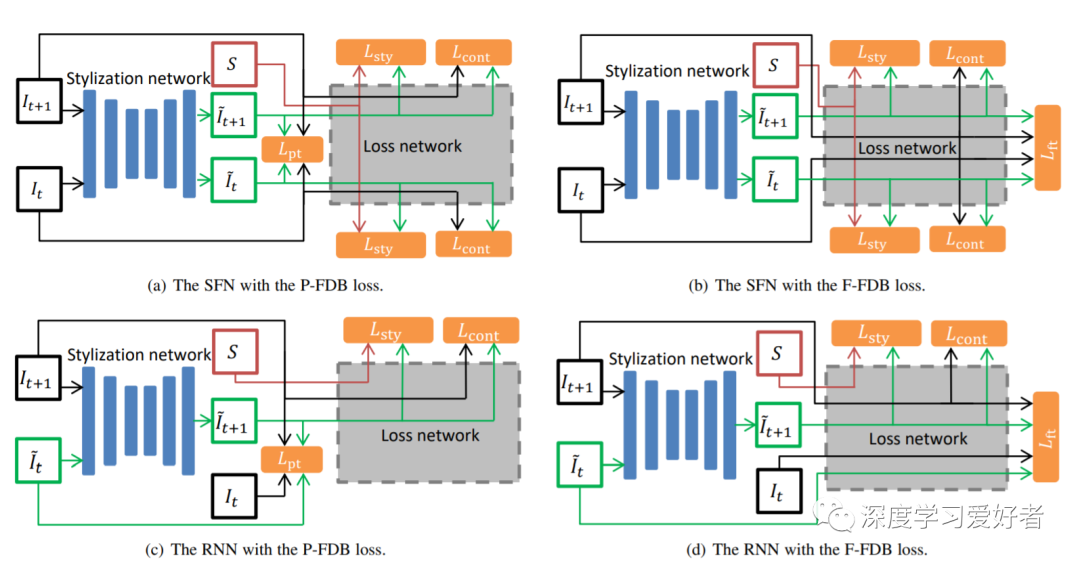

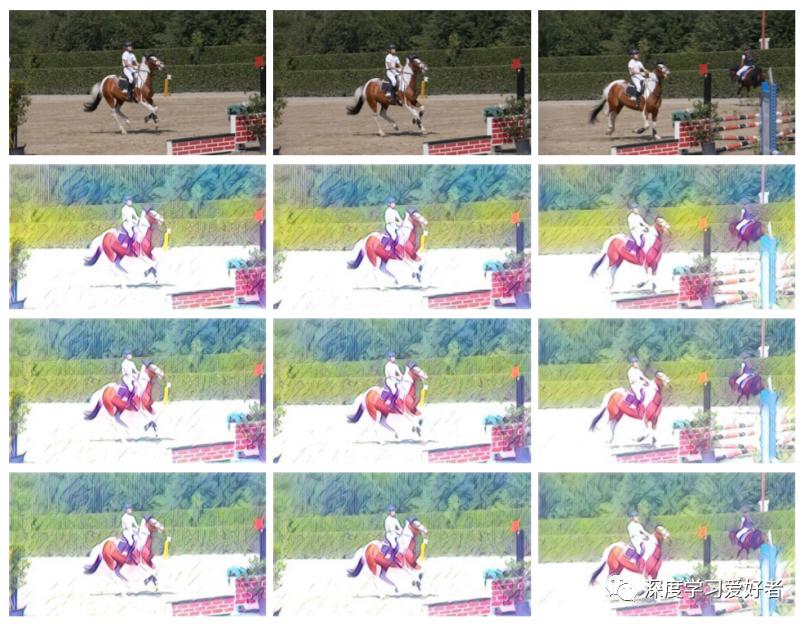

不同填充方法的SFN模型的结果。第一行说明了各种填充方法。第二行和第三行分别是训练无时间损耗和P-FDB损耗的SFN的结果。其风格形象是La Muse。

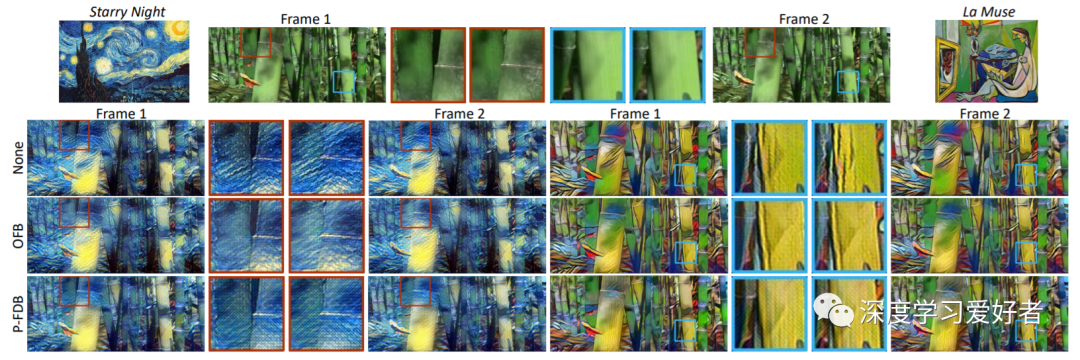

三个sfn的结果给出了一个内容视频(竹3在辛特数据集)和两个风格图像(星夜和La Muse)。第一行显示内容视频中的两个样式图像和两个连续的帧。放大后的图像也显示在红框和蓝框中。第二至第四行分别是经过无时间损失训练的SFNs,经过OFB损失训练和P-FDB损失训练后得到的程式化帧。

采样不同帧间隔的SFNs的结果。模特们接受了风格形象羽毛的训练。第一行显示了三个原始帧(编号0、1和9),来自于DAVIS测试拆分中的一个剪辑。第二至第四行分别显示由SFN用1、4和8帧间隔P-FDB损耗训练的程式化帧。

先进的视频风格化模型通常采用OFB方法来稳定帧。然而,在复杂的情况下,光流的计算是昂贵和具有挑战性的。由于稳定性编码在原始视频的帧差中,作者建议通过要求输出帧差接近输入帧差来稳定帧。FDB损耗可以在像素空间中计算,也可以在某些深度神经网络的特征空间中计算,也可以在两个空间中计算。这个技巧简单而有效。作者在两种典型的视频程式化网络上比较了所提出的时间损耗和流行的OFB时间损耗的性能。大量的人类行为实验表明,在视频的稳定性和程式化质量方面,所提出的损失与一个网络上的OFB损失相当,并优于另一个网络上的OFB损失。

所提出的FDB损耗可以应用于大多数使用OFB损耗的视频程式化模型。此外,它可能还有视频风格化之外的应用。事实上,在任何需要视频帧间的时间一致性而原始稳定视频已知的任务中,例如,颜色分级[35]和色调稳定[27],所提出的基于帧差的方法或其扩展可能是基于光流的方法的良好替代品。使用OFB损耗意味着用户必须了解并正确设置光流量估计管道,这需要在实践中付出巨大的努力。相比之下,C-FDB损失可以应用于新的模型,类似于任何其他用于训练神经网络的损失函数。它不需要耗时的预处理。作者相信,该方法将在视频处理中得到广泛的应用。

论文链接:https://arxiv.org/pdf/2102.05822.pdf

每日坚持论文分享不易,如果喜欢我们的内容,希望可以推荐或者转发给周围的同学。

- END -

交流群

欢迎加入公众号读者群一起和同行交流,目前有SLAM、三维视觉、传感器、自动驾驶、计算摄影、检测、分割、识别、医学影像、GAN、算法竞赛等微信群(以后会逐渐细分),请扫描下面微信号加群,备注:”昵称+学校/公司+研究方向“,例如:”张三 + 上海交大 + 视觉SLAM“。请按照格式备注,否则不予通过。添加成功后会根据研究方向邀请进入相关微信群。请勿在群内发送广告,否则会请出群,谢谢理解~