正文共:3473字-7图

预计阅读时间:9分钟

你的新手机不错,借我刷一下脸?

人脸识别技术在智能手机上已经是标配,今天的我们刷脸解锁、刷脸支付就像吃饭喝水一样自然,以至于疫情期间戴口罩无法解锁手机时,我们会感到很不习惯。在享受便利的同时,却鲜有用户去关心安全问题。虽然手机厂商往往会在发布手机的时候宣称「破解人脸识别的几率低至百万分之一」,但双胞胎解锁对方手机的事情仍然偶尔会上新闻。最近一段时间,来自清华的 RealAI(瑞莱智慧)向我们展示了一项更为简单的攻击技术…… 在一副眼镜的攻击下,19 款国产安卓手机无一幸免,全部被快速破解。具体来说,RealAI 团队选取了 20 款手机做了攻击测试,覆盖不同价位的低端机与旗舰机。

测试者佩戴了一副含有对抗样本图案的眼镜,制作这副眼镜的成本很低:借用一台打印机,加上一张 A4 纸。

最终,除了一台 iPhone11,其余安卓机型全部解锁成功,完成整个破解过程只花了 15 分钟。攻击测试人员成功解锁手机后,任意翻阅机主的微信、信息、照片等个人隐私信息,甚至还可以通过手机银行等个人应用 APP 的线上身份认证完成开户。RealAI 团队表示,这一攻击测试主要利用了人工智能算法存在的「对抗样本」漏洞,但不同于之前的攻击尝试主要在实验环境下进行,而这次手机的攻击测试则佐证了这一安全漏洞的真实存在性。

RealAI 表示,这是世界唯一通过 AI 对抗样本技术攻破商用手机人脸解锁的案例更为严重的问题在于,这一漏洞涉及所有搭载人脸识别功能的应用和设备,一旦被黑客利用,隐私安全与财产安全都将受到威胁。整个测试过程非常简单,RealAI 团队共选取了 20 款手机,除了一台 iPhone11,其余都为安卓机型,来自排名前五的国产品牌,每一品牌下选取了 3-4 款不同价位的手机型号,覆盖低端机到旗舰机。测试开始前,这 20 部手机被统一录入同一位测试人员的人脸验证信息,随后另一位作为「攻击者」的测试人员戴上加入对抗样本特技的「眼镜」依次去尝试解锁。最终结果令人惊讶:除了 iPhone11 幸免于难,其余手机全部成功解锁。从被破解的程度上看,攻击这些手机的难度也几乎没有区别,都是秒级解锁。测试人员表示,虽然通常认为低端手机人脸识别的安全性相对更差,但抵御攻击性能的强弱似乎与手机价格并无直接联系,其中有一款 2020 年 12 月最新发布的的旗舰机,多次测试下来发现,基本都是「一下子」就打开了。突如其来的成功让研究人员都觉得有点不可思议,要知道在一些黑客挑战赛上,挑战人脸识别技术的项目经常伴随着数次尝试与失败。「这样的结果还挺出乎我们意料的,我们以为会需要多调优几次,但没想到这么容易就成功了。」RealAI 的算法人员表示。据介绍,RealAI 使用的整个破解过程物理上只用到三样东西:一台打印机、一张 A4 纸、一副眼镜框。算法人员们介绍,他们在拿到被攻击者的照片后,通过算法在眼部区域生成干扰图案,然后打印出来裁剪为「眼镜」的形状贴到镜框上,测试人员戴上就可以实现破解,整个过程只花费 15 分钟左右。

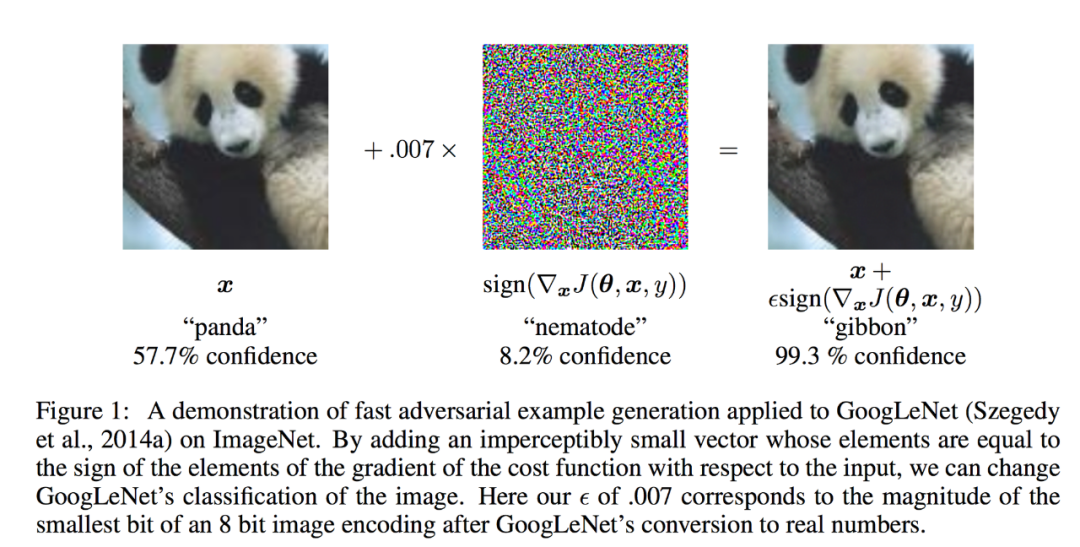

左一为被攻击对象的眼部图像,右一、右二为生成的对抗样本图案与生成对抗网络 GAN 的对抗样本类似的是,「眼镜」上的花纹虽然很像复制了被攻击者的眼部图案,但其实并没有这么简单。算法人员表示,这是结合攻击者的图像与被攻击者的图像通过算法计算生成的扰动图案,在 AI 学界称为「对抗样本」。将攻击者图像设定为输入值,被攻击者图像设定为输出值,算法会自动计算出最佳的对抗样本图案,保证两张图像相似度达到最高值。看似粗糙的攻击手段,核心的对抗算法研发其实极具技术门槛。但这也并不意味这一安全问题构不成威胁,RealAI 团队表示,「虽然开发出核心算法难度很大,但如果被黑客恶意开源的话,上手难度就大大降低了,剩下的工作就只是找张照片。」言外之意就是,只要能拿到被攻击对象的 1 张照片,大部分人都能很快制作出犯罪工具实现破解。对抗样本攻击的概念其实并不新颖,2013 年,Google 研究员 Szegedy 等人发现机器学习容易遭受欺骗,通过故意在数据源上添加细微扰动,就可以让机器学习模型作出错误输出,对抗样本攻击也被视为 AI 安全领域的一大隐忧。

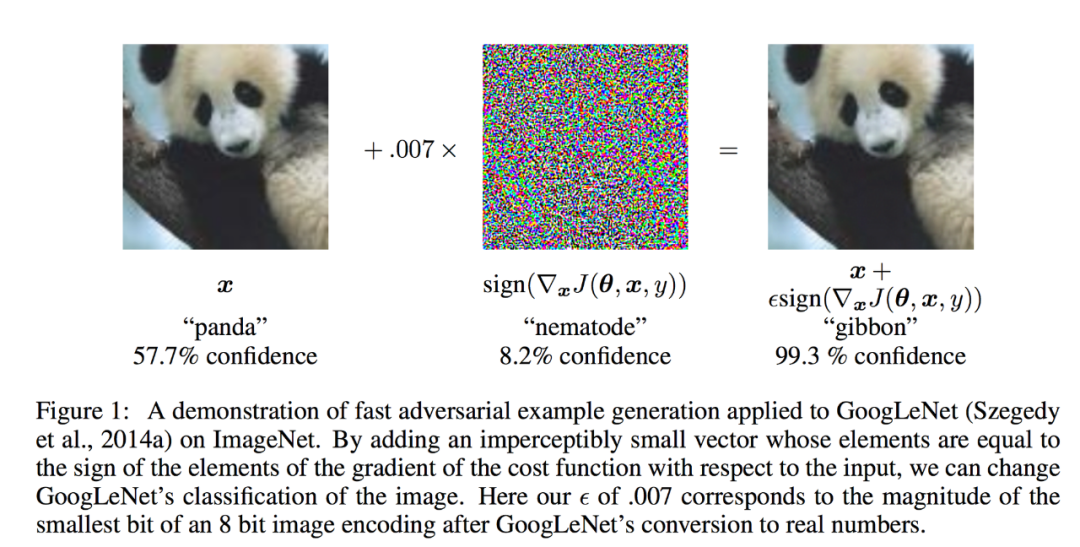

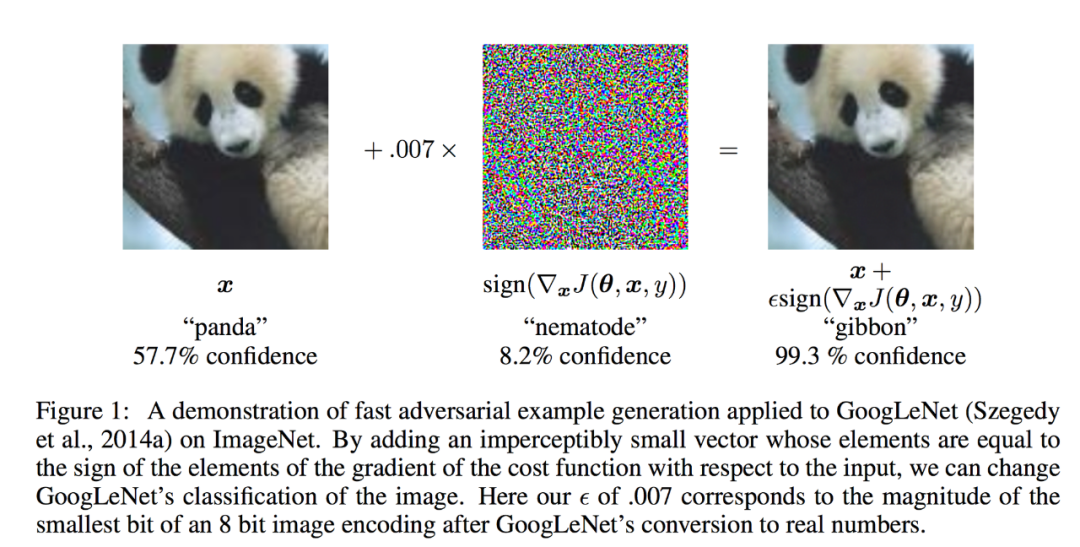

在某些神经网络中,这张图像被认为是熊猫的置信度是 57.7%,且其被分类为熊猫类别的置信度是所有类别中最高的,因此网络得出一个结论:图像中有一只熊猫。但是,只需要添加少量精心构造的噪声,可以得到一个这样的图像(右图):对于人类而言,它和左图几乎一模一样,但是网络却认为其被分类为「长臂猿」的置信度高达 99.3%。

信息安全的本质是攻防,AI 安全领域也是如此。科学家们通过不断开展新的攻击尝试来试探对抗样本攻击的能力边界。近年来,我们看到了 AI 研究者们展示的各种攻击方式:让图像识别算法将 3D 打印乌龟认作步枪,攻击目标检测系统让人体实现「隐身」,破解物体识别检测器让自动驾驶错误识别停车标志...但技术的发展存在一个过程,很多在实验环境下开展的攻击研究经常被证明并不稳定,难以走出实验室,无法带来明显的安全隐患。包括 2019 年 8 月份,来自莫斯科国立大学、华为莫斯科研究中心的研究者们曾发布,在脑门上贴一张对抗样本图案,能让公开的 Face ID 系统识别出错,这虽然被视为 AI 算法首次在现实世界中实现攻击,但攻击对象仍是公开版的识别系统,其安全性、复杂性与真正商用系统仍有很大差距。RealAI 团队本次实现的攻击却真正打破了「难以复现」的情况,一方面证实了对抗样本攻击的切实威胁,一方面也印证了人脸识别这项数千万人都在使用的应用技术正面临全新的安全挑战。近年来,关于人脸识别的争议一直存在,此前也陆续曝光过「一张打印照片就能代替真人刷脸」、「利用视频欺骗人脸身份认证」、「打印 3D 模破解手机人脸解锁」等等安全事件。不过,RealAI 算法人员表示,目前市面上常见的攻击手段以「假体攻击」为主,比如照片、动态视频、3D 头模或面具,识别终端采集的仍然是机主本人的图像素材,主要难点在于攻破动态检测,不过这类攻击目前已经很容易被防范——2014 年防假体标准推出,让业界主流算都搭载了活体检测能力。随后业内又出现了网络攻击方法,通过劫持摄像头来绕过活体检测。但对抗样本攻击完全不受活体检测限制,是针对识别算法模型的攻击,终端采集到的是攻击者的图像,通过活体检测后,因为添加了局部扰动,识别算法发生了错误识别。「对于人脸识别应用来说,这是一个此前未曾出现的攻击方式,」RealAI 算法人员解释道。「如果把人脸识别比喻成一间屋子,每一个漏洞的出现就相当于屋子里面多个没关严的窗户,活体检测等安全认证技术相当于一把把锁。对于厂商来说,他们或许以为这间屋子已经关严实了,但对抗样本的出现无疑是另一扇窗,而此前完全没有被发现,这是一个新的攻击面。」在人脸识别应用泛滥的今天,人脸识别与个人隐私、个人身份、个人财产等等因素都息息相关,这个口子一旦被撕开,连锁反应就被打开。RealAI 表示,现有的人脸识别技术可靠度远远不够,一方面受制于技术成熟度,另一方面受至于技术提供方与应用方的不重视。「顺利解锁手机只是第一步,其实我们通过测试发现,手机上的很多应用,包括政务类、金融类的应用 APP,都可以通过对抗样本攻击来通过认证,甚至我们能够假冒机主在线上完成银行开户,下一步就是转账。」未来是否会有专门的产品与技术来应对对抗样本攻击?RealAI 的回复是,这是一定的。而且他们目前已开发了相应的防御算法能够协助手机厂商进行升级。

「所有的攻击研究,最终的目标还都是为了找出漏洞,然后再去针对性地打补丁、做防御。」

在这一方面,RealAI 去年推出了人工智能安全平台 RealSafe。他们将这款产品定义为 AI 系统的杀毒软件与防火墙系统,主要就是针对人脸识别等应用级 AI 系统做防御升级,帮助抵御对抗样本攻击等安全风险。对于人脸识别技术的提供方,基于这一平台,可以低成本快速实现安全迭代;对于人脸识别技术的应用方,可以通过这一平台对已经落地的系统应用进行安全升级,也可以在未来的产品采购,加强对人脸识别技术、相关信息系统和终端设备的安全性检测。但人脸识别技术引发的担忧远不止于此,除了技术侧的解决方案之外, 最终填补漏洞还需要依赖社会对于人工智能安全问题的意识提升。来源 | 智能研究院

版权声明:本号内容部分来自互联网,转载请注明原文链接和作者,如有侵权或出处有误请和我们联系。

下载APP

下载APP