谷歌发布5620亿参数多模态模型PaLM-E,机器人操控无所不能

大数据文摘授权转载自夕小瑶的卖萌屋

作者:CoCo酱

ChatGPT已经是大模型的天花板了吗?

不!没有做不到,只有想不到。谷歌出手,果然不会让人失望!

谷歌悄悄上线了一个炸弹级模型——足足有5620亿参数!

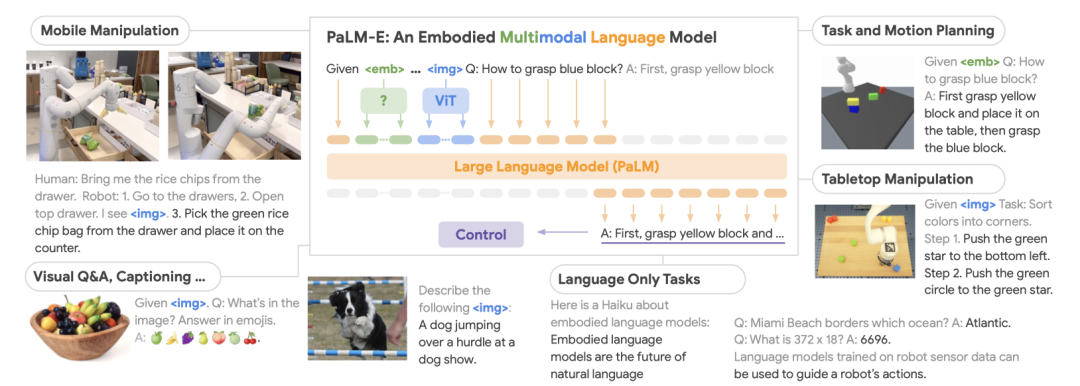

PaLM-E 将真实世界的传感器信号与文本输入相结合,建立语言和感知的链接。

规模最大的模型“PaLM-E-562B”具有562B个参数,将540B的PaLM和22B的ViT集成在一起,这是目前报道的最大的视觉-语言模型。

模型输入包括视觉、连续状态估计值和文本输入。作者在多个任务(包括顺序机器人操作规划、视觉问答和字幕生成)中进行了端到端的训练,并通过评估表明,其模型能够有效地解决各种推理任务,并且在不同的观察模态和多个实体上表现出了积极的转移。该模型在进行机器人任务训练的同时,还具有先进的视觉-语言任务表现,并随着规模的增大保持了通用的语言能力。

论文链接:

https://palm-e.github.io/assets/palm-e.pdf

PaLM-E是一个单一通用的多模态语言模型,可用于感知推理任务、视觉语言任务和语言任务。它将来自视觉语言领域的知识转化为体验推理的知识,从具有复杂动态和物理约束的环境中进行机器人规划,到回答关于可观察世界的问题,都可轻松搞定!

它支持多模态输入,来自任意模态(例如图像、三维表示或状态,绿色和蓝色)的输入插入文本token(橙色)旁边作为LLM的输入,进行端到端的训练。

PaLM-E的主要架构思想:将连续的、可感知的观察数据注入预先训练的语言模型的嵌入空间中,以使其能够理解这些连续数据。这是通过将连续观测数据编码为与语言嵌入空间中的语言标记具有相同维度的向量序列来实现的。这种连续信息以类似于语言标记的方式注入语言模型中。

PaLM-E是一个仅具有解码器的语言模型,可以自动地根据前缀或提示生成文本完成结果。该模型使用预先训练的语言模型PaLM,并将其赋予感知推理的能力。

我们展示了几个示例视频,展示了如何使用PaLM-E在两个不同的真实实体上规划和执行长期任务。请注意,所有这些结果都是使用同一模型在所有数据上训练得出的。在第一个视频中,我们执行了一个长期指令“从抽屉里拿来米饼”,其中包括多个规划步骤,以及整合了机器人摄像头的视觉反馈。

最后,在同一机器人上展示另一个示例,指令是“给我带一个绿色的星星”。绿色的星星是这个机器人没有直接接触过的物品。

在接下来的部分中,我们展示了PaLM-E控制桌面机器人排列方块。

PaLM-E可以基于视觉和语言输入成功地规划多个阶段。它能够成功地规划长期任务“按颜色将方块分类到不同的角落”。还展示了另一个多阶段规划并在长时间范围内整合视觉反馈的示例。最后,演示了另一个长期推动任务的示例。在这个任务中,PaLM-E一步步地将指令序列化到低层策略,例如“将黄色六边形移动到绿色星星”,“将蓝色三角形移动到组中”。

此外,还介绍了两个泛化的示例。在第一个示例中,指令是“将红色方块推到咖啡杯旁边”。数据集中只有三个包含咖啡杯的示范,但其中没有一个包含红色方块。在第二个示例中,指令是“将绿色方块推到乌龟旁边”。机器人能够成功地执行这个任务,尽管它之前从未见过这只乌龟。这两个示例展示了模型对于未曾接触过的物体或指令具有一定的泛化能力。

参考文献:

https://palm-e.github.io/