虚机软中断竟然是可一个CPU使劲造?

了解了软中断对CPU的占用之后,如果你动手操作查看过的话,相信会和我一样会遇到下面这个的问题。

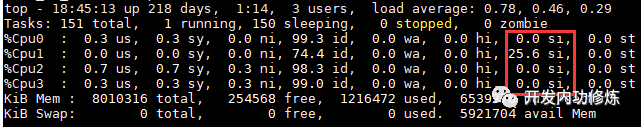

我当时对一台线上虚机查看软中断造成的CPU开销的时候,发现很奇怪,那就是所有的软中断几乎都是被一个CPU处理的。用top看si列,绝大部分都是消耗在CPU1上的,其它CPU只有很少。怎么样,你有没有和我一样感觉到一脸蒙圈呢?

如果没有实际遇到也没关系,你可以用hping命令制造一些网络接收包来观测。

# hping3 -S -p 80 -i 你的服务器ip网卡和内核交互是通过软中断的方式来进行的。既然是中断,那就每个可中断到CPU的设备就都会有一个中断号。来,我们现在虚机上找到软中断对应的中断号(可能需要左右滑动)。

# cat /proc/interruptsCPU0 CPU1 CPU2 CPU327: 351 0 0 280559832 PCI-MSI-edge virtio1-input.028: 1 0 0 0 PCI-MSI-edge virtio1-output.029: 0 0 0 0 PCI-MSI-edge virtio2-config30: 4233459 375136079 244872 474097 PCI-MSI-edge virtio2-input.031: 1 0 0 0 PCI-MSI-edge virtio2-output.0......

其中的virtio1-output.0和virtio1-output.0对应的是虚拟网卡eth0的发送和接收队列。其中断号分别是27和28。virtio2-input.0和virtio2-output.0对应是eth1的发送和接收队列,其中断号分别是30和31。

我们分别查看着几个中断号的cpu亲和性配置:

# cat /proc/irq/27/smp_affinity8# cat /proc/irq/28/smp_affinity1# cat /proc/irq/30/smp_affinity2# cat /proc/irq/31/smp_affinity4

原来虚拟机是通过将不同网卡的不同队列绑定在不同的CPU上来实现软中断均衡的。刚才我们服务器的包都是发送到eth1上的,它的读队列请求特别的多,因此30号“引脚”上的中断也会特别的多。自然和30亲和的2号CPU,也就是CPU1就会出现明显比其它CPU高的软中断了。这下你明白了吧?

其实我们上面看到的中断的亲和性都是由一个叫irqbalance的服务来维护的。通过ps命令可以查看到

# ps -ef | grep irqbroot 29805 1 0 18:57 ? 00:00:00 /usr/sbin/irqbalance --foreground

irqbalance根据系统中断负载的情况,自动维护和迁移各个中断的CPU亲和性,以保持各个CPU之间的中断开销均衡。绑定了亲和性的好处是运行中断的时候CPU缓存L1、L2命中率高。但如果有必要,irqbalance也会自动把中断从一个CPU迁移到另一个CPU上。一般情况下,我们都不需要去手工干涉irqbalance的配置。

如果实在有必要,你可以通过修改这些参数来达到将软中断转移到其它CPU上,但是得先关掉irqbalance。修改方法很简单,直接echo既可。

# service irqbalance stop# echo 2 > /proc/irq/30/smp_affinity

不过我遇到了一个未解的问题,我想把一个中断的亲和性绑到2个CPU上,貌似是不work的。仍然是一个核被打满,另外一个核闲着,没有想明白。如果你有答案,欢迎评论!

在实机上,原理是一样的。不过现在的实机上网卡都是多队列,也就是说eth0可能会有多个读取队列,多个写队列,都可以各自分开配其CPU亲和性。你手头如果有实机的话,可以试一试。