左手技术,右手规范,AI治理需要「价值观」

编辑 | 余快

假设你驾驶的车辆出现意外,你有且只有两种选择:

A:无动于衷,车会直接撞向前方的人群; B:拨动方向盘,但车会撞向另一条路上的人。

你该如何抉择?

功利主义者认为,决策应该遵从“为多数人提供最大利益”原则,即牺牲更少的人,拯救更多的人。

这一观点遭到义务论者的反对,后者认为因救人而杀人,本质属于不道德行为,与人内心的道德命令相悖。

这个被称为电车难题的实验,不论如何选择,人都会陷入「道德困境」之中。

假如把人换成AI呢?

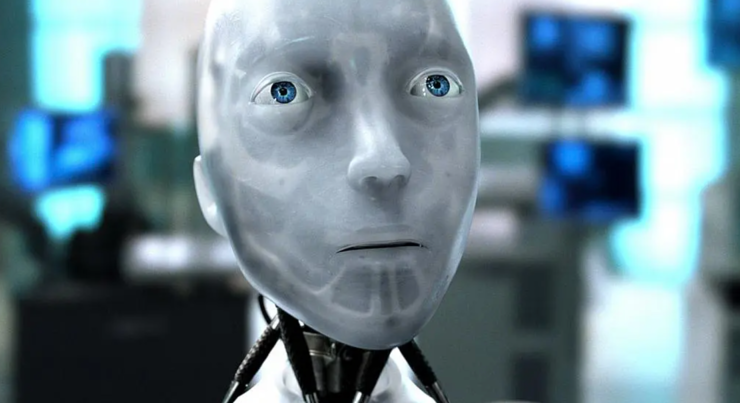

在电影《机械公敌》中,主角戴尔·史普纳曾遭遇一次车祸,前来营救的机器人经过计算,选择了生存率更高的男主,而非另一个小女孩Sarah。实际上,史普纳更希望机器人救小女孩。

电影《机械公敌》剧照

这部剧中,AI并未面临「道德困境」,而是根据其计算出的“生存率”进行施救,但恰恰是这冷冰冰的数字,加深了戴尔·史普纳对机器人(AI)的不信任。

这实际上反映出一个问题:当人们期待更高智能水平的AI时,要不要对AI本身进行法律上的规制,或进行道德约束?假设需要,如何进行规制?

更具体一点,在上述的施救过程中,AI能不能担责?法律责任如何界定?等等,该如何回答?

1

AI的「信任危机」

先来思考一个问题:《机械公敌》中,机器人根据“生存率”救下男主戴尔·史普纳,这个“生存率”是怎么计算的?

这个在剧中看似简单的问题,实际上触摸到了AI的核心难题之一:决策的不可解释性。

性别、年龄、情绪等特征可能是计算生存率的部分数据,但机器人是怎么进行决策的,目前的人工智能系统很难解释。

换句话说,人们知其然而不知其所以然。

以现在非常火热的深度学习为例,其决策场景下的模型可解释性很差,具体表现为:输入特征与输出结果之间存在一个无法观测的“黑箱”空间。

比如,阿尔法狗在与柯洁的对弈中,其每一步都是动态的,谷歌只下达了“赢得比赛”的指令,但阿尔法狗是如何根据柯洁的落子来决定对策从而赢得比赛,人们却无从得知。

这种不可解释性对于非常重要的场景,比如交通、金融、医疗等,是一种巨大的安全隐患。人们无法从人工智能系统决策过程中获取有效信息,进而也无法快速对系统进行优化,避免可能导致的利益损失。

另一个重要的点:机器人在救人过程中是否涉嫌“算法歧视”?也就是人工智能系统的公平性问题。

人工智能算法会受到训练数据的影响,如果训练数据中存在偏见,那么其决策也会形成歧视。

电影里的机器人在面对男女性别差异时,作出的决策有没有偏见,这一点无从得知。但现实生活中,美国芝加哥法院曾采用的犯罪风险评估系统(COMPAS)被证明对黑人存在歧视。

如果一个黑人犯了罪,他被该系统错误地标记为具有高犯罪风险的可能性更大,因此可能会被法官判处更长的刑期。

更为普遍的例子是,人们所熟知的大数据杀熟,实际上是根据用户特征/偏好数据形成的价格歧视。

从经济学角度上讲,价格歧视并非贬义,比如老人小孩乘坐公交车享受比成人更低的价格优惠。

但对于人工智能系统而言,基于数据训练形成的价格歧视,根据用户购买行为、性别等进行分层,从而给新用户以优惠,给老用户「高贵」,这种歧视无法可依,本身影响了「消费者公平」。

除了可解释性、公平性之外,AI的安全性、稳健性等问题也引发人们对AI的信任危机。

安全性表现在AI如何保护数据安全。过去一段时间里,Google、Meta等公司先后被爆出数据泄露问题,引发全球对数据保护的关注,各国也加快了针对隐私、数据保护方面的立法。

稳健性则是指人工智能系统在异常情况下,仍能保持正常运行,而不至于崩溃。例如,现在的智能驾驶都有一套「冗余」方案,目的是防止极端天气、车辆碰撞等场景下,车辆失控的情况。

但目前人工智能系统的稳健性,还有待增强。

基于不可解释性、公平性、安全性、稳定性等问题,AI需要面临的最后一道门槛是:人工智能到底能不能成为责任主体?

也就是说,人工智能因技术缺陷带来的不良后果,谁来背锅?软件开发商还是所有者?

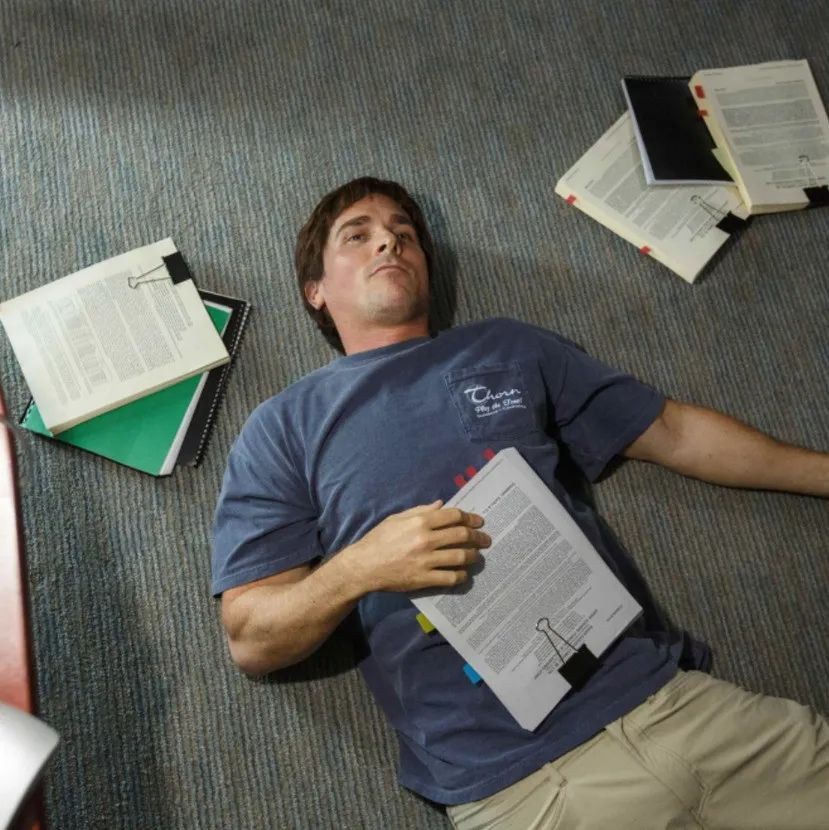

《机械公敌》中,机器人桑尼杀死了自己的“父亲”朗宁博士,真相大白以后主角史普纳警官却没有对桑尼提起诉讼,因为桑尼并非人类,处于人类法律的界限之外。

电影《机械公敌》剧照

上述的问题实际上造成了普通大众对于人工智能的「信任危机」,然而直到现在,尚且没有一部成型的法律来对人工智能进行规制。

不过,从学界、产业界以及政府等多方的实践之中,仍能看到有益的探索。

2

AI治理需要什么样的「价值观」?

《机械公敌》里对机器人设置了三大法则:

1、机器人不得伤害人类个体,或者目睹人类个体将遭受危险而袖手不管; 2、机器人必须服从人给予它的命令,当该命令与第一定律冲突时例外;

3、机器人在不违反第一、第二定律的情况下要尽可能保护自己的生存。

这三条法则相互制约,但从规则内容不难看出,「以人为本」是其根本精神。

这种精神从AI诞生元年就已经存在,然而在漫长的AI发展年轮中,技术探索始终占据着主流,对AI的审视与反思,主要是近十年来的结果。

究其原因,是技术从实验室或者小规模应用场景,走向了大规模落地场景;人们对AI的认知也在逐渐深化,从“不可置信”到怀疑,再到建立信任,是一个螺旋式上升的过程。

雷峰网了解到,对于人工智能的规范性研究,主要以2015年为爆发点。

2015年1月,欧盟议会法律事务委员会(JURI)决定成立专门小组,研究机器人和人工智能发展相关的法律问题。同年,联合国教科文组织开启关于机器人伦理方面的研究。

此后的几年时间里,联合国、欧盟、电气和电子工程师协会(IEEE)等国际性组织先后开启关于人工智能伦理方面的研究工作,并且发布了相应的伦理准则。其中,影响较为广泛的是2017年的“阿西洛马人工智能原则”和IEEE倡议的人工智能伦理标准。

我国于2018年1月成立了“人工智能标准化总体组”,并发布《人工智能标准化白皮书2018》,论述了人工智能的安全、伦理、隐私等问题,并设定了相应的伦理要求和共识原则。

可以看出,自2015年以来,不论是国家级别的顶层设计,还是专业组织的呼吁倡议,人工智能的研究主要集中在伦理方面。

但这些伦理准则在实操过程中却面临执行困难问题,其根本原因在于,伦理准则属于“软性约束”,缺少相配套的落地机制,比如法律监管、行业约束等等,容易形成道德漂白(ethics washing)。

因而,在伦理准则的基础上,学术界开始了「可信AI」的讨论与探索。

所谓「可信AI」,根据中国信通院发布的《可信人工智能白皮书》的定义,可以理解为一种方法论,即“从技术和工程实践的角度,落实伦理治理要求。”

国内关于可信AI的讨论最早可追溯至2017年香山科学会议,由何积丰院士提出的“人工智能技术应该具备可信的品质。”并从学术研究角度,将可信AI的研究范围放在安全性、公平性、可解释性、隐私保护等方面。

国际上对于可信AI的研究在近几年也呈爆发趋势,2020年关于可信AI的研究论文比2017年增长近5倍,国际先进人工智能协会(AAAI)连续数年举办了 Explainable AI 研讨会。

学术界的影响也蔓延至政府,后者开始在人工智能伦理准则之上,强调“治理”。

2020年,欧盟发布《人工智能白皮书》,提出人工智能“可信生态系统”,对高风险人工智能系统提出强制性监管要求;同年,美国也发布了《促进政府使用可信人工智能》的行政命令。

我国在可信AI方面,先后发布了《国家新一代人工智能标准体系建设指南》《新一代人工智能伦理规范》等文件。

综合人工智能伦理规范和可信AI相关的学术研究和行政文件,可以总结出,当前的AI治理「价值观」体现在“以人为本,AI向善”,具体则表现为公平(无歧视)、透明(可解释)、无害(不作恶)等等。

而在这种价值观的指引下,作为AI落地的实际推动者,产业界也开始了关于AI治理的探索之路。

3

AI治理「方法论」

对于治理人工智能发展出现的的各种问题,企业作为直接相关方,起着不可或缺的作用。

一方面,在市场经济大环境下,需求对供给的反向作用非常明显,大众对于人工智能安全隐患的担忧,实际上影响着企业的生存空间。

作为技术/产品供应商,企业倘若不能深刻理解市场需求,只关注技术而忽略市场,必然遭遇获取用户信任的滑铁卢,导致失去市场。

另一方面,企业作为整个经济活动中的一份子,必然要遵循「市场法则」(法律法规),在追求经济效益的同时,强化社会责任(Corporate social responsibility)。

因此,国内外诸多互联网、AI公司先后加入了对AI治理的探索,国外如微软、亚马逊,国内如腾讯、京东、旷视等等。

雷峰网发现,目前多数公司的AI治理主要分三个方面:顶层设计、内部管理、技术攻关。

以人工智能公司旷视为例:

在顶层设计方面,2019年7月,旷视公布了基于企业自身管理标准的《人工智能应用准则》,从正当性、人的监督、技术可靠性和安全性、公平和多样性、问责和及时修正、数据安全与隐私保护六个维度,对人工智能正确有序发展作出明确规范。

与此同时,旷视还参加了多个国家及行业规范标准制定,例如《新一代人工智能治理原则》、《新一代人工智能伦理规范》等,并成为国内率先通过隐私保护国际标准ISO/IEC 27701的人工智能企业。

在内部管理上,旷视主要从企业制度和架构两方面进行管理。

架构:2019年8月,作为业内首个成立“人工智能道德委员会”的AI公司,旷视聚焦于研讨、制定公司相关伦理道德治理的规章与管理机制,并对公司业务中涉及到的重大伦理问题进行决议;

2020年1月,旷视又成立AI治理研究院,旨在联合国内顶尖研究机构,积极探索AI道德伦理与治理工作的落地路径。

制度:除了发布《人工智能应用准则》这类纲领性文件,旷视还出台了《数据分类分级管理规范》、《员工信息安全守则》等细则,在内部形成规范化管理。

与此同时,旷视倡导客户遵循《数据安全声明》、《正确使用人工智能产品倡议书》,形成行业「合力」。

对于技术攻关,旷视目前主要集中在数据安全和隐私保护、算法的安全性、稳健性等问题。

例如,旷视研发的前端图像脱敏方案,是目前业内率先实现在采集端就能完成人脸图像的不可逆脱敏,来加强个人信息保护。

而在AI基础平台研发上,旷视主张通过研发面向数据安全和隐私保护的AI平台,实现从需求提出到交付的全流程一体化数据安全及隐私保护,相关成果将进行试点推广。

值得一提的是,旷视还联合人民智库、中国人工智能产业发展联盟等专业机构、组织,发布“全球十大人工智能治理事件”评选榜单,以议题设置的方式,联动各方对AI治理进行持续关注与深度讨论,通过多元交流,共同推动AI治理走向规范化。

目前,该榜单已持续三届,针对2021年度全球十大人工智能治理事件,来自不同领域的专家表达了类似的观点。

中国信息通信研究院副总工程师、中国人工智能产业发展联盟副秘书长王爱华认为,2021年是全球人工智能治理极具实质性突破的一年,纵观全年的治理事件,全球人工智能治理呈现出“趋实、趋严、趋细”三大特点。

清华大学公共管理学院教授、人工智能国际治理研究院副院长梁正同样表示,人工智能治理已经成为全球共识,且已从理念层面进入到建章立制、落地实施的阶段。

从旷视的人工智能治理探索中不难发现,多数企业采取的是自上而下的方式,即建立规章制度,先保证企业自身的技术、制度合规性,再通过企业实践和行业研讨来共识产业方向。

而在当下的人工智能治理中,自下而上的基于应用主体和用户选择的参与,也成为人工智能治理的一个重要方法。

需要指明的是,当前的AI治理仍然处于探索期,如何引导人工智能进一步规范发展,仍有待市场经济环境下,供给、需求、监管等多方在「磨合」后,达成「共识」。

正如旷视联合创始人兼CEO印奇所言:“AI不仅要在技术创新和应用落地上下功夫,也需在治理上使力气,这离不开所有AI从业者和社会各界的共同努力。”

4

结语

回到最初的「电车难题」,在这个场景中,人不得不面临道德困境,AI或许能破解这个困局。但随之而来的AI治理相关的难点,又成为AI发展过程中必须要回答的问题。

如今,AI行业在多方的努力下已迈出实质性的一步:在规范中发展,在发展中规范。

在正确「价值观」的引导下,作为改变世界的技术,人工智能也将快速走进日常生活,造福大众。

END

粤康码「崩溃」的90分钟

辛巴薇娅那些事儿

大公司该不该砍掉IT部?