谷歌用AI研发「乒乓球机器人」,4分钟对拉300多次,还能指哪打哪!

大数据文摘转载自机器人大讲堂

一个人怎么练习乒乓球?或许这事你可以问问谷歌。

最近,谷歌又玩新花样,这回是乒乓球机器人AI 项目,号称和人类对战时能够连续接球340次?!

要知道,让解说员激动到破音的「乒乓球史上最疯狂一球」——许昕和朱霖峰超级对拉名场面也就止步于 42 板。

在乒乓球比赛中,首要的就是速度和精度,这对学习算法提出了很高的要求。同时,这项运动具有高度结构化(具有固定的、可预测的环境)和多智能体协作(机器人可以与人类或其他机器人一起对打)两大特点,使其成为研究人机交互和强化学习问题的理想实验平台。

谷歌的机器人团队就建了这样一个平台来研究机器人在多人、动态和互动环境中学习所产生的问题,分别是Iterative-Sim2Real(简称i-S2R)和GoalsEye。

利用模拟器与人类合作进行游戏

i-S2R作为一种打造 AI 的方式,目的在于打造一套可应对人类快速且不可预测行为的机器人系统,借助虚拟或模拟的环境,来训练机器学习模型,再从模型运用知识到真实世界中,这样可以大幅缩短训练时间。

虽然这握拍姿势略显僵硬,但接球可是稳得一批,你来我往配合的还挺有模有样~

其实在此之前就已经有乒乓球机器人的身影,比如和邓亚萍老师对阵的“庞伯特”,面对邓亚萍老师的高速球、弧圈球,它都能够及时调整自己的策略,灵活变化的同时它还能找到一些致胜点,引来邓亚萍老师赞叹连连。

那么谷歌这次推出的“乒乓球机器人”是如何精准学习人类行为的呢?

学习人类行为模型:破解“先有鸡还是先有蛋”

让机器人精准学习人类行为模型可没那么容易。

首先,想要让机器人学会与人类互动,就需要有人类的行为模型;然而,想建立人类的行为模型,就需要人类先与机器人进行互动。

为了搞清楚这个“蛋鸡难题”,i-S2R 使用人类行为的简单模型作为近似起点,并在模拟训练和现实世界部署之间交替进行。在每次迭代中,人类行为模型和策略都会被细化。

虽然一开始AI的学习情况并不咋地,但随着人机对战次数和AI收集到的数据成正比增加,其准确性也自然随之upup↑↑↑

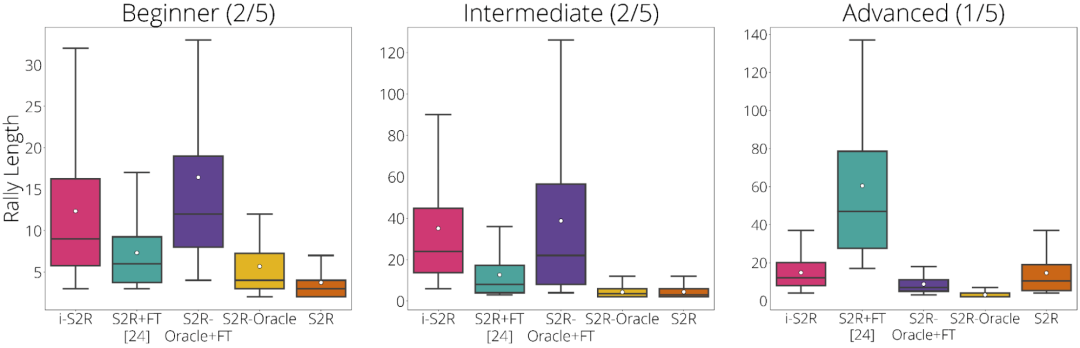

为了评估 i-S2R谷歌搞了个实验,他们把玩家类型进行了细分:初学者(占 40% 的玩家)、中级(占 40% 的玩家)和高级(占 20% 的玩家)。

按玩家类型划分的 i-S2R 结果

实验结果显示,对于初学者和中级玩家(占 80% 的玩家),i-S2R 的表现都明显优于 S2R+FT(sim-to-real plus fine-tuning)。

除了i-Sim2Real这种模拟与现实交替进行的方法,谷歌还公布了只使用现实的数据学习的方法,即GoalsEye项目。

GoalsEye目标:“指哪打哪”

GoalsEye结合了行为克隆技术(behavior cloning techniques)来学习精确的目标定位策略。

粗暴地来说就是:打准就完了。

研发团队为实现机器人精准的效果,他们还采用了 LFP(Learning from Play)、GCSL(Goal-Conditioned Supervised Learning)。

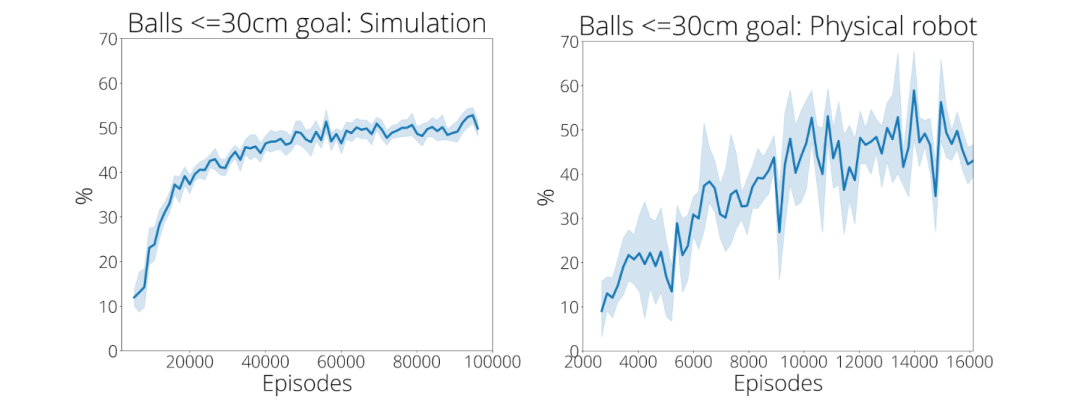

在最初的 2480 次演示中,谷歌的训练策略仅在 9% 的时间内准确地击中半径为 30 厘米的圆形目标。在经过了大约 13500 次演示后,小球达到目标的准确率上升到 43%(右下图)。

看到这里,俺只想期待一下子让这个机器人和咱们的乒乓男团一决高下。

不过很遗憾,谷歌表示,“乒乓球机器人”只是为了AI与人类的“合作”,并非为了击败人类。

不过,谷歌还是留下了一丝悬念,他们补充道,“以AI成长的速度来看,它将很快成为专业选手。”

话不多说,关于这两个项目的更多介绍,请小伙伴们自行采摘:

Iterative-Sim2Real 主页:https://sites.google.com/view/is2r

GoalsEye 主页:https://sites.google.com/view/goals-eye

点「在看」的人都变好看了哦!

点「在看」的人都变好看了哦!