1小时学会走路,10分钟学会翻身!世界模型让新生机器狗掌握多项技能

大数据文摘转载自机器人大讲堂

人类宝宝在出生后的第1年里,就会逐渐掌握协调能力,学习坐、立、翻滚和爬行。

那么机器人呢?

机器人能完成多复杂的任务,取决于它的学习能力。在最近的一项研究中,来自UC伯克利大学的的研发人员利用“ Dreamer” 世界模型的最新成果训练了各种机器人:无需模拟器或示范学习,就能实现现实世界中的在线强化学习。

正在学习走路的机械狗

开始走的像模像样了!

起身也贼6!

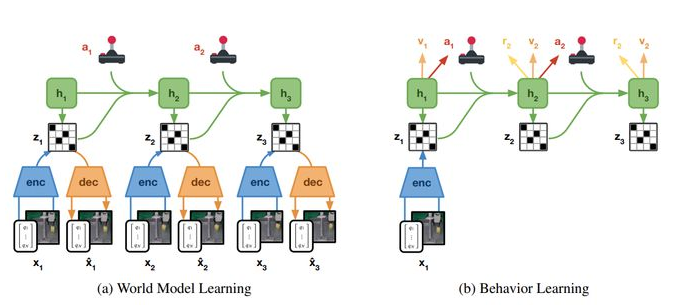

运用了“想象力”的Dreamer

早在2019年,谷歌DeepMind和多伦多大学的研究人员就在NeurIPS 2019会议上介绍了AI “Dreamer”,它可以通过已知世界模型在新环境中对视觉图像的运动方式进行预测。Dreamer在观察到图像运动方式时,会先构想出一些可能的动作,然后判断这些构想动作可能得到的奖励,根据奖励来最终预测动作。

基于谷歌提出的这种可扩展的强化学习方法。在此次研究中,团队的目标是在现实世界中推动机器人学习的极限,并提供一个强大的平台来支持未来的工作。

除了教四足机器人翻身、站立并在 1 小时内学会行走,团队还把 Dreamer 应用于其他3个机器人。

比如这个机械臂,在经过8-10小时抓取学习后,表现接近于人类水平;

这个有计算机视觉的小机器人,通过学习摸索2小时后,可以“顺滑”的滚动到指定地点。

研发团队还公开发布了所有实验的软件基础架构,感兴趣的小伙伴们可以移步开源地址↓↓↓

总的来说,World Model就是一个智能体模型。它包括一个视觉感知组件,能将看到的图像压缩成一个低维的表征向量作为模型输入,同时还有一个记忆组件,可以基于历史信息,对未来的表征向量做出预测。最后还包括一个决策组件,它能基于视觉感知组件、决策组件的表征向量,决定采取怎样的动作。

三个紧密协作的组件:视觉 (V)、记忆 (M) 和控制器 (C)

世界模型作为一个学习预测环境动态的深度神经网络,我们不难发现,这是一个经验积累到动作输出的过程。

此次,研发人员们主要解决了机器人学习、训练中的两项难题:效率和准确率。

以往训练机器人的常规方法是强化学习,通过反复实验来调整机器人的运作,但这种方法往往需要反复不断的测试才能达到满意的效果,在效率和训练的成本上显得有些差强人意。

通过此次研发团队的成果进展,在训练机械狗的过程来看,效率有了明显的提升。

在训练机械臂学习的过程中,这一新成果还克服了视觉定位和稀疏奖励的挑战,训练成果明显优于其他方法。

研发团队大揭秘

此次研发项目中的一位核心成员十分令人瞩目,他就是AI 大牛吴恩达的学生、机器人学习专家、UC 伯克利教授 Pieter Abbeel 。在今年4月,他还摘得了最新一届 ACM 计算奖的荣誉,以表彰他在机器人学习方面的贡献,包括从演示中学习和用于机器人控制的深度强化学习。

Pieter Abbeel 现为加州大学伯克利分校计算机科学与电气工程教授,也是人工智能机器人公司 Covariant 的联合创始人、总裁兼首席科学家。Abbeel 在比利时鲁汶大学获得电气工程学士学位,并在斯坦福大学获得计算机科学硕士和博士学位。

Pieter Abbeel和老师吴恩达

Pieter Abbeel和老师吴恩达

不愧是AI 大牛的开山大弟子,让人看了都直呼优秀!

另一位 Ken Goldberg,也是 AI 领域的顶级专家。

他现在是 UC 伯克利工程教授,研究方向为强化学习、人机交互等。其卓越的科研成就使其被公认为美国人工智能领域的重量级专家。他教授研发出多种让他享有盛誉的网络化遥控科研产品,由他主导的自动化领域研究共获六项美国专利并荣获诸多国家级科学大奖。

此外,Philipp Wu、Alejandro Escontrela、Danijar Hafner 三人为共同一作。其中 Philipp Wu 还只是 UC 伯克利一位大四的学生。

论文地址:

https://danijar.com/project/daydreamer/