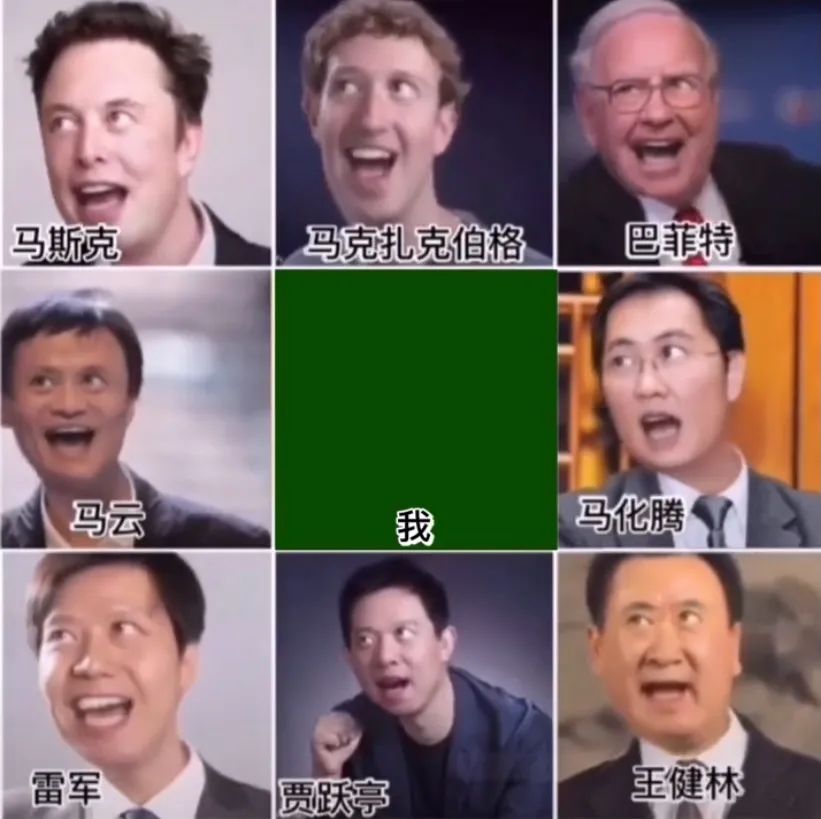

这款 App 火遍全网,马云和马斯克齐唱“蚂蚁呀嘿”?

又一款 App 火遍全网,它能让包括马化腾、马云、马斯克在内的名人“齐唱一曲”,并配有生动的表情,可以说相当魔性。

这款 App 名叫 Avatarify,已经连续好几天登顶中国区 App Store 免费榜。

事实上,Avatarify 并不是一款新推出的应用。据了解,Avatarify 的创作者是一位开发人员,最初是因为 2020 年疫情期间开视频会议时觉得无聊,于是在去年 4 月左右做了这么一个换脸开源项目。

当时该项目也登上了 GitHub 热榜。据项目作者 Ali Aliev 介绍,Avatarify 使用了当年 3 月份一篇 arXiv 论文的方法“First Order Motion”,无需事先对目标图像进行任何训练,就能用另一个人的视频来替换自己的图像。在使用 Avatarify 时,会借助 deepfake 等技术,在想要交换的脸部图像上对算法进行训练。一般来说需要几张你想要用的那个人的图像,在目标图像的相似类别上训练算法即可,该模型也支持实时换脸操作。

项目地址:https://github.com/alievk/avatarify

几个月后,开发者将它做成了 App。直到最近,这款 App 才突然在中国火了起来。

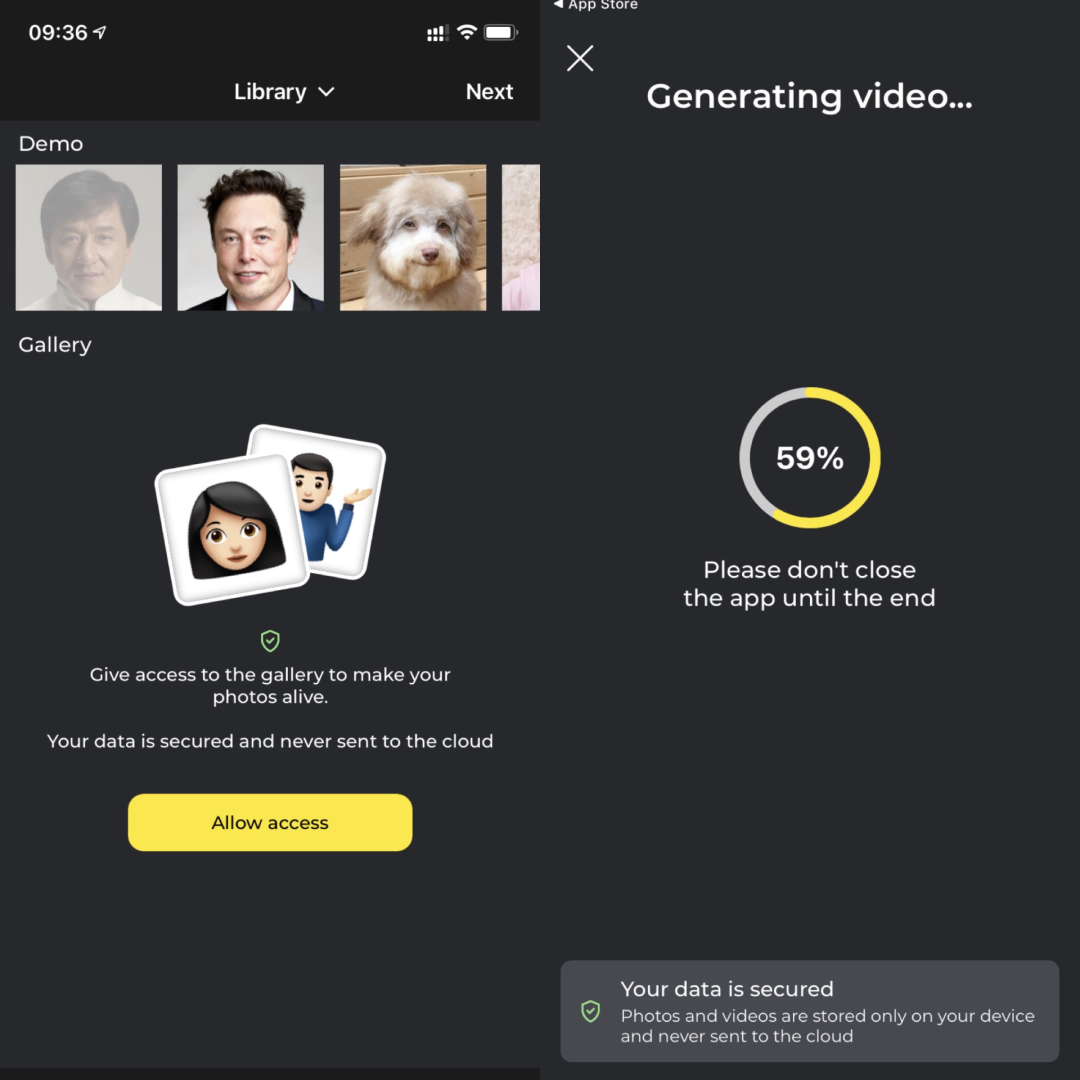

Avatarify 的玩法很简单:只需导入手机中的图像或实时拍一张照片,然后在 Avatarify 的素材库中选择需要使用的模版,选择 24fps 或 12fps 的帧率后,就能够一键生成 Gif 动图。

Deepfake 换脸并不是新鲜概念,比如曾经昙花一现的“ZAO”,还有 FaceApp、Reface 等等都是基于 Deepfake 的应用,并且不少修图 App 现今都具备类似功能。

这次 Avatarify 的爆火或许跟“蚂蚁呀嘿”模版的魔性有关,洗脑 BGM 和随 BGM 实时匹配的五官表情,确实挺让人“上头”。

除了纯娱乐目的,最近还有公司推出了以“深度怀旧”(deep nostalgia)为题的功能,可以将亲人的照片加工,哪怕只有一张,也可以做成一段视频,视频中的亲人可以向他们微笑、点头和眨眼。这是近日由 MyHeritage,一家供用户研究家谱的网站所推出的新功能。

该功能由 MyHeritage 与以色列计算机视觉公司 D-ID 合作开发,D-ID CEO Gil Perry 表示,人们现在可以“以过去绝对想象不到的方式来感知自己家遥远过去的祖先”。他还表示,让昔日人物重现是一个人们越来越感兴趣的领域。

“在合成媒体领域,我们自认为是好人,为了崇高的目的使用这项技术。”Gil Perry 表示,D-ID 对选择什么公司合作有严格的准则,而且其视频上打有水印,显示这些视频为人工合成。

需要注意的是,AI 换脸系列软件在供大众娱乐的同时,如果涉及使用名人肖像,且存在商业用途则使用者将要承担法律风险。比如此前日本有人在网上搜集公开的女明星 DeepFake 假视频,并从中挑出比较有人气的放在自己经营的免费猥亵视频站,收取高额广告费用,虽然视频不是他做的,但此举同样会被当地警方已以名誉侵权罪起诉。

另一方面,提起“ZAO”,有些用户或许还记得它当时引起的隐私安全问题。推出之时,其用户协议、隐私政策和版权说明的相关规定,被指有过滥收集用户信息和侵犯版权的嫌疑。不友好的用户协议更使得该应用一夜之间从刷屏变成遭万人指责。

当时“ZAO”的一条授权协议指出:用户上传发布内容后,即意味着同意授予 ZAO 及其关联公司以及 ZAO 用户在“全球范围内完全免费、不可撤销、永久、可转授权和可再许可的权利”,“包括但不限于可以对用户内容进行全部或部分的修改与编辑(如将短视频中的人脸或者声音换成另一个人的人脸或者声音等)以及对修改前后的用户内容进行信息网络传播以及《著作权法》规定的由著作权人享有的全部著作财产权利及邻接权利”。因安全性存疑,该用户协议被发现后立刻引发争议,虽然 ZAO 后来悄悄修改了其用户协议,以回应用户对其隐私泄露的质疑,但仍未能消除用户对它的担忧。

InfoQ 留意到,Avatarify 应用内有多处关于数据安全的提醒,并强调用户的照片和视频都不会上传到云端。

对于 Deepfake 引发假消息和假新闻泛滥的可能性,也是让人担忧的问题。

当 Deepfake 在 2017 年首次流行起来时,它绝大多数被用于在互联网论坛上生成名人的假色情作品。即使在 2019 年,根据 Sensity 的调查,96% 的公开发布的 Deepfake 内容都是色情相关。

除了色情作品外,各种各样的网络创作者还将 Deepfake 应用于其他形式的媒体,比如电影片段,个人不断制作病毒式传播的视频,并将视频中的演员面孔替换成其他影星。

而只要有一个 Deepfake 视频在网上引起关注,就会有许多人发表评论说,他们担心有人利用 Deepfake 来影响政治以达到邪恶目的。因为在信息时代,人们很容易就可以在互联网上散布政敌的虚假新闻,而这些虚假新闻可以蒙骗观众。

不过计算机视觉工程师 Eric Hofesmann 认为,虽然未来的媒体内容里,Deepfake 可能会产生可怕的错误信息。然而目前的技术还处于比较初级的阶段,高质量的 Deepfake 仍需要大量的人工操作。而随着 Deepfake 的改进,应对 Deepfake 的方法和算法也在不断完善。至少在目前,更令人担忧的是通过人工编辑的图片和视频来传播错误信息。

麻省理工学院研究员 Matt Groh 认为,如果你认为你可能看到的是 Deepfake 内容,那么你应该特别仔细地观察几点:

脸部:脸部的某些部位是否出现了“毛刺”?当他们说话时,他们的眉毛和面部肌肉是否会动?他们的头发看起来是否自然地垂下?

音频:音频和人脸上的表情是否匹配?音频中有没有怪异的剪辑或跳跃,听起来不自然?

光线:视频中是否有部分光线与场景其他部分不匹配?在眼镜之类的东西上看到反光了吗?

end

@程序员,这笔钱下个月可以领!

微信终于可以免费提现了!