全球排名第一的网站,比暗网还黄暴

前段时间,Facebook被指控:用自己的算法为毒贩和人贩子提供便利。

这个事情,还得从一个叫弗朗西斯・豪根(Frances Haugen)的人说起。

她曾任职谷歌、Yelp(美国版大众点评)等企业的算法工程师。

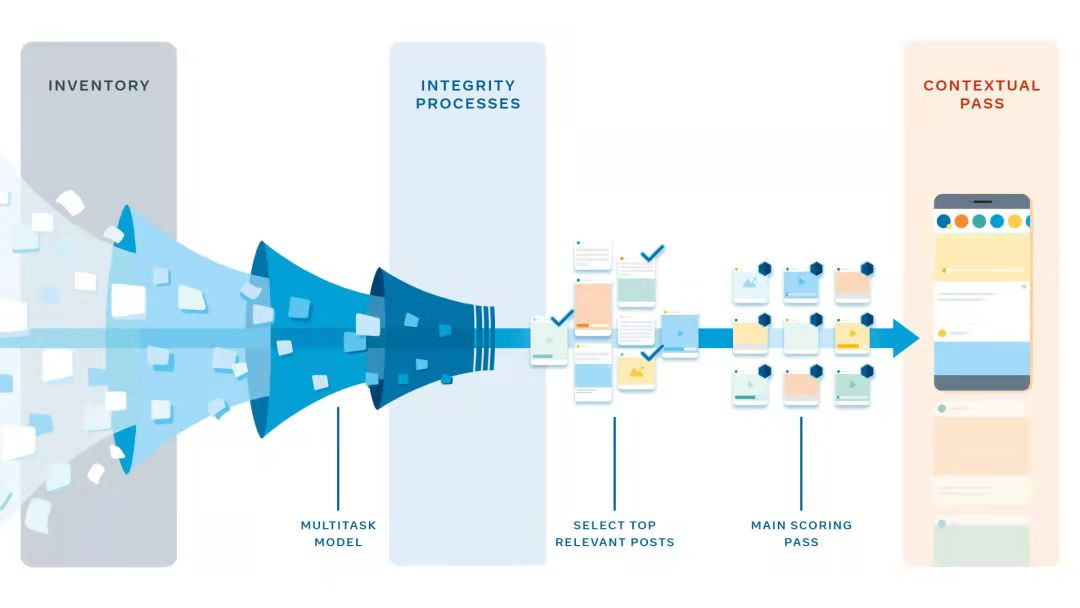

后来入职为Facebook的员工,任公民诚信项目经理,工作就是净化Facebook的社区环境,打击平台上的一些假新闻和假消息。

但是在工作了一段时间之后,豪根发现Facebook做这个项目的原因有蹊跷。

按照她所在部门的职责,她完全有权力撤下Facebook上一些不健康的内容。但是很多情况下,Facebook出于营收的考虑,经常否决她的想法。

而在前段时间,豪根所在的部门甚至被整个裁撤,她选择向媒体公开了,大量揭露Facbook不作为的文件,包括贩毒、人口贩卖走私的内容。

之后,豪根在美国60 Minutes节目上揭露了Facebook更多的内部运作机制,并与《华尔街日报》分享了大量内部文件。

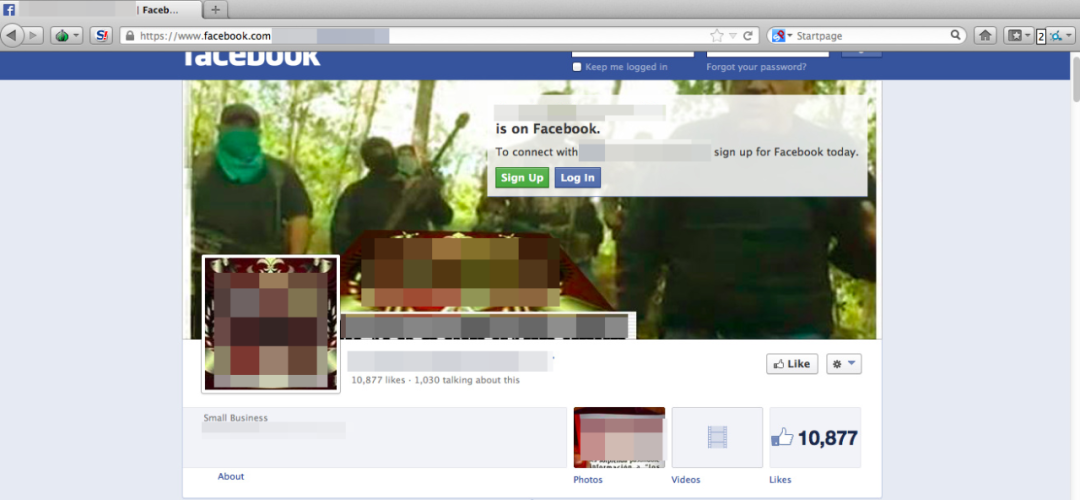

首先是墨西哥黑帮卡特尔在Facebook上,招募杀手进行培训。

他们有专门的页面展示自家的日常的奢靡生活,并以此来吸引同伙加入。

除此之外,还发布了很多暴力血腥的内容。

而这些内容竟然在Facebook上整整存在了五个月,经过员工多次反映才将这些内容下架。

还有在中东地区,还有团伙利用Facebook广告为诱饵,欺骗并控制女性从事非法行为,甚至是人口贩卖。

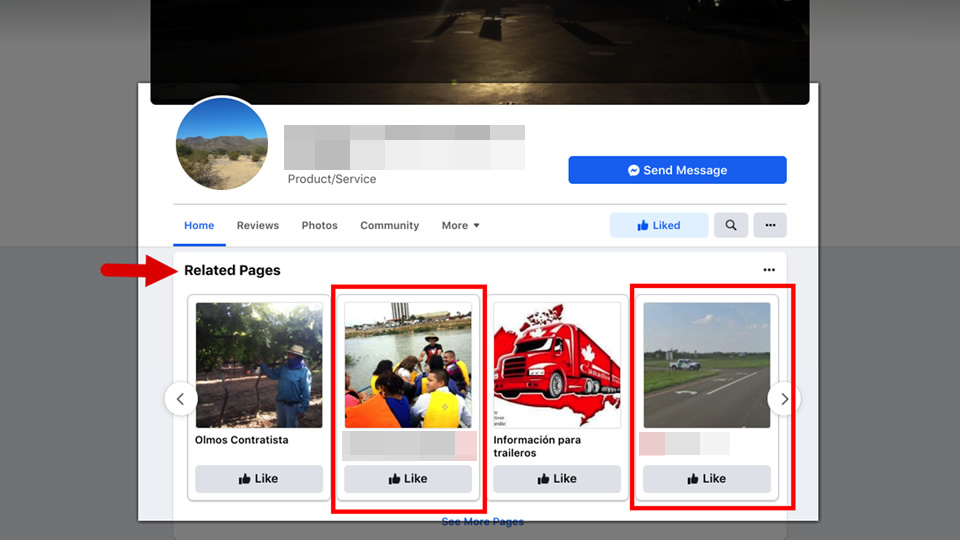

就连在美国,也有各种各样的边境偷渡团伙,依靠Facebook来开拓业务。

而这些违法暴力内容,豪根部门向公司提出处理后,得到的回复都是理由不充分。

当然Facebook确实很难时刻盯着这些团体开设账号宣传,大家只能够要求它尽到维护网络环境的责任。

只要这些内容无法传播,或者及时删除,那么完全能够把危害降到最低。

但是,Facebook的算法机制却为这些内容加大了扩散范围。只要你点赞过或者浏览过相关内容,Facebook就会把这些内容一股脑地推荐给你。

就算你没有关注过此类视频,如果你的好友或者群组成员有点赞过这些内容,在算法里,你也成了喜欢这些内容的一员。

这也就意味着,如果不完全端掉所有违法犯罪团伙的页面,它们还是能借助Facebook死灰复燃。

不法分子抓住了算法机制,就算内容没有过高的点赞量,水军迅速渗透到各个群组,点赞该内容。

除非你把好友全部删除,退出所有群组,代价非常大。

除了用自己的算法为不法分子提供便利之外,Facebook还采用了放大仇恨论言论的算法。

豪根在节目中表示:Facebook为了提高用户的参与度,发现最好的参与方式便是向用户灌输恐惧和憎恨。因为激发人们的愤怒比激发其他情绪要容易得多。

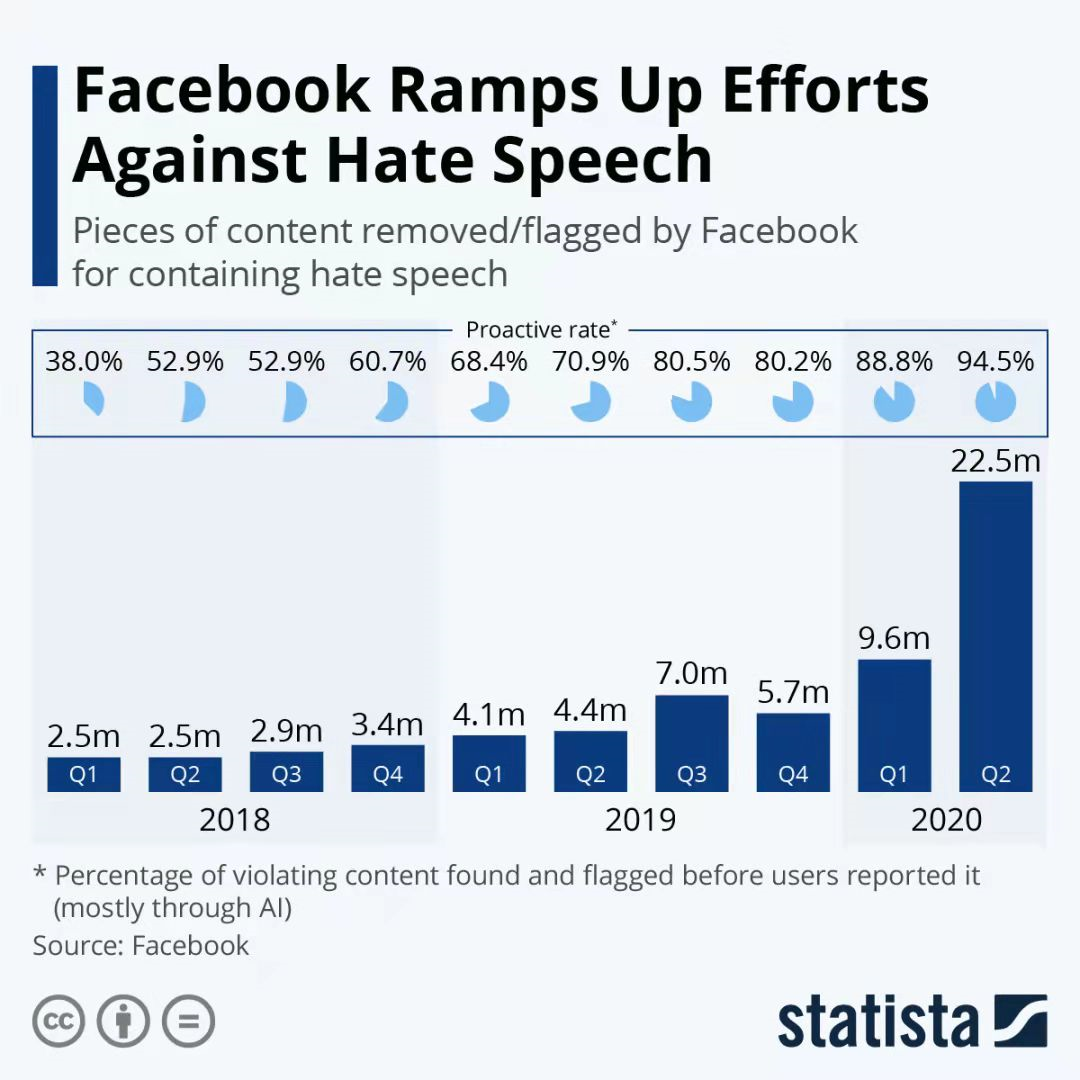

这让脸书公布的一项Facebook致力于反对仇恨言论所做的努力的数据,看起来更像一个笑话。