看这一头蓬松的秀发,加上帅气的动作,你以为是在绿幕前拍大片?不信有这么丝滑?我们用线上Demo亲自尝试了一波。相比之下,现在在线会议软件里的抠图,一旦头发遮住脸,人就会消失……你也可以上手一试

目前,RVM已经在GitHub上开源,并给出了两种试玩途径:不过我们也发现,如果视频的背景较暗,就会影响RVM的发挥。比如在这种背景光线昏暗的情况下,抠图的效果就非常不尽人意了。所以,如果你想自己拍视频试玩,就一定要选择光线充足的场景。

利用时间信息

那么这样的“魔法”,具体又是如何实现的?

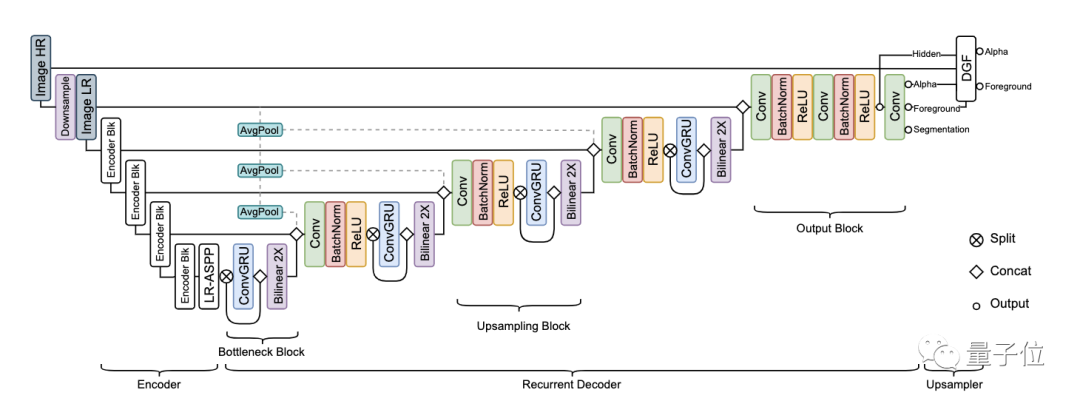

实际上,有关视频抠图的算法如今已不鲜见,其中大多数采用的是将视频中的每一帧作为独立图像来实现抠图的方法。不同与此,在这篇论文中,研究人员构建了一个循环架构,利用上了视频的时间信息,在时间一致性和抠图质量上取得了明显改进。其中,循环机制的引入使得AI能够在连续的视频流中自我学习,从而了解到哪些信息需要保留,哪些信息可以遗忘掉。具体而言,循环解码器采用了多尺度ConvGRU来聚合时间信息。其定义如下:在这个编码器-解码器网络中,AI会完成对高分辨率视频的下采样,然后再使用DGF对结果进行上采样。除此之外,研究人员还提出了一种新的训练策略:同时使用抠图和语义分割目标数据集来训练网络。首先,人像抠图与人像分割任务密切相关,AI必须学会从语义上理解场景,才能在定位人物主体方面具备鲁棒性。其次,现有的大部分抠图数据集只提供真实的alpha通道和前景信息,所以必须对背景图像进行合成。但前景和背景的光照往往不同,这就影响了合成的效果。语义分割数据集的引入可以有效防止过拟合。

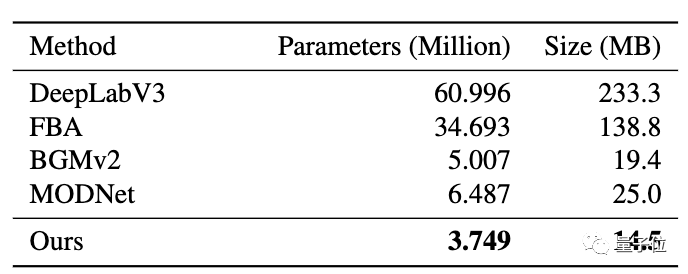

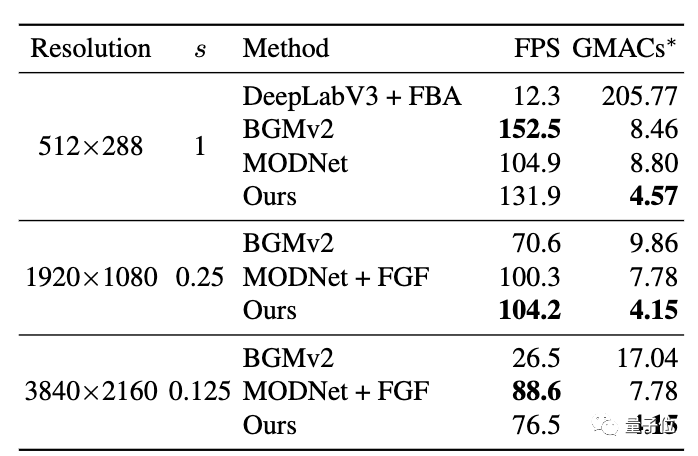

经过这一番调教之后,RVM和前辈们比起来,有怎样的改进?从下面这张表格中可以看出,在1080p视频上RVM的处理速度是最快的,在512×288上比BGMv2略慢,在4K视频上则比带FGF的MODNet慢一点。研究人员分析,这是因为RVM除了alpha通道外还预判了前景。更直观的数据是,在英伟达GTX 1080Ti上,RVM能以76FPS的速度处理4K视频,以104FPS的速度处理HD视频。一作字节跳动实习生

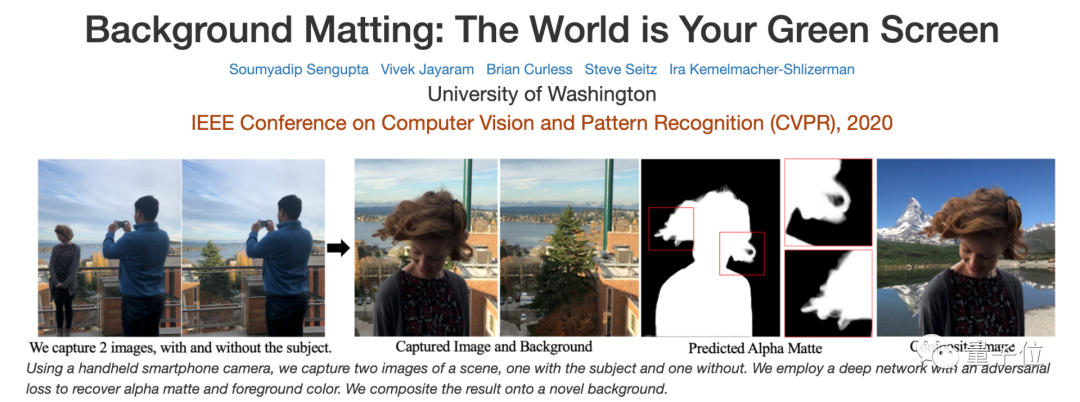

他本科、硕士均毕业于华盛顿大学,曾先后在Adobe、Facebook等大厂实习。2021年3月-6月,林山川在字节跳动实习。8月刚刚入职微软。事实上,林山川此前就曾凭借AI抠图大法拿下CVPR 2021最佳学生论文荣誉奖。他以一作身份发表论文《Real-Time High-Resolution Background Matting》,提出了Background Matting V2方法。这一方法能够以30FPS的速度处理4K视频,以60FPS的速度处理HD视频。值得一提的是,Background Matting这一系列方法不止一次中了CVPR。此前,第一代Background Matting就被CVPR 2020收录。两次论文的通讯作者都是华盛顿大学副教授Ira Kemelmacher-Shlizerman,她的研究方向为计算机视觉、计算机图形、AR/VR等。此外,本次论文的二作为Linjie Yang,他是字节跳动的研究科学家。本科毕业于清华大学,在香港中文大学获得博士学位。对了,除了能在Colab上试用之外,你也可以在网页版上实时感受一下这只AI的效果,地址:

https://peterl1n.github.io/RobustVideoMatting/#/demo

GitHub地址:

https://github.com/PeterL1n/RobustVideoMatting

论文地址:

https://arxiv.org/abs/2108.11515

参考链接:

https://www.reddit.com/r/MachineLearning/comments/pdbpmg/r_robust_highresolution_video_matting_with

PS:如果觉得我的分享不错,欢迎大家随手点赞、转发、在看。

PS:欢迎在留言区留下你的观点,一起讨论提高。如果今天的文章让你有新的启发,欢迎转发分享给更多人。