本周优秀开源项目分享:无脑套用格式、开源模板最高10万赞

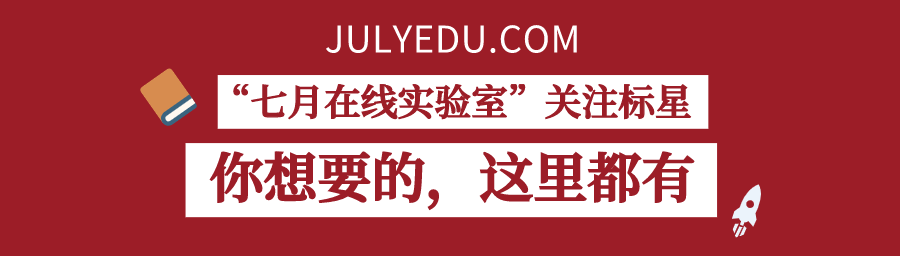

fMRIPrep 是一种功能性磁共振成像 (fMRI) 数据预处理管道,旨在提供易于访问的、最先进的接口,该接口可对扫描采集协议的变化非常可靠,并且需要最少的用户输入,同时提供易于解释和全面的误差和输出报告。它执行基本处理步骤(核心、规范化、解曲线、噪声成分提取、分割、头骨跳闸等),提供可轻松提交到各种组级分析的输出,包括基于任务或静止状态的 fMRI、图形理论测量、表面或基于体积的统计等。

fMRIPrep 管道使用来自知名软件包的工具的组合,包括FSL_、ANTs_、FreeSurfer_和AFNI_。此管道旨在为每个预处理状态提供最佳的软件实现,并将随着更新和更好的神经成像软件的可用而更新。

此工具允许您轻松执行以下操作:

将 fMRI 数据从原始数据从原始到完全预处理

实现不同软件包的工具

通过使用可用的最佳工具实现最佳的数据处理

生成预处理质量报告,用户可以通过这些报告轻松识别异常

接收有关每个主题的预处理阶段(包括有意义的错误)

自动和并行化处理步骤,从典型的线性手动处理中显著加快速度。

fMRIPrep 围绕三个原则构建:

稳健性 - 管道根据输入数据集调整预处理步骤,并且应提供尽可能好的结果,与扫描仪制作、扫描参数或是否存在其他校正扫描(如现场地图)不同

易用性 - 由于对 BIDS 标准的依赖,手动参数输入减少到最小,允许管道以自动方式运行。

"玻璃盒"理念 - 自动化不应意味着不应直观地检查结果或了解方法。因此,fMRIPrep 会为每个主题提供可视化报告,详细说明最重要的处理步骤的准确性。这与文档相结合,可以帮助研究人员了解流程,并决定应保留哪些主题进行小组级分析。

项目地址:

https://github.com/nipreps/fmriprep

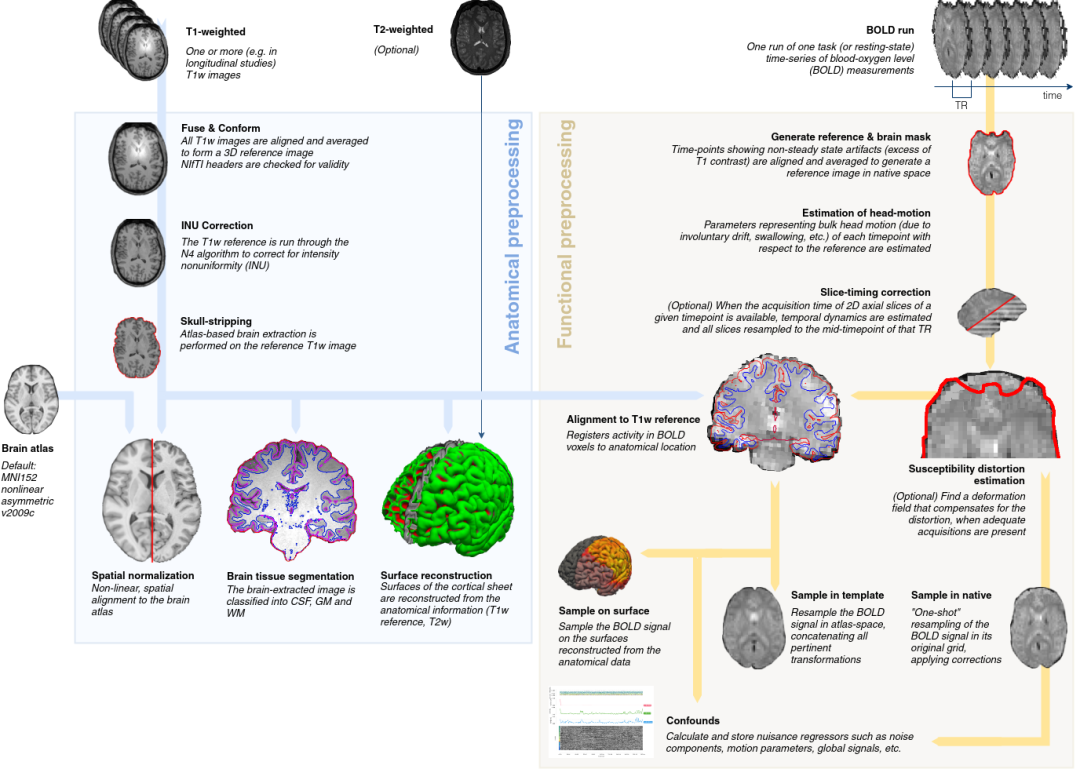

本文的目的是创建一个能够探测卫星图像中新构造的CNN。更精确地,拍摄两张不同时间拍摄的卫星图像,并输出一个带新建筑轮廓的分段蒙版。该模型将两个 650 x 650 的 RGB 图像作为输入,并输出相同大小的 semgment 掩码。

项目使用的 CNN 体系结构是 UNet++,其层被移除,过滤器大小减小。这样,该模型适合具有 6G 内存的 GPU。如上图所示,模型设法查找更改并生成具有近似形状的分段蒙版。

数据集:

https://drive.google.com/drive/folders/1rd1vseWiFSqQc5-93XSRQW9Bzzcgqc6H?usp=sharing

模型:

https://drive.google.com/drive/folders/1qbZm-b4gdhzzMCP09XwWx2wJKxsSXBJL?usp=sharing https://drive.google.com/drive/folders/1-DdCZxCv7OInvpUnbbT-4p2Uhc_v6ztI?usp=sharing

依赖库:

PyTorch (1.3.1+)

numpy

scikit-learn

matplotlib

imageio

Pillow

imgaug

tqdm

项目地址:

https://github.com/hbaudhuin/LamboiseNet自动和并行化处理步骤,从典型的线性手动处理中显著加快速度。

fMRIPrep 围绕三个原则构建:

稳健性 - 管道根据输入数据集调整预处理步骤,并且应提供尽可能好的结果,与扫描仪制作、扫描参数或是否存在其他校正扫描(如现场地图)不同

易用性 - 由于对 BIDS 标准的依赖,手动参数输入减少到最小,允许管道以自动方式运行。

"玻璃盒"理念 - 自动化不应意味着不应直观地检查结果或了解方法。因此,fMRIPrep 会为每个主题提供可视化报告,详细说明最重要的处理步骤的准确性。这与文档相结合,可以帮助研究人员了解流程,并决定应保留哪些主题进行小组级分析。

项目地址:

https://github.com/nipreps/fmriprep

项目描述:

本项目使用 GPT2-Chinese 的模型将wiki中文的数据导入模型训练了通用模型。

将GPT2-chitchat的对话任务稍作修改来适用于中文摘要任务。

将通用模型的权重应用在摘要问题上进行进一步训练的。

GPT2-Chinese 参考:https://github.com/Morizeyao/GPT2-Chinese

GPT2-chitchat参考:https://link.zhihu.com/?target=https%3A//github.com/yangjianxin1/GPT2-chitchat

项目工作流程详见:https://zhuanlan.zhihu.com/p/113869509

本项目为GPT2-chitchat稍作修改的内容,在此也感谢大佬的分享。

由于NLPCC的摘要数据为新闻语料,涉及话题和内容较多,应用在垂直领域下效果会好一些。

运行环境:

python3.6、 transformers==2.1.1、pytorch==1.3.1

项目结构:

config:存放GPT2模型的参数的配置文件

data

train_with_summary.txt:默认的原始训练集文件,存放摘要语料

train_tokenized.txt:对原始训练语料进行顺序tokenize之后的文件,用于model的训练

summary_model:存放摘要生成的模型

vocabulary:存放GPT2模型的字典

train.py:训练代码

interact.py:测试代码

Dialogue Model是基于GPT2模型的生成模型,对每条训练数据进行"顺序"拼接,然后将其输入到网络中,进行训练(该项目没有训练MMI Model的"逆序")。在训练Chinese Summary时,将上述训练数据进行如下拼接然后,将上述拼接结果作为Summary Model的输入,对模型进行训练。

模型分享:

模型 | 百度网盘 | 模型描述 |

GPT2-nlpcc-summary | 链接:https://pan.baidu.com/s/1atsbABI7Lq5HQNctC11E5g 提取码:grtn | 使用nlpcc的摘要数据基于GPT2-wiki训练的摘要模型 |

GPT2-wiki | 链接:https://pan.baidu.com/s/1oo1fpuGPYR9IMCcWQzzE9w 提取码:o1aq | 使用GPT2-Chinese训练的通用模型 |

项目地址:

https://github.com/qingkongzhiqian/GPT2-Summary

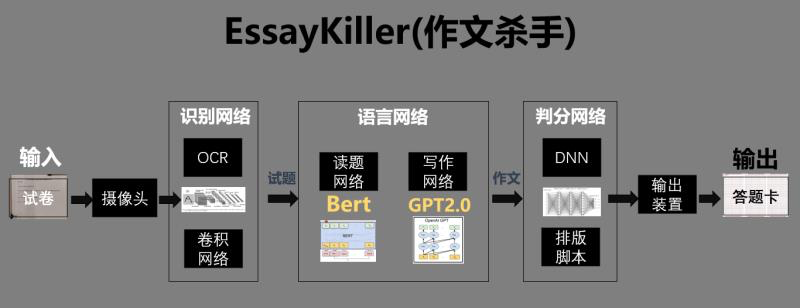

04 EssayKiller_V2 基于开源GPT2.0的初代创作型人工智能

EssayKiller是基于OCR、NLP领域的最新模型所构建的生成式文本创作AI框架,目前第一版finetune模型针对高考作文(主要是议论文),可以有效生成符合人类认知的文章,多数文章经过测试可以达到正常高中生及格作文水平。

框架说明:

基于EAST、CRNN、Bert和GPT-2语言模型的高考作文生成AI

支持bert tokenizer,当前版本基于clue chinese vocab

17亿参数多模块异构深度神经网络,超2亿条预训练数据

线上点击即用的文本生成效果demo:17亿参数作文杀手

端到端生成,从试卷识别到答题卡输出一条龙服务

模型结构:

整个框架分为EAST、CRNN、Bert、GPT-2、DNN 5个模块,每个模块的网络单独训练,参数相互独立。infer过程使用pipeline串联,通过外接装置直接输出到答题卡。

模型亮点:

简单的管道实现在当时较高精度的文本检测。

图像通过FCN处理产生像素级文本缩放地图和几何图形的多个频道。

可旋转的文本框,可以检测文本也可以检测单词。

项目地址:

https://github.com/EssayKillerBrain/EssayKiller_V2

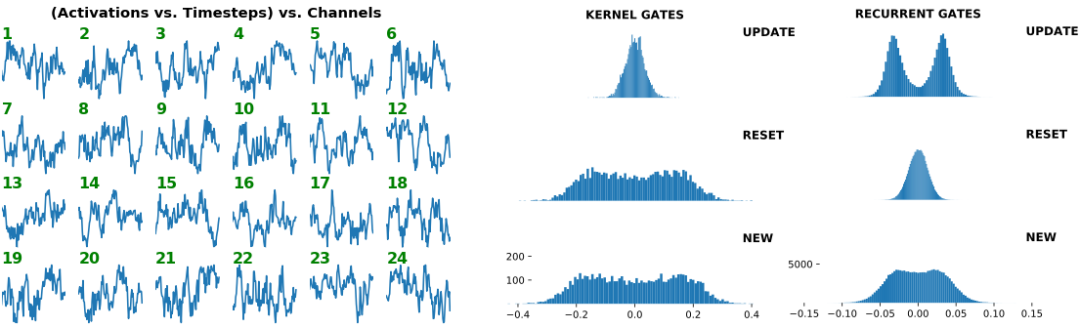

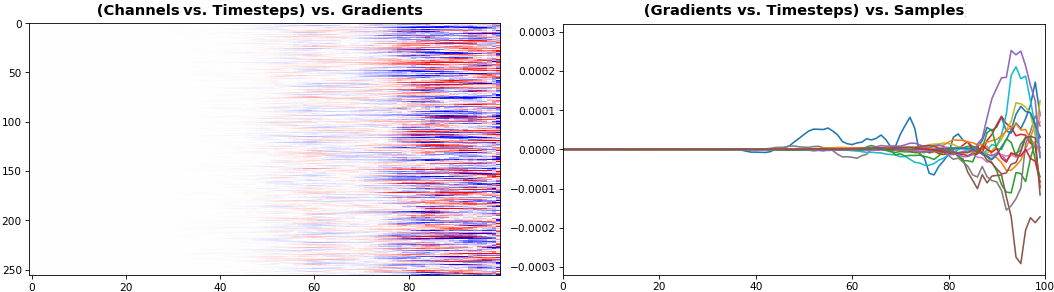

Keras 和 TensorFlow 中的 Rnn 权重、渐变和激活可视化 (Lstm 、 Gru 、 Simplernn 、 Cudnn 和所有其他)

特性:

权重、渐变、激活可视化

内核视觉对象:内核、循环内核和偏置显式显示

门视觉对象:门控架构(LSTM、GRU)中的门明确显示

通道视觉对象:显式显示的单元格单元(功能提取器

一般视觉对象:也适用于CNN和其他方法

重量规范跟踪:可用于分析重量衰减

内省是调试、规范和理解神经网络的有力工具。此项目的方法启用:

监视权重和激活进度 - 每个更改epoch-to-epoch、iteration-to-iteration

评估学习效率 - 梯度反传播对层到层的、时间到时间步长的影响

评估层健康 - 神经元的"死亡"或"爆炸"的百分比

跟踪体重衰减 - 各种方案(例如 l2 惩罚)如何影响重量规范

能够回答以下问题:

我的 RNN 是否学习长期依赖关系?>> 监控梯度:如果非零梯度每次时间步道流动,则每个时间步有助于学习 - 即,由此产生的梯度源于对每个输入时间步长的核算,因此整个序列会影响权重更新。因此,RNN 不再忽略长序列的部分,而被迫从它们中吸取教训

我的 Rnn 是否学习独立表示?>>监控激活:如果每个通道的输出不同且相互关联,则 RNN 提取了

为什么我有验证损失峰值?>>所有:瓦尔尖峰可能源于由于较大的梯度导致的层权重的急剧变化,这将明显改变激活模式;查看详细信息有助于通知更正

我的权重衰减是过度还是不足?>>监控权重规范:如果值斜减到许多倍,则衰减可能过大 - 或者,如果没有看到任何效果,则增加衰减

项目地址:

https://github.com/OverLordGoldDragon/see-rnn

06 FundamentalAnalysis 全面的基本面分析包

此包从 FinancialModelingPrep 收集来自大型公司集团的基本面和详细的公司股票数据 (13.000+),并使用 Yahoo Financial 获取任何金融工具的股票数据。它允许用户做大部分的基本分析。它还提供了快速比较多个公司或进行行业分析的可能性。

功能:

详细信息

可用公司 - 显示可用于基础数据收集的公司的完整列表,包括当前价格和公司列出的交易所。这是一个广泛的列表,有超过13000家公司

配置文件 - 提供有关行业、行业交易所和公司描述等

报价 - 提供有关公司的实际信息,其中包括日高、市值、开盘价和收盘价以及价格与权益

企业 - 显示股票价格、股票数量、市值和企业价值。

评级 - 基于特定比率,提供公司是(强)买入、中性还是(强)卖出的信息

discounted_cash_flow - 计算公司一段时间的贴现现金流量,包括今天的 DCF.

earnings_calendar - 显示有关今年大量品种的盈利日期的信息,包括预期的市盈率。

financial_statement

income_statement - 收集一个完整的损益表随着时间的推移。

balance_sheet_statement - 收集一段时间的完整资产负债表。

cash_flow_statement - 收集一个完整现金流量表随着时间的推移。

比率

key_metrics - 列出公司一段时间(每年和每季度)的关键指标(共 57 个指标)。这包括,除其他外,股本回报率(ROE)、流动资本、流动比率和债务

financial_ratios - 包括公司的深度比率(共 57 个比率)在一段时间(年度和季度)。其中包括价格与账面比率、支付比率和运营周期

financial_statement_growth - 衡量多个财务报表项目和比率在一段时间(年度和季度)的增长。其中包括收入增长(3 年、5 年和 10 年)、库存增长和运营现金流增长(3 年、5 年和 10 年)。

stock_data

stock_data - 收集所提供的股票代码的所有股票数据(包括收盘、调整后、高、低、开盘和成交量)。这可能是任何金融工具

stock_data_detailed - 收集大量股票数据(包括收盘、调整后收盘、高、低、开盘、成交量、未调整交易量、绝对变化、百分比变化、交易量加权平均价格 (VWAP)、日期标签和时间变化)。数据收集仅限于在功能公司中上市的公司。使用 stock_data函数了解任何其他内容。(ETF、共同基金、期权、指数等)

项目地址:

https://github.com/JerBouma/FundamentalAnalysis

本文部分素材来源于网络,如有侵权,联系删除。

今日福利推荐

锦鲤免单

知识图谱实战 / 计算机视觉训练

行为识别分析实战

千元AI课程大免单

100%中奖机率,扫码一键直达

☟