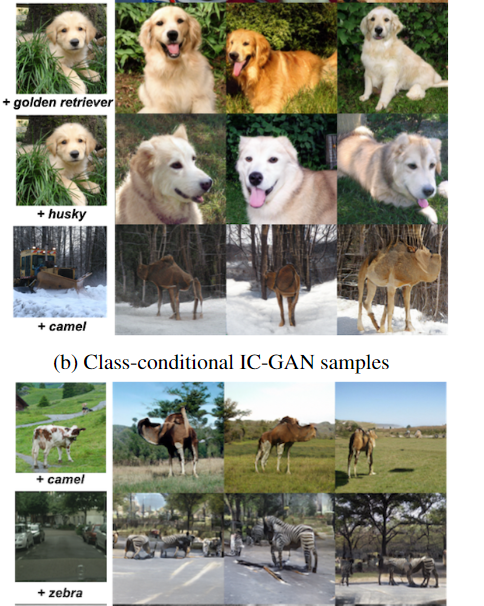

最会造假的GAN模型,雪地里都能有骆驼!Facebook发布IC-GAN,迁移能力史上最强

新智元报道

新智元报道

来源:Facebook AI

编辑:LRS

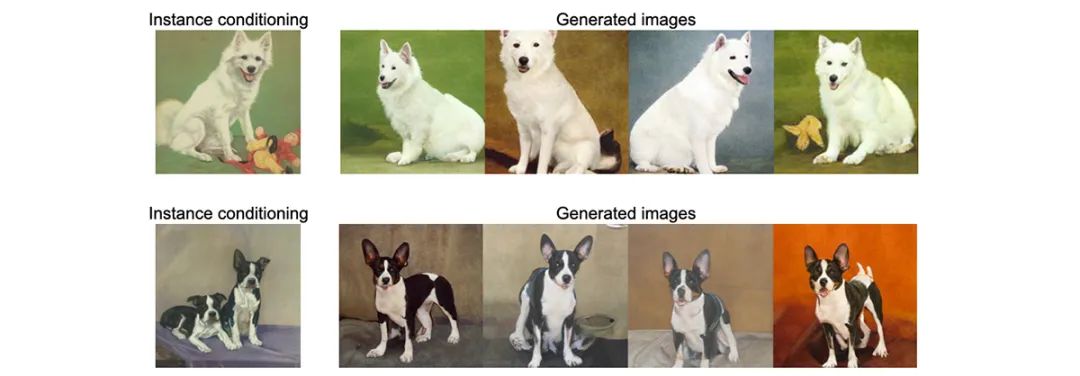

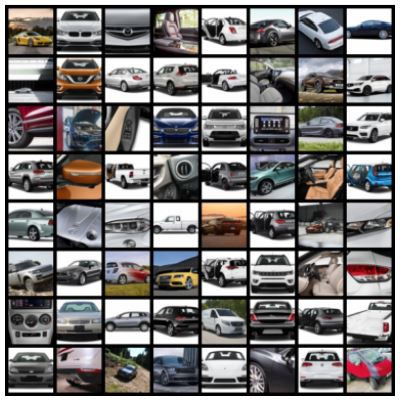

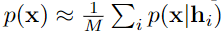

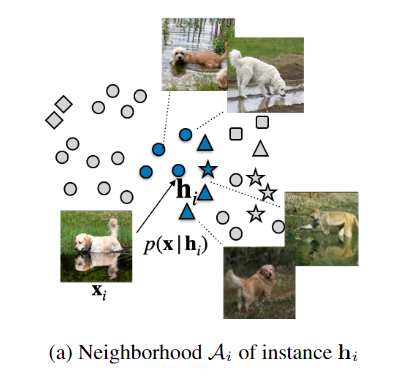

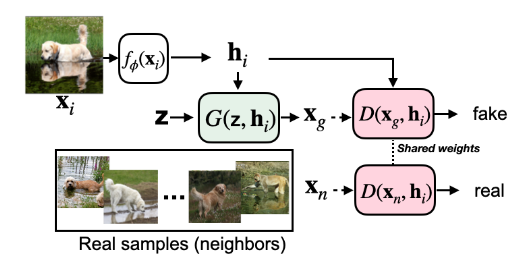

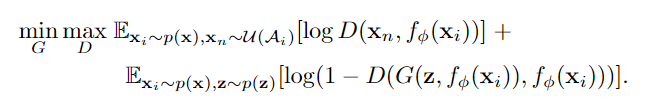

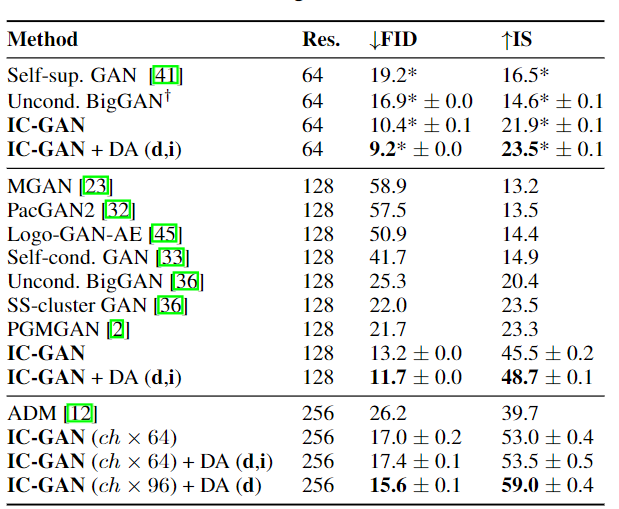

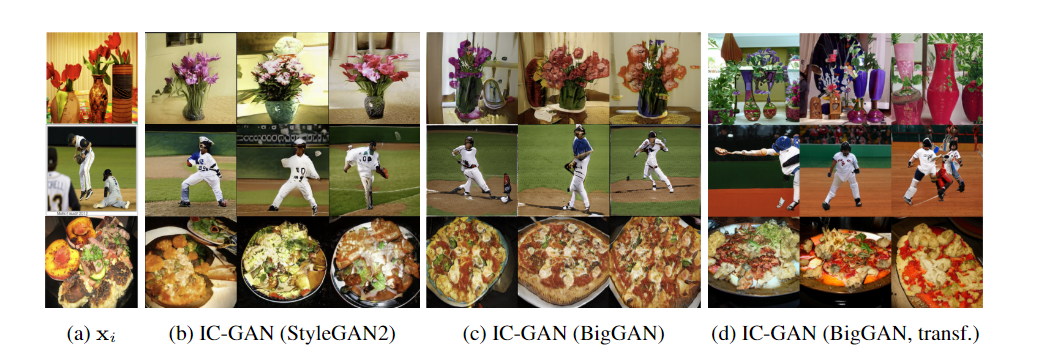

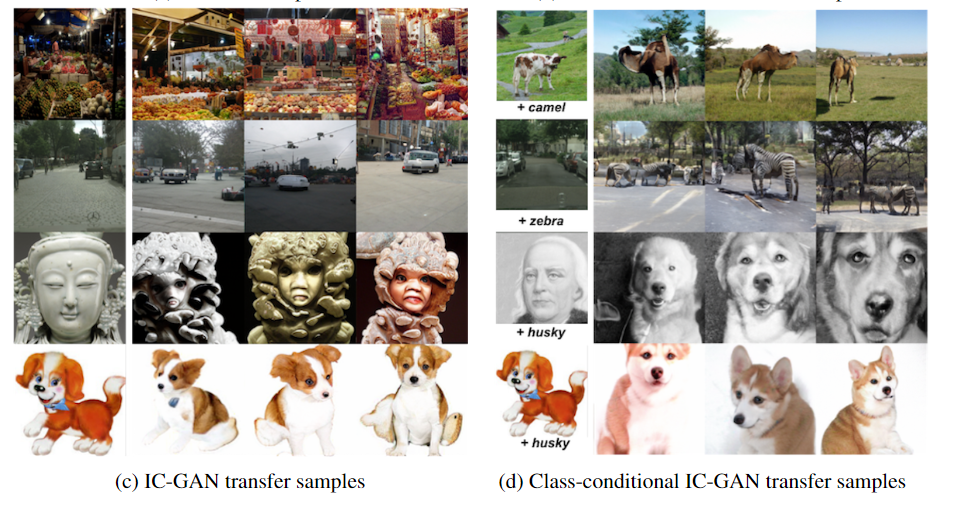

【新智元导读】GAN模型好是好,但就是对训练数据的要求太高,并且在场景和物体的语义组合时容易出现不合常理的生成图像,导致一眼假!最近Facebook发布了一个IC-GAN模型,迁移能力号称史上最强,能把各种场景和物体组合起来,训练集中没出现过的也能完美复原!甚至把雪地和骆驼放一起都毫无违和感!

参考资料:

https://ai.facebook.com/blog/instance-conditioned-gans/

-往期精彩-

评论